Ce blog n'a d'autre prétention que de me permettre de mettre à la disposition de tous des petits textes que j'écris. On y parle surtout d'informatique mais d'autres sujets apparaissent parfois.

Résumé du protocole HIP

Première rédaction de cet article le 21 décembre 2010

La parution régulière de RFC sur HIP (Host Identity Protocol) me donne à penser qu'un petit résumé de ce protocole est une bonne idée (ce texte est très inspiré du chapitre 3 du RFC 6079). HIP est un protocole de séparation entre l'identificateur et le localisateur. Avant HIP, les adresses IP servaient les deux rôles à la fois : comme localisateur, elles identifient une position de la machine sur l'Internet (pas une localisation physique, bien sûr), et changent donc si la machine se déplace ou si le réseau change de FAI. Comme identificateur, elles sont utilisées par les protocoles des couches supérieures, notamment TCP pour identifier une connexion en cours et, si elles changent, la connexion est cassée. Cette dualité de rôle des adresses IP rend certains problèmes comme la mobilité, le renumérotage (cf. RFC 5887) ou le multihoming très durs à traiter.

HIP, normalisé dans le RFC 7401, résout le problème en limitant les adresses IP au rôle de

localisateur. Ainsi, un paquet HIP est un paquet IP normal et les

routeurs n'ont pas besoin d'être modifiés. HIP est entièrement mis en

œuvre dans la machine terminale. Les identificateurs sont, eux,

des clés publiques, permettant une

authentification des machines (leur nom officiel est HI, pour

Host Identifier). Comme ces clés sont souvent très

longues, et, pire, de taille variable, HIP introduit également un

condensat cryptographique des clés, le HIT

(Host Identifier Tag), qui a la taille d'une

adresse IPv6 et peut donc être présenté aux

couches supérieures comme TCP, sans trop les traumatiser. (Sur

FreeBSD, vous trouverez le HIT de votre machine

sous /etc/hip.)

Les HIT sont rangés dans un préfixe IPv6 spécial, nommé

Orchid (RFC 7343),

2001:20::/28, avant d'éviter toute collision avec

les adresses IPv6 « normales ».

Pour établir une connexion, HIP utilise un échange de quatre

paquets (comme SCTP, alors que TCP n'en utilise que trois). Pour

envoyer ces paquets, le pair à l'initiative de la connexion doit

connaître le localisateur (l'adresse IP) du répondeur. Il peut la

trouver dans le DNS (RFC 8005) ou bien via un serveur de rendez-vous (RFC 8004). En pair-à-pair, une

DHT pourrait être un bon moyen de résoudre un

identificateur en localisateur, et le RFC 6537 explore cette piste. (Sur FreeBSD,

on peut même mettre HIT et adresse - identificateur et localisateur -

du pair dans /etc/hosts.) HIP dispose également d'un mécanisme

pour pouvoir fonctionner à travers les NAT

(RFC 5770). Une fois la connexion établie, les

localisateurs peuvent changer (RFC 5206), la

connexion continue.

HIP dispose d'une forte sécurité : protection contre les usurpations d'identificateur par le fait que ceux-ci sont une clé cryptographique et que les messages sont signés, protections contre les DoS au moment de l'établissement de la connexion (une faiblesse traditionnelle de TCP lorsqu'il est utilisé seul). Le « certificat » que représente cette clé est auto-signé par défaut (et est donc accepté par TOFU Trust On First Use comme dans SSH) mais, si on veut avoir encore plus de sécurité, on peut tout à fait avoir un serveur central qui alloue les identificateurs et les lie à des identificateurs des applications. HIP n'a pas qu'un seul modèle de sécurité pour authentifier les pairs.

Qu'est-ce que HIP change pour les applications ? Une application traditionnelle peut tout à fait utiliser HIP (cf. RFC 5338) mais une API standard figure dans le RFC 6317 pour celles qui veulent aller plus loin.

Il existe des mises en œuvres de HIP pour FreeBSD (le développement a stoppé en 2008) et Linux mais aucun des deux ne semble proche d'une intégration dans le système officiel (pour FreeBSD, rien n'est prévu). Le projet OpenHIP adapte également des logiciels comme Wireshark pour qu'ils aient un support HIP. InfraHIP travaille également à l'infrastructure HIP et à des implémentations. Ils ont réalisé une bonne explication de HIP en une page qui concurrence sérieusement cet article. Un compte-rendu des expériencs pratiques avec HIP se trouve dans le RFC 6538.

L'article seul

Comcast, Level 3 et la cuisson des pommes de terre

Première rédaction de cet article le 21 décembre 2010

Dernière mise à jour le 22 décembre 2010

Il y a déjà eu beaucoup d'articles, surtout aux États-Unis, à propos du conflit qui oppose deux opérateurs Internet, Comcast et Level 3 (j'ai mis quelques références à la fin). Je n'ai pas de sources privilégiées, je ne suis pas un « blogueur influent » donc je ne vais pas pouvoir vous faire de révélations sensationnelles mais il y a quand même, deux ou trois points que je voudrais traiter. Donc, Comcast réclame à Level 3 des sous et Level 3 porte l'affaire devant le régulateur. Pourquoi ?

L'article complet

Dynamic Languages Strike Back

Première rédaction de cet article le 17 décembre 2010

Cela ne date pas d'aujourd'hui, mais voici un excellent exposé de Steve Yegge sur la programmation : « Dynamic Languages Strike Back ». Au contraire de ces insupportables vidéos pour décideurs, ici, ce n'est que du texte et des transparents. L'auteur a tout simplement transcrit (et avec soin) l'intégralité de sa conférence !

Une passionnante et détaillée plongée dans le monde de ce qu'on appelle, faut de mieux, les « langages [de programmation] dynamiques » comme Lua, Python ou Ruby, où Yegge détaille pourquoi la plupart des défauts qu'on leur reproche traditionnellement (comme leur lenteur) ne sont plus des problèmes de nos jours ou, du moins, pourraient être résolus rapidement si on investissait plus de temps dans ces langages au lieu de s'obstiner à programmer dans les langages « statiques ».

L'article seul

Faire tourner sshd sur un autre port que 22

Première rédaction de cet article le 17 décembre 2010

Dernière mise à jour le 20 décembre 2010

La plupart des serveurs et routeurs connectés à l'Internet ont un serveur SSH qui écoute sur le port 22 pour permettre l'accès à distance et l'administration de la machine. Très souvent, des attaques automatiques sont lancées contre ces machines. Même si elles échouent, elles remplissent les journaux et déclenchent des alarmes inutiles. Je recommande personnellement de ne jamais faire tourner le serveur SSH sur le port 22.

Voici un exemple d'une attaque réelle (je n'ai pas modifié l'adresse IP source de l'attaquant car, comme d'habitude, abuse n'a jamais répondu à mon signalement). Il s'agit apparemment d'une attaque par dictionnaire classique, où l'assaillant essaie plusieurs mots de passe classiques pour des comptes courants dans les pays anglo-saxons (john, adam, kevin) :

Dec 9 05:35:10 mon-serveur sshd[28839]: Invalid user john from 173.45.74.230 Dec 9 05:35:10 mon-serveur sshd[28839]: pam_unix(sshd:auth): check pass; user unknown Dec 9 05:35:10 mon-serveur sshd[28839]: pam_unix(sshd:auth): authentication failure; logname= uid=0 euid=0 tty=ssh ruser= rhost=e6.4a.2d.static.xlhost.com Dec 9 05:35:11 mon-serveur sshd[28839]: Failed password for invalid user john from 173.45.74.230 port 40514 ssh2 Dec 9 05:35:12 mon-serveur sshd[28841]: Invalid user john from 173.45.74.230 Dec 9 05:35:12 mon-serveur sshd[28841]: pam_unix(sshd:auth): check pass; user unknown Dec 9 05:35:12 mon-serveur sshd[28841]: pam_unix(sshd:auth): authentication failure; logname= uid=0 euid=0 tty=ssh ruser= rhost=e6.4a.2d.static.xlhost.com Dec 9 05:35:14 mon-serveur sshd[28841]: Failed password for invalid user john from 173.45.74.230 port 41395 ssh2 Dec 9 05:35:16 mon-serveur sshd[28843]: Invalid user kevin from 173.45.74.230 Dec 9 05:35:16 mon-serveur sshd[28843]: pam_unix(sshd:auth): check pass; user unknown Dec 9 05:35:16 mon-serveur sshd[28843]: pam_unix(sshd:auth): authentication failure; logname= uid=0 euid=0 tty=ssh ruser= rhost=e6.4a.2d.static.xlhost.com Dec 9 05:35:18 mon-serveur sshd[28843]: Failed password for invalid user kevin from 173.45.74.230 port 42402 ssh2 Dec 9 05:35:19 mon-serveur sshd[28845]: Invalid user kevin from 173.45.74.230 Dec 9 05:35:19 mon-serveur sshd[28845]: pam_unix(sshd:auth): check pass; user unknown Dec 9 05:35:19 mon-serveur sshd[28845]: pam_unix(sshd:auth): authentication failure; logname= uid=0 euid=0 tty=ssh ruser= rhost=e6.4a.2d.static.xlhost.com Dec 9 05:35:20 mon-serveur sshd[28845]: Failed password for invalid user kevin from 173.45.74.230 port 43071 ssh2 Dec 9 05:35:21 mon-serveur sshd[28847]: Invalid user adam from 173.45.74.230 Dec 9 05:35:21 mon-serveur sshd[28847]: pam_unix(sshd:auth): check pass; user unknown Dec 9 05:35:21 mon-serveur sshd[28847]: pam_unix(sshd:auth): authentication failure; logname= uid=0 euid=0 tty=ssh ruser= rhost=e6.4a.2d.static.xlhost.com Dec 9 05:35:23 mon-serveur sshd[28847]: Failed password for invalid user adam from 173.45.74.230 port 43842 ssh2 Dec 9 05:35:24 mon-serveur sshd[28849]: Invalid user adam from 173.45.74.230 Dec 9 05:35:24 mon-serveur sshd[28849]: pam_unix(sshd:auth): check pass; user unknown Dec 9 05:35:24 mon-serveur sshd[28849]: pam_unix(sshd:auth): authentication failure; logname= uid=0 euid=0 tty=ssh ruser= rhost=e6.4a.2d.static.xlhost.com Dec 9 05:35:27 mon-serveur sshd[28849]: Failed password for invalid user adam from 173.45.74.230 port 44743 ssh2

Ici, l'attaque a apparemment échoué. Mais, même si le serveur SSH a un

accès restreint (par exemple avec la directive

AllowUsers de OpenSSH),

c'est ennuyeux d'avoir ses journaux encombrés par de telles attaques,

qui sont très courantes. Un script PHP bogué,

une prise de contrôle à distance, même sans passer

root et hop, tout serveur dédié n'importe où

sur la planète commence un balayage systématique des serveurs et

routeurs, pour le compte du craqueur masqué

derrière lui.

Ma méthode préférée pour garder mes journaux courts et pour embêter un peu les pirates est de faire tourner le serveur sur un autre port. Avec OpenSSH, c'est :

Port 42666

dans le fichier de configuration. Et, là, plus d'attaques.

J'insiste bien sur le fait que le but principal est d'éviter l'encombrement des journaux. Changer de port ralentit les craqueurs mais n'est pas réellement un gros avantage en matière de sécurité (croire cela serait croire au STO). Un craqueur compétent pourrait faire un nmap sur le serveur et découvrir le port SSH par la bannière envoyée :

% telnet mon-serveur 42666 Trying 2001:db8:37a::d946:bee8:232... Connected to mon-serveur. Escape character is '^]'. SSH-2.0-OpenSSH_5.1p1 Debian-5 ...

Mais, en pratique, la plupart des attaques sont bêtes et massives. Pas de subtilité, juste tester le port 22. Sur les serveurs qui écoutent sur un autre port, on ne voit jamais, à l'heure actuelle, d'attaques par dictionnaire.

Certaines personnes pensent que changer de port va leur compliquer

la vie à eux aussi, en les obligeant à indiquer le numéro de port à

chaque commande SSH, par exemple à taper ssh -p 42666

mon-serveur au lieu de ssh

mon-serveur. Mais non ; OpenSSH permet de mettre le numéro

de port une fois pour toutes dans le fichier

~/.ssh/config :

Host mon-serveur Port 42666

et c'est tout, il n'y aura plus rien à taper (si on travaille sur plusieurs machines, ce qui est mon cas, on peut synchroniser son répertoire). Même chose avec un client SSH comme ConnectBot sur Android, qui permet d'indiquer le numéro de port lors de l'enregistrement d'un serveur.

Et que faire si on ne contrôle pas le pare-feu et que les ports alternatifs sont bloqués ? La bonne solution est d'utiliser le port 443 (celui de HTTPS) qui est rarement bloqué. Et si on a déjà un serveur Web sur ce port ? Dans ce cas, il y a sslh.

Existe-t-il d'autres méthodes pour contrarier ce genre d'attaquants ? Oui, bien sûr, on peut restreindre l'accès à SSH par adresse IP source (voir un exemple sur Linux). Cela se fait souvent sur les routeurs, qu'on n'administre que depuis le réseau interne, mais ce n'est pas toujours possible pour les serveurs, il faut bien pouvoir se connecter à distance. Il y a aussi la possibilité de faire du « toquage à la porte » avec un logiciel comme knockd (cf. un bon article en français) ou avec une solution plus simple. Encore une autre solution est de détecter automatiquement les clients SSH qui abusent et de les filtrer. C'est ce que fait fail2ban mais je ne l'ai personnellement pas encore tenté. On peut aussi faire la même chose avec DenyHosts (qui utilise un TCP Wrapper et pas Netfilter), avec iptables et le module "recent" (attention, cette solution a des limites). Ces techniques sont toutes plus sûres que le simple changement de port mais sont également plus compliquées à mettre en œuvre.

Merci à Pascal Hambourg, Sébastien Rodriguez, Cyril Bouthors, Clochix et aux utilisateurs de Twitter dont j'ai oublié de noter le nom.

Je recommande un très bon article sur l'état des attaques SSH par force brute : « Observations from two weeks of SSH brute force attacks ». Et il faut se rappeler qu'il n'y a pas que les méchants qui balaient l'Internet sur le port 22. les chercheurs en sécurité le font aussi (et trouvent plein de machines).

L'article seul

RFC 6069: Making TCP more Robust to Long Connectivity Disruptions (TCP-LCD)

Date de publication du RFC : Décembre 2010

Auteur(s) du RFC : A. Zimmermann, A. Hannemann (RWTH Aachen University)

Expérimental

Réalisé dans le cadre du groupe de travail IETF tcpm

Première rédaction de cet article le 13 décembre 2010

Depuis très longtemps, un des problèmes du protocole de transport TCP est le fait qu'il réduise son débit en cas de pertes de paquets, pensant que cette perte provient d'une congestion. Mais si la perte de paquets était due à une coupure temporaire de la connectivité (ce qui est fréquent avec les liaisons radio), il est inutile de diminuer le débit, puisque le problème ne venait pas d'une congestion. TCP devrait au contraire continuer au même rythme, surtout une fois que la connectivité est rétablie. Une solution au problème pourrait être d'utiliser les messages ICMP pour mieux diagnostiquer la cause de la perte de paquets et c'est cette approche que ce RFC 6069 suggère d'essayer.

Rappelons que TCP fonctionne en envoyant des données dont l'autre pair doit accuser réception. S'il ne le fait pas à temps, TCP réemet les données et, s'il n'y a toujours rien, TCP en déduit que le réseau est surchargé (et jette donc des paquets) et, bon citoyen, il réagit en diminuant le rythme d'envoi (RFC 2988 et section 1 de notre RFC 6069). C'est ce comportement qui évite à l'Internet de s'écrouler sous la charge. Il n'est donc pas question que TCP soit modifié pour envoyer systématiquement au maximum de ses possibilités, « au cas où ça passe ». Mais, parfois, TCP est excessivement prudent. Si je débranche puis rebranche un câble réseau pendant le transfert d'un gros fichier, TCP va ralentir alors qu'il n'y avait aucune congestion (voir l'article de Schuetz, S., Eggert, L., Schmid, S., et M. Brunner, « Protocol enhancements for intermittently connected hosts », dans SIGCOMM Computer Communication Review vol. 35, no. 3). En pratique, le cas le plus embêtant se produit avec les réseaux sans-fil où de tels « branchements/débranchements » sont fréquents, soit en raison d'une modification soudaine du médium (une pluie intense, si on est dehors, ou bien un parasite soudain), soit en raison d'un déplacement de l'ordinateur. Peut-on détecter qu'une absence d'accusés de réception était due à une coupure temporaire du réseau ?

D'abord (section 2), il faut distinguer deux sortes de coupure du réseau. Les courtes sont celles qui durent moins longtemps que le délai de retransmission de TCP. Si les files d'attente du routeur situé avant la coupure sont suffisamment grandes, il pourra « tamponner » les paquets et il n'y aura même pas de perte, juste des variations de délai (cf. RFC 3522, RFC 4015 ou RFC 5682). Les longues coupures sont celles qui durent plus longtemps et où l'émetteur TCP doit donc commencer à renvoyer des paquets déjà transmis. Suivant le RFC 5681, TCP ne se contente pas de réémettre, il diminue son rythme de transmission. Si la connectivité revient, TCP ne va pas s'en apercevoir tout de suite et, même si les accusés de réception réapparaissent, TCP continuera à envoyer à un rythme réduit, sans bonne raison, juste parce qu'il a cru à la congestion. Idéalement, TCP devrait, au contraire, recommencer à pleine vitesse dès que la liaison est rétablie.

Comment détecter la coupure et le rétablissement ? La section 3 rappelle l'existence des paquets ICMP Destination Unreachable (RFC 792, RFC 1812 et RFC 4443). Ces paquets sont envoyés par le routeur, vers l'émetteur, si le routeur est obligé de jeter le paquet (codes 1, Host unreachable ou 0, Network unreachable). Mais attention, ils ne sont pas parfaits : ils ne sont pas envoyés en temps-réel (et donc arriveront peut-être après que TCP ait trouvé tout seul qu'il y a un problème) et ils sont en général limités en quantité.

Ces paquets ICMP contiennent les premiers octets du paquet qui a déclenché le problème et l'émetteur peut donc, en recevant le paquet ICMP, trouver la connexion TCP en cause. Le principe du nouvel algorithme expérimental TCP-LD (TCP Long Disruption) est donc d'utiliser ces messages ICMP pour différencier la congestion et la coupure. Dans le cas d'une coupure, cela vaudra la peine de réessayer de manière plus agressive.

L'algorithme est présenté en section 4. Le principe est simple : lorsque TCP a déjà dépassé son délai de garde, attendant un accusé de réception, et en cas de réception d'un message ICMP indiquant une coupure, TCP ne va pas augmenter les délais de retransmission. Au retour des accusés de réception, TCP reprendra « plein pot ». Les détails figurent par la suite. D'abord, TCP-LD ne s'applique qu'aux TCP qui suivaient l'algorithme de retransmission du RFC 2988. L'algorithme ne doit être utilisé qu'une fois la connexion complètement établie. Les seuls messages ICMP pris en compte sont ceux qui sont émis en réponse à des données TCP qui ont fait l'objet d'une retransmission. (Et autres détails, l'algorithme complet figure dans cette section 4.)

Une discussion des différents points à garder en tête figure en section 5. Elle insiste sur le fait que l'algorithme TCP-LD n'est déclenché que s'il y a réception des messages ICMP indiquant une erreur et expiration du délai de garde. Cela garantit que TCP-LD ne sera utilisé qu'en cas de longue coupure. Il y a quand même des cas qui prennent TCP-LD en défaut. C'est le cas par exemple de l'ambiguité analysée en section 5.1. Cette ambiguité vient du fait que le paquet TCP (et donc le message ICMP d'erreur qui concerne ce paquet) n'indique pas s'il s'agit d'une transmission ou d'une retransmission. Ce n'est pas un problème en pratique mais, si l'émetteur TCP qui reçoit le paquet ICMP peut être sûr qu'il y a eu retransmission, il n'est pas forcément sûr que le message d'erreur était en réponse à la retransmission. Encore plus rigolo (section 5.2), TCP-LD peut associer à tort un message ICMP à une session TCP ayant connu une retransmission, simplement parce que le numéro de séquence a dépassé sa valeur maximale et est revenu au début (sur des réseaux rapides, les 32 bits qui stockent le numéro de séquence TCP ne suffisent pas longtemps). La probabilité que cela arrive et interfère avec une coupure réelle est toutefois très faible. D'autres problèmes amusants (pour ceux qui connaissent bien TCP) forment la fin de la section 4, comme par exemple les risques liés aux paquets dupliqués. Un certain nombre des problèmes exposés pourraient être résolus avec l'option d'estampillage temporel de TCP (RFC 7323 et section 6 de notre RFC) : les estampilles pourraient lever certaines ambiguités.

TCP-LD est une technique « côté émetteur » seulement, et qui peut donc être déployée unilatéralement. Y a-t-il des risques à le faire ? La section 7 explore ces risques. Par exemple (section 7.1), si un émetteur TCP essaie de détecter une coupure définitive en se donnant une limite maximale au nombre de retransmissions, l'utilisation de TCP-LD, qui va réduire l'intervalle entre les retransmissions, pourra amener à des conclusions erronées. Il faut donc évaluer la durée maximale qu'on accepte avant de couper en temps, et pas en nombre de retransmissions.

Je l'ai dit au début, ce problème est perçu depuis très longtemps par les utilisateur de TCP. Il y a donc eu bien d'autres efforts pour le résoudre. La section 8 les résume. On y trouve par exemple des modifications des couches inférieures (RFC 3819) ou bien des modifications des routeurs IP, pour qu'ils analysent suffisamment de TCP pour pouvoir générer des messages d'information. TCP-LD, par contre, ne nécessite pas de modification des couches basses, ni des routeurs intermédiaires.

Un point important de ce schéma est que les messages ICMP ne sont sécurisés en rien et que d'autres RFC, comme le RFC 5927, demandent de s'en méfier et au minimum de ne pas agir sans les avoir sérieusement validés. Quels sont donc les risques (section 9) ? Un attaquant pourrait, soit générer des faux messages ICMP Destination Unreachable pour que TCP, croyant à une coupure et pas à une congestion, continue à inonder le réseau, soit au contraire empêcher les messages ICMP d'arriver, ramenant TCP à la situation avant TCP-LD. Dans le premier cas, les paquets ICMP nécessiteraient d'inclure une partie du paquet TCP, dont des éléments difficiles à deviner, comme le numéro de séquence et les mécanismes de validation du RFC 5927 conviendraient donc. Si elles échouent, l'attaquant qui arrive à trouver le numéro de séquence et les autres informations a de toute façon la possibilité de monter des attaques bien pires.

L'algorithme TCP-LD avait été présenté en

2009 à la réunion IETF 75

de Stockholm. Les transparents (« Make

TCP more Robust to Long Connectivity Disruptions ») sont

en

ligne. Ils exposent l'algorithme et le résultat d'une

évaluation après mise en œuvre sur

Linux. Plein de jolis graphes. À propos de

Linux, le travail des auteurs était disponible en http://www.umic-mesh.net/downloads/linux-tcp.html et a depuis

été intégré (sous une forme modifiée) dans le noyau standard : regardez

tcp_v4_err() dans

net/ipv4/tcp_ipv4.c et les commentaires

mentionnant

draft-zimmermann-tcp-lcd (l'ancien nom de ce RFC 6069).

L'article seul

WikiLeaks DNS mirrors and the limits of the DNS

First publication of this article on 12 December 2010

Last update on of 13 December 2010

Following the big crackdown against WikiLeaks and the many attempts to censor the independent information Web site, many people, eager to do something for the freedom of information, have set up mirrors of the WikiLeaks content. Some of these mirrors do not actually store content, they are just DNS mirrors, which store the IP addresses of the actual Web sites. The goal is to allow these Web sites to be found even if many domain names are deleted, following brutal takedowns like the one performed by the US customs in another case. But these DNS mirrors must be careful to test that they work even if they go beyond the traditional limits of the DNS.

The biggest of these limits is the size: at its beginning, DNS accepted only answers of up to 512 bytes (RFC 1035, section 2.3.4). This limit was lifted ten years ago, in RFC 2671. But ten years is short in an environment as ossified as the Internet and many DNS resolvers still cannot handle properly larger answers.

Let's take as an example the DNS mirror

all-wikileaks.bortzmeyer.fr. It now stores 157 IP

addresses (it may change in the future since mirrors appear and

disappear all the time and you have to test them

often). It allows a big resilience since only one working IP

address in the set is sufficient to reach

WikiLeaks. The total size of the DNS answer is 2753 bytes (a bit

less if you query only one IP address family, for instance only

IPv4). It is much larger than the traditional

limit and it is even larger than the Ethernet

MTU, the most common maximum packet size

today. Does it work?

It depends on the resolver. With a standard, out-of-the-box DNS resolver like BIND or Unbound, it works fine, the name can be resolved and a Web browser can visit the site. That's because these programs correctly implement the DNS as it is today. They use the EDNS0 option of RFC 2671 and have a default buffer size of 4096 bytes, which is sufficient today (the largest theoretical size now is 65536 bytes).

If you want to test by hand, with the common DNS testing tool dig, be careful that, unlike a proper resolver, it does not use EDNS0 by default. You have to indicate it on the command line:

% dig +bufsize=4096 ANY all-wikileaks.bortzmeyer.fr ... ;; Query time: 4 msec ;; SERVER: ::1#53(::1) ;; WHEN: Fri Dec 10 17:16:03 2010 ;; MSG SIZE rcvd: 2753

or to put it once for all in the ~/.digrc

configuration file:

% cat ~/.digrc +bufsize=4096 % dig ANY all-wikileaks.bortzmeyer.fr ... ;; Query time: 4 msec ;; SERVER: ::1#53(::1) ;; WHEN: Fri Dec 10 17:17:14 2010 ;; MSG SIZE rcvd: 2753

But many ISP or local networks provide broken DNS resolvers to their users. Even if the DNS resolver is OK, it is at the mercy of a firewall or another middlebox which mangles either the DNS query (by deleting the EDNS0 option) or the answer (by being unable of transmitting the larger-than-512-bytes reply). (For details on middleboxes, see the SSAC 035 document or RFC 5625.)

Possible issues are many: for instance, if the query does not use EDNS0, the answer, too large, won't be entirely sent and the authoritative name server will set the TC bit which means "Data truncated"). The resolver is then supposed to retry over TCP and some cannot, either because they don't support TCP (a big mistake in today's Internet) or because they are blocked by a misconfigured firewall which allows DNS only on UDP.

Here is an example on the Free network (Free being the second largest ISP in France). While EDNS0 queries seem to go just fine, the resolvers do not accept TCP. When the dig testing tool queries them, it receives a truncated response, retries over TCP and is blocked:

% dig A all-wikileaks.bortzmeyer.fr

;; Truncated, retrying in TCP mode.

;; Connection to 212.27.40.241#53(212.27.40.241) for \

all-wikileaks.bortzmeyer.fr failed: connection refused.

Among the programs which may have problems, the PowerDNS recursor, which does not have EDNS0 by default (for the reasons explained by its author). As a result, PowerDNS Recursor always falls back to TCP, which may be a problem with some broken firewalls.

Another interesting test (thanks to Marco Davids) was done through a AVM Fritz!Box 7170 Annex A with firmware version 58.04.82. Like many cheap boxes, it has an internal DNS proxy which does not do TCP and does not accept answers >512 bytes. TCP connections are here rejected:

% dig +bufsize=4096 ANY all-wikileaks.bortzmeyer.fr @192.168.68.7 ;; Truncated, retrying in TCP mode. ;; Connection to 192.168.68.7#53(192.168.68.7) for all-wikileaks.bortzmeyer.fr failed: connection refused.

With EDNS0 on the dig side (option +bufsize), and the interdiction to fall back to TCP (option

+ignore):

% dig +ignore +bufsize=4096 ANY all-wikileaks.bortzmeyer.fr @192.168.68.7 ... ;; flags: qr tc rd ra; QUERY: 1, ANSWER: 23, AUTHORITY: 0, ADDITIONAL: 0 ... ;; Query time: 4 msec ;; SERVER: 192.168.68.7#53(192.168.68.7) ;; WHEN: Mon Dec 13 09:35:10 2010 ;; MSG SIZE rcvd: 509

The box has stuffed as many answers it could, to stay below 512 bytes.

If you want to test yourself, I'll be happy to receive (at

bortzmeyer+testdnssize@bortzmeyer.org) reports of

issues but please, do not forget to indicate the resolver used (make

and model), as well as existing middleboxes such as firewalls) or the

network used (name of the ISP and city) if you do not control the DNS

resolver yourself. Complete output of dig would be a big plus. Another big DNS mirror, to have several tests, is wklk.eu.org.

Thanks to Niall O'Reilly for his style and technical checking. All the opinions are mine.

L'article seul

Attaque dictionnaire via POP

Première rédaction de cet article le 11 décembre 2010

Tout serveur réseau connecté à l'Internet voit passer en permanence des attaques, qui se traduisent entre autres par des lignes et des lignes dans le journal. La grande majorité de ces attaques (sauf si on abrite un service spécifiquement visé, comme WikiLeaks) sont aveugles au sens où le méchant ne cherchait pas spécialement à attaquer ce serveur, il a juste écrit un ver qui attaque un peu au hasard toutes les adresses IP qu'il peut trouver. Je viens de m'apercevoir que le vénérable protocole POP, décrit dans le RFC 1939, connaissait aussi ce genre d'attaques.

Voici l'extrait du journal concernant un cas parmi d'autres. L'heure est en UTC + 1. J'ai laissé la vraie adresse IP de l'attaquant car j'ai prévenu le contact indiqué dans la base du RIPE et ledit contact n'a évidemment jamais répondu. Je vois très souvent des attaques de ver sur SSH ou sur HTTP. Avec le protocole POP, conçu pour le relevé de boîtes aux lettres à distance, c'est plus rare, mais il est vrai qu'il y a moins de serveurs POP accessibles que de serveurs HTTP donc les vers se concentrent sur un plus petit nombre d'objectifs.

Dec 8 13:22:51 mon-serveur pop3d: LOGIN FAILED, user=tokend, ip=[::ffff:94.102.55.80] Dec 8 13:22:56 mon-serveur pop3d: LOGIN FAILED, user=windowserver, ip=[::ffff:94.102.55.80] Dec 8 13:23:01 mon-serveur pop3d: LOGIN FAILED, user=appowner, ip=[::ffff:94.102.55.80] Dec 8 13:23:06 mon-serveur pop3d: LOGIN FAILED, user=xgridagent, ip=[::ffff:94.102.55.80] Dec 8 13:23:11 mon-serveur pop3d: LOGIN FAILED, user=agent, ip=[::ffff:94.102.55.80] Dec 8 13:23:16 mon-serveur pop3d: LOGIN FAILED, user=xgridcontroller, ip=[::ffff:94.102.55.80] Dec 8 13:23:21 mon-serveur pop3d: LOGIN FAILED, user=jabber, ip=[::ffff:94.102.55.80] Dec 8 13:23:26 mon-serveur pop3d: LOGIN FAILED, user=amavisd, ip=[::ffff:94.102.55.80] Dec 8 13:23:31 mon-serveur pop3d: LOGIN FAILED, user=clamav, ip=[::ffff:94.102.55.80] Dec 8 13:23:37 mon-serveur pop3d: LOGIN FAILED, user=appserver, ip=[::ffff:94.102.55.80] Dec 8 13:23:42 mon-serveur pop3d: LOGIN FAILED, user=mailman, ip=[::ffff:94.102.55.80] Dec 8 13:23:47 mon-serveur pop3d: LOGIN FAILED, user=cyrusimap, ip=[::ffff:94.102.55.80] Dec 8 13:23:52 mon-serveur pop3d: LOGIN FAILED, user=qtss, ip=[::ffff:94.102.55.80] Dec 8 13:23:57 mon-serveur pop3d: LOGIN FAILED, user=eppc, ip=[::ffff:94.102.55.80] Dec 8 13:24:02 mon-serveur pop3d: LOGIN FAILED, user=telnetd, ip=[::ffff:94.102.55.80] Dec 8 13:24:07 mon-serveur pop3d: LOGIN FAILED, user=identd, ip=[::ffff:94.102.55.80] Dec 8 13:24:14 mon-serveur pop3d: LOGIN FAILED, user=gnats, ip=[::ffff:94.102.55.80] Dec 8 13:24:19 mon-serveur pop3d: LOGIN FAILED, user=jeff, ip=[::ffff:94.102.55.80] Dec 8 13:24:26 mon-serveur pop3d: LOGIN FAILED, user=irc, ip=[::ffff:94.102.55.80] Dec 8 13:24:34 mon-serveur pop3d: LOGIN FAILED, user=list, ip=[::ffff:94.102.55.80] Dec 8 13:24:39 mon-serveur pop3d: LOGIN FAILED, user=eleve, ip=[::ffff:94.102.55.80] Dec 8 13:24:46 mon-serveur pop3d: LOGIN FAILED, user=proxy, ip=[::ffff:94.102.55.80] Dec 8 13:24:53 mon-serveur pop3d: LOGIN FAILED, user=sys, ip=[::ffff:94.102.55.80] Dec 8 13:24:58 mon-serveur pop3d: LOGIN FAILED, user=zzz, ip=[::ffff:94.102.55.80] Dec 8 13:25:03 mon-serveur pop3d: LOGIN FAILED, user=frank, ip=[::ffff:94.102.55.80] Dec 8 13:25:08 mon-serveur pop3d: LOGIN FAILED, user=dan, ip=[::ffff:94.102.55.80] Dec 8 13:25:13 mon-serveur pop3d: LOGIN FAILED, user=james, ip=[::ffff:94.102.55.80] Dec 8 13:25:18 mon-serveur pop3d: LOGIN FAILED, user=snort, ip=[::ffff:94.102.55.80] Dec 8 13:25:23 mon-serveur pop3d: LOGIN FAILED, user=radiomail, ip=[::ffff:94.102.55.80] Dec 8 13:25:28 mon-serveur pop3d: LOGIN FAILED, user=harrypotter, ip=[::ffff:94.102.55.80] Dec 8 13:25:33 mon-serveur pop3d: LOGIN FAILED, user=divine, ip=[::ffff:94.102.55.80] Dec 8 13:25:39 mon-serveur pop3d: LOGIN FAILED, user=popa3d, ip=[::ffff:94.102.55.80] Dec 8 13:25:44 mon-serveur pop3d: LOGIN FAILED, user=aptproxy, ip=[::ffff:94.102.55.80] Dec 8 13:25:49 mon-serveur pop3d: LOGIN FAILED, user=desktop, ip=[::ffff:94.102.55.80] Dec 8 13:25:54 mon-serveur pop3d: LOGIN FAILED, user=workshop, ip=[::ffff:94.102.55.80] Dec 8 13:25:59 mon-serveur pop3d: LOGIN FAILED, user=mailnull, ip=[::ffff:94.102.55.80] Dec 8 13:26:04 mon-serveur pop3d: LOGIN FAILED, user=nfsnobody, ip=[::ffff:94.102.55.80] Dec 8 13:26:09 mon-serveur pop3d: LOGIN FAILED, user=rpcuser, ip=[::ffff:94.102.55.80] Dec 8 13:26:14 mon-serveur pop3d: LOGIN FAILED, user=rpc, ip=[::ffff:94.102.55.80] Dec 8 13:26:19 mon-serveur pop3d: LOGIN FAILED, user=gopher, ip=[::ffff:94.102.55.80]

On voit les signes typiques d'une attaque par dictionnaire. Le méchant essaie automatiquement plein d'identifiants courants et, probablement, des mots de passe simples comme l'identifiant lui-même. Ces noms correspondent à des identifiants courants pour des personnes (jeff, dan, james) ou pour des fonctions systèmes (sys, amavisd, mailman). Certains sont particulièrement pittoresques (harrypotter ou gopher, ce dernier semblant indiquer que le pirate n'a pas mis à jour son dictionnaire depuis longtemps). Sur ce serveur particulier, beaucoup d'utilisateurs n'appliquent pas les bonnes pratiques de sécurité, croyant que leur compte personnel sur un serveur isolé n'attirera l'attention de personne, et oubliant les vers infatigables qui, vingt-quatre heures sur vingt-quatre, balayent tous les serveurs.

Au fait, pourquoi POP ? Même si le méchant trouve un mot de passe,

à quoi cela lui servira-t-il ? Certes, il pourra lire le courrier de

cet utilisateur mais il n'y trouvera probablement pas de révélations

sensationnelles. Espère-t-il pouvoir ensuite tester SSH avec le même

identifiant et le même mot de passe pour avoir un accès

shell ? (Sur la plupart des sites, et pour de

très bonnes raisons, les comptes

POP ne donnent pas accès à un shell, soit parce qu'il n'ont pas de

shell, soit par des techniques comme le AllowUsers de

OpenSSH.) Ou bien connaissait-il une

vulnérabilité d'un serveur POP courant (avez-vous reconnu le serveur

utilisé ci-dessus ?), dont l'exploitation nécessitait

un compte valide ? Je l'ignore.

Comment détecter ce genre d'attaques ? Un

tail -f en permanence est

certes distrayant mais peu réaliste : on ne peut pas regarder des

journaux toute la journée. Il existe plusieurs outils d'analyse de

ceux-ci, qui envoient des synthèses, mais la plupart nécessitent pas

mal de réglages avant d'arrêter d'inonder leur propriétaire sous les

alarmes. Pour le cas d'un serveur dédié de peu d'importance, où

l'administrateur système ne peut pas passer plusieurs heures par jour

à le surveiller, je n'ai pas encore trouvé de mécanisme d'alarme

simple et efficace.

L'article seul

Testing Wikileaks DNS mirrors

First publication of this article on 10 December 2010

Among the efforts to prevent censorship to take down WikiLeaks, several persons have set up DNS mirrors. They are names that point, not to one Web server but to a list of IP addresses which host a Web mirror. These lists can be quite long and it is better to have an automatic tool to test them.

There is a technical reason why you cannot put the IP address of any WikiLeaks Web mirror in a DNS record for

wikileaks.anything.example: the

HTTP protocol expects a

Host: header in the query and dispatches the

request to the proper virtual host, depending on this header. If the

header is missing or wrong, you are sent to the "default" virtual

host, which may be quite different from what you expect. So, you

cannot just take a list of Web mirrors and add their IP addresses, you

need to test.

The program test-wikileaks.py, written in

Python, does exactly that: it takes the IP

addresses from a name, and performs a HTTP connection to this address,

retrieves a page and searches if it looks like a correct Wikileaks

page. If not, it complains:

% test-wikileaks.py wikileaks.jmp.net Wrong data in http://88.80.13.160/cablegate.html, not a Wikileaks mirror?

Note well that it does not mean that

wikileaks.jmp.net is wrong, just that it is not a

DNS mirror, you cannot copy its addresses blindly.

If you want more details, you can use the -v

option:

% test-wikileaks.py -v wikileaks.jmp.net Testing http://46.59.1.2/cablegate.html... 1269 cables Testing http://88.80.13.160/cablegate.html... Wrong data in http://88.80.13.160/cablegate.html, not a Wikileaks mirror? Testing http://213.251.145.96/cablegate.html... 1269 cables

It shows also the current number of diplomatic cables uploaded on this

mirror. This is important because some mirrors are really behind. Here

is a test on a large mirror, wklk.eu.org:

wklk.eu.org-test-2010-12-10.txt. Thanks to Pierre Beyssac for his

contributions to this program.

Oh, by the way, my DNS mirrors are

wikileaks.bortzmeyer.fr (a small subset) and

all-wikileaks.bortzmeyer.fr (a larger set, which

may create problems with some DNS resolvers).

L'article seul

Avec des logiciels pareils sur l'App Store, plus besoin de virus

Première rédaction de cet article le 9 décembre 2010

Dave Winer raconte sur son excellent blog, une curieuse aventure qui lui est arrivée avec son iPhone. Il a installé une nouvelle application (de partage de photos) sur son smartphone et découvert que celle-ci lisait son carnet d'adresses avant de l'envoyer au site maître (le tout, évidemment, sous couvert d'améliorer the user experience). Par delà l'immoralité de l'entreprise Path.com, cet incident donne à réfléchir sur le modèle de sécurité des smartphones.

L'auteur s'indigne en effet de ce qu'aucun avertissement ne soit apparu. On installe une application non libre censée permettre de partager des photos et elle accède au carnet d'adresses, et elle l'envoie sans demander d'autorisation, sans même qu'on soit prévenu ! Tout logiciel qui fait cela est habituellement nommé malware mais, ici, comme il est distribué sur l'App Store, il échappe à cette qualification, pourtant bien méritée.

Comment l'utilisateur d'un smartphone est-il protégé contre ce genre d'attaques ? L'essentiel de la (passionnante) discussion dans les commentaires a porté sur ce point. Sur iPhone, le système installe une application sans limiter ses privilèges, sans dire à l'utilisateur ce que cette application va faire. C'est pareil sur un Unix normal, me direz-vous. Certes, mais la plupart des logiciels (la totalité, dans mon cas) qu'on utilise sur Unix sont du logiciel libre et le fait que le code source soit accessible (même s'il n'est pas toujours lu) limite sérieusement les tentations pour les auteurs. Au contraire, avec le logiciel privateur, pas de code source et l'entreprise qui l'écrit peut donc avoir envie d'en profiter, d'en abuser.

Normalement, tout logiciel distribué sur l'App Store est validé par Apple. Ce pouvoir exorbitant a mené à bien des dérapages (croisade à l'iranienne contre la pornographie, censure des documentations sur les systèmes concurrents) mais, en théorie, il devait protéger l'utilisateur de tas de choses désagréables qu'on a sur un ordinateur Windows et qu'on ne voudrait pas trouver sur son téléphone, notamment les virus. L'expérience malheureuse de Dave Winer montre que cela ne marche pas. Il est probable que l'évaluation que fait Apple des logiciels ne se base que sur des considérations business et certainement pas sur le respect de la vie privée des futurs utilisateurs.

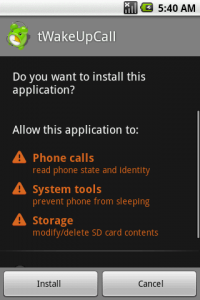

Existe-t-il des meilleurs mécanismes pour prévenir l'utilisateur de

ce que va faire l'application qui l'installe ? Sans doute mais, comme

souvent en matière de sécurité, il n'y a pas de solution idéale, ledit

utilisateur étant souvent le maillon faible. Sur

Android, lors de l'installation d'une

application (qu'elle vienne du

Market officiel ou pas),

l'utilisateur est prévenu des privilèges que demandera

l'application. Trouvé sur un article

sur la sécurité d'Android, voici un exemple de ce qu'affiche le

téléphone :

Ce mécanisme n'est pas

parfait. D'abord, comme souvent dès qu'on demande à l'utilisateur,

celui-ci cliquera souvent Oui sans même réfléchir, quelle que soit la

longueur de la liste des privilèges demandés. Et, même s'il ne faut

pas être informaticien pour comprendre qu'un logiciel qui affiche

les horaires des prochains bus n'a pas besoin d'avoir accès au carnet

d'adresses, en pratique, le temps manque et le cerveau ralentit dès

qu'il est confronté à un ordinateur. À la décharge de l'utilisateur,

il faut

ajouter que le mécanisme d'approbation est binaire : soit on accepte

toute la liste (et, avec certaines applications, elle est longue),

soit on ne peut pas utiliser l'application du tout. Il n'y a hélas pas moyen de dire

« Je veux bien que tu lises le GPS mais ne touche pas au carnet d'adresses ». (Il existe des solutions non-standard comme celle de CyanogenMod.)

Ce mécanisme n'est pas

parfait. D'abord, comme souvent dès qu'on demande à l'utilisateur,

celui-ci cliquera souvent Oui sans même réfléchir, quelle que soit la

longueur de la liste des privilèges demandés. Et, même s'il ne faut

pas être informaticien pour comprendre qu'un logiciel qui affiche

les horaires des prochains bus n'a pas besoin d'avoir accès au carnet

d'adresses, en pratique, le temps manque et le cerveau ralentit dès

qu'il est confronté à un ordinateur. À la décharge de l'utilisateur,

il faut

ajouter que le mécanisme d'approbation est binaire : soit on accepte

toute la liste (et, avec certaines applications, elle est longue),

soit on ne peut pas utiliser l'application du tout. Il n'y a hélas pas moyen de dire

« Je veux bien que tu lises le GPS mais ne touche pas au carnet d'adresses ». (Il existe des solutions non-standard comme celle de CyanogenMod.)

Autre limitation de ce mécanisme de sécurité : il ne limite pas ce que fait l'application qui avait un accès. Par exemple, il est tout à fait normal qu'un client SIP ait accès au carnet d'adresses mais ensuite, je ne veux pas qu'il l'envoie à un tiers, ce que font pourtant certains logiciels (voir une bonne étude à ce sujet).

Au fait, s'il y a des utilisateurs de MeeGo qui lisent ceci, comment cela se passe-t-il sur ce système ? Ces problèmes de donner à des applications des privilèges, avec une certaine granularité, me rappelle mon travail passé comme ingénieur système sur VMS : contrairement au modèle Unix binaire (root / pas root, avec root qui a tous les droits), VMS avait un système de permissions très riche, où on pouvait ne donner à une application que certains droits. Une des faiblesses de ce mécanisme était la longueur de la liste des droits possibles, que peu de gens maîtrisaient. Une autre faiblesse était que certains droits, sans que cela soit clairement documenté, permettait d'en acquérir d'autres (je me souviens bien du privilège « Change Mode to Kernel » qui permettait d'écrire dans les métadonnées du processus... où la liste des droits était stockée). Android a-t-il de telles faiblesses ? Si une chose est sûre en matière de sécurité, c'est que concevoir un système invulnérable est fort difficile : des failles inattendues surgissent toujours (pour Android, voir par exemple Soundminer).

Sur la question de limiter les privilèges d'une application inconnue et peut-être malveillante, il y a aussi :

- Les solutions à base de machines virtuelles comme Qubes,

- Les mécanismes à base de privilèges pour les applications, comme celui de VMS cité plus haut ou comme cela existe sur Linux (voir une bonne discussion suite à un très intéressant article de Brad Spengler, sur les limites de ces capacités).

- Le modèle de sécurité d'Android est très bien décrit dans la documentation officielle.

Merci à Vincent-Xavier Jumel pour ses suggestions.

Notez qu'Apple n'a nullement corrigé le problème qui reste, début 2012, aussi préoccupant qu'avant.

L'article seul

RFC 6057: Comcast's Protocol-Agnostic Congestion Management System

Date de publication du RFC : Décembre 2010

Auteur(s) du RFC : C. Bastian (Comcast), T. Klieber (Comcast), J. Livingood (Comcast), J. Mills (Comcast), R. Woundy (Comcast)

Intérêt historique uniquement

Première rédaction de cet article le 8 décembre 2010

Pour tout FAI, la gestion de la congestion est un problème récurrent. Même avec de très gros tuyaux, les utilisateurs, avides de profiter de leur abonnement à l'Internet (et poussés par des évolutions comme le remplacement de cours sous forme texte par des conneries multimédia genre webinar), envoient de plus en plus de paquets. Beaucoup de FAI, lors de débats sur la neutralité du réseau défendent leur droit à « gérer la congestion » par tous les moyens, même les plus inavouables. C'est ainsi que l'un des plus gros FAI états-uniens, Comcast, s'est rendu célèbre en usurpant l'adresse IP de ses propres abonnés pour couper leurs sessions BitTorrent fin 2007. Ces méthodes de cow-boys ont suscité beaucoup de protestation et, dans ce RFC, Comcast annonce un changement de cap et l'adoption d'un nouveau système de gestion de la congestion, neutre (protocol agnostic car « neutre » est un gros mot pour les FAI) et fondé sur des mesures objectives (le nombre d'octets envoyés ou reçus). Ce système est mis en œuvre dans le réseau de Comcast depuis la fin de 2008.

Comcast, qui connecte des dizaines de

millions de foyers états-uniens, notamment par le

câble (des détails sur leur réseau figurent en

section 7), s'est donc fait allumer par la

FCC au sujet de ses curieuses pratiques de

gestion du réseau, qui consistaient à générer, depuis un boîtier

Sandvine, des faux paquets

TCP de type RST

(Reset) prétendant venir des pairs, de manière à

couper les sessions pair-à-pair (voir le rapport très détaillé de l'EFF ou son résumé à Ars Technica). Ce mécanisme

visait, de manière complètement arbitraire, un protocole réseau

particulier, BitTorrent.

La section 1 du RFC resitue le problème de la congestion. TCP est un protocole gourmand : tant qu'il n'y a pas de perte (cf. RFC 7680) de paquets, il va augmenter le débit jusqu'à ce que le réseau ne puisse plus suivre et le signale en laissant tomber certains paquets (TCP réduira alors le débit). La congestion est donc un état normal du réseau (sinon, cela veut dire qu'il est sous-utilisé).

Le mécanisme déployé étant spécifique au réseau de Comcast, il est

utile, pour suivre le RFC, de bien apprendre la section 3 sur la

terminologie, notamment si on n'est pas habitué aux réseaux par

câble TV coaxial. Ainsi, un modem

câble est le CPE, l'engin placé

chez le client, et un CMTS

(Cable Modem Termination System, cf. section 2.6 du

RFC 3083) est l'équipement

situé dans les locaux du FAI où sont connectés les clients

(à peu près l'équivalent d'un DSLAM pour les

FAI ADSL). Le tout fonctionne grâce à la norme

DOCSIS dont les documents sont disponibles en

http://www.cablelabs.com/. D'autre part, la rubrique

terminologique en section 3 référence également les RFC sur la

qualité de service, les RFC 1633 et

RFC 2475.

Le nouveau système de contrôle de la congestion a évolué, comme le résume la section 4, en partie en suivant les débats à l'IETF comme l'atelier de 2008, qui a été documenté dans le RFC 5594. La contribution de Comcast à cet atelier consistait en un document « Service Provider Perspective ». Le système décrit par Comcast à l'occasion de cet atelier (et qui avait été également présenté dans les réponses de Comcast à la FCC, qui était mécontente du système de piratage des sessions BitTorrent) a été progressivement déployé à partir de la fin de 2008.

En quoi consiste ce système de contrôle de la congestion ? La section 5 résume ses principes. Plusieurs éléments du réseau étant partagés, le but du système est de partager « équitablement » ces éléments (le terme « équitablement » est entre guillemets dans le RFC car il n'est pas évident d'en donner une définition rigoureuse). D'autre part, le système actuel est agnostique (le RFC aurait pu dire « neutre » mais la plupart des FAI ne veulent pas entendre parler du concept de neutralité), c'est-à-dire qu'il ne cible pas un protocole particulier, il tient juste compte d'un facteur objectif : le débit de la ligne de l'abonné. L'algorithme (simplifié) est donc le suivant : le logiciel surveille en permanence l'usage des ressources réseau. Si l'une de celles-ci devient congestionnée, le logiciel regarde quel client sur cette ressource consommait plus que les autres et lui affecte une priorité plus basse. Cela n'aura pas de conséquence pratique si les lignes ont de la capacité suffisante mais, si la congestion empêche de faire passer tous les paquets, ceux de ce(s) client(s) seront retardés, voire jetés (cela peut sembler violent mais c'est le mécanisme normal d'IP pour gérer la congestion ; les protocoles de transport savent réagir à ce problème, par exemple TCP réduit automatiquement son débit). Si le client diminue son usage, sa priorité redevient normale.

Ne serait-ce pas préférable, en cas de congestion, d'augmenter la capacité du réseau ? Certes, dit la section 6, mais le problème est plus compliqué que cela. D'abord, l'ajout de capacité nécessite souvent des travaux matériels, qui prennent du temps. Ensuite, quelle que soit la capacité du réseau, il y aura des pics de trafic imprévus et aucun réseau ne peut être assez dimensionné pour éviter complètement la congestion. (De même qu'aucun autoroute ne peut être assez large pour un samedi 1er août.) Pouvoir gérer la congestion est donc une nécessité.

Quelles sont les valeurs numériques exactes utilisées pour des opérations comme « abaisser la priorité » ? L'abaisser de combien ? Et que veut dire exactement « proche de la congestion » ? 90 % 95 % ? La section 7 du RFC traite de l'implémentation concrète des principes de la section 5. Elle commence par un excellent résumé de l'architecture du réseau de Comcast, où 3 200 CMTS servent environ 15 millions d'utilisateurs. Le réseau, comme illustré dans la figure 1 du RFC, est en fait mixte, les CMTS étant connectés en fibre optique, seul le dernier mile étant en câble de cuivre coaxial. La section 7.1 définit ensuite rigoureusement la métrique utilisée pour déclarer qu'un CMTS approche de la congestion. Ensuite, la valeur numérique a été déterminée par des essais en laboratoire : aujourd'hui 70 % d'utilisation en montée et 80 % en descente pendant 5 minutes de suite. La section 7.2 traite de la seconde partie de l'algorithme : définir ce que signifie, pour un utilisateur, « consommer plus que sa part ». (Les chiffres exacts dépendent de l'abonnement qu'il a souscrit : les riches ont plus que les pauvres.)

Ce RFC n'hésite pas devant les chiffres précis. Ainsi, un exemple donné est celui d'un abonné à un service à 22 Mb/s descendants. Malgré plusieurs usages simultanés (un flux vidéo HD depuis Hulu à 2,5 Mb/s, un appel Skype à 131 kb/s, et un flux musical à 128 kb/s), il reste en dessous de la limite. L'idée est donc que beaucoup d'utilisations, même multimédia, n'amèneront pas à la limite. Lors de tests avec de vrais utilisateurs, par exemple à Colorado Springs en 2008, 22 utilisateurs sur 6 016 ont été « déprioritisés ». Lors de tels tests, quel a été le ressenti des utilisateurs ? La section 7.3 note simplement que personne ne s'est plaint.

La section 9 argumente même que ce mécanisme, prévu pour gérer la minorité la plus gourmande des utilisateurs, est aussi utile en cas de congestion plus globale. Par exemple, si une brusque épidémie de grippe se développe, forçant l'arrêt des transports publics et amenant de nombreuses entreprises à fermer, le télétravail depuis la maison va brusquement augmenter. Le réseau tiendra-t-il ? En tout cas, le même mécanisme de gestion de la congestion peut être utile.

Rien n'étant parfait en ce bas monde, quelles sont les limites de ce système ? La section 10 en cite quelques unes. Entre autres, le mécanisme de Comcast ne signale pas à l'utilisateur qu'il a été déprioritisé. Cela empêche ses applications de s'adapter (par exemple en basculant vers une résolution vidéo plus faible) et l'utilisateur de changer son comportement.

D'autres mécanismes de contrôle de la congestion pourraient apparaître plus tard, par exemple issus des travaux de l'IETF, que la section 11 résume. Des groupes de travail comme Conex (signalisation explicite de la congestion), Alto (recherche du meilleur pair dans un réseau pair-à-pair) ou Ledbat (transfert de grosses quantités de données en arrière-plan, en se glissant dans les moments où le réseau est libre) produiront peut-être des solutions meilleures (voir le RFC 6817 pour Ledbat).

Enfin, la section 12, sur la sécurité, est une lecture intéressante : à chaque fois qu'on construit un tel appareillage, il faut se demander s'il ne risque pas d'être mal utilisé. Ici, la principale crainte est le risque d'injection de fausses données, pour bloquer les utilisateurs (une attaque par déni de service). Les équipements de statistiques doivent donc être protégés contre un accès non autorisé. Moins grand est le risque pour la vie privée : si le trafic par modem (donc par foyer) est stocké, cela n'inclut pas les adresses IP de destination, les ports, etc.

Arrivé au terme de ce très intéressant document, très détaillé (il faut noter qu'aucun FAI dans le monde n'a fait un tel effort de documentation, comparez par exemple avec le silence complet que maintient Free face aux accusations de shaping), quel bilan tirer ? D'abord, que les protestations des clients, de l'EFF et les menaces de la FCC ont eu un effet positif. Ensuite, je pense personnellement que le système est bon dans son principe. Face à la congestion, un problème auquel peut être confronté tout réseau, quelles que soient les dimensions de ses tuyaux, il est nécessaire de prendre des mesures. Celles-ci doivent être publiquement exposées (et, on l'a dit, Comcast est le seul à le faire) et être non-discriminatoires, fondées sur des problèmes objectifs (le débit dans les tuyaux) et pas sur les intérêts financiers du FAI (comme les opérateurs 3G qui interdisent la VoIP mais qui autorisent la vidéo ; cette dernière consomme pourtant bien plus de ressources mais, elle, elle n'empiète pas sur le business traditionnel de l'opérateur...). Donc, le principe du système de gestion de la congestion de Comcast est bon. Maitenant, tout est dans l'exécution en pratique. Le système effectivement déployé est-il celui décrit ? Les évolutions futures respecteront-elles les principes posés ? Poser la question n'est pas de la paranoïa. Comcast a déjà menti, par exemple en niant la création de faux TCP resets même si la section 8 du RFC reconnait aujourd'hui leur usage (cf. RFC 3360). Le lecteur des aventures de Thursday Next pensera certainement au tome 4, « Something rotten », où la tentaculaire société Goliath tente de faire croire qu'elle est devenue une église n'agissant plus que pour le bien commun...

Ce RFC a été reclassé « intérêt historique seulement » en août 2020, Comcast n'utilisant plus ce système.

L'article seul

RFC 6067: BCP 47 Extension U

Date de publication du RFC : Décembre 2010

Auteur(s) du RFC : M. Davis (Google), A. Phillips (Lab126), Y. Umaoka (IBM)

Pour information

Première rédaction de cet article le 8 décembre 2010

Le RFC 5646 (alias « BCP 47 » pour Best Common Practice 47), qui normalise les étiquettes de langue, prévoyait un mécanisme d'extension par le biais de sous-étiquettes d'un seul caractère. Ce RFC 6067 spécifie la première de ces extensions à rentrer en service, pour indiquer l'information de localisation du consortium Unicode.

Les étiquettes de langue sont utilisées pour

marquer du contenu sur le Web mais également en

plein d'autres endroits, afin d'indiquer la

langue utilisée. Leur norme, le RFC 5646 décrit un mini-langage permettant d'indiquer la langue

mais aussi l'écriture, le

pays, voire la variante dialectale. Ainsi,

ru-petr1708 désignera le

russe tel qu'il était écrit dans l'ortographe

de Pierre Ier, avant la réforme de 1917. Ce

langage de construction des étiquettes est très riche mais ne permet

de faire une étiquette qu'à partir de sous-étiquettes déjà

enregistrées dans le registre

des langues (ou bien à partir de sous-étiquettes purement

privées). Il n'y a notamment pas de moyen pour utiliser les catalogues

existants.

Or, un de ces catalogues est particulièrement utilisé, le catalogue

des locales décrit dans le

TR35 et géré par

le consortium

Unicode. C'est pour pouvoir l'utiliser que l'extension « u »

est créée par notre RFC. (Le singleton « u » voulant dire Unicode.) Il

permettra d'étiqueter avec davantage de précision un document. Ainsi,

en-u-cu-usd désignera un texte en

anglais dont, grâce à l'extension « u », on

pourra savoir qu'il utilise le dollar états-unien

(usd) comme

unité monétaire.

Les données utilisables avec cette extension proviennent du CLDR, le grand dépôt des locales géré par le consortium Unicode et qui contient des choses aussi variées que les jours fériés par pays ou bien les différents ordres de tri utilisés.

Le RFC 5646/BCP 47 (section 3.7) impose un certain nombre de règles pour la création d'une extension, notamment l'indication précise de l'autorité en charge du catalogue accessible via l'extension, et de ses politiques. La section 2 de notre RFC 6067 satisfait à cette règle en décrivant comment est géré CLDR.

Maintenant, quelle information peut-on indiquer avec l'extension

« u » ? La section 2.1 les liste en renvoyant à la section 3 du

TR35. On peut indiquer des attributs, des clés et des

types. Aujourd'hui, aucun attribut n'est défini. Les clés, elles, ont

exactement deux caractères et sont

définis par le TR35. ca désigne un calendrier,

co un ordre de tri, cu la monnaie, tz le fuseau horaire, etc. Les types sont les

valeurs associées aux clés. Ainsi, ca-coptic

désigne le calendrier copte. Une étiquette

complète comme de-DE-u-co-phonebk sera

« l'allemand tel qu'écrit en

Allemagne, utilisant l'ordre de tri

phonebk, i.e. celui normalisé pour

l'annuaire téléphonique (qui se nomme

phonebook dans CLDR, qui n'a pas les mêmes

contraintes de taille) ». en-u-tz-usden sera

l'anglais avec le fuseau

horaire

Mountain Time. Et

es-u-cu-mxn sera

l'espagnol avec comme unité monétaire le

peso mexicain. Bien sûr, dans la plupart des

cas, il n'y aura pas besoin d'étiqueter les textes avec ce niveau de

précision. (Merci à Doug Ewell pour la plupart des exemples.) Mais certaines utilisations pourront en avoir besoin.

CLDR distribue des fichiers contenant les informations nécessaires

pour tous les types possibles en http://unicode.org/Public/cldr/. Si vous voulez l'ordre de tri allemand,

il est en common/collation/de.xml.

La section 2.2 du RFC contient le formulaire d'enregistrement obligatoire (RFC 5646, section 3.7) pour une extension. « u » est donc désormais le premier élément du registre des extensions..

Attention à un petit piège : les extensions comme « u » n'ont rien à voir avec les Extended Language Subtags (alias extlangs), qui sont un mécanisme (pas le seul) pour représenter des idiomes intermédiaires entre une « vraie » langue et un dialecte.

L'article seul

À propos de Wikileaks

Première rédaction de cet article le 4 décembre 2010

Je suis désolé pour mes lecteurs qui apprécient les articles techniques, j'avais en effet plein de sujets techniques rigolos et intéressants à traiter mais, parfois, l'actualité commande de remettre les sujets geeks à plus tard et de s'intéresser à la vie de la société. Bien sûr, tout le monde a déjà parlé de WikiLeaks, mais je crois qu'un nouveau seuil a été franchi par les puissants de ce monde dans une guerre, non pas contre l'Internet mais contre la liberté d'expression.

Je n'ai en effet pas l'intention d'analyser WikiLeaks, de dire si c'est utile ou pas. Que Wikileaks joue un rôle positif ou pas, leur liberté d'expression doit être défendue de la même façon. Même s'ils font des choses illégales ? Mais je note qu'aucun gouvernement, même aux États-Unis, n'a osé traîner Wikileaks devant un tribunal pour ses publications. En France, le ministre des expulsions a hypocritement demandé au CGIET de lui trouver des moyens d'interdire Wikileaks, reconnaissant ainsi qu'il ne pouvait pas trouver de raison juridique valable de le faire. Le voici réduit à chercher n'importe quelle astuce lui permettant d'arriver à ses fins.

Mais pourquoi est-ce que Wikileaks gêne les pouvoirs en place ? Ce n'est pas que les révélations du « Cablegate » aient été si fracassantes que cela, jusqu'à présent. Il est bien sûr utile d'apprendre que la loi Hadopi a été rédigée sous stricte surveillance états-unienne. Mais la plupart des révélations n'ont pas une grande portée (l'ambassadeur des États-Unis pense que Sarkozy est un nerveux : grande nouvelle).

Non, le problème des gens de pouvoir est qu'ils vivaient dans une bulle : isolés de tout et surtout des citoyens, ils s'étaient habitués à ne pas avoir à rendre de comptes. Le coup de projecteur les rabaisse soudain au niveau de n'importe quel citoyen espionné grâce au Patriot Act ou grâce aux écoutes téléphoniques.

Ce choc soudain, d'être écouté comme un vulgaire journaliste de Mediapart ou comme un simple citoyen vidéo-surveillé, a déclenché une campagne anti-WikiLeaks, bien plus forte que celle provoquée par les précédentes révélations de Julian Assange, qui concernaient pourtant des affaires militaires, a priori plus sensibles... Cette haine de Wikileaks va très loin et des oubliées du cirque médiatique comme Catherine Nay (qui, quand elle était journaliste, n'a effectivement jamais révélé quoi que ce soit qui puisse nuire aux puissants...) en profitent pour essayer de se faire un peu de publicité en comparant « la menace Internet » à la Stasi en pire (technique classique de troll que d'exagérer pour être sûr de faire parler de soi). De même, une députée UMP, Muriel Marland-Militello, a saisi l'occasion en demandant l'interdiction de WikiLeaks, et en reprenant le concept sarkozyen d'« Internet civilisé ». Je dois dire que, la première fois que j'avais entendu ce terme digne de « Tintin au Congo », je croyais que c'était une blague. Mais non. Le parti qui voulait faire rentrer dans les têtes des enfants le rôle positif de la colonisation voudrait désormais civiliser les indigènes de l'Internet. Et comment Marland-Minitello justifie-t-elle l'interdiction de WikiLeaks ? « La liberté de chacun [...] a pour limite infrangible la sûreté des Etats ». Donnez cette phrase sans son contexte à plusieurs personnes et demandez l'auteur. Ils répondront probablement « Le Parti Communiste chinois ou bien « Le dictateur tunisien Ben Ali » mais ne penseront pas au parti actuellement majoritaire au Parlement français. Certains se sont dit « Quelle importance, ce n'est qu'une petite députée inconnue » mais elle affiche en gros le logo du parti du Président sous son texte.

Cette réaction corporatiste des politiciens contre WikiLeaks (on est pour qu'on puisse espionner tout le monde avec Echelon mais pas pour que WikiLeaks nous espionne, nous) est également partagée par les journalistes comme l'a bien analysé Éric Scherer.

(Au passage, pour une excellent analyse en profondeur de l'effet WikiLeaks, je vous recommande « Suites de la fuite », de Jean-Noël Lafargue et pour un excellent panorama juridique de la question, l'interview de Cédric Manara.)

Alors, que peut faire le citoyen face à cette campagne contre la liberté d'expression ? Je ne suis pas sûr qu'on puisse compter sur l'opposition officielle, qui semble complètement silencieuse à ce sujet. Il faut donc que les citoyens se manifestent eux-mêmes.

Bien sûr, des actions pratiques sur le terrain des réseaux

informatiques sont possibles et souhaitables. C'est ainsi que, en

réaction au retrait de l'hébergeur DNS de

wikileaks.org (qui a laissé ce domaine hors

d'usage), des dizaines de gérants de serveurs DNS ont créé des

wikileaks.quelquechose comme par exemple

wikileaks.bortzmeyer.fr

qui contiennent les adresses

IP des serveurs de Wikileaks qui fonctionnent (petit piège

du protocole HTTP : il faut que le serveur en

question accepte un champ Host: incorrect et

serve quand même Wikileaks). Ces noms, véritables

« miroirs DNS » sont ensuite publiés un peu partout (notamment sur

Twitter). Comme le note l'inventeur de

XML-RPC et RSS,

Dave Winer, « in a weird sort we have

implemented a human DNS ». Ces noms, et ceux de sites

qui hébergent une copie complète de WikiLeaks sont ensuite rassemblés

dans des pages comme http://etherpad.mozilla.org:9000/wikileaks, http://www.allyourleakarebelongtous.com/ ou http://bluetouff.com/2010/12/03/acceder-a-wikileaks/ qui, au fur et à

mesure que la censure les fait fermer, sont recopiées ailleurs. Encore

mieux, les services qui testent automatiquement tous ces miroirs,

comme http://www.whereiswikileaks.org/, de

façon à éviter de perdre du temps sur un miroir devenu caduc. Pour

ceux qui veulent créer un tel « miroir »,

Spyou explique comment. Pour les miroirs DNS, ceux qui en font

doivent prendre soin de mettre de courts TTL

(genre dix minutes) car les adresses IP des serveurs du contenu vont souvent

changer, et sans préavis (merci à Pierre Beyssac pour avoir attiré mon

attention à ce sujet). Il faut aussi les tests par exemple avec l'outil que je propose. Un autre projet est en cours de déploiement, le

mécanisme

automatique de recopie sur un grand nombre de miroirs

volontaires. J'ai deux machines candidates à ce service, mais ça ne fonctionne pas pour moi,

WikiLeaks ne les a jamais contactées. Attention toutefois aux problèmes de sécurité

si vous choisissez cette voie, cela peut valoir la peine de se

renseigner sur la technique d'abord. Plus geek, on trouve

les données de

WikiLeaks sous des formats très exotiques comme

RDF ou sous forme d'un moteur SPARQL.

Un tel système de contournement de la censure est complexe et nécessite des lecteurs très motivés, pour suivre les derniers changements. Mais elle a l'avantage, comme le notait Winer, de faire participer tout le monde et de montrer à la face des censeurs l'ampleur de la contestation. Ce n'est donc pas une solution purement technique et c'est justement son avantage.

Techniquement, une meilleure solution serait bien sûr d'avoir un autre système de résolution de noms (« DNS pair à pair ») et d'hébergement. J'ai récemment écrit sur la vanité qu'il y à croire qu'on trouvera la solution technique idéale, surtout face à une censure qui frappera simplement ailleurs. Seul avantage de cette discussion, cela a permis, sur la liste NANOG, de refaire parler d'UUCP, qui avait en effet un système de nommage pair à pair.

Une contradiction a été fort peu relevée dans les articles sur l'extension du domaine de la censure de l'Internet. C'est que les gouvernements démocratiques (les autres aussi, mais, dans ce cas, ce n'est pas une information, son entropie est nulle) sont tous occupés à mettre au point des mécanismes pour réaliser des DoS légales alors que, dans le même temps, des agences gouvernementales travaillent à essayer d'empêcher les attaques... Verra t-on bientôt la main gauche de l'État réclamer le déploiement de technologies visant à améliorer la sécurité, mais rendant la censure visible (comme DNSSEC) pendant que sa main droite fera des lois comme LOPPSI, qui imposent justement ce que DNSSEC ou la RPKI essaient d'empêcher ? Ainsi, au niveau européen, l'ENISA a un programme de développement de la résistance de l'Internet aux attaques (la censure en étant une), programme qui a fait récemment l'objet d'un atelier à Bruxelles. De même, l'ANSSI française a une activité sur ce même concept de résistance (pas besoin de WikiLeaks pour connaitre ce programme : il est discret mais n'a rien de secret). La même ANSSI est citée dans la lettre de Besson, qui lui donne l'ordre de contribuer à trouver un moyen de censurer WikiLeaks. Alors, résistance aux pannes ou contrôle accru ? Il va falloir choisir... Les deux sont complètement incompatibles : ce qui rend la censure si difficile à faire respecter, c'est justement ce qui rend l'Internet si robuste, la variété des connexions et des techniques, et surtout l'intelligence et l'initiative des acteurs.

L'article seul

RFC 2680: A One-way Packet Loss Metric for IPPM

Date de publication du RFC : Septembre 1999

Auteur(s) du RFC : Guy Almes (Advanced Network & Services), S. Kalidindi (Advanced Network & Services), M. Zekauskas (Advanced Network & Services)

Chemin des normes

Réalisé dans le cadre du groupe de travail IETF ippm

Première rédaction de cet article le 3 décembre 2010

Une des tristes réalités de l'Internet d'aujourd'hui est que les paquets se perdent. Ils quittent la machine émettrice et ne sont jamais reçus par la machine réceptrice. Il y a de nombreuses causes à cela (abandon du paquet par un routeur surchargé, par exemple), mais ce RFC 2680, comme les autres documents du groupe de travail IPPM se focalise sur la mesure du phénomène, pas sur ses causes. Il définissait donc une métrique « perte de paquet » permettant de comparer des mesures entre elles en sachant qu'on parle bien de la même chose. (Il a depuis été remplacé par le RFC 7680.)

Comme les autres RFC décrivant des

métriques, des grandeurs rigoureusement définies et qu'on va mesurer,

il s'appuie sur les définitions et le vocabulaire du RFC 2330. Par ailleurs, il suit de très près le plan du RFC 2679, qui spécifiait la mesure du délai

d'acheminement d'un paquet. Cette fois, ce qui est défini est une

mesure binaire (un paquet est perdu ou bien ne l'est pas),

Type-P-One-way-Loss, puis une statistique

pour le cas où il y a plusieurs paquets, le taux de

perte moyen. (Petit rappel : Type-P signifie que

le rapport de mesure doit indiquer le type du

paquet - protocole de transport, port, etc - car le

résultat peut en dépendre. Cf. section 2.8.1.)

Pourquoi cette métrique est-elle utile ? La section 1.1 rappelle l'intérêt de connaître les pertes :

- Certaines applications, notamment interactives, se comportent mal (ou pas du tout) si le taux de pertes dépasse un certain seuil.

- Les applications plus ou moins temps-réel aiment encore moins les pertes de paquets que les autres applications.

- Les protocoles de transport comme TCP compensent les pertes en réémettant les paquets mais un taux de pertes trop élevé les empêchera d'atteindre leur débit maximum.

Mais pourquoi mesurer les pertes sur un chemin aller-simple (one-way) plutôt que aller-retour (two-way) ? La célébrissime commande ping affiche en effet des pertes après un aller-retour (ici 57 %) :

% ping -c 19 198.51.100.80 PING 198.51.100.80 (198.51.100.80) 1450(1478) bytes of data. 1458 bytes from 198.51.100.80: icmp_seq=1 ttl=46 time=168 ms 1458 bytes from 198.51.100.80: icmp_seq=5 ttl=46 time=167 ms 1458 bytes from 198.51.100.80: icmp_seq=6 ttl=46 time=167 ms 1458 bytes from 198.51.100.80: icmp_seq=9 ttl=46 time=169 ms 1458 bytes from 198.51.100.80: icmp_seq=10 ttl=46 time=167 ms 1458 bytes from 198.51.100.80: icmp_seq=13 ttl=46 time=168 ms 1458 bytes from 198.51.100.80: icmp_seq=15 ttl=46 time=168 ms 1458 bytes from 198.51.100.80: icmp_seq=18 ttl=46 time=167 ms --- 198.51.100.80 ping statistics --- 19 packets transmitted, 8 received, 57% packet loss, time 18013ms rtt min/avg/max/mdev = 167.407/168.034/169.066/0.639 ms

Mais les mesures aller-retour ont bien des limites :

- Si le chemin est asymétrique, on mesure en fait les performances de deux chemins, l'aller et le retour, qui n'ont pas forcément les mêmes caractéristiques. Même si le chemin est symétrique (passage par les mêmes routeurs à l'aller et au retour), rien ne dit que les résultats soient les mêmes dans les deux sens : files d'attente différentes, QoS peut-être réglée différemment, etc.

- Beaucoup d'applications, par exemple les transferts de fichiers, voient leurs performances dépendre essentiellement d'un seul chemin (pour un transfert de fichiers, celui que suivent les données, pas le chemin inverse par lequel ne transitent que les petits accusés de réception).

Mais les mesures aller-simple sont plus difficiles à effectuer entre autres parce qu'elles ont souvent besoin d'horloges synchronisées (section 1.2). Le principe de la mesure de notre métrique est en effet d'émettre un paquet depuis la machine source à un temps T et de l'attendre à la machine destination jusqu'au temps T + t (où t est le délai qu'on accepte d'attendre). Si les deux machines ne sont pas synchronisées, leurs mesures de T vont différer, faussant ainsi les résultats. La section 1.2 rappelle donc le vocabulaire à utiliser pour évaluer la synchronisation. Les gourous de l'horlogerie verront qu'il est différent de celui des documents UIT comme le G.810, « Definitions and terminology for synchronization networks ».

- Synchronisation (synchronization) signifie que deux horloges sont d'accord entre elles sur l'heure qu'il est (time error pour l'UIT).

- Correction (accuracy) désigne le degré d'accord entre une horloge et la vraie heure UTC (time error from UTC pour l'UIT). Deux horloges peuvent donc être synchronisées et néanmoins incorrectes.

- Résolution (resolution) est la précision de l'horloge. Certains vieux Unix n'avancent ainsi l'horloge que toutes les dix ms et sa résolution est donc de 10 ms (cela se voyait bien avec la commande ping, qui n'affichait que des RTT multiples de 10). L'UIT dit sampling period.

- Décalage (skew) est le changement dans la synchronisation ou la correction. Il se produit lorsque l'horloge va plus ou moins vite qu'elle ne le devrait. L'UIT appelle cela time drift.

Une fois ces préliminaires achevés, la section 2 décrit la métrique

principale de notre RFC,

Type-P-One-way-Packet-Loss. Sa valeur est

simplement 0 lorsque le paquet est arrivé et 1 autrement.

Il y a bien sûr davantage de choses à dire sur cette métrique. Par exemple (section 2.5), faut-il distinguer le cas où un paquet a vraiment été perdu et le cas où il est simplement arrivé en retard, après l'expiration du délai ? En théorie, on devrait attendre 255 secondes, la durée de vie maximale d'un paquet IP (RFC 791, section 3.2). En pratique, on attendra moins longtemps : après tout, pour beaucoup d'applications, un paquet en retard n'a aucun intérêt, on peut aussi bien le considérer comme perdu. C'est l'approche retenue ici.

Et si le paquet arrive corrompu, le considère-t-on comme perdu ? Là encore, oui, pas de distinction. En effet, si le paquet est corrompu, on ne peut même pas être sûr qu'il était bien le paquet attendu, puisque les bits qui permettent de le reconnaître sont peut-être ceux qui ont été changés.

Même chose si le paquet est fragmenté et que certains des fragments n'arrivent pas à tout. On ne peut pas reconstituer le paquet, on le considère comme perdu. En revanche, la duplication, elle, n'est pas considérée comme une perte.

Notre RFC 2680 décrit une métrique (une grandeur définie rigoureusement), pas une méthodologie de mesure, encore moins un protocole. Toutefois, la section 2.6 donne des indications sur ce que pourrait être une telle méthodologie. Le mécanisme recommandé est de mettre une estampille temporelle dans le paquet émis, et de regarder à l'arrivée si on détecte le paquet au bout d'un temps « raisonnable ». À noter que cette méthode n'implique pas une stricte synchronisation des horloges entre les deux machines. On est loin d'un protocole complet (je n'ai pas l'impression qu'il ait jamais été mis au point) et, par exemple, on n'indique pas comment la destination sait qu'elle doit s'attendre à voir arriver un paquet.

Toute mesure implique des erreurs et des incertitudes et la section 2.7 les analyse. D'abord, si les horloges ne sont pas synchronisées du tout, un paquet peut être déclaré comme perdu à tort (si l'émetteur a une horloge qui retarde, le paquet arrivera tard et le destinataire aura pu s'impatienter et le considéré perdu). Même problème si le délai d'attente n'est pas raisonnable, si le destinataire renonce trop vite. Ces deux problèmes peuvent être évités en synchronisant à peu près les horloges (il suffit que leur écart soit petit par rapport au délai d'attente) et en choisissant bien le délai (par exemple, sur une liaison utilisant un satellite géostationnaire, la finitude de la vitesse de la lumière impose un délai d'attente minimum de 240 ms - 2 * 35 786 / 300 000).

Une troisième source d'erreur est plus subtile : le paquet peut arriver jusqu'à la machine de destination (donc le réseau fonctionne bien) mais celle-ci le rejeter car ses ressources (par exemple les tampons d'entrée/sortie) sont pleines. Pour éviter de compter à tort des paquets comme perdus, il faut s'assurer que la machine de mesure a des ressources suffisantes pour traiter tous les paquets.

La métrique présentée en section 2 était pour

un paquet. La section 3 définit une métrique

supplémentaires,

Type-P-One-way-Packet-Loss-Poisson-Stream pour le

cas où on utilise plusieurs paquets. Et la section 4 s'en sert pour

définir une statistique utile.

Type-P-One-way-Packet-Loss-Average (section 4.1)

est le taux de pertes moyen. Si

on envoie cinq paquets et que quatre arrivent, elle vaut 0,2 (c'est ce

qu'affiche ping sous l'intitulé %

packet loss).