Ce blog n'a d'autre prétention que de me permettre de mettre à la disposition de tous des petits textes que j'écris. On y parle surtout d'informatique mais d'autres sujets apparaissent parfois.

La ferme de compilation Cfarm

Première rédaction de cet article le 1 décembre 2023

Si vous êtes programmeuse ou programmeur, vous avez peut-être des problèmes de portabilité de vos programmes, et vous souhaitez les tester sur d'autres plate-formes que celles où vous avez accès habituellement. C'est le but des fermes de compilation et cet article va présenter la Cfarm, sur laquelle je viens d'avoir un compte.

Donc, le principe d'une ferme de compilation : beaucoup de machines, de types et de systèmes d'exploitation différents, auxquelles vous pouvez accéder via SSH et tester vos programmes. C'est surtout utile pour les langages de bas niveau comme C, il y a sans doute moins de problèmes de portabilité en Python ou Haskell…

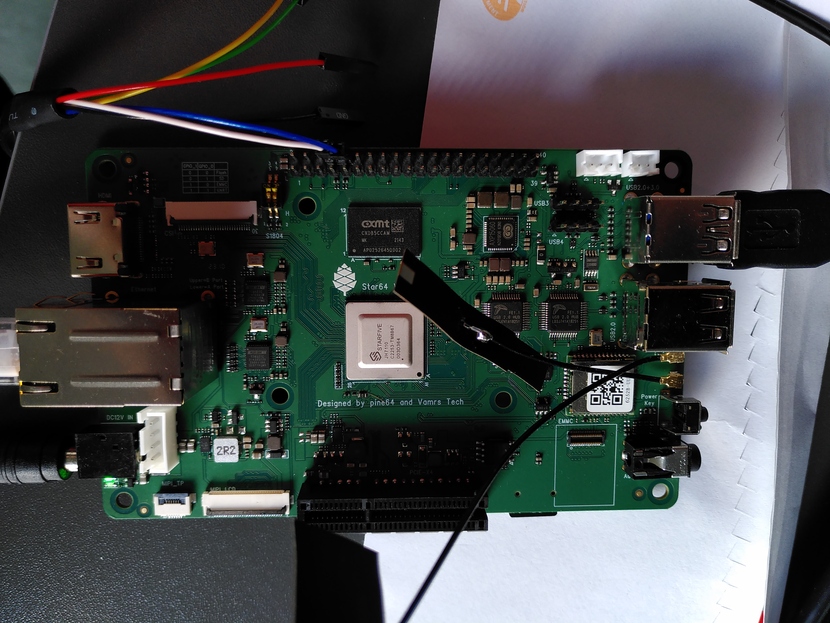

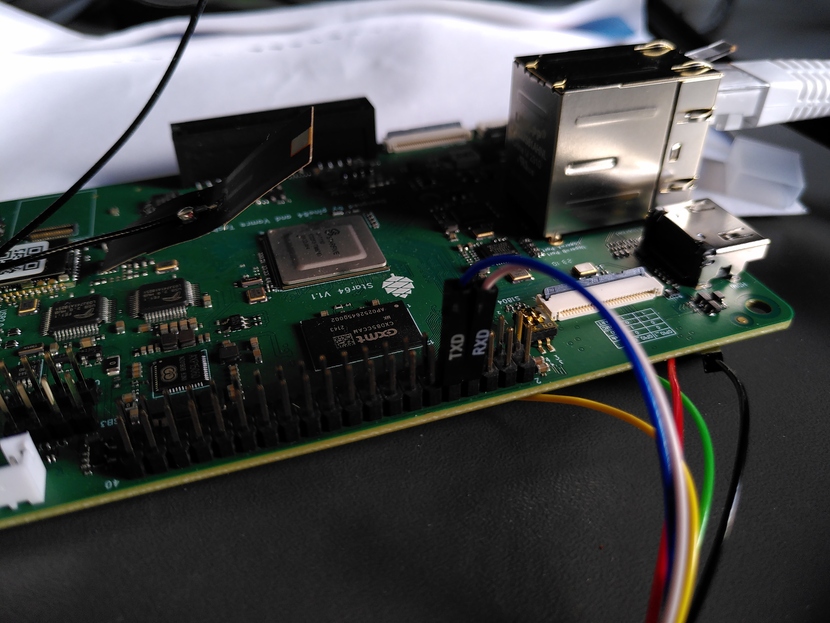

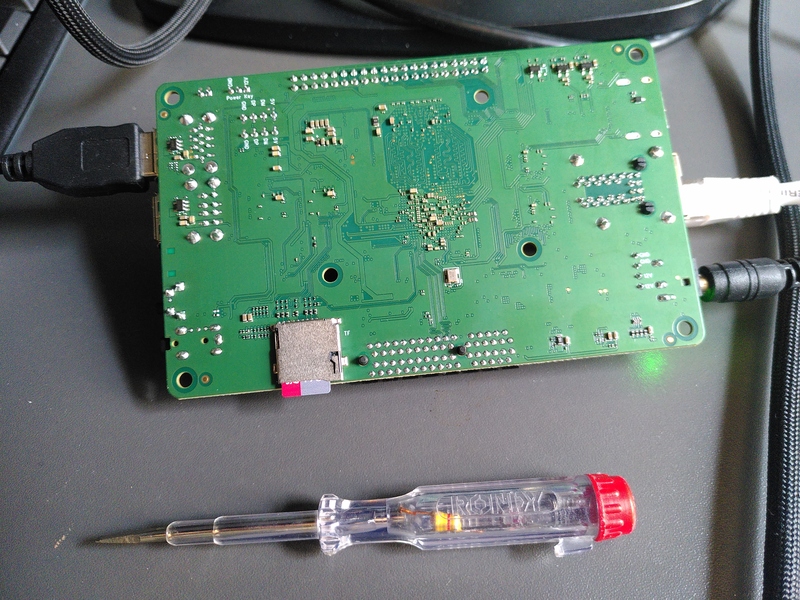

La Cfarm est réservée aux programmes libres. Pour avoir un compte, vous devez remplir un formulaire où vous indiquez notamment les projets de logiciel libre que vous maintenez. Votre compte est ensuite approuvé (dans mon cas, cela avait pris moins de 24 heures) et vous pouvez alors vous connecter sur le site Web, et indiquer des clés SSH qui seront automatiquement copiées sur toutes les machines, vous permettant de vous connecter (mais vous ne serez évidemment pas root). La liste des machines est longue ! Et elle contient des types devenus rares, par exemple des processeurs PowerPC, qui sont utiles car ce sont dans les rares à être gros-boutiens. J'aime bien aussi la machine ARM faisant tourner FreeBSD. Et, oui, il y a une RISC-V, si vous ne voulez pas en acheter une.

Pour vous simplifier la vie, si vous travaillez sur plusieurs de

ces machines, OpenSSH permet des

configurations globales, voici mon

~/.ssh/config :

Host *.cfarm.net User bortzmeyer IdentityFile ~/.ssh/id_cfarm

Notez que j'utilise une clé ed25519 mais la documentation note bien que certains vieux systèmes ne connaissent pas cet algorithme, et elle suggère d'utiliser RSA, si on veut passer partout (on peut avoir plusieurs clés dans sa configuration Cfarm).

Cette configuration est également utile si la machine utilise un port inhabituel, ce que font certaines.

L'article seul

Fiche de lecture : La réputation

Auteur(s) du livre : Laure Daussy

Éditeur : Les échappés

978-2-35766-198-1

Publié en 2023

Première rédaction de cet article le 26 novembre 2023

Ce livre parle d'un féminicide, l'assassinat de Shaïna Hansye en 2019. Et regarde de près l'environnement où ce crime a eu lieu. Ce n'était pas un fait isolé, mais le produit de plusieurs phénomènes, dont le sexisme et les injonctions à la « pureté » contre les filles et femmes.

Le meurtre a eu lieu à Creil et l'assassin était le « petit ami » de la victime. La journaliste Laure Daussy est allé interroger les parents de Shaïna, ses amies, les enseignants, les associations pour comprendre ce qui s'est passé. Creil cumule les problèmes : services publics supprimés ou défaillants, chômage massif, montée de l'islamisme, etc. Pour ne citer qu'un exemple, la maternité, où les jeunes filles pouvaient avoir des conseils sur la contraception et l'IVG a fermé, les habitantes sont censées aller à Senlis, ville avec laquelle il n'y a pas de liaison par transports en commun. Les jeunes filles sans permis de conduire sont donc privées de toute information, sauf si leurs parents acceptent de les emmener (ce qui n'est pas toujours facile à demander !). Les « territoires perdus de la République », dont les médias aiment bien parler, c'est aussi ça : une ville abandonnée des pouvoirs publics. Un autre exemple est donné par l'incroyable passivité de la police lorsque Shaïna, deux ans avant le meurtre, était allé porter plainte pour un viol. Beaucoup de femmes n'osent pas porter plainte, craignant (à juste titre) qu'elles se retrouvent accusées ou stigmatisées ou bien que cela ne serve à rien. Ici, l'enquête de la police et l'instruction judiciaire se sont déroulées avec lenteur, le jugement n'ayant eu lieu qu'après le meurtre de la victime.

Mais l'un des principaux problèmes n'est pas directement lié à cet abandon. C'est la question de la réputation, qui donne son titre à l'enquête. Des hommes ont décidé de contrôler la vie des femmes et notamment par le biais du contrôle de leur vie affective et sexuelle. Une jeune fille qui vit un peu librement peut vite se retrouver marquée par l'étiquette « fille facile ». Souvent, il n'est même pas nécessaire de vouloir vivre sa vie, toute fille peut se retrouver ainsi étiquetée, par exemple parce qu'un homme a voulu se « venger » d'elle. Si personne, parlant à la journaliste, n'a osé défendre ouvertemement le meurtre de Shaïna, en revanche plusieurs de ses interlocuteurs ont relativisé ce meurtre, le justifiant par le statut de « fille facile » de la victime.

Le terme revient souvent lorsque les hommes (et parfois aussi les femmes) parlent à l'auteure. Le poids des préjugés, celui, grandissant, de la religion, le sexisme se combinent pour enfermer les femmes de Creil. Toutes portent en permanence le poids de cette injonction à la réputation.

L'article seul

Modifier un message entrant en Python

Première rédaction de cet article le 24 novembre 2023

Un peu de programmation aujourd'hui. Supposons qu'on reçoive des messages qui ont été modifiés en cours de route et qu'on veut remettre dans leur état initial. Comment faire cela en Python ?

Comme exemple, on va supposer que les messages contenant le mot « chiffrer » ont été modifiés pour mettre « crypter » et qu'on veut remettre le terme correct. On va écrire un programme qui reçoit le message sur son entrée standard et met la version corrigée sur la sortie standard. D'abord, la mauvaise méthode, qui ne tient pas compte de la complexité du courrier électronique :

import re

import sys

botched_line = re.compile("^(.*?)crypter(.*?)$")

for line in sys.stdin:

match = botched_line.search(line[:-1])

if match:

# re.sub() serait peut-être meilleur ?

newcontent = match.group(1) + "chiffrer" + match.group(2) + "\n"

else:

newcontent = line

print(newcontent, end="")

On lit l'entrée standard, on se sert d'une expression rationnelle (avec le module re) pour trouver les lignes pertinentes, et on les modifie (au passage, le point d'interrogation à la fin des groupes entre parenthèses est pour rendre l'expression non gourmande). Cette méthode n'est pas bonne car elle oublie :

- Qu'un message peut être composé de plusieurs parties,

- et que même les parties faites de texte peuvent être encodées, par exemple en quoted-printable.

Il faut donc faire mieux.

Il va falloir passer au module email. Il fournit tout ce qu'il faut pour analyser proprement un message, même complexe :

import sys

import re

import email

import email.message

import email.policy

import email.contentmanager

botched_line = re.compile("^(.*?)crypter(.*?)$")

msg = email.message_from_file(sys.stdin, _class=email.message.EmailMessage,

policy=email.policy.default)

for part in msg.walk():

if part.get_content_type() == "text/plain":

newcontent = ""

for line in part.get_content().splitlines():

match = botched_line.search(line)

if match:

# re.sub() serait peut-être meilleur ?

newcontent += match.group(1) + "chiffrer" + match.group(2) + "\n"

else:

newcontent += line + "\n"

email.contentmanager.raw_data_manager.set_content(part, newcontent)

print(msg.as_string(unixfrom=True))

Ce code mérite quelques explications :

email.message_from_filelit un fichier (ici, l'entrée standard) et rend un objet Python de type message. Attention, par défaut, c'est un ancien type, et les opérations suivantes donneront des messages d'erreur incompréhensibles (comme « AttributeError: 'Compat32' object has no attribute 'content_manager' » ou « AttributeError: 'Message' object has no attribute 'get_content'. Did you mean: 'get_content_type'? »). Les paramètres_classetpolicysont là pour produire des messages suivant les types Python modernes.walk()va parcourir les différentes parties MIME du message, récursivement.get_content_type()renvoie le type MIME de la partie et nous ne nous intéressons qu'aux textes bruts, les autres parties sont laissées telles quelles.get_content()donne accès aux données (des lignes de texte) quesplitlines()va découper.- Si l'expression rationnelle correspond au motif donné, on ajoute la version modifiée, sinon on ne touche à rien.

set_content()remplace l'ancien contenu par le nouveau.- Et enfin,

as_stringtransforme l'objet Python en texte. Notre message a été transformé.

Ce code peut s'utiliser, par exemple, depuis procmail, avec cette configuration :

:0fw | $HOME/bin/repair-email.py

Évidemment, il peut être prudent de sauvegarder le message avant cette manipulation, au cas où. En procmail :

:0c: Mail/unmodified

Vous voulez tester (sage précaution) ? Voici un exemple de message, fait à partir d'un spam reçu :

From spammer@example Fri Nov 24 15:08:06 2023

To: <stephane@bortzmeyer.org>

MIME-Version: 1.0

Content-Type: multipart/alternative;

boundary="----=_Part_9748132_1635010878.1700827045631"

Date: Fri, 24 Nov 2023 13:42:17 +0100 (CET)

Subject: 🍷 Catalogues vins

From: Ornella FEDI <ornella.fedi@vinodiff.com>

Content-Length: 65540

Lines: 2041

------=_Part_9748132_1635010878.1700827045631

Content-Type: text/plain; charset="UTF-8"

Content-Transfer-Encoding: quoted-printable

Cet E-mail dit "crypter". Pour pouvoir afficher cet E-mail, le clie=

nt de messagerie du destinataire doit supporter ce format.

------=_Part_9748132_1635010878.1700827045631

Content-Type: text/html; charset="UTF-8"

Content-Transfer-Encoding: quoted-printable

<?xml version=3D"1.0" ?>

<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN"

"http://www.w3.org/TR/xhtml1/DTD/xhtml1-transitional.dtd">

<html xmlns=3D"http://www.w3.org/1999/xhtml">

<head>

<title>E-Mail</title>

<style type=3D"text/css" media=3D"screen">

</style>

</head>

<body>Deleted to save room</body></html>

------=_Part_9748132_1635010878.1700827045631--

Mettez-le dans un fichier, mettons spam.email

et passez le au programme Python :

% cat /tmp/spam.email | ./repair.py

From spammer@example Fri Nov 24 15:08:06 2023

To: <stephane@bortzmeyer.org>

MIME-Version: 1.0

Content-Type: multipart/alternative;

boundary="----=_Part_9748132_1635010878.1700827045631"

Date: Fri, 24 Nov 2023 13:42:17 +0100 (CET)

...

------=_Part_9748132_1635010878.1700827045631

Content-Type: text/plain; charset="utf-8"

Content-Transfer-Encoding: quoted-printable

Cet E-mail dit "chiffrer". Pour pouvoir afficher cet E-mail, le client de mes=

sagerie du destinataire doit supporter ce format.

------=_Part_9748132_1635010878.1700827045631

...

Si vous voulez améliorer ce programme, vous pouvez gérer les cas :

- Plusieurs « crypter » sur une ligne.

- Remplacer la concaténation

+par quelque chose de plus rapide (je cite Bertrand Petit : concaténer des chaines en Python est couteux. Chaque application de l'opérateur + crée une nouvelle chaîne qui n'aura qu'une existence brève, et cela cause aussi, à chaque fois, la copie de l'intéralité du contenu de la chaine en croissance. À la place, il vaudrait mieux stocker chaque bout de chaine dans une liste, pour finir par tout assembler en une fois, par exemple avecjoin).

L'article seul

Capitole du Libre 2023, et mon exposé sur la censure de l'Internet

Première rédaction de cet article le 22 novembre 2023

Les 18 et 19 novembre 2023, c'était Capitole du Libre à

Toulouse. Plein d'exposés intéressants et de

rencontres passionnantes autour du thème du logiciel libre.

C'est gros, le Capitole du Libre : 1 200 personnes sont venues,

il y avait 118 orateurices, 94 conférences, 18 ateliers et 31

stands. Comme il y a eu davantage de propositions que de créneaux,

certaines ont été refusées. 50 kg de pop-corn

ont été légués par le DevFest dont 20 ont été

consommés. Mais il y avait aussi des pains au chocolat :

Personnellement, j'ai fait un exposé sur la

censure sur

l'Internet. Les supports au format PDF sont capitole-libre-2023-censure.pdfcapitole-libre-2023-censure.tex

Ironie de la situation, le réseau de l'ENSEEIHT, l'école qui héberge gratuitement le Capitole du Libre, met en œuvre une des techniques de censure présentées. Si on tente de se connecter à OnlyFans, on récupére un RST (ReSeT) TCP, probablement suite à l'examen du SNI dans l'ouverture de la session TLS. Vu par tcpdump, voici ce que ça donne (le dernier paquet, le RST, n'est pas légitime) :

13:19:35.603931 IP 172.22.223.35.40874 > 54.211.0.120.443: Flags [S], seq 2413541568, win 64240, options [mss 1460,sackOK,TS val 46581492 ecr 0,nop,wscale 7], length 0 13:19:35.744066 IP 54.211.0.120.443 > 172.22.223.35.40874: Flags [S.], seq 3076610656, ack 2413541569, win 26847, options [mss 1460,sackOK,TS val 453378101 ecr 46581492,nop,wscale 8], length 0 13:19:35.744173 IP 172.22.223.35.40874 > 54.211.0.120.443: Flags [.], ack 1, win 502, options [nop,nop,TS val 46581633 ecr 453378101], length 0 13:19:35.830075 IP 172.22.223.35.40874 > 54.211.0.120.443: Flags [P.], seq 1:518, ack 1, win 502, options [nop,nop,TS val 46581719 ecr 453378101], length 517 13:19:35.833848 IP 54.211.0.120.443 > 172.22.223.35.40874: Flags [R.], seq 1, ack 518, win 502, length 0

Et ne dites pas d'utiliser Tor, les nœuds d'entrée publics sont bloqués.

Maintenant, les bons exposés (dans l'ordre arbitraire que j'ai décidé tout seul avec mes préférés en premier). Vincent Privat a présenté un système pour récupérer automatiquement les photos que publie la NASA (avec leurs métadonnées) et les mettre sur Wikimedia Commons. C'est légal puisque la NASA, comme toutes les agences fédérales étatsuniennes, met tout ce qu'elle publie dans le domaine public. Mais c'est techniquement difficile. Déjà, s'il y a parfois une API pour lister les images à récupérer, parfois, il faut plutôt scraper l'HTML. Et parfois il faut deviner l'URL en testant plusieurs variantes. D'autre part, il faut éliminer les doublons (chacun peut écrire dans Wikimedia Commons et ces images sont souvent importées). Son outil récupère toutes les métadonnées, les vérifie et convertit vers ce qu'attend Wikimedia Commons. Comme toujours avec l'open data, il y a des bavures amusantes, par exemple la date de prise de vue indiquée est parfois dans le futur, il y a du mojibake dans les textes, des licences incohérentes (entre le texte et les EXIF), des « descriptions » qui sont en fait de la publicité, etc (tous des problèmes classiques de l'open data). D'autre part, beaucoup d'outils de Wikimedia sont conçus pour le texte, car la cible est Wikipédia. Utiliser les outils et machines de Wikimedia pour traiter des images de beaucoup de giga-octets (par exemple pour le dédoublonnage) explosait les quotas. Enfin, pour dédoublonner, le programme calcule un perceptual hashing, pas un simple et traditionnel condensat.

À noter que les autres agences spatiales ne mettent rien sous licence libre donc la vision de l'espace est dominée par celle des États-Unis, les seuls à avoir compris la force du soft power.

Julian Vanden Broeck a fait un trés bon bilan de son changement

du système de messagerie instantanée interne dans son entreprise

(passage à Matrix). Comment ça marche en

vrai ? Quel accompagnement pour les utilisateurices ? Quelle

acceptation ? Entre utilisateurices qui râlaient contre l'ancien

système, celleux qui râlaient contre le nouveau, celleux qui

disaient que Microsoft Teams, c'était mieux,

et celleux qui critiquaient la couleur des boutons, l'acceptation

n'était pas évidente. La technique,

c'est facile, ce sont les humains qui sont compliqué·es. « On a

désactivé le chiffrement systématique car c'était trop frustrant

pour les utilisateurs, notamment en cas de perte de clés. » Je

confirme que c'est aussi mon expérience avec Matrix, loin des

promesses d'un système parfait. Et encore, l'entreprise de l'orateur

n'utilise que le client Element, les problèmes sont pires quand on a

plusieurs clients (de ce point de vue, Matrix ne marque aucun

progrès par rapport à XMPP, où l'incompatibilité des

clients a toujours été une plaie). Au passage, si vous voulez

essayer, je suis joignable à

@bortzmeyer:matrix.underworld.fr.

On s'est bien amusés avec l'exposé « Modèles d'organisation ouverts dans les entreprises du logiciel libre » car les deux orateurs ne se sont pas présentés, sans explication. Thomas Petazzoni a alors lancé l'idée que, puisque le sujet était les organisations ouvertes, non hiérarchiques, etc, on n'avait pas besoin d'orateurs et on pouvait débattre entre nous. Ça a très bien pris et il y a eu une discussion intéressante, par exemple avec les gens d'une association, l'Échappée Belle, qui est en fait une coopérative de freelances, où chaque salarié décide de son salaire. Évidemment, ils insistaient sur le fait que ça ne peut sans doute marcher que dans les petites organisations (ils sont six), où les gens se connaissent et ont des valeurs communes.

Et Pierre-Yves Lapersonne a posé la question du choix des bibliothèques logicielles quand on développe un logiciel libre. Le ou la programmeureuse ne peut pas tout faire, il faut donc dépendre de bibliothèques existantes. Vous, je ne sais pas mais moi, quand je commence un projet, j'ai toujours du mal à identifier les bonnes bibliothèques dont mon projet va dépendre. Vous utilisez quoi, comme critères ? Quand il y a le choix, c'est compliqué. Comment choisir, et, par exemple, détecter celles qui ne sont plus maintenues (donc où les bogues ne seront plus corrigées), celles gérées par une boite qui va subitement changer la licence (il y a eu deux-trois cas spectaculaires ces dernières années, comme MongoDB), etc. Parmi les critères possibles (mais aucun n'est parfait et l'auteur recommande de se méfier des critères quantitatifs simples) :

- la licence utilisée, bien sûr,

- le langage de programmation utilisé,

- les dépendances de cette bibliothèque,

- le nombre de tickets, s'il est faible, c'est peut-être qu'il n'y a pas beaucoup d'utilisateurs, si beaucoup sont fermés, cela peut être bon signe (bogues corrigées rapidement) ou mauvais signe (mainteneur qui ferme tout de suite sans corriger),

- la date du dernier ticket fermé peut être un bon indicateur pour savoir si le projet vit toujours,

- nombre de commits

(pas très pertinent car il dépend du style de travail des

programmeurs, certain·es font dix commits dans

la matinée, d'autres un par semaine (pensez à

git rebase…), - date du dernier commit pour détecter les codes abandonnés (ou bien tellement parfaits qu'ils n'ont pas besoin de changements…),

- l'activité du mainteneur ; est-ce qu'il est actif (voir son profil sur la forge publique utilisée) avec le langage du projet (un projet Go créé par quelqu'un qui ne fait que du Rust aujourd'hui risque de de ne pas faire l'objet de beaucoup d'attention),

- l'existence de tests, et la couverture du code par la suite de tests (pour avoir une base saine si on va devoir modifier le logiciel).

On a aussi discuté d'UI et d'UX au Capitole du Libre. Nojhan a parlé de LiquidPrompt, un des nombreux mécanismes permettant d'avoir des invites très riches pour la ligne de commande du shell Unix. L'orateur a commencé par : « vous utilisez toustes le shell ? », ce qui évidemment fait rire au Capitole du Libre. Le but du projet est d'améliorer l'invite de la ligne de commande en indiquant davantage d'informations. Le problème est évidemment de ne pas surcharger l'utilisateurice. LiquidPrompt, comme ses concurrents, permet d'avoir plusieurs thèmes, et le thème par défaut est dense et plein d'informations. (Y compris la charge de la batterie, ce que je trouve anxiogène.) Pour les démonstrations, c'est spectaculaire. Une autre démonstration montrait un thème où l'invite occupe tout le terminal tellement il y a d'informations.

Un gros avantage de ces systèmes d'invites riches est l'indication de l'état du dépôt Git (ou bien parfois d'autres VCS) où on se trouve. On peut indiquer la branche, bien sûr (combien de fois je me suis planté, me trompant sur la branche où j'étais) mais aussi des suggestions sur les commandes git qui pourraient être pertinentes.

Bon, il y a tellement de systèmes d'invites shell améliorées que c'est un travail en soi d'en choisir une ! L'auteur a fait un article de comparaison.

Maïtané Lenoir a parlé de « modération » (terme que je trouve contestable) sur les réseaux sociaux, notamment les « réseaux sociaux capitalistes » (ce qui inclut TikTok, même si ça déplait au PC chinois). « Je vais vous raconter des trucs traumatiques. » Déjà, elle a noté qu'il fallait bien différencier la politique officiellement affichée, et les moyens qui sont effectivement mis en œuvre pour l'appliquer. (Ce principe doit pouvoir s'appliquer à la politique en général.) Elle a insisté sur l'importance d'une riposte graduée. Si un logiciel ne permet que des réactions simplistes et binaires (supprimer le compte, par exemple), le contrôle sera difficile car on n'aura le choix qu'entre deux mauvaises décisions. Parmi les difficultés (que les réseaux sociaux capitalistes mettent sous le tapis) du contrôle, la langue. Il ne suffit pas de lire la langue utilisée, il faut aussi connaitre la culture, pour comprendre allusions, jeux de mots, choix de vocabulaire. Un Français va avoir du mal à évaluer du contenu écrit en français par un Ivoirien ou un Québecois.

Et, bien sûr, le contrôle prend du temps et des efforts et les réseaux sociaux capitalistes, quoi qu'ils prétendent, ne mettent pas assez de moyens. L'IA n'est pas une solution. (Notez que Pharos a la même analyse.)

L'auteure travaille dans l'équipe de modération de Framasoft, par exemple pour l'instance fédivers Framapiaf. Inutile de dire que ce n'est pas facile, cette équipe a dû faire face à des campagnes s'attaquant à Framasoft et à sa modération (prétendant par exemple qu'il n'y en avait pas). La publication de la charte de modération n'a rien arrangé, les attaques des ultras du contrôle contre Framasoft ont redoublé, tournant au harcèlement. Heureusement qu'en interne, le collectif était soudé.

L'oratrice a beaucoup insisté sur les difficultés pratiques, quotidiennes de la modération : par exemple, beaucoup de signalements ne donnent aucun détail. C'est quoi, le problème, exactement ? Les modérateurs doivent essayer de deviner. Signaleurs, détaillez vos messages ! (Sinon, elle n'en a pas parlé, mais je trouve qu'il y a aussi des signalements malveillants, pour faire taire des ennemis politiques. Les islamistes font souvent cela, par exemple.) Conseil : ne pas oublier le temps et l'énergie consommée. Certes, la modération de Framapiaf n'est pas parfaite (aucune ne l'est) mais un des principes est : « ne pas passer un temps infini sur chaque cas » (surtout que les modérateurs sont bénévoles). Or, les signaleurs sont souvent très exigeants « on veut une action safe tout de suite !!! »

La conclusion : Modération = Pouvoir et Humain = Faillible.

On a eu évidemment une table ronde sur l'IA, où on a surtout

parlé de régulation. Celle-ci évidemment ne vise pas forcément qu'à

protéger les gens, elle peut avoir des motivations

protectionnistes. Florence Sèdes a noté que le récent projet

Kyutai

de Niel et

Saadé ne mette en jeu que des sommes

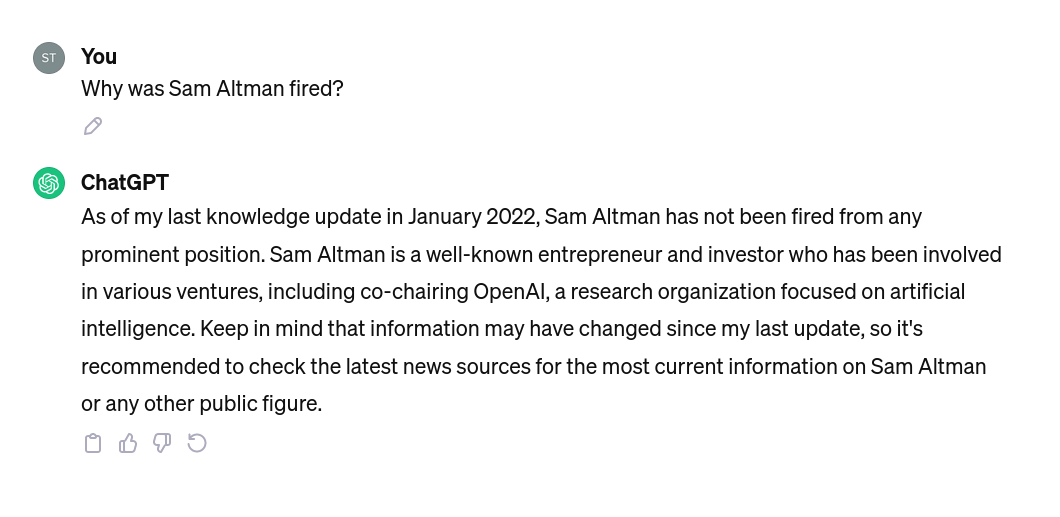

« dérisoires ». Toujours dans l'actualité chargée de l'IA, j'ai

demandé à ChatGPT les raisons du licenciement

spectaculaire de la direction d'OpenAI, la

veille du Capitole du Libre, licenciement qui fait parler toute la

Silicon Valley mais il m'a répondu qu'il ne savait pas, qu'à sa

connaissance, Altman était toujours

CEO.

L'autre table ronde portait sur la sobriété, avec notamment Agnès Crepet, qui bosse chez Fairphone. La table ronde a été un peu plus animée car il y avait aussi le député Modem Philippe Latombe, spécialiste des questions numériques, mais qui a voté la loi JO, avec l'extension de la vidéo-surveillance. Indépendamment de la question des droits humains, la vidéo-surveillance est un gouffre énergétique, il s'est fait interpeller là-dessus, a agité le chiffon rouge en disant qu'il ne fallait pas dire vidéo-surveillance mais vidéo-protection (comme on dit dans les comptes rendus de débats « mouvements divers ; protestations »), bref, a contribué à rappeler que la sobriété numérique n'était pas consensuelle. Les JO, qui sont le prétexte pour généraliser cette surveillance, sont une grande source de gaspillage, et Bookynette, qui animait la table ronde, a appelé à boycotter cette fête du fric et du dopage.

Sinon, en matière d'empreinte environnementale du numérique, ne pensez pas qu'à la consommation électrique, note Agnès Crepet. Il y a aussi l'extraction des métaux, dans des conditions désastreuses. Elle a aussi parlé de la réparabilité, sa tante Ginette étant capable de démonter un ordiphone. Ginette est plus habile de ses mains que moi, elle arrive à réparer son Fairphone, alors que j'ai bousillé un Fairphone 2 en essayant d'intervenir à l'intérieur.

Autre participant à la table ronde, Gaël Duval (/e/). Il a parlé de l'obsolescence logicielle. Pour limiter la surconsommation de matériel, il faut aussi maintenir du logiciel qui continue à tourner sur les « vieux » (10 ans) équipements. Par exemple, les vieux trucs 32 bits ont du mal avec des applications qui sont en 64 bits maintenant. Philippe Latombe note que l'État n'est pas forcément cohérent, par exemple en prônant la réutilisation tout en taxant (avec le racket « copie privée ») les téléphones reconditionnés. Agnès Crepet a appelé au « techno-discernement » ; la technique n'est pas forcément utile. Parfois, la solution est de ne pas numériser.

Guillaume a parlé de l'intégration des contributions externes dans le compilateur Rust. Il a expliqué comment les auteurs de Rust géraient ces contributions, entre le désir de favoriser les contributions extérieures (un gros point fort du logiciel libre) et la nécessité de contrôler (pour éviter bogues, voire, pires, attaques « supply chain »). L'équilibre est délicat. Une bonne partie du processus d'examen des contributions est automatisée, via la CI. Si le changement est léger et que la CI passe, ça va plus vite. Sinon, jetez un coup d'œil à la file d'attente de Rust. Évidemment, il faut que tous les tests passent et, rien que pour les messages d'erreur du compilateur, il y a plusieurs dizaines de milliers de tests. Les machines tournent longtemps ! Si vous voulez contribuer au compilateur Rust, certains tickets sont marqués « pour débutants » et sont a priori plus faciles. Vous pouvez voir pas mal d'articles sur Rust au blog de l'orateur.

Adrien Destugues a fait un exposé très geek, la rétro-ingéniérie d'un jeu vidéo où il jouait quand il était petit (le logiciel ludo-éducatif « Lectures Enjeu »), jeu commercial abandonné et qu'il voulait faire revivre. Aucune perspective utilitaire ou financière, c"était juste de l'art pour l'art. Amusant, les chaines de caractères du jeu sont paramétrées avec un @ qui est remplacé par une marque du féminin si la joueuse a indiqué qu'elle était du genre féminin. "arrivé@" dans le fichier est affiché "arrivé" ou "arrivée" selon le cas.

Un sujet financier ? « La blockchain pour le financement du logiciel libre » par Guillaume Poullain, par exemple. Gitcoin est une organisation de financement du logiciel libre (50 M$ distribués en 2023). Ça utilise le protocole Allo (je ne connais pas). Les gens qui financent ont un droit de vote. L'allocation est quadratique, favorisant le nombre de votes davantage que le montant (pour éviter qu'un millionaire n'ait autant de poids que mille smicards). 3 715 projets ont été financés, 3,8 M$ de donations (je n'ai pas vérifié tous les chiffres).

Un des problèmes est évidemment ce sont les projets les plus connus (souvent les plus riches) qui ont le plus de votes. Et, évidemment, certains projets reçoivent peu de votes et donc de fric. Il y a aussi le risque d'attaque Sybil, favorisé par l'allocation quadratique. (Solution : une vérification d'unicité avec un système nommé Passport.)

À noter qu'on ne peut pas retirer l'argent, le flux est dans un seul sens (ce qui évite les bogues style The DAO qui sont la plaie des fonds d'investissement tournant sur la chaine de blocs). Bref, mon opinion :ça me semble une bonne utilisation des possibilités de la chaine de blocs.

Merci à l'école qui prête les locaux gratuitement, aux sponsors. Et

surtout aux bénévoles :

L'article seul

Fiche de lecture : Ni Web, ni master

Auteur(s) du livre : David Snug

Éditeur : Nada

9-791092-457513

Publié en 2022

Première rédaction de cet article le 20 novembre 2023

J'avoue, j'ai acheté cette BD pour le titre, référence à un ancien slogan anarchiste. Il y a d'autres jeux de mots dans ce livre. Mais le point important est que c'est une critique vigoureuse du Web commercial et de ses conséquences sur la société.

L'inconvénient des librairies comme Quilombo est qu'une fois qu'on y va pour quelque chose de précis, on se laisse prendre et on achète des livres pas prévus. En l'occurrence, la librairie a pas mal de livres luddites, assez variés. Cette BD imagine un auteur un peu âgé, fan de toutes les possibilités du Web commercial, et qui rencontre son moi du passé qui a voyagé dans le temps pour voir comment était le futur. Le David Snug du passé découvre donc Amazon, Uber Eats, Spotify, etc.

J'aime le style des dessins, et la vision de la ville moderne, où tout le monde est accroché à son ordiphone sonne juste. De même, l'auteur dénonce avec précision les conséquences concrètes du Web commercial, comme l'exploitation des travailleurs sans-papier pour la livraison des repas. C'est souvent très drôle, et rempli de jeux de mots mêlant termes du monde numérique et vieux slogans anarchistes. (Il y en a même un sur les noms de domaine.) C'est parfois, comme souvent avec les luddites, un peu trop nostalgique (« c'était mieux avant ») mais, bon, le fait que le passé connaissait déjà l'exploitation de l'homme par l'homme n'excuse pas le présent.

Bref, c'est un livre que je peux conseiller pour des gens qui n'ont pas perçu le côté obscur du Web commercial. (Si, par contre, vous lisez tous les articles du Framablog, vous n'apprendrez sans doute rien, mais vous passerez quand même un bon moment.) Je regrette quand même que l'auteur ne semble connaitre de l'Internet que le Web et du Web que les GAFA. Ainsi, Wikipédia est expédié en une phrase, pas très correcte.

Un conseil pour finir : ne lisez pas la postface qui, elle est franchement conservatrice et défend une vision passéiste du monde, d'un courant politique qu'on peut qualifier d'« anarchiste primitiviste ». Encore pire, la bibliographie, qui va des réactionnaires comme Michel Desmurget à l'extrême-droite, avec Pièces et Main d'Œuvre. C'est là qu'on se rend compte que le courant luddite a du mal à trancher avec les défenseurs de l'ordre naturel sacré.

L'article seul

Fiche de lecture : Ada & Zangemann

Auteur(s) du livre : Matthias Kirschner, Sandra

Brandstätter

Éditeur : C&F Éditions

978-2-37662-075-4

Publié en 2023

Première rédaction de cet article le 8 novembre 2023

Ce livre pour enfants a pour but de sensibiliser au rôle du logiciel dans nos sociétés. Difficile aujourd'hui d'avoir quelque activité que ce soit, personnelle ou professionnelle, sans passer par de nombreux programmes informatiques qui déterminent ce qu'on peut faire ou pas, ou, au minimum, encouragent ou découragent certaines actions. Les enfants d'aujourd'hui vont vivre dans un monde où ce sera encore plus vrai et où il est donc crucial qu'ils apprennent deux ou trois choses sur le logiciel, notamment qu'il existe du logiciel libre.

Le livre est originellement écrit en allemand, je l'ai lu dans la traduction française, publiée chez C&F Éditions. Il a été écrit à l'initiative de la FSFE.

Donc, l'histoire. Zangemann (un mélange de Jobs, Gates, Zuckerberg et Musk) est un homme d'affaires qui a réussi en fabriquant entre autres des objets connectés dont il contrôle complètement le logiciel, et il ne se prive pas d'appliquer ses règles suivant sa volonté du moment. Les utilisateurices des objets sont désarmé·es face à ces changements. Ada est une petite fille qui commence par bricoler du matériel (c'est plus facile à illustrer que la programmation) puis comprend le rôle du logiciel et devient programmeuse (de logiciels libres, bien sûr). Je ne vous raconte pas davantage, je précise juste, pour mes lecteurices programmeur·ses que ce n'est pas un cours de programmation, c'est un conte pour enfants. Le but est de sensibiliser à l'importance du logiciel, et d'expliquer que le logiciel peut être écrit par et pour le peuple, pas forcément par les Zangemann d'aujourd'hui.

Le livre est sous une licence

libre. J'ai mis une illustration sur cet article car la

licence est compatible avec celle de mon blog, et cela vous

permet de voir le style de la dessinatrice :

Je n'ai par contre pas aimé le fait que, à part pour les glaces à la framboise, les logiciels ne soient utilisés que pour occuper l'espace public sans tenir compte des autres. Zangemann programme les planches à roulette connectées pour ne pas rouler sur le trottoir et donc respecter les piétons ? Ada écrit du logiciel qui permet aux planchistes d'occuper le trottoir et de renverser les personnes âgées et les handicapé·es. L'espace public est normalement un commun, qui devrait être géré de manière collective, et pas approprié par les valides qui maitrisent la programmation. Le film « Skater Girl » représente bien mieux cette tension entre planchistes et autres utilisateurs. Un problème analogue se pose avec les enceintes connectées où la modification logicielle va permettre de saturer l'espace sonore (un comportement très macho, alors que le livre est censé être féministe) et de casser les oreilles des autres. Remarquez, cela illustre bien le point principal du livre : qui contrôle le logiciel contrôle le monde.

Le livre parait en français le premier décembre. La version originale est déjà disponible, ainsi que la version en anglais.

L'article seul

Mes débuts en programmation Zig

Première rédaction de cet article le 3 novembre 2023

Je suis en train d'apprendre le langage de programmation Zig donc je vous fais profiter ici de ce que j'ai appris. Je ne vais pas détailler les points secondaires, comme la syntaxe, mais plutôt parler des concepts originaux de Zig, comme sa gestion d'erreurs, ses variables optionnelles ou son modèle de gestion mémoire.

Attention, si vous êtes sénateur, ne lisez pas ce texte, il utilise plusieurs techniques d'écriture inclusive. Le risque de crise cardiaque est particulièrement élevé après un déjeuner bien arrosé au restaurant du Sénat.

D'abord, le cahier des charges. Zig est un langage de bas niveau, au sens où il est conçu pour des programmes où le·a programmeur·se contrôle plein de détails, comme l'allocation de mémoire. Il est prévu pour programmer sur le métal nu (par exemple programmation dite « embarquée » ou bien pour faire un noyau de système d'exploitation). Mais on peut aussi l'utiliser sur un environement plus perfectionné, par exemple sur Unix pour écrire des serveurs Internet (le domaine de la programmation que je connais le mieux).

Zig est donc un concurrent de C mais se voulant plus sécurisé, C s'étant distingué au cours de sa longue histoire par la facilité avec laquelle le·a programmeur·se peut produire des failles de sécurité. Bien d'autres langages sont sur ce créneau, le plus connu (et le seul déjà largement utilisé en production) étant Rust. Mais il y a aussi V, Odin, Vale… (Une liste a été compilée.)

Zig a démarré en 2016 et n'est donc pas un langage si récent que cela. Mais il est toujours officiellement expérimental (l'actuelle version stable est la 0.11, j'ai travaillé avec la 0.12) et le langage continue à évoluer, ce qui rend difficile de l'utiliser pour des projets réels. En outre, sa bibliothèque standard évolue encore davantage que le langage lui-même. Il est ainsi fréquent qu'on trouve avec un moteur de recherche des articles prometteurs… mais dépassés et dont les exemples ne compilent même pas.

Bon, connaissant les lecteurices de ce blog, je pense qu'ielles sont toustes en train de se demander à quoi ressemble Hello, world en Zig. Donc :

const std = @import("std");

pub fn main() !void {

const public = "Blog";

std.debug.print("Hello, {s}!\n", .{public});

}

Vous noterez qu'il faut importer explicitement la bibliothèque

standard, contrairement à la grande majorité des langages de

programmation. Une version plus longue de ce premier programme est

hello.zig

Bon, je vous ai suggéré d'essayer mais, pour cela, il faudrait un compilateur. La mise en œuvre actuelle de Zig est en C++ mais une version en Zig existe et est déjà capable de se compiler elle-même. En attendant, on va utiliser le binaire fourni car je suis paresseux :

% zig version 0.12.0-dev.1245+a07f288eb % zig build-exe hello.zig % ./hello Hello, Blog!

Vous verrez un message pendant un moment disant que le code est généré par LLVM. Un des avantages de cette méthode est de rendre Zig très portable. Ainsi, les programmes tournent tous sur ma carte RISC-V.

D'autre part, la commande zig joue plusieurs rôles : compilateur et éditeur de liens, bien sûr, mais aussi remplaçant de make et des outils similaires, et gestionnaire de paquetages.

Revenons à des programmes zig et voyons ce qui se passe si le programme plante :

const std = @import("std");

pub fn main() void {

const name = "myfile.txt";

const f = std.fs.cwd().openFile(name, .{});

std.debug.print("File opened? {any}\n", .{f});

}

Ouvrir un fichier n'est évidemment pas une opération sûre. Le

fichier peut être absent, par exemple. Les différents langages de

programmation ont des mécanismes très différents pour gérer ces cas.

Si vous faites tourner le programme Zig ci-dessus, et que le fichier

myfile.txt n'existe pas, vous obtiendrez

un File opened? error.FileNotFound. Si le fichier

existe, ce sera File opened? fs.file.File{ .handle = 3,

.capable_io_mode = io.ModeOverride__enum_3788.blocking,

.intended_io_mode = io.ModeOverride__enum_3788.blocking },

une structure de données à travers laquelle on pourra manipuler le

fichier ouvert. La fonction de la bibliothèque standard

openFile peut donc retourner deux types

différents, une erreur ou une structure d'accès au fichier. Ce

mécanisme est très fréquent en Zig, on peut avoir des unions de type

et les fonctions renvoient souvent « soit ce qu'on attend d'elles,

soit une erreur ».

Maintenant, imaginons un·e programmeur·se négligent·e qui ignore l'erreur et veut lire le contenu du fichier :

var buffer: [100]u8 = undefined;

const f = std.fs.cwd().openFile(name, .{});

const result = f.readAll(&buffer);

std.debug.print("Result of read is {d} and content is \"{s}\"\n", .{result, buffer[0..result]});

}

Ce code ne pourra pas être compilé :

% zig build-exe erreurs.zig

erreurs.zig:8:19: error: no field or member function named 'readAll' in 'error{…FileNotFound…BadPathName…}!fs.file.File'

const result = f.readAll(&buffer);

~^~~~~~~~

En effet, en Zig, on ne peut pas ignorer les erreurs (une faute

courante en C). openFile ne renvoie pas un

fichier (sur lequel on pourrait appliquer

readAll) mais une union « erreur ou

fichier ». Il faut donc faire quelque chose de l'erreur. Zig offre

plusieurs moyens pour cela. L'une des plus classiques est de

préfixer l'appel de fonction avec try. Si la

fonction ne renvoie pas d'erreur, try permet de

ne garder que la valeur retournée, si par contre il y a une erreur,

on revient immédiatement de la fonction appelante, en renvoyant

l'erreur :

var buffer: [100]u8 = undefined;

const f = try std.fs.cwd().openFile(name, .{});

const result = try f.readAll(&buffer);

std.debug.print("Result of read is {d} and content is \"{s}\"\n", .{result, buffer[0..result]});

Mais ça ne compile pas non plus :

% zig build-exe erreurs.zig

erreurs.zig:6:13: error: expected type 'void', found 'error{AccessDenied…}'

const f = try std.fs.cwd().openFile(name, .{});

^~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

erreurs.zig:3:15: note: function cannot return an error

pub fn main() void {

^~~~

On a dit que try renvoyait une erreur en cas de

problème. Or, la fonction main a été déclarée

comme ne renvoyant rien (void). Il faut donc la

changer pour déclarer qu'elle ne renvoie rien, ou bien une erreur :

pub fn main() !void {

Le point d'exclamation indiquant l'union du

type erreur et du vrai résultat (ici,

void). Rappelez-vous : on n'a pas le droit de

planquer les erreurs sous le tapis. Le programme utilisé est erreurs.zig

Revenons sur le typage Zig :

- Il est strict, on ne peut pas ajouter un entier à un pointeur, par exemple,

- il est entièrement statique (les types ne survivent pas à la compilation),

- résultat (qui ne surprendra pas les programmeurs et programmeuses Rust), arriver à compiler le programme est souvent long et pénible mais, une fois que ça compile, il y a beaucoup moins de bogues qui trainent (ce qui est, entre autre, positif pour la sécurité),

- les types sont aussi des valeurs, on peut les mettre dans des variables, les passer en paramètres à des fonctions (ce qui est utile pour la généricité) mais tout cela est fait à la compilation.

Voyons maintenant les variables

optionnelles. Il est courant qu'une variable n'ait pas toujours une

valeur, par exemple si la fonction qui lui donnait une valeur

échoue. En C, et dans d'autres langages, il est courant de réserver

une valeur spéciale pour dire « pas de valeur ». Par exemple 0 pour

un entier, la chaine vide pour une chaine de caractères, etc. Le

problème de cette approche est que cette valeur se trouve désormais

interdite (que faire si l'entier doit vraiment valoir 0 ?) Zig

utilise donc le concept de variable optionnelle, variable qui peut

avoir une valeur ou pas (un peu come le MayBe

d'Haskell). On les déclare avec un

point d'interrogation :

var i:?u8; // = null;

var j:?u8; // = 42;

std.debug.print("Hello, {d}!\n", .{i orelse 0}); // orelse va déballer la valeur (ou mettre 0)

i = 7;

std.debug.print("Hello, {any}!\n", .{j}); // Optionnel, donc le format {d} ne serait pas accepté

std.debug.print("Hello, {d}!\n", .{i orelse 0});

Ce code ne sera pas accepté tel quel car, rappelez-vous, les variables doivent être initialisées. Autrement, error: expected '=', found ';' (message peu clair, il faut bien l'avouer). En donnant une valeur initiale aux deux variables optionnelles, le programme marche. On notera :

nullindique que la variable n'a pas de valeur. On peut testerif (i == null)si on veut vérifier ce cas.orelsesert à donner une valeur par défaut lorsqu'on « déballe » la variable et qu'on découvre qu'elle n'a pas de valeur.

Passons maintenant à un sujet chaud en sécurité (car une bonne partie des failles de sécurité dans les programmes écrits en C viennent de là), la gestion de la mémoire. En simplifiant, il y a les langages qui gèrent tout, laissant le programmeur libre de faire autre chose (comme Python) et les langages où la programmeuse doit gérer la mémoire elle-même. La première approche est évidemment plus simple mais la deuxième permet de contrôler exactement la mémoire utilisée, ce qui est indispensable pour l'embarqué et souhaitable pour les gros programmes tournant longtemps (les serveurs Internet, par exemple). Et l'approche manuelle a également l'inconvénient que les humain·es femelles ou mâles font des erreurs (lire de la mémoire non allouée, ou qui a été libérée ou, pire, y écrire).

L'approche de Zig est que la mémoire est allouée via des allocateurs (concept emprunté à C++) et que différents allocateurs ont différentes propriétés. La responsabilité de la personne qui programme est de choisir le bon allocateur. Commençons par un exemple simple :

pub fn main() !void {

var myallo = std.heap.GeneralPurposeAllocator(.{}){};

const allocator = myallo.allocator();

var myarray = try allocator.alloc(u8, 10); // Peut échouer par manque de mémoire

defer allocator.free(myarray);

std.debug.print("{any}\n", .{myarray}); // Selon l'allocateur utilisé, donnée initialisées ou pas

for (0..myarray.len) |i| {

myarray[i] = @truncate(i); // @as serait refusé, le type de destination étant trop petit

}

std.debug.print("{any}\n", .{myarray});

}

Ce programme, allocate.zig

- crée un allocateur à partir d'une fonction de la

bibliothèque standard,

GeneralPurposeAllocator, allocateur qui privilégie la sécurité sur les performances, et n'est pas optimisé pour une tâche précise (comme son nom l'indique), - alloue de la mémoire pour dix octets

(

u8), ce qui peut échouer (d'où letry), - enregistre une action de libération de la mémoire

(

free) à exécuter lors de la sortie du bloc (defer), - écrit dans cette mémoire (les fonctions dont le nom commençe

par un arobase sont les fonctions

pré-définies du langage ; ici,

@truncateva faire rentrer un compteur de boucle dans un octet, quitte à le tronquer), - affiche le résultat.

D'une manière générale, Zig essaie d'éviter les allocations implicites de mémoire. Normalement, vous voyez les endroits où la mémoire est allouée.

La puissance du concept d'allocateur se voit lorsqu'on en

change. Ainsi, si on veut voir les opérations d'allocation et de

désallocation, la bibliothèque standard a un allocateur bavard,

LoggingAllocator, qui ajoute à un allocateur

existant ses fonctions de journalisation. Comme tous les allocateurs

ont la même interface, définie par la bibliothèque standard, le

remplacement d'un allocateur par un autre est facile :

const myallo = std.heap.LoggingAllocator(std.log.Level.debug, std.log.Level.debug);

var myrealallo = myallo.init(std.heap.page_allocator);

const allocator = myrealallo.allocator();

var myarray = try allocator.alloc(u8, 10);

defer allocator.free(myarray);

for (0..myarray.len) |i| {

myarray[i] = @truncate(i);

}

std.debug.print("{any}\n", .{myarray});

const otherarray = try allocator.alloc(f64, 3);

defer allocator.free(otherarray);

for (0..otherarray.len) |i| {

otherarray[i] = @floatFromInt(i);

}

std.debug.print("{any}\n", .{otherarray});

Ce programme, loggingallocator.zig

% ./loggingallocator

debug: alloc - success - len: 10, ptr_align: 0

{ 0, 1, 2, 3, 4, 5, 6, 7, 8, 9 }

debug: alloc - success - len: 24, ptr_align: 3

{ 0.0e+00, 1.0e+00, 2.0e+00 }

debug: free - len: 24

debug: free - len: 10

Que se passe-t-il si le·a programmeur·se se trompe et, par

exemple, utilise de la mémoire qui a été désallouée ? Le résultat

dépend de l'allocateur, et des sécurités qu'il fournit (d'où

l'importance du choix de l'allocateur). Par exemple, ce code

(memoryerrors.zig

var myallo = std.heap.GeneralPurposeAllocator(.{}){};

const allocator = myallo.allocator();

var myarray = try allocator.alloc(u8, 10);

for (0..myarray.len) |i| {

myarray[i] = @truncate(i);

}

allocator.free(myarray);

std.debug.print("Use after free: {any}\n", .{myarray});

va, avec cet allocateur, provoquer un plantage puisqu'on utilise de la mémoire qu'on vient de désallouer :

% ./memoryerrors

Use after free: { Segmentation fault at address 0x7f55f88e0000

Mais si on utilise à la place l'allocateur de la libc (plus rapide mais, comme vous le savez, beaucoup moins sûr), aucune erreur ne se produit (ce qui, en dépit des apparences, est un problème) :

const allocator = std.heap.c_allocator;

var myarray = try allocator.alloc(u8, 10);

for (0..myarray.len) |i| {

myarray[i] = @truncate(i);

}

allocator.free(myarray);

std.debug.print("Use after free: {any}\n", .{myarray});

var myotherarray = try allocator.alloc(u8, 10);

allocator.free(myotherarray);

allocator.free(myotherarray);

std.debug.print("Double free: {any}\n", .{myarray});

On doit le compiler en liant avec la libc (sinon, C allocator is only available when linking against libc) :

% zig build-exe memoryerrors.zig -lc

% ./memoryerrors

Use after free: { 212, 33, 0, 0, 0, 0, 0, 0, 59, 175 }

Double free: { 116, 99, 29, 2, 0, 0, 0, 0, 59, 175 }

En Zig, les bibliothèques qui ont besoin d'allouer de la mémoire

demandent qu'on leur fournisse un allocateur. Si on prend comme

exemple std.fmt.allocPrint,

qui formate une chaine de caractères, sa documentation précise

qu'elle attend comme premier paramètre une variable de type

std:mem.Allocator. L'allocateur à usage

généraliste convient donc :

const a = 2;

const b = 3;

var myallo = std.heap.GeneralPurposeAllocator(.{}){};

const allocator = myallo.allocator();

const mystring = try std.fmt.allocPrint(

allocator,

"{d} + {d} = {d}",

.{ a, b, a + b },

);

defer allocator.free(mystring);

std.debug.print("{s}\n", .{mystring});

(Source complet en allocformatting.zig

Zig permet évidemment d'utiliser des bibliothèques existantes, et d'écrire les siennes. Voyons un exemple avec le DNS. On va utiliser la bibliothèque zig-dns. Elle-même dépend de zig-network, pour envoyer et recevoir des paquets. On les télécharge :

git clone https://github.com/MasterQ32/zig-network.git git clone https://github.com/dantecatalfamo/zig-dns.git

Puis on écrit un programme qui les utilise, pour obtenir

l'adresse IP de www.afnic.fr :

// On importe les deux bibliothèques

const network = @import("zig-network/network.zig");

const dns = @import("zig-dns/src/dns.zig");

// Beaucoup de bibliothèques ont une fonction init, pour… les initialiser.

try network.init();

// On crée la prise réseau et on se « connecte » à son résolveur DNS, ici

// celui de DNS.sb

const sock = try network.connectToHost(allocator, "2a09::", 53, .udp);

const writer = sock.writer();

// La requête

const message = try dns.createQuery(allocator, "www.afnic.fr", .AAAA);

var message_bytes = try message.to_bytes(allocator);

try writer.writeAll(message_bytes);

// On lit la réponse

var recv = [_]u8{0} ** 1024;

const recv_size = try sock.receive(&recv);

const response = try dns.Message.from_bytes(allocator, recv[0..recv_size]);

std.debug.print("Response:\n{any}\n", .{response});

Compilé et exécuté, ce programme nous donne :

% ./use-zig-dns

…

Response:

Message {

Header {

ID: 1

Response: true

…

Answers {

Resource Record {

Name: www.afnic.fr.

Type: AAAA

Class: IN

TTL: 581

Resource Data Length: 16

Resource Data: 2a00:0e00:0000:0005:0000:0000:0000:0002

}

(L'adresse IP de www.afnic.fr est

2a00:e00:0:5::2, même si l'affichage par défaut

ne met pas en œuvre la compression du RFC 5952.) Le code complet est en use-zig-dns.zig

Zig n'a pas de macros. Les macros qui permettent de changer la syntaxe (comme le préprocesseur C) sont jugées trop dangereuses car rendant difficile la lecture d'un programme. Et celles qui ne changent pas la syntaxe sont moins nécessaires en Zig où on peut faire bien des choses à la compilation. Mais si vous voulez des exemples de tâches qu'on accomplirait avec une macro en C, regardez cette question que j'ai posée sur un forum, avec plusieurs très bonnes réponses.

Zig est fortement typé et un tel niveau de vérification peut

poser des problèmes lorsqu'on veut, par exemple, mettre en œuvre des

structures de données génériques. Par

exemple, une file d'attente FIFO de variables

d'un type quelconque. Zig résout en général ce problème avec

l'utilisation de types pour paramétrer un programme. Ces types comme

variables doivent pouvoir être évalués à la compilation, et sont

donc souvent marqués avec le mot-clé comptime

(compilation time) :

pub fn Queue(comptime Child: type) type {

return struct {

const This = @This();

const Node = struct {

data: Child,

next: ?*Node,

};

Ici, la file d'attente est programmée sous forme d'un enregistrement

(struct),

qui comprend des données d'un type Child

quelconque (mais connu à la compilation). Notez qu'une file est créée

en appelant la fonction Queue qui renvoie un

enregistrement qui comprend, entre autres, les fonctions qui opéreront

sur les files d'attente (permettant de faire partiellement de la

programmation objet). Le code complet est en

queue.zig

Zig se veut un concurrent de C mais, naturellement, ce n'est pas demain la veille que tout le code existant en C sera recodé en Zig, même dans les hypothèses les plus optimistes. Il est donc nécessaire de pouvoir utiliser les bibliothèques existantes écrites en C. C'est justement un des points forts de Zig : il peut importer facilement des déclarations C et donc permettre l'utilisation des bibliothèques correspondantes. Voyons tout de suite un exemple. Supposons que nous avons un programme en C qui calcule le PGCD de deux nombres et que nous n'avons pas l'intention de recoder (dans ce cas précis, il est suffisamment trivial pour être recodé, je sais) :

unsigned int

pgcd(unsigned int l, unsigned int r)

{

while (l != r) {

if (l > r) {

l = l - r;

} else {

r = r - l;

}

}

return l;

}

Zig peut importer ce programme (la commande zig

inclut clang pour analyser le C) :

const std = @import("std");

const c = @cImport(@cInclude("pgcd.c")); // No need to have a .h

pub fn main() !void {

…

std.debug.print("PGCD({d},{d}) = {d}\n", .{ l, r, c.pgcd(l, r) });

}

On notera qu'il n'y a pas besoin de déclarations C dans un fichier

.h (mais, évidemment, si vous avez un

.h, vous pouvez l'utiliser). Le programme se

compile simplement (et le pgcd.c est compilé automatiquement

grâce à clang) :

% zig build-exe find-pgcd.zig -I. % ./find-pgcd 9 12 PGCD(9,12) = 3

Pour compiler, au lieu de lancer zig build-exe,

on aurait pu créer un fichier build.zig

contenant les instructions nécessaires et, après un simple

zig build fait tout ce qu'il faut (ici,

l'application était suffisamment simple pour que ce ne soit pas

nécessaire). Un exemple d'un tel fichier est build.zigpgcd.cfind-pgcd.zig

Prenons maintenant un exemple d'une vraie bibliothèque C, plus

complexe. On va essayer avec la libidn, qui permet

de gérer des noms

de domaines internationalisés (noms en

Unicode, cf. RFC 5891). On va essayer de se servir de la fonction

idn2_to_ascii_8z, qui convertit un nom en

Unicode vers la forme Punycode (RFC 5892). D'abord, on va importer l'en-tête fourni

par cette bibliothèque (au passage, n'oubliez pas d'installer les

fichiers de développement, sur Debian, c'est

le paquetage

libidn2-dev) :

const idn2 = @cImport(@cInclude("idn2.h"));

Puis on crée les variables nécessaires à la fonction qu'on va utiliser :

var origin: [*c]u8 = args[1]; var destination: [*:0]u8 = undefined;

Le type *c indique une chaine de caractères

sous forme d'un pointeur du langage C, quant à

[*:0], c'est une chaine terminée par l'octet

nul, justement ce que la fonction C va nous renvoyer. On peut donc

appeler la fonction :

const result: c_int = idn2.idn2_to_ascii_8z(orig, @ptrCast(&dest),

idn2.IDN2_NONTRANSITIONAL);

Ce code peut ensuite être compilé et exécuté :

% ./use-libidn café.fr Punycode(café.fr) = xn--caf-dma.fr (return code is 0)

Comment est-ce qe j'ai trouvé quels paramètres exacts passer à cette fonction ? La documentation conçue pour les programmeurs C suffit souvent mais, si ce n'est pas le cas, si on connait C meux que Zig, et qu'on a un exemple de code qui marche en C, une technique bien pratique est de demander à Zig de traduire cet exemple C en Zig :

% zig translate-c example.c -lc > example.zig

Et l'examen du example.zig produit vous

donnera beaucoup d'informations.

Notez que je n'ai pas alloué de mémoire pour la chaine de caractères de destination, la documentation (pas très claire, je suis d'accord) disant que la libidn le fait.

Autre problème, le code Zig doit être lié à la libc explicitement (merci à Ian Johnson pour l'explication). Si vous ne le faites pas, vous n'aurez pas de message d'erreur mais (dépendant de votre plate-forme), une segmentation fault à l'adresse… zéro :

% zig build-exe use-libidn.zig -lidn2 % ./use-libidn café.fr Segmentation fault at address 0x0 ???:?:?: 0x0 in ??? (???) zsh: IOT instruction ./use-libidn café.fr % zig build-exe use-libidn.zig -lidn2 -lc % ./use-libidn café.fr Punycode(café.fr) = xn--caf-dma.fr (return code is 0)

Si vous utilisez un build.zig, n'oubliez donc

pas le exe.linkLibC();.

Si vous voulez essayer vous-même, voici use-libidn.zigbuild-libidn.zigbuild.zig avant de faire un zig

build). Si vous voulez d'autres exemples, vous pouvez

lire l'article de

Michael Lynch.

Une des forces de Zig est l'inclusion dans le langage d'un mécanisme de tests permettant de s'assurer du caractère correct d'un programme, et d'éviter les régressions lors de modifications ultérieures. Pour reprendre l'exemple du calcul du PGCD plus haut, on peut ajouter ces tests à la fin du fichier :

const expect = @import("std").testing.expect;

fn expectidentical(i: u32) !void {

try expect(c.pgcd(i, i) == i);

}

test "identical" {

try expectidentical(1);

try expectidentical(7);

try expectidentical(18);

}

test "primes" {

try expect(c.pgcd(4, 13) == 1);

}

test "pgcdexists" {

try expect(c.pgcd(15, 35) == 5);

}

test "pgcdlower" {

try expect(c.pgcd(15, 5) == 5);

}

Et vérifier que tout va bien :

% zig test find-pgcd.zig -I. All 4 tests passed.

Il n'y a pas actuellement de « vrai » programme écrit en Zig, « vrai » au sens où il serait utilisé par des gens qui ne connaissent pas le langage de programmation et s'en moquent. On lira toutefois un intéressant article sur le développement de Bun.

Si ce court article vous a donné envie d'approfondir Zig, voici quelques ressources en ligne :

- Le site officiel,

- Plus pédagogiques et progressifs, Ziglearn ou les géniaux Ziglings, où on apprend en corrigeant des programmes erronés (avec des indications, rassurez-vous),

- Côté forums, on a Zigg-it, Zig NEWS ou bien sûr StackOverflow (mais où les ziggistes semblent moins actifs),

- Et si vous hésitez entre Zig et d'autres langages, il y a une bonne comparaison avec les langages concurrents.

L'article seul

Visite des plate-formes Pharos et Thesee

Première rédaction de cet article le 3 octobre 2023

J'ai visité aujourd'hui les locaux du ministère de l'Intérieur (SDLC, Sous-Direction de Lutte contre la Cybercriminalité, à Nanterre) où sont installées les plate-formes Pharos (signalement de contenus illégaux) et Thesee (gestion centralisée des plaintes pour escroquerie). La visite avait été organisée par le député Renaissance Éric Bothorel.

C'était une visite très cadrée, évidemment. On n'a finalement pas vu la plate-forme Pharos mais elle nous a été décrite comme très proche de celle de Thesee (un grand open space avec des PC : rien de spectaculaire). Donc, pas de démonstration de l'informatique de Pharos.

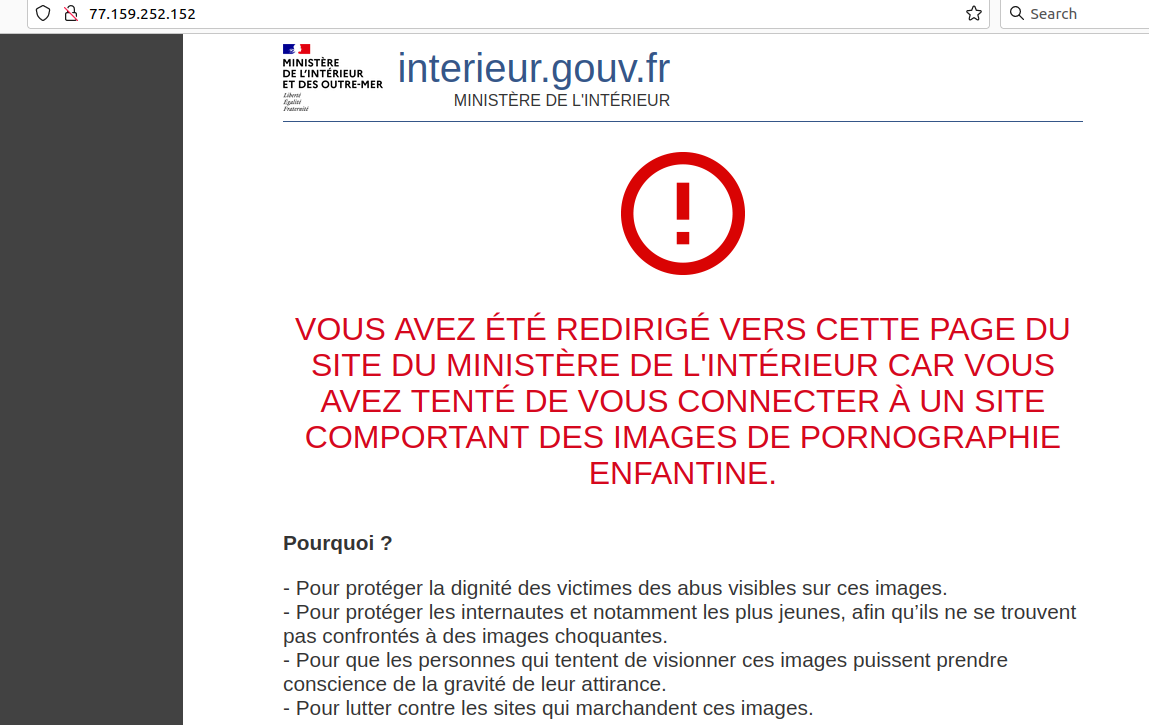

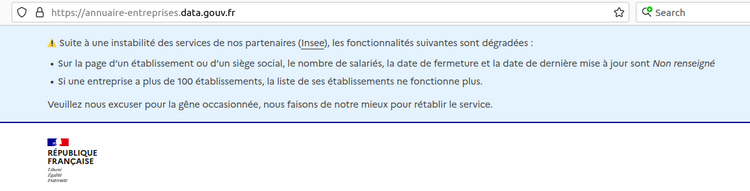

Pharos est le service derrière

https://www.internet-signalement.gouv.fr/

Tout contenu illégal est concerné : racisme, terrorisme, appel à la violence, pédopornographie, escroquerie (voir plus loin le rôle de Thesee), etc.

Les signalements peuvent être faits par des citoyens ordinaires, ou par des « signaleurs de confiance », les 84 personnnes morales qui ont signé un partenariat avec Pharos (la liste ne semble pas publique). Ces signaleurs de confiance peuvent signaler plusieurs URL d'un coup, et mettre une pièce jointe (ce qui n'est pas possible pour les signaleurs ordinaires, entre autres pour des raisons de sécurité).

Pour enquêter, les gens de Pharos utilisent les outils classiques de l'Internet plus des logiciels du marché et des développements locaux. Il ne semble pas qu'il existe un logiciel unique, regroupant tout ce dont l'enquêteur a besoin. (Mais je rappelle qu'on n'a pas eu de démonstration.) Pour ne pas être identifié comme la police (un site d'escroquerie pourrait leur servir un contenu différent), ils passent par un abonnement Internet ordinaire, qui n'est pas celui du ministère, et éventuellement par des VPN.

Pharos ne publie pas actuellement de rapport d'activité, avec des chiffres. Toutes les données chiffrées qui circulent viennent d'informations ponctuelles (par exemple de questions écrites à l'Assemblée nationale). Un amendement législatif récent (dû à Bothorel, au nom de l'open data) impose la publication d'un rapport d'activité régulier, avec des données chiffrées. La première édition du rapport est d'ailleurs prête, n'attendant que sa révision RGAA. En 2022, il y a eu 175 000 signalements (on ne sait pas pour combien de contenus, plusieurs signalements peuvent concerner le même), 390 procédures judiciaires ouvertes, 89 000 demandes administratives de retrait, 354 blocages exigés (leur liste n'est pas publique contrairement à, par exemple, celle de l'ANJ).

Le nombre de signalements varie beaucoup avec l'actualité, par exemple lors des troubles suivant la mort de Nahel Merzouk à Nanterre. C'est notamment le cas pour la rubrique « terrorisme », très liée à l'actualité. Seule la pédo-pornographie a un rythme constant.

Pharos ne travaille que sur du contenu public (tweet, site Web), afin de pouvoir le vérifier et le qualifier, donc une insulte raciste sur WhatsApp, par exemple, n'est pas de leur ressort.

Les signalements sont évidemment de qualité variable. Ils peuvent concerner du contenu légal, ou être franchement incompréhensibles. (Les responsables disent qu'ils n'ont pas vu beaucoup de signalements malveillants ; les erreurs sont nombreuses, mais de bonne foi.) Par exemple un type avait fait une vidéo très bizarre (« ambiance et bruitages ») sur la disparition du petit Émile, et elle avait été signalée comme « c'est peut-être lui le coupable ». Pharos ne tient pas compte du nombre de signalements pour un contenu donné, chaque signalement compte.

Pharos emploie entre 40 et 50 personnes (selon les fluctuations, le burn out est un problème, voir plus loin), tou·tes policiers et gendarmes. Il y a un peu de spécialisation : un pôle est spécialisé dans l'ouverture des procédures judiciaires, un autre dans l'expression de la haine en ligne, jugée assez différente pour avoir son propre pôle.

Lors d'un interview à France Inter, la semaine dernière, la présidente du Haut Conseil à l'Égalité, en réponse au journaliste qui lui demandait si elle prônait l'augmentation des effectifs de Pharos pour les nouvelles règles sur la pornographie, avait répondu que ce n'était pas nécessaire car « [le problème] est très facile, il suffit d'utiliser les techniques d'Intelligence Artificielle ». Nos interlocuteurs ont affirmé que Pharos n'utilisait pas du tout d'IA, que peut-être dans le futur, mais se sont montrés plutôt sceptiques, vu la difficulté à qualifier exactement les cas auxquels ielles sont confrontés. L'humain reste irremplaçable, à leur avis.

Sur le problème psychologique, puisque les enquêteurs voient passer pas mal d'horreurs (par exemple les vidéos de Daech) : la politique de Pharos est qu'il n'y a pas de jugement de valeur si un employé n'y arrive plus. « Pas de culture viriliste », « Même les grands et forts peuvent avoir des problèmes ». Les employés ont droit à une aide psychologique.

Un autre pôle à Pharos est celui chargé des mesures administratives (ne passant pas par le contrôle d'un juge). Pharos peut demander à un hébergeur le retrait d'un contenu, et si ce n'est pas fait, ordonner aux grands FAI de bloquer (presque toujours par résolveur DNS menteur). C'est une « erreur humaine » qui a été la cause du blocage de Telegram.

Et Thesee ? Cette plate-forme, plus récente (mars 2022), et que nous avons visitée (comme dit plus haut : un grand open space avec des PC, rien d'extraordinaire), est consacrée à la centralisation de certaines plaintes sur l'escroquerie. (Vous pouvez enregistrer votre plainte via Thesee.) L'idée est que beaucoup d'escroqueries portent sur des petites sommes et que, si on regarde individuellement les plaintes, elles peuvent sembler peu importantes et être mises en bas de la pile de dossiers à traiter. Or, ces « petites » escroqueries peuvent être l'œuvre de gens qui travaillent en grand et escroquent de nombreuses personnes, donc le montant total peut être important. Mais, sans centralisation et regroupement, on peut ne pas voir qu'il ne s'agit pas de manœuvres isolées. Thesee est donc une plate-forme humaine d'analyse de ces clusters. Par exemple, si dix escroqués ont porté plainte contre un faux vendeur et que l'IBAN du vendeur est toujours le même, on a trouvé un cluster. Un logiciel aide à effectuer ces regroupements. (Mais la démonstration de ce logiciel n'a pas fonctionné.) De toute façon, aussi bien pour Thesee que pour Pharos, les enquêteurs ont insisté sur le fait que la technique ne peut pas tout, qu'une enquête est surtout un travail humain.

Thesee compte 32 personnes. Déjà 100 000 plaintes.

Ces escroqueries touchent souvent des personnes vulnérables, et les enquêteurs de Thesee sont souvent confrontés à la détresse des victimes, quand on leur apprend qu'ils ne reverront jamais leurs économies, ou que la jolie femme qui, depuis l'autre bout du monde, leur affirmait qu'elle était tombée amoureuse d'eux et avait juste besoin de 4 000 € pour venir les rejoindre, n'existait pas. Bref, il faut être bienveillant lors des contacts avec les victimes, d'autant plus que l'entourage de celles-ci ne l'est pas toujours (« mais comment as-tu pu être aussi bête ? »).

Pendant la visite. De gauche à droite, Jeanne Bouligny, Éric

Bothorel, Pierre Beyssac et moi :

L'article seul

RFC 9476: The .alt Special-Use Top-Level Domain

Date de publication du RFC : Septembre 2023

Auteur(s) du RFC : W. Kumari (Google), P. Hoffman (ICANN)

Chemin des normes

Première rédaction de cet article le 30 septembre 2023

Le TLD

.alt a été réservé pour les utilisations

non-DNS. Si demain

je crée une chaine de blocs nommée Catena et

que j'enregistre des noms dessus, il est recommandé qu'ils se

terminent par catena.alt (mais comme toujours

sur l'Internet, il n'y a pas de police mondiale chargée de faire

respecter les RFC).

Ce nouveau RFC

est l'occasion de rappeler que noms

de domaine et DNS, ce

n'est pas pareil. Les noms de domaine existaient avant le DNS

et, même aujourd'hui, peuvent être résolus par d'autres techniques

que le DNS (par exemple votre fichier local

/etc/hosts ou équivalent).

Mais le DNS est un tel succès que cette « marque » est utilisée

partout. On voit ainsi des systèmes de résolution de noms n'ayant

rien à voir avec le DNS se prétendre « DNS pair-à-pair » ou « DNS

sur la blockchain », ce

qui n'a aucun sens. Ce nouveau RFC, lui, vise clairement uniquement

les systèmes non-DNS. Ainsi, des racines alternatives ou des

domaines privés comme le

.local du RFC 6762 ne

rentrent pas dans son champ d'application. De plus, il ne s'applique

qu'aux noms de domaine ou en tout cas aux identificateurs qui leur

ressemblent suffisamment. Si vous créez un système complètement

disruptif où les identificateurs ne ressemblent pas à des noms de

domaine, ce RFC ne vous concerne pas non plus. Mais si, pour des

raisons techniques (être compatible avec les applications

existantes) ou marketing (les noms de domaine, c'est bien, tout le

monde les reconnait), vous choisissez des noms de domaine comme

identificateurs, lisez ce RFC.

En effet, il existe plusieurs de ces systèmes. Ils permettent, en

indiquant un nom de domaine (c'est-à-dire une

série de composants séparés par des points comme

truc.machin.chose.example) d'obtenir des

informations techniques, permettant, par exemple, de trouver un

serveur ou de s'y connecter. Un exemple d'un tel système est le

mécanisme de résolution utilisé par Tor. Les

identificateurs sont construits à partir d'une clé

cryptographique et suffixés d'un

.onion (réservé par le RFC 7686). Ainsi, ce blog est en

http://sjnrk23rmcl4ie5atmz664v7o7k5nkk4jh7mm6lor2n4hxz2tos3eyid.onion/. N'essayez

pas ce nom dans le DNS : vous ne le trouverez pas, il se résout via

Tor.

Pendant longtemps, cette pratique de prendre, un peu au hasard,

un nom et de l'utiliser comme TLD a été la façon la plus courante de créer des

noms de domaine dans son espace à soi. C'est ainsi que

Namecoin a utilisé le

.bit, ENS (Ethereum Name Service) le

.eth et GNUnet le

.gnu. Chacun prenait son nom comme il voulait,

sans concertation (il n'existe pas de forum ou d'organisation pour

discuter de ces allocations). Cela entraine deux risques, celui de

collision (deux systèmes de nommage utilisent le même TLD, ou bien

un système de nommage utilise un TLD qui est finalement alloué dans

le DNS, ce qui est d'autant plus probable qu'il n'existe pas de

liste de ces TLD non-DNS). Il y a plusieurs solutions à ce problème,

et l'IETF en a longuement discuté (cf. par exemple

l'atelier

EName de 2017, ou bien le très contestable RFC 8244). Ce RFC a donc mis des années à sortir. L'ICANN, par exemple, a essayé de diaboliser ces

noms, attirant surtout l'attention sur leurs dangers. Autre méthode,

il a été suggéré de créer un mécanisme de concertation pour éviter

les collisions, création qui n'a jamais eu lieu, et pas pour des

raisons techniques. Ce RFC 9476 propose simplement de

mettre les noms non-DNS sous un TLD unique, le

.alt. Ce TLD est réservé dans le registre

des noms spéciaux (créé par le RFC 6761). Ainsi, si le système de résolution de Tor était

créé aujourd'hui, on lui proposerait d'être en

.onion.alt. Est-ce que les concepteurs de

futurs systèmes de résolution non-DNS se plieront à cette demande ?

Je suis assez pessimiste à ce sujet. Et il serait encore plus

utopique de penser que les TLD non-DNS existants migrent vers

.alt.

Comme .alt, par construction, regroupe des

noms qui ne sont pas résolvables dans le DNS, un résolveur purement

DNS ne peut que répondre tout de suite NXDOMAIN (ce nom n'existe

pas) alors qu'un résolveur qui parle plusieurs protocoles peut

utiliser le suffixe du nom comme une indication qu'il faut utiliser

tel ou tel protocole. Si jamais des noms sous

.alt sont réellement utilisés, ils ne devraient

jamais apparaitre dans le DNS (par exemple dans les requêtes aux

serveurs racine) mais, compte-tenu de

l'expérience, il n'y a aucun doute qu'on les verra fuiter dans le

DNS. Espérons que des techniques comme celles du RFC 8020, du RFC 8198 ou du RFC 9156 réduiront la

charge sur les serveurs de la racine; et préserveront un peu la vie

privée (section 4 du RFC).

Le nom .alt est évidemment une référence à

alternative mais il rappelera des souvenirs aux utilisateurs

d'Usenet. D'autres noms avaient été

sérieusement discutés comme de préfixer

tous les TLD non-DNS par un tiret

bas. Mon catena.alt aurait été

_catena :-) Tout ce qui touche à la

terminologie est évidemment très sensible, et le RFC prend soin de

souligner que le terme de « pseudo-TLD », qu'il utilise pour

désigner les TLD non-DNS n'est pas péjoratif…

On note que le risque de collision existe toujours, mais sous

.alt. Notre RFC ne prévoit pas de registre des

noms sous .alt (en partie parce que

l'IETF

ne veut pas s'en mêler, son protocole, c'est le DNS, et en partie

parce que ce milieu des mécanismes de résolution différents est très

individualiste et pas du tout organisé).

L'article seul

MaginotDNS, une faiblesse de certains résolveurs DNS

Première rédaction de cet article le 27 septembre 2023

Dernière mise à jour le 28 septembre 2023

La faille de sécurité MaginotDNS est une faiblesse de certains résolveurs DNS, qui ne vérifient pas assez les données quand elles sont envoyées par un résolveur à qui ils avaient fait suivre leurs requêtes. Elle peut permettre l'empoisonnement du résolveur par de fausses données.

La faille a été présentée à Usenix, a son propre site Web, et a été désignée par CVE-2021-25220 (pour BIND ; Knot a eu CVE-2022-32983 et Technitium CVE-2021-43105). Elle frappe plusieurs logiciels, BIND (quand on l'utilise comme résolveur), Knot Resolver, le résolveur de Microsoft et Technitium. Elle se produit quand le résolveur fait suivre (to forward) les requêtes DNS pour certains domaines à un autre résolveur (ce que l'article nomme un CDNS, Conditional Domain Name Server). Voici un exemple de configuration de BIND qui, sur une version vulnérable du logiciel, peut permettre la faille :

options {

recursion yes;

dnssec-validation no;

};

zone "unautredomaine.example." {

type forward;

forwarders { 192.0.2.1; };

};

Cette configuration se lit ainsi : pour tous les noms de domaine sous

unautredomaine.example, BIND va, au lieu de

passer par le mécanisme de résolution habituel (en commençant par la

racine), faire

suivre la requête au résolveur

192.0.2.1 (une autre configuration, avec

stub à la place de

forward, permet de faire suivre à un serveur

faisant autorité ; en pratique, avec certains logiciels, on peut

faire suivre aux deux et, parfois, cela permet d'exploiter la faille).

Évidemment, si on écrit une telle configuration, c'est qu'on

estime que 192.0.2.1 est légitime et digne de

confiance pour le domaine

unautredomaine.example (et ceux en-dessous, les noms de

domaine étant arborescents). Mais la faille

MaginotDNS permet d'empoisonner le résolveur pour tous les

noms à partir de 192.0.2.1,

ou d'une machine se faisant passer pour

lui.

Le DNS sur UDP (le mode par défaut) ne protège pas contre

une usurpation d'adresse

IP. Une machine peut donc répondre à la place du vrai

192.0.2.1. Pour empêcher cela, le DNS dispose

de plusieurs protections :

- L'attaquant qui va répondre à la place du serveur légitime doit deviner le Query ID de la requête,

- Et (depuis l'attaque Kaminsky) le port source,

- Et de toute façon le résolveur n'acceptera que les réponses

qui sont dans le bailliage

(in-bailiwick) de la question. S'il a demandé

truc.machin.exampleet qu'on lui répond par un enregistrement pourchose.example, il ne gardera pas cette information qui est hors-bailliage.

Du fait de la dernière règle, sur le bailliage, un attaquant qui

contrôle 192.0.2.1 ne pourrait que donner des

informations sur les noms sous

unautredomaine.example.

Mais les chercheurs qui ont découvert MaginotDNS ont repéré une faille dans le contrôle du bailliage : celui-ci est, sur certains logiciels, bien trop laxiste, lorsque la demande a été transmise à un autre résolveur et pas à un serveur faisant autorité. Il est donc possible de faire passer des données hors-bailliage. L'article donne l'exemple d'une réponse qui inclurait l'enregistrement mensonger :

com. IN NS ns1.nasty.attacker.example.

Une telle réponse, clairement hors-bailliage, ne devrait pas être

acceptée. Mais elle l'est (plus exactement, l'était, les logiciels vulnérables

ont tous été corrigés) lorsqu'elle vient du résolveur à qui on a

fait suivre une requête. À partir de là, le résolveur empoisonné

fait passer toutes les requêtes des noms en

.com à l'ennemi…

L'attaquant a plusieurs moyens d'exploiter cette faiblesse. Je vais en citer deux :

- La plus évidente est de contrôler la machine listée

forwarder(192.0.2.1dans l'exemple plus haut). Bien sûr, si on décide de faire suivre à192.0.2.1, c'est qu'on lui fait confiance. Mais on lui fait une confiance limitée, àunautredomaine.example. Avec MaginotDNS,192.0.2.1peut injecter des réponses pour tout domaine. (Cette attaque est appelée on-path dans l'article mais cette terminologie est inhabituelle.) - Sans doute plus réaliste est le cas où l'attaquant ne

contrôle pas la machine listée

forwarder. Il doit alors répondre à sa place en essayant de deviner Query ID et port source, ce qui n'est pas impossible (l'article donne les détails de ce cas, appelé off-path).

Dans les deux cas, l'absence de contrôle correct du bailliage permet à l'attaquant d'empoisonner n'importe quel nom.

Quelles sont les solutions que l'administrateur système peut déployer :

- Bien sûr mettre à jour ses logiciels (la faille a été bouchée dans tous les programmes vulnérables). Il faut le répéter : les logiciels doivent être maintenus à jour. Aucune excuse ne doit être admise.

- DNSSEC,

qui avait justement été conçu

pour cela, protège complètement (c'est pour cela que la

configuration vulnérable, plus haut, a