Ce blog n'a d'autre prétention que de me permettre de mettre à la disposition de tous des petits textes que j'écris. On y parle surtout d'informatique mais d'autres sujets apparaissent parfois.

RFC 9154: Extensible Provisioning Protocol (EPP) Secure Authorization Information for Transfer

Date de publication du RFC : Décembre 2021

Auteur(s) du RFC : J. Gould, R. Wilhelm (VeriSign)

Chemin des normes

Réalisé dans le cadre du groupe de travail IETF regext

Première rédaction de cet article le 31 décembre 2021

Le protocole EPP d'avitaillement des noms de domaine permet, entre autres opérations, de transférer un domaine d'un client (typiquement un BE) à un autre. Cette opération ouvre de sérieux problèmes de sécurité, le transfert pouvant être utilisé pour détourner un nom de domaine. En général, la sécurisation de ce transfert est faite par un mot de passe stocké en clair. Notre RFC décrit une méthode pour gérer ces mots de passe qui évite ce stockage, et qui gêne sérieusement les transferts malveillants.

EPP est normalisé dans le RFC 5730 et c'est ce document qui décrit le cadre général

d'autorisation d'un transfert de domaines. La forme exacte que prend

l'autorisation dépend du type d'objets qu'on gère avec EPP. Pour les

domaines (RFC 5731), c'est un élément

<authInfo>, qui peut contenir divers

types de sous-élements mais le plus fréquent est un simple

mot de passe (parfois appelé « code de

transfert » ou « code d'autorisation », ou simplement « authinfo »),

comme dans cet exemple, une réponse à une commande EPP

<info>, où le mot de passe est

« 2fooBAR » :

<domain:infData>

<domain:name>example.com</domain:name>

...

<domain:crDate>1999-04-03T22:00:00.0Z</domain:crDate>

...

<domain:authInfo>

<domain:pw>2fooBAR</domain:pw>

</domain:authInfo>

</domain:infData>

L'utilisation typique de ce mot de passe est que le client (en

général un BE)

le crée, le stocke en clair, l'envoie au serveur, qui le

stocke. Lors d'un transfert légitime, le BE gagnant recevra ce mot

de passe (typiquement via le titulaire de l'objet, ici un nom de

domaine) et le transmettra au registre (RFC 5731, section 3.2.4). Ici, le BE gagnant demande à son

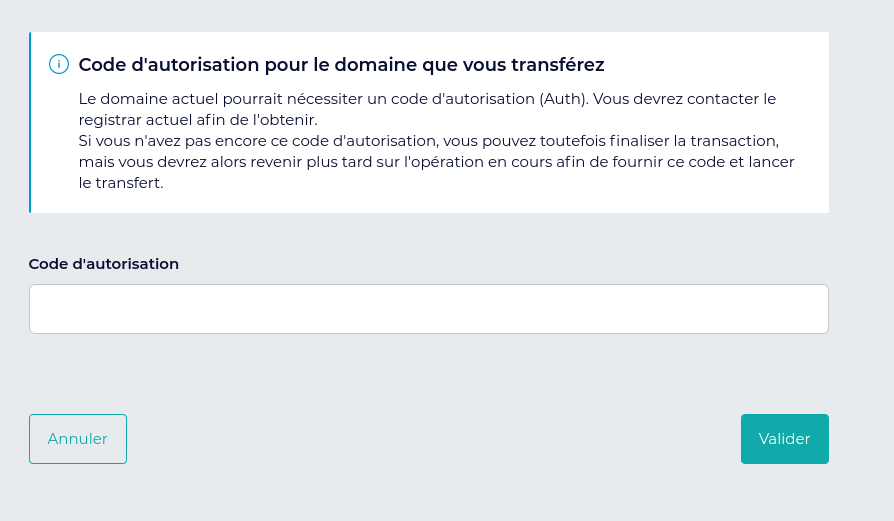

client le code d'autorisation qu'il a normalement obtenu via le BE

perdant (si le client est vraiment le titulaire légitime) :  Et ici le BE perdant indique à

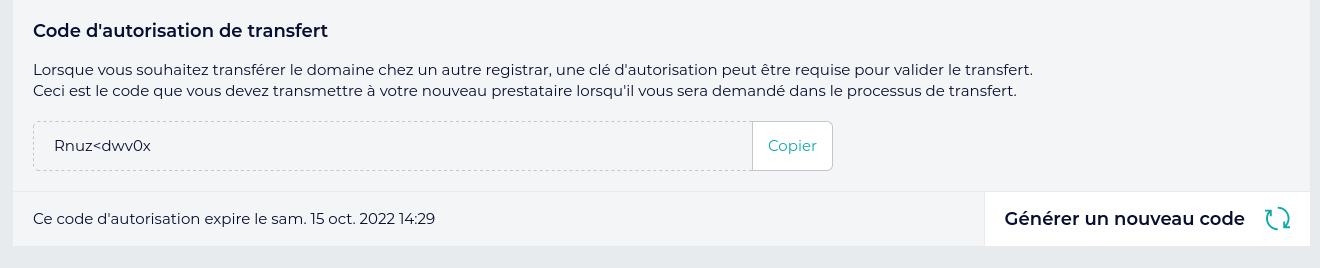

son client le code d'autorisation :

Et ici le BE perdant indique à

son client le code d'autorisation :  (registar = BE)

(registar = BE)

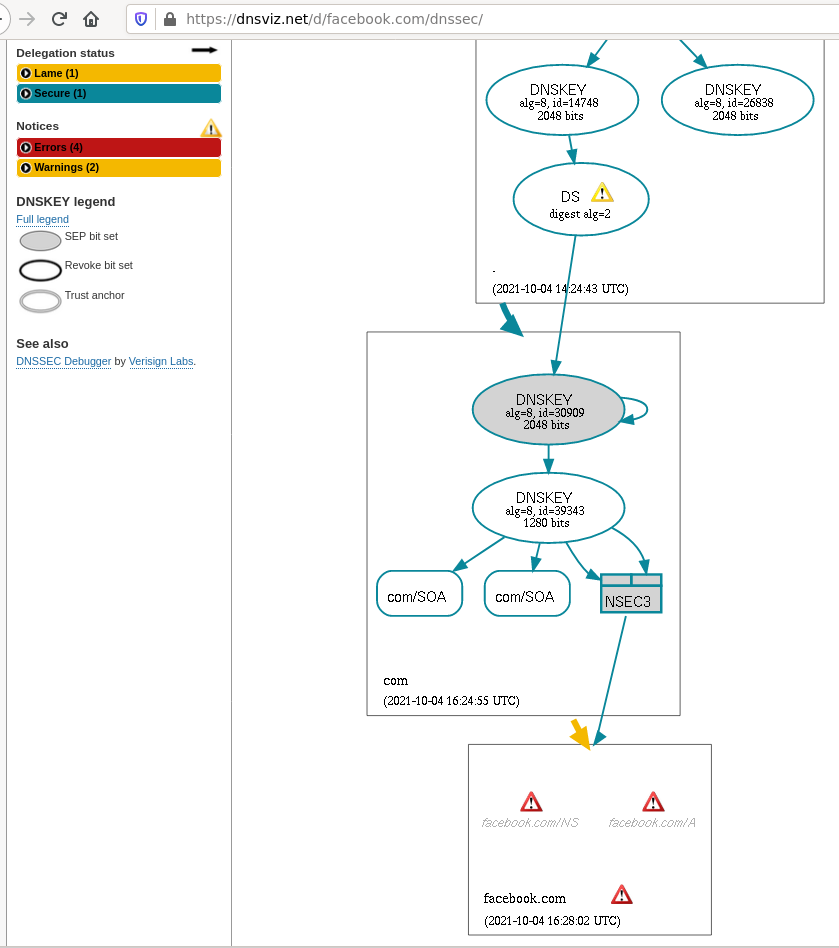

Notez que la façon d'autoriser les transferts, et d'accéder aux informations d'autorisation, dépend de la politique du registre. Les RFC sur EPP normalisent la technique mais pas la politique. Par exemple, lorsqu'un BE demande un transfert sans fournir d'information d'autorisation, certains registres refusent immédiatement le transfert, tandis que d'autres le mettent en attente d'une acceptation ou d'un refus explicite. De même, certains registres permettent de récupérer l'information d'autorisation, comme dans l'exemple ci-dessus, alors que d'autres (comme CentralNic) refusent.

Même chose pour d'autres types d'objets comme les contacts (RFC 5733) même si en pratique la pratique du transfert est plus rare pour ces types. Le mot de passe étant typiquement stocké en clair chez le client, pour pouvoir être donné en cas de transfert, on voit les risques que cela pose en cas d'accès à la base du BE. Aujourd'hui, stocker un mot de passe en clair est nettement considéré comme une mauvaise pratique de sécurité.

À la place, notre RFC décrit, non pas une modification du protocole EPP, mais une nouvelle procédure, une façon créative de se servir du protocole existant pour gérer ces informations d'autorisation de manière plus sérieuse : l'objet (par exemple le nom de domaine) est créé sans information d'autorisation, le serveur EPP (par exemple le registre de noms de domaine) doit refuser le transfert si cette information est manquante. Lors d'un transfert légitime, le client (par exemple un BE) perdant va générer un mot de passe, le transmettre au registre et à son client (typiquement le titulaire du nom de domaine) et ne pas le stocker. Le registre stockera le mot de passe uniquement sous forme condensée et, lorsqu'il recevra la demande de transfert accompagnée d'un mot de passe, il pourra condenser ce mot et vérifier qu'il correspond bien à celui stocké. Le mot ne servira qu'une fois et l'information d'autorisation est détruite après le succès du transfert. Tout ceci ne nécessite pas de modification du protocole, mais, dans certains cas, une modification des pratiques des différents acteurs (par exemple, le serveur EPP doit accepter qu'un objet soit créé sans information d'autorisation, et doit considérer que cela vaut refus de tout transfert).

Le RFC note que la norme EPP ne décrit, logiquement, que le protocole, c'est-à-dire l'interaction entre les deux machines, mais pas ce que fait chaque machine de son côté. Ainsi, la nécessité de stocker les mots de passe de manière sécurisée n'est pas imposée par EPP (mais est néanmoins une bonne pratique).

D'autre part, EPP ne prévoit pas explicitement de durée de vie pour les mots de passe (mais n'interdit pas non plus de les supprimer au bout d'un temps donné, ce qui va être justement la technique de notre RFC).

Petite révision sur les acteurs de l'avitaillement de noms de domaine en section 2 du RFC. La norme EPP parle de client et de serveur, notions techniques, mais du point de vue business, il y a trois acteurs (cf. la terminologie dans le RFC 8499), le registre (qui gère le serveur EPP), le bureau d'enregistrement (BE, qui gère le client EPP) et le titulaire (qui se connecte à son BE via une interface Web ou une API). Dans beaucoup de domaines d'enregistrement, il n'y a aucun lien direct entre le titulaire et le registre, tout devant passer par le BE.

Maintenant, place à la description de la nouvelle manière de faire

des transferts. Bien qu'elle ne change pas le protocole, qu'elle ne

soit qu'une nouvelle façon d'utiliser ce qui existe déjà dans EPP,

elle doit se signaler lors de la connexion EPP, avec

l'espace de noms

urn:ietf:params:xml:ns:epp:secure-authinfo-transfer-1.0

(enregistré

à l'IANA). En effet, la nouvelle manière a besoin que le

serveur accepte des choses qui sont autorisées par EPP mais pas

obligatoires, notamment :

- une information d'autorisation vide (représentée par exemple

par le

NULLdans une base SQL), - la possibilité de supprimer l'information d'autorisation

avec la commande EPP

<update>, - la possibilité de valider l'information d'autorisation

avec la commande EPP

<info>, - le refus de tout transfert si l'information d'autorisation est vide,

- la remise à zéro de l'information d'autorisation lorsque le transfert a été réalisé (mot de passe à usage unique).

Le serveur, lui, en recevant

urn:ietf:params:xml:ns:epp:secure-authinfo-transfer-1.0,

peut compter que le client EPP saura :

- générer une information d'autorisation forte (aléatoire, par exemple),

- ne le faire que lorsqu'un transfert est demandé.

L'autorisation d'information dans l'élement XML

<domain:pw> (RFC 5731, section 3.2.4) est un mot de passe qui doit être

difficile à deviner par un attaquant. Idéalement, il doit être

aléatoire ou équivalent (RFC 4086). Le RFC

calcule que pour avoir 128 bits d'entropie, avec uniquement les

caractères ASCII imprimables, il faut environ 20

caractères.

Pour compenser l'absence de la notion de durée de vie de l'information d'autorisation dans EPP, le client ne doit définir une information d'autorisation que lorsqu'un transfert est demandé, et supprimer cette information ensuite. La plupart du temps, le domaine n'aura pas d'information d'autorisation, et les transferts seront donc refusés.

L'information d'autorisation, comme tout mot de passe, ne doit plus être stockée en clair, mais sous forme d'un condensat. Le BE perdant ne doit pas la stocker (il la génère, la passe au titulaire et l'oublie ensuite). Le BE gagnant ne doit la stocker que le temps de finaliser le transfert. Évidemment, toute la communication EPP doit être chiffrée (RFC 5734). Lors d'une demande de transfert, le registre va vérifier qu'un condensat de l'information d'autorisation transmise par le BE gagnant correspond à ce que le BE perdant avait envoyé. L'information vide est un cas particulier, le registre ne doit pas tester l'égalité mais rejeter le transfert.

La section 4 explique en détail le processus de transfert avec cette nouvelle méthode :

- Quand le domaine est créé, l'information d'autorisation est vide (pas de « authinfo »),

- quand le titulaire veut transférer le nom à un nouveau BE, il demande au BE perdant l'information d'autorisation,

- le BE perdant génère un mot de passe, qu'il transmet au titulaire et au registre (qui peut répondre avec le code d'erreur EPP 2202 si ce mot de passe ne lui semble pas assez fort), puis qu'il oublie aussitôt,

- le titulaire donne le mot de passe au BE gagnant,

- le BE gagnant demande le transfert au registre, en fournissant le mot de passe, ce qui permet au transfert d'être accepté immédiatement,

- le registre (ou bien le BE perdant), efface le mot de passe.

Voici en EPP quelques messages pour réaliser ces différentes opérations. D'abord, la création d'un nom (notez le mot de passe vide) :

<create>

<domain:create

xmlns:domain="urn:ietf:params:xml:ns:domain-1.0">

<domain:name>example.test</domain:name>

<domain:authInfo>

<domain:pw/>

</domain:authInfo>

</domain:create>

</create>

Ici, la mise à jour de l'information d'autorisation par le BE

perdant, lorsque le titulaire lui a annoncé le départ du domaine ;

le mot de passe est

LuQ7Bu@w9?%+_HK3cayg$55$LSft3MPP (le RFC

rappelle fortement l'importance de générer un mot de passe fort, par

exemple en utilisant des sources bien aléatoires, comme documenté

dans le RFC 4086) :

<update>

<domain:update

xmlns:domain="urn:ietf:params:xml:ns:domain-1.0">

<domain:name>example.test</domain:name>

<domain:chg>

<domain:authInfo>

<domain:pw>LuQ7Bu@w9?%+_HK3cayg$55$LSft3MPP</domain:pw>

</domain:authInfo>

</domain:chg>

</domain:update>

</update>

Le BE perdant devra peut-être également supprimer l'état

clientTransferProhibited, si le domaine était

protégé contre les transferts.

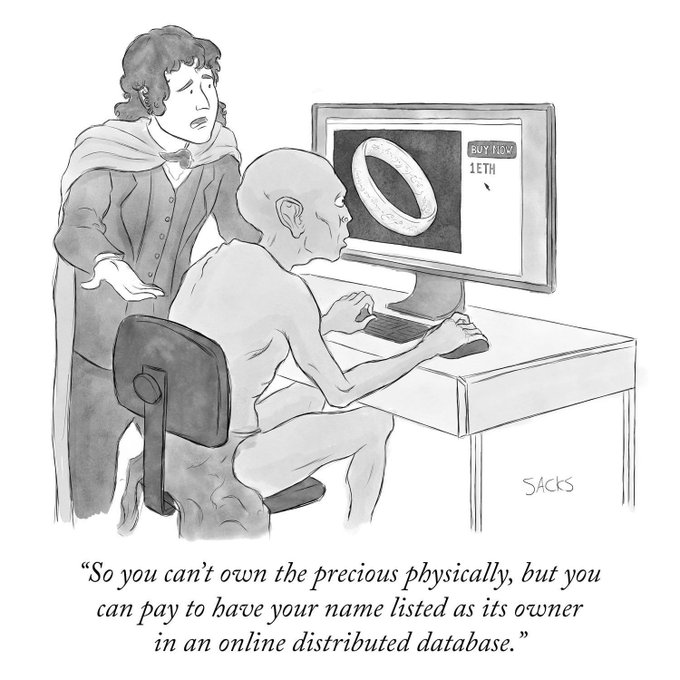

Le BE gagnant peut également vérifier l'information

d'autorisation sans déclencher un transfert, avec une requête

<info>, qui lui renverra l'information

d'autorisation. Pour plusieurs exemples par la suite, j'ai utilisé le

logiciel Cocca. Cocca,

par défaut, ne stocke pas l'autorisation d'information en clair et

ne peut donc pas la renvoyer.

Ou bien le client EPP peut envoyer une commande

<info> en indiquant l'information

d'autorisation. S'il obtient une erreur EPP 2202 (RFC 5730, section 3), c'est que cette

information n'était pas correcte. Ici, la

réponse EPP de Cocca lorsqu'on lui envoie un

<info> avec information d'autorisation correcte :

Client : <info xmlns="urn:ietf:params:xml:ns:epp-1.0"><info xmlns="urn:ietf:params:xml:ns:domain-1.0"><name>foobar.test</name><authInfo xmlns="urn:ietf:params:xml:ns:domain-1.0"><pw xmlns="urn:ietf:params:xml:ns:domain-1.0">tropfort1298</pw></authInfo></info></info> Serveur : ... <ns1:authInfo><ns1:pw>Authinfo Correct</ns1:pw></ns1:authInfo> ...

Et si cette information est incorrecte :

Serveur : ... <ns1:authInfo><ns1:pw>Authinfo Incorrect</ns1:pw></ns1:authInfo>

(Mais Cocca répond quand même avec un code EPP 1000, ce qui n'est pas correct.)

Et enfin, bien sûr, voici la demande de transfert elle-même :

<transfer op="request">

<domain:transfer

xmlns:domain="urn:ietf:params:xml:ns:domain-1.0">

<domain:name>example1.com</domain:name>

<domain:authInfo>

<domain:pw>LuQ7Bu@w9?%+_HK3cayg$55$LSft3MPP</domain:pw>

</domain:authInfo>

</domain:transfer>

</transfer>

Et si c'est bon :

<ns0:response xmlns:ns0="urn:ietf:params:xml:ns:epp-1.0" xmlns:ns1="urn:ietf:params:xml:ns:domain-1.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"><ns0:result code="1000"><ns0:msg>Command completed successfully</ns0:msg></ns0:result><ns0:msgQ count="2" id="3" />

<ns1:trStatus>serverApproved</ns1:trStatus> ...

Et avec une mauvaise information d'autorisation :

<ns0:response xmlns:ns0="urn:ietf:params:xml:ns:epp-1.0"><ns0:result code="2202"><ns0:msg>Invalid authorization information; (T07) Auth Info Password incorrect</ns0:msg></ns0:result>...

La section 6 du RFC décrit le problème de la transition depuis

l'ancien modèle d'autorisation vers le nouveau. Notez que certains

registres peuvent avoir une partie du nouveau système déjà en

place. Le registre qui désire transitionner doit d'abord s'assurer

que l'information d'autorisation absente ou vide équivaut à un

rejet. Il doit ensuite permettre aux BE de mettre une information

d'autorisation vide, permettre que la commande

<info> puisse tester une information

d'autorisation, s'assurer que l'acceptation d'un transfert supprime

l'information d'autorisation, etc.

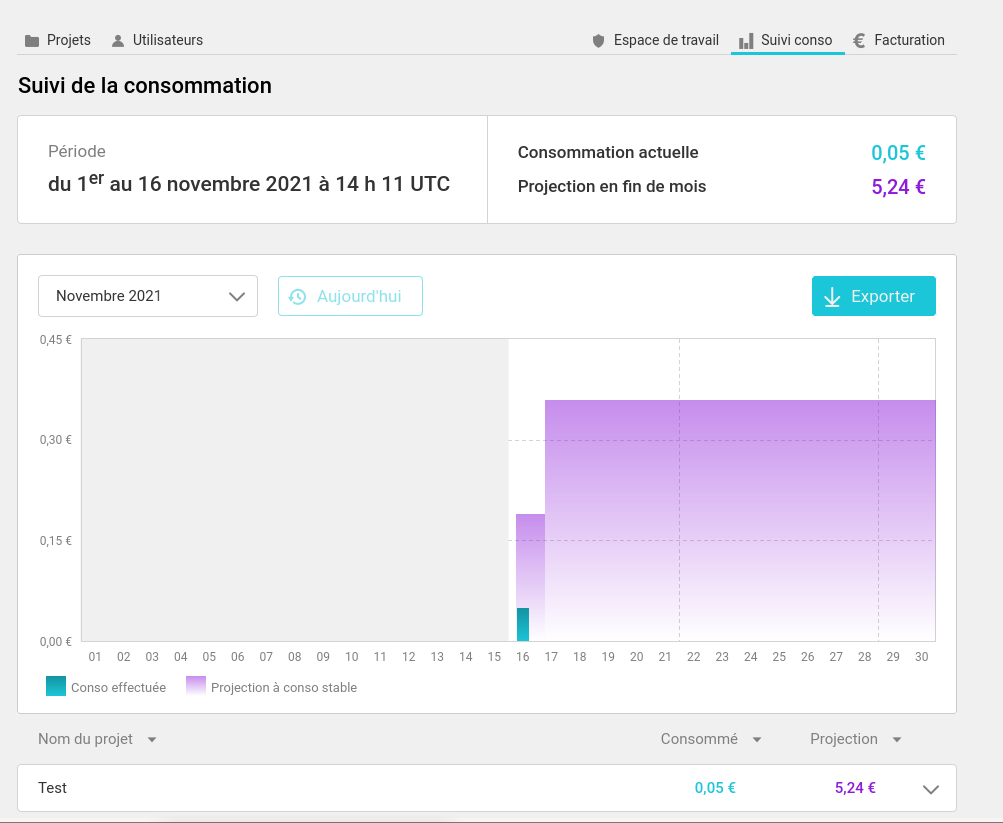

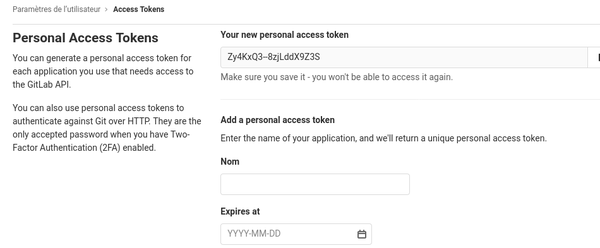

L'extension à EPP décrite dans ce RFC a été enregistrée dans le registre des extensions EPP. Quelles sont les mises en œuvre de ce RFC ? Cocca, déjà cité, le fait partiellement (par exemple en ne stockant pas les mots de passe en clair). Je n'ai pas testé avec ce logiciel ce qui se passait avec une information d'autorisation vide. Sinon, CentralNic a déjà ce mécanisme en production. Et Verisign l'a mis dans son SDK.

L'article seul

RFC 9167: Registry Maintenance Notification for the Extensible Provisioning Protocol (EPP)

Date de publication du RFC : Décembre 2021

Auteur(s) du RFC : T. Sattler, R. Carney, J. Kolker (GoDaddy)

Chemin des normes

Réalisé dans le cadre du groupe de travail IETF regext

Première rédaction de cet article le 26 décembre 2021

Un registre, par exemple un registre de noms de domaine, utilise parfois le protocole EPP pour la communication avec ses clients. Ce RFC décrit comment utiliser ce protocole pour informer les clients des périodes d'indisponibilité du registre, par exemple lors d'une opération de maintenance.

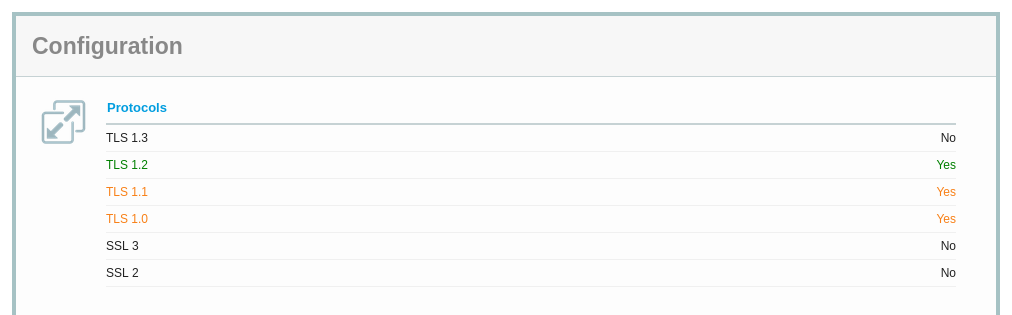

Aujourd'hui, un registre prévient de ses periodes

d'indisponibilité prévues par divers moyens : courriers aux BE, messages sur des

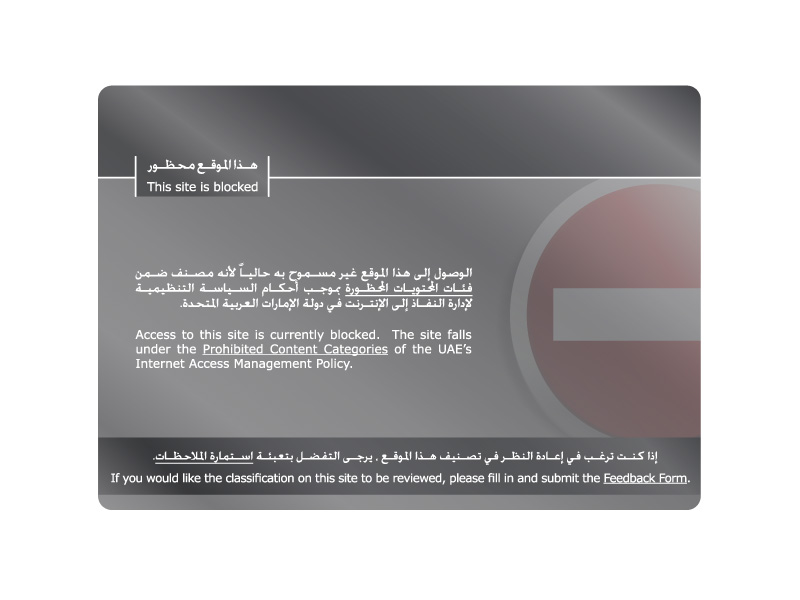

réseaux sociaux, page Web dédiée comme :

Chaque registre le fait de façon différente, il n'existe pas de règles communes, et le côté non-structuré de ces annonces fait qu'il faut une interventon humaine pour les analyser et les mettre dans un agenda. Et un BE peut devoir interagir avec de nombreux registres ! Notre RFC propose d'utiliser EPP (RFC 5730) pour ces annonces.

Donc, premier principe, puisqu'on va souvent manipuler des dates,

les dates et heures seront toutes représentées en UTC et dans le format

du RFC 3339. Ensuite, les annonces seront dans

un élément XML <item>, de

l'espace de noms

urn:ietf:params:xml:ns:epp:maintenance-1.0

(enregistré

à l'IANA). Parmi les sous-éléments de cet élément :

id, un identificateur de l'évènement,systems, qui permettra de désigner les systèmes affectés,environment, pour dire si l'évènement concerne la production ou bien un banc de test,startetend, qui indiquent le début et la fin (prévue…) de l'évènement,- et plusieurs autres éléments.

Un exemple d'évènement, une intervention sur le serveur EPP

epp.registry.example de production, peut être :

<maint:item>

<maint:id>2e6df9b0-4092-4491-bcc8-9fb2166dcee6</maint:id>

<maint:systems>

<maint:system>

<maint:name>EPP</maint:name>

<maint:host>epp.registry.example</maint:host>

<maint:impact>full</maint:impact>

</maint:system>

</maint:systems>

<maint:environment type="production"/>

<maint:start>2021-12-30T06:00:00Z</maint:start>

<maint:end>2021-12-30T07:00:00Z</maint:end>

<maint:reason>planned</maint:reason>

<maint:detail>

https://www.registry.example/notice?123

</maint:detail>

<maint:tlds>

<maint:tld>example</maint:tld>

<maint:tld>test</maint:tld>

</maint:tlds>

</maint:item>

On voit que le serveur EPP sera arrêté pendant une heure

(<impact>full</impact> indiquant

une indisponibilité totale) et que cela affectera les TLD

.example et .test. Une

telle information, étant sous une forme structurée, peut être

analysée par un programme et automatiquement insérée dans un agenda,

ou un système de supervision.

Les commandes EPP exactes, maintenant (section 4 du RFC). La

commande <info> peut renvoyer maintenant

un élément <maint:info> qui contient

l'information de maintenance. Voici l'exemple du RFC. D'abord, la

question du client, qui veut de l'information sur l'évènement

2e6df9b0-4092-4491-bcc8-9fb2166dcee6 :

<info>

<maint:info

xmlns:maint="urn:ietf:params:xml:ns:epp:maintenance-1.0">

<maint:id>2e6df9b0-4092-4491-bcc8-9fb2166dcee6</maint:id>

</maint:info>

</info>

Puis la réponse du serveur :

<response>

<result code="1000">

<msg>Command completed successfully</msg>

</result>

<resData>

<maint:infData

xmlns:maint="urn:ietf:params:xml:ns:epp:maintenance-1.0">

<maint:item>

<maint:id>2e6df9b0-4092-4491-bcc8-9fb2166dcee6

</maint:id>

<maint:type lang="en">Routine Maintenance</maint:type>

<maint:systems>

<maint:system>

<maint:name>EPP</maint:name>

<maint:host>epp.registry.example

</maint:host>

<maint:impact>full</maint:impact>

</maint:system>

</maint:systems>

<maint:environment type="production"/>

<maint:start>2021-12-30T06:00:00Z</maint:start>

<maint:end>2021-12-30T07:00:00Z</maint:end>

<maint:reason>planned</maint:reason>

<maint:detail>

https://www.registry.example/notice?123

</maint:detail>

<maint:description lang="en">free-text

</maint:description>

<maint:description lang="de">Freitext

</maint:description>

<maint:tlds>

<maint:tld>example</maint:tld>

<maint:tld>test</maint:tld>

</maint:tlds>

<maint:intervention>

<maint:connection>false</maint:connection>

<maint:implementation>false</maint:implementation>

</maint:intervention>

<maint:crDate>2021-11-08T22:10:00Z</maint:crDate>

</maint:item>

</maint:infData>

</resData>

...

Ici, le client connaissait l'identificateur d'une opération de maintenance particulière. S'il ne le connait pas et veut récupérer une liste d'événements :

<info>

<maint:info

xmlns:maint="urn:ietf:params:xml:ns:epp:maintenance-1.0">

<maint:list/>

</maint:info>

</info>

Il récupérera alors une <maint:list>, une

liste d'opérations de maintenance.

Le client EPP peut

également être prévenu des maintenances par la commande

<poll>, qui dote EPP d'un système de

messagerie (RFC 5730, section 2.9.2.3). Ainsi,

un message dans la boite aux lettres du client pourra être :

<response>

<result code="1301">

<msg>Command completed successfully; ack to dequeue</msg>

</result>

<msgQ count="1" id="12345">

<qDate>2021-11-08T22:10:00Z</qDate>

<msg lang="en">Registry Maintenance Notification</msg>

</msgQ>

<resData>

<maint:infData

xmlns:maint="urn:ietf:params:xml:ns:epp:maintenance-1.0">

<maint:item>

<maint:id>2e6df9b0-4092-4491-bcc8-9fb2166dcee6</maint:id>

<maint:pollType>create</maint:pollType>

<maint:systems>

<maint:system>

<maint:name>EPP</maint:name>

<maint:host>epp.registry.example

</maint:host>

<maint:impact>full</maint:impact>

...

La section 5 du RFC décrit la syntaxe formelle de cette extension (en XML Schema). Elle est dans le registre IANA des extensions à EPP.

Et question mises en œuvre ? Apparemment, les registres gérés par GoDaddy et Tango envoient déjà ces informations de maintenance.

L'article seul

Clé PGP inutilisable ?

Première rédaction de cet article le 25 décembre 2021

Décembre 2021, des correspondants m'informent que ma clé PGP n'est plus utilisable pour m'envoyer des messages chiffrés. Unusable public key ou autres messages peu parlants. Alors que ça marchait avant.

% gpg --encrypt --recipient CCC66677 toto.txt

gpg: CCC66677: skipped: Unusable public key

gpg: toto.txt: encryption failed: Unusable public key

C'était un simple oubli idiot de ma part : la clé a plusieurs sous-clés, ayant des rôles différents (chiffrement, signature…). Lors de la précédente expiration de la clé, j'avais bien re-signé mais en oubliant une des sous-clés, celle de chiffrement (une grosse bêtise). Au lieu d'un message clair du genre « cette clé a expiré » (ce qui se produit quand toutes les clés sont expirées), le logiciel, ne voyant que la clé de signature, n'arrivait pas à produire un message d'erreur intelligent. (Au passage, le format de clés PGP ou, plus exactement, OpenPGP, est normalisé dans le RFC 4880).

La clé et ses sous-clés, dont une (tout à la fin) était expirée :

sec rsa4096/555F5B15CCC66677

created: 2014-02-08 expires: 2023-12-21 usage: SC

trust: unknown validity: undefined

ssb rsa4096/3FA836C996A4A254

created: 2014-02-09 expires: 2023-12-21 usage: S

ssb* rsa4096/9045E02757F02AA1

created: 2014-02-09 expired: 2021-12-19 usage: E

(Usage: E = encryption - chiffrement, alors que Usage: S désigne la possibilité de signer.)

Une fois tout re-signé proprement :

sec rsa4096/555F5B15CCC66677

created: 2014-02-08 expires: 2023-12-25 usage: SC

trust: unknown validity: undefined

ssb* rsa4096/3FA836C996A4A254

created: 2014-02-09 expires: 2023-12-25 usage: S

ssb* rsa4096/9045E02757F02AA1

created: 2014-02-09 expires: 2023-12-25 usage: E

Vous pouvez récupérer ma clé publique sur les serveurs de clés PGP habituels, ou bien directement sur ce site Web. Les raisons pour lesquelles j'ai mis une date d'expiration à ma clé (ce n'est pas obligatoire et, vous avez vu, ça peut entrainer des problèmes), sont détaillées dans un autre article.

Merci à André Sintzoff pour le signalement et à Kim Minh Kaplan pour la solution.

L'article seul

RFC 9165: Additional Control Operators for Concise Data Definition Language (CDDL)

Date de publication du RFC : Décembre 2021

Auteur(s) du RFC : C. Bormann (Universität Bremen TZI)

Chemin des normes

Réalisé dans le cadre du groupe de travail IETF cbor

Première rédaction de cet article le 25 décembre 2021

Le langage CDDL (Concise Data Definition Language) est un langage de description de schémas de données, notamment pour le format CBOR. Ce nouveau RFC étend CDDL avec de nouveaux opérateurs, permettant entre autres l'addition d'entiers et la concaténation de chaines de caractères.

CDDL est normalisé dans le RFC 8610 (et le format CBOR dans le RFC 8949). Il permet l'ajout de nouveaux opérateurs pour étendre le langage, possibilité utilisée par notre nouveau RFC. Notez que, comme les modèles de données de JSON et CBOR sont très proches, les schémas CDDL peuvent également être utilisés pour JSON, ce que je fais ici pour les exemples car le JSON est plus facile à lire et à écrire.

D'abord, l'opérateur .plus. Il permet par

exemple, dans la spécification d'un schéma, de faire dépendre

certains nombres d'autres nombres. L'exemple ci-dessous

définit un type « intervalle » où la borne supérieure doit être

supérieure de 5 à la borne inférieure :

top = interval<3>

interval<BASE> = BASE .. (BASE .plus 5)

Avec un tel schéma, la valeur 4 sera acceptée mais 9 sera refusée :

% cddl tmp.cddl validate tmp.json CDDL validation failure (nil for 9): [9, [:range, 3..8, Integer], ""]

Deuxième opérateur, la

concaténation, avec le nouvel opérateur

.cat :

s = "foo" .cat "bar"

Dans cet exemple, évidemment, .cat n'est pas

très utile, on aurait pu écrire la chaine complète directement. Mais

.cat est plus pertinent quand on veut manipuler

des chaines contenants des sauts de ligne :

s = "foo" .cat ' bar baz '

Ce schéma acceptera la chaine de caractère "foo\n bar\n

baz\n".

Dans l'exemple ci-dessus, bar et

baz seront précédés des espaces qui

apparaissaient dans le code source. Souvent, on souhaite mettre ces

espaces en début de ligne dans le code source, pour

l'indenter joliment, mais les supprimer dans

le résultat final. Cela peut se faire avec l'opérateur pour lequel

notre RFC invente le joli mot de détentation

(dedending), .det, qui

fonctionne comme .cat mais « dédente » les

lignes :

s = "foo" .det ' bar baz '

Cette fois, le schéma n'acceptera que la chaine

"foo\nbar\nbaz\n".

Le RFC note que, comme .det est l'abréviation

de dedending cat, on aurait pu l'appeler

.dedcat mais cela aurait chagriné les amis des

chats.

CDDL est souvent utilisé dans les normes techniques de l'Internet

et celles-ci contiennent souvent des

grammaires en ABNF (RFC 5234). Pour permettre de réutiliser les règles ABNF dans

CDDL, et donc se dispenser d'une ennuyeuse traduction, un nouvel

opérateur fait son apparition, .abnf. Le RFC

donne l'exemple de la grammaire du RFC 3339,

qui normalise les formats de date : abnf-rfc3339.cddl. Avec ce fichier, on peut accepter des

chaines comme "2021-12-15" ou

"2021-12-15T15:52:00Z". Notons qu'il reste

quelques difficultés car les règles d'ABNF ne sont pas parfaitement

compatibles avec celles de CDDL. Si .abnf va

traiter l'ABNF comme de l'Unicode encodé en

UTF-8, un autre opérateur,

.abnfb, va le traiter comme une bête suite

d'octets. D'autre part, comme ABNF exige souvent des sauts de ligne,

les opérateurs .cat et

.det vont être très utiles.

Quatrième et dernier opérateur introduit par ce RFC,

.feature. À quoi sert-il ? Comme le langage

CDDL peut ếtre étendu au-delà de ce qui existait dans le RFC 8610, on court toujours le risque de traiter

un schéma CDDL avec une mise en œuvre de CDDL qui ne connait pas

toutes les fonctions utilisées dans le schéma. Cela produit en

général un message d'erreur peu clair et, surtout, cela mènerait à

considérer des données comme invalides alors qu'elles sont

parfaitement acceptables pour le reste du

schéma. .feature sert donc à marquer les

extensions qu'on utilise. Le programme qui met en œuvre CDDL pourra

ainsi afficher de l'information claire. Par exemple, si on définit

une personne :

person = {

? name: text

? organization: text

}

puis qu'on veut rajouter son groupe sanguin :

{"name": "Jean", "bloodgroup": "O+"}

Cet objet sera rejeté, en raison du champ

bloodgroup. On va faire un schéma plus ouvert, avec

.feature :

person = {

? name: text

? organization: text

* (text .feature "further-person-extension") => any

}

Et, cette fois, l'objet est accepté avec un message d'avertissement clair :

% cddl person-new-feature.cddl validate tmp.json ** Features potentially used (tmp.json): further-person-extension: ["bloodgroup"]

Comme le schéma est assez ouvert, la fonction de génération de fichiers d'exemple de l'outil donne des résultats amusants :

% cddl person-new-feature.cddl generate

{"name": "plain", "dependency's": "Kathryn's", "marvelous": "cleavers"}

Les nouveaux opérateurs ont été placés dans le registre

IANA. Ils sont mis en œuvre dans l'outil de référence de CDDL

(le cddl utilisé ici). Écrit en

Ruby, on peut l'installer avec la méthode Ruby

classique :

% gem install cddl

Il existe une autre mise en œuvre de CDDL (qui porte malheureusement le même nom). Elle est en Rust et peut donc s'installer avec :

% cargo install cddl

Elle n'inclut pas encore les opérateurs de ce RFC :

% /home/stephane/.cargo/bin/cddl validate --cddl plus.cddl plus.json Validation of "plus.json" failed error parsing CDDL: error: lexer error ┌─ input:8:12 │ 8 │ (BASE .plus 1) => int ; upper bound │ ^^^^^ invalid control operator

L'article seul

RFC 0810: DoD Internet host table specification

Date de publication du RFC : Mars 1982

Auteur(s) du RFC : Elizabeth Feinler, Ken Harrenstien, Zaw-Sing Su, Vic White (SRI International, Network Information Center)

Statut inconnu, probablement trop ancien

Première rédaction de cet article le 22 décembre 2021

Un peu d'histoire, avec ce RFC 810, qui mettait à jour le format du fichier géant qui, à l'époque, contenait la liste de toutes les machines de l'Internet. Il remplaçait le RFC 608.

Par rapport à son prédécesseur, ce RFC marquait le début de la fin de ce fichier

géant : ses limites étaient désormais bien comprises, et le

DNS était en cours

d'élaboration, quoique encore dans le futur. En attendant ce système

décentralisé et réparti, notre RFC mettait à jour la syntaxe du

fichier HOSTS.TXT, aussi appelé

« hosts » ou « host

table ». Il s'appliquait à

l'Internet mais aussi à son prédécesseur

Arpanet qui, à l'époque, vivait encore, une

vie séparée. Le fichier était ensuite distribué par un serveur

centralisé, décrit dans le RFC 811. Si vous

vouliez le fichier entier, notre RFC rappelait les instructions, à

l'époque où les URL n'existaient pas encore : « Connectez-vous

à 10.0.0.73 en FTP, en utilisant le compte

ANONYMOUS et le mot de passe

GUEST, puis utilisez la commande

get pour le fichier

<NETFINFO>HOSTS.TXT ». (On notera qu'à

l'époque, le FTP anonyme était réellement

anonyme, la convention d'utiliser son adresse comme mot de passe n'existait pas

encore.)

Bon, quelle était la syntaxe de ce fichier ? Les noms étaient

composés de lettres ASCII, de chiffres, de

traits d'union et de

points, en 24 caractères maximum. Ils étaient

insensibles à la casse. Il existait des

conventions de nommage : un routeur devait

avoir un nom se terminant en -GATEWAY ou

-GW. Un TAC devait se nommer

quelquechose-TAC. (Le RFC ne prend pas la peine

d'expliquer ce qu'est un TAC. Un TAC,

Terminal Access Controller était un ordinateur

spécialisé dans le service de terminaux, qui n'avait pas de compte

local et ne servait qu'à se connecter à des ordinateurs

distants.)

Le RFC décrit ensuite le format des adresses. Loin des débuts de l'Arpanet, elles étaient déjà sur 32 bits à l'époque (cela avait été normalisé par le RFC 796 en 1981). La longueur du préfixe dépendait de la valeur des premiers bits de l'adresse (le système des classes, qui a été abandonné en 1993).

Le fichier contenait aussi les noms des réseaux. Pour les machines, le fichier ne contenait pas que noms et adresses. À cette époque sans Web et sans moteur de recherche, il servait aussi à publier les services disponibles sur chaque machine. Et il indiquait aussi le système d'exploitation des machines, information utile quand on voulait se connecter avec telnet. (D'autres protocoles nécessitaient de connaitre ce système d'exploitation. L'utilisation de FTP en dépendait, sans compter les problèmes d'encodage des caractères, dans un monde sans Unicode.) Voici quelques exemples de machines, datant de 1983 :

HOST : 10.0.0.4, 192.5.12.21 : UTAH-CS : VAX-11/750 : UNIX : TCP/TELNET,TCP/FTP,TCP/SMTP : HOST : 10.0.0.6 : MIT-MULTICS,MULTICS : HONEYWELL-DPS-8/70M : MULTICS : TCP/TELNET,TCP/SMTP,TCP/FTP,TCP/FINGER,TCP/ECHO,TCP/DISCARD,ICMP : HOST : 10.0.0.9 : HARV-10,ACL : DEC-10 : TOPS10 :: HOST : 32.2.0.42 : UCL-TAC,LONDON-TAC : H-316 : TAC : TCP : HOST : 26.4.0.73 : SRI-F4 : FOONLY-F4 : TENEX :: HOST : 10.0.0.51, 26.0.0.73 : SRI-NIC,NIC : DEC-2060 : TOPS20 : TCP/TELNET,TCP/SMTP,TCP/TIME,TCP/FTP,TCP/ECHO,ICMP :

Vous noterez que l'université d'Utah

utilise toujours, en 2021, le même préfixe

192.5.12.0/24… Par contre, le

MIT n'a plus de service ECHO… (Ce service

était normalisé dans le RFC 862.) La machine de

l'UCL était une des rares étrangères aux

USA. Le Foonly qu'on voit au

SRI était une machine connue pour avoir fait

les CGI des films Tron

et, come le note John Shaft, Looker :

« première fois qu'il était possible de voir de la

3D avec ombrage dans un film, de mémoire. Un

corps humain de surcroît. ». Quant à la machine

SRI-NIC, c'est elle qui distribuait ce fichier

(son adresse avait changé depuis la publication du RFC).

L'internet était encore assez centralisé à l'époque, et il était possible de décider d'un « jour J », où on fait changer tout le monde en même temps : ce RFC fixait la date au 1er mai 1982, où tout le monde devait utiliser le nouveau format, l'ancien, celui du RFC 608, étant abandonné.

Une copie du fichier de 1983 est en ligne (merci à Patrick Mevzek pour l'avoir trouvée) et j'en ai fait une copie locale.

L'article seul

RFC 9155: Deprecating MD5 and SHA-1 signature hashes in (D)TLS 1.2

Date de publication du RFC : Décembre 2021

Auteur(s) du RFC : L.V. Velvindron (cyberstorm.mu), K.M. Moriarty (CIS), A.G. Ghedini (Cloudflare)

Chemin des normes

Réalisé dans le cadre du groupe de travail IETF tls

Première rédaction de cet article le 20 décembre 2021

Vous le savez certainement déjà, car toutes les lectrices et tous les lecteurs de ce blog sont très attentif·ves et informé·es, mais les algorithmes de condensation MD5 et SHA-1 ont des failles connues et ne doivent pas être utilisés dans le cadre de signatures. Vous le savez, mais tout le monde ne le sait pas, ou bien certain·es ont besoin d'un document « officiel » pour agir donc, le voici : notre RFC dit qu'on ne doit plus utiliser MD5 et SHA-1 dans TLS.

Si vous voulez savoir pourquoi ces algorithmes sont mauvais, le RFC 6151 vous renseignera (et la section 1 de notre RFC 9155 vous donnera une bibliographie récente).

La section 2 à 5 sont le cœur du RFC et elle est sont très simples : pas de MD5, ni de SHA-1 pour les signatures. Dans le registre IANA, ces algorithmes sont désormais marqués comme déconseillés.

Les fanas de cryptographie noteront qu'on peut toujours utiliser SHA-1 pour HMAC (où ses faiblesses connues n'ont pas de conséquences).

L'article seul

Log4Shell, et le financement du logiciel libre

Première rédaction de cet article le 14 décembre 2021

Vous avez sans doute suivi l'affaire de la faille de sécurité Log4Shell. Elle a souvent été utilisée comme point de départ pour des discussions à propos du financement du logiciel libre, en mode « de nombreuses grosses entreprises utilisent tel logiciel libre et en dépendent mais ne contribuent pas à son financement ». Ce point de vue mérite d'être nuancé.

La faille concerne le logiciel Log4j, très utilisé (ce qui explique en partie l'intérêt porté à la faille Log4Shell). Comme beaucoup de logiciels libres très utilisés, il ne bénéficie pas d'une équipe de développeurs payés à temps plein pour le maintenir. Je cite tout de suite le dessin de XKCD que tout le monde mentionne tout le temps. Face à cela, on lit souvent des affirmations comme quoi les grosses entreprises (par exemple les GAFA) devraient financer ces logiciels cruciaux. Je pense que c'est plus compliqué que cela, et je voudrais présenter ici deux faits et une opinion.

Premier fait, un ou une développeureuse de logiciel libre n'est pas forcément bénévole. Le logiciel libre n'est pas synonyme de gratuité et, de toute façon, la gratuité du logiciel ne veut pas dire que les développeureuses n'ont pas été payé·es. Il y a beaucoup de logiciels libres cruciaux qui sont maintenus par des salarié·es. (Dans le domaine du DNS, c'est le cas de tous les serveurs libres, comme BIND ou NSD, maintenus par les employé·es de l'ISC, de NLnet Labs, de PowerDNS, etc.) D'affirmer comme je l'ai lu souvent qu'il faut s'inquiéter des logiciels libres car leurs développereuses sont bénévoles est donc absurde. La question du financement du logiciel libre est une question très intéressante (il est parfaitement normal que les programmeureuses soient payé·es pour leur travail) mais elle a de nombreuses réponses.

Deuxième fait, si le logiciel est libre, par définition, personne n'est obligé de payer pour l'utiliser. Du point de vue moral, on peut trouver que ce n'est pas beau qu'Amazon ou Google ne dépensent pas un centime pour des logiciels qu'ils utilisent mais c'est le principe du logiciel libre. Un·e auteur·e de logiciel peut toujours mettre son logiciel sous une licence non-libre, imposant par exemple un paiement pour un usage commercial (ce qui est en général une mauvaise idée) mais ce n'est plus du logiciel libre.

Enfin, mon opinion. À défaut d'imposer un paiement, ce qui n'est pas possible pour un logiciel libre, ne faudrait-il pas au moins exercer une pression morale pour que les entreprises qui gagnent de l'argent avec une infrastructure composée en (bonne) partie de logiciel libre mettent la main sur l'interface Web de leur banque et envoient de l'argent ?

Ce point soulève de nombreuses questions. D'abord, si la programmeuse ou le programmeur a choisi le logiciel libre (et donc de ne pas forcément toucher de l'argent des utilisateurs), c'est qu'il y a une raison. Souvent, c'était pour être elle-même ou lui-même plus libre, pour ne pas dépendre de product owners, de commerciaux ou de décideurs qui lui diraient qu'ils veulent telle ou telle jolie fonction dans l'interface. Si le financement des logiciels libres est assuré par des grosses entreprises, elles exigeront sans doute du reporting, des process formalisés, elles demanderont un pouvoir de décision, et tou·tes les auteur·es de logiciel libre n'ont pas envie de travailler dans un tel cadre. Même si Amazon voulait payer, tout le monde ne le voudrait pas. (En outre, se faire payer pour développer du logiciel libre est parfois compliqué, du point de vue administratif, même si quelqu'un veut le faire.)

C'est d'autant plus vrai que ces grosses entreprises ont souvent un rôle très néfaste dans l'Internet. Je me souviens d'une discussion il y a quelques années avec la responsable d'un gros projet libre, financé en grande partie par des contrats avec des entreprises de l'Internet qui payaient pour que telle ou telle fonction soit développée. Je lui suggérai des améliorations pour préserver la vie privée des utilisateurices. Elle m'avait répondu « Stéphane, tu nous demandes toujours des trucs pour mieux protéger la vie privée, mais les clients qui paient nous paient pour, au contraire, trouver des moyens de récolter davantage de données. »

Bien sûr, une solution possible serait d'isoler les programmeuses ou programmeurs des financeurs via, par exemple, une fondation qui recevrait l'argent et le distribuerait (un certain nombre de gros logiciels libres fonctionnent ainsi, et c'est d'ailleurs le cas de Log4j). Mais cela ne convient pas non plus à tout le monde. (Ces fondations ne sont pas forcément innocentes.)

Et la sécurité n'y gagnerait pas forcément. Dans le cas de Log4Shell, les auteurs ont commis une bogue, c'est sûr. Mais tous les logiciels peuvent avoir des bogues, que leurs auteurs soient payés ou pas. Et, une fois la bogue signalée, tout semble indiquer que les auteurs de Log4j ont réagi vite et bien. Tout n'est pas une question de financement, et, en matière de sécurité, la conscience professionnelle et la réactivité comptent davantage. Rajouter des règles, des procédures et de la bureaucratie, sous couvert d'avoir des dévelopements logiciels « plus sérieux » ne serait pas un progrès en sécurité, probablement plutôt le contraire. (Sans compter que les grosses entreprises sont les premières à réclamer davantage de fonctions, donc davantage de failles de sécurité, et à prioriser l'apparence sur la qualité.)

[Ne me faites pas dire ce que je n'ai pas dit ; je n'ai pas proposé que les développeur·ses de logiciels soient forcément pauvres et grelottant de froid dans une mansarde non chauffée. Qu'ielles soient payé·es est normal. Mais, vu l'actuel marché de l'emploi dans la programmation, celles et ceux qui ne s'intéressent qu'à l'argent n'ont en général pas de problème. La question du financement et de la maintenance des logiciels essentiels est importante, mais elle ne se résoudra pas en demandant simplement aux GAFA de mettre la main à la poche.]

Quelques lectures sur ce sujet délicat :

- Un appel à financer les développeurs dont on utilise le travail (appel qui n'est pas destiné qu'aux « grosses entreprises »).

- Un rappel de la situation dans Next Inpact.

- Un avis d'un employé de Google, qui pointe entre autres les contraintes liées aux grandes entreprises, et qui illustre parfaitement les dangers dont je parle plus haut (en disant explicitement que de payer les développeureuses permettra de leur donner des ordres).

- Un article de Numérama décrit bien l'opinion dominante (« il faut faire payer les grosses entreprises »).

- Au contraire, cet article pointe les dangers du financement par les grosses entreprises.

- Un excellent article de Daniel Stenberg sur le sujet, pointant entre autres les difficultés paperassières à toucher de l'argent, même quand une entreprise ou l'État veut vous en donner, et également le fait que ce n'est pas un hasard si les logiciels touchés sont souvent des logiciels d'infrastructure, sans jolie interface que les décideurs peuvent admirer.

- Un développeur qui pointe la paperasserie nécessaire pour se faire payer.

- Dans le débat, des gens disent souvent open source au lieu de logiciel libre, par snobisme, parce que c'est mieux en anglais (ou bien parce qu'ils ne comprennent pas le sujet). C'est pareil.

L'article seul

RFC 9164: Concise Binary Object Representation (CBOR) Tags for IPv4 and IPv6 Addresses

Date de publication du RFC : Décembre 2021

Auteur(s) du RFC : M. Richardson (Sandelman Software Works), C. Bormann (Universität Bremen TZI)

Chemin des normes

Réalisé dans le cadre du groupe de travail IETF cbor

Première rédaction de cet article le 14 décembre 2021

Ce nouveau RFC normalise deux étiquettes CBOR pour représenter des adresses IP et des préfixes d'adresses.

Le format de données CBOR, normalisé dans le RFC 8949, a une liste de types prédéfinis mais on peut en créer d'autres, en étiquetant la donnée avec un entier qui permettre de savoir comment interpréter la donnée en question. Notre RFC introduit les étiquettes 52 (pour les adresses IPv4) et 54 (pour les adresses IPv6). Ah, pourquoi 52 et 54 ? Je vous laisse chercher, la solution est à la fin de l'article

La section 3 de notre RFC décrit le format. Pour chaque famille (IPv4 ou IPv6), il y a trois formats (tous avec la même étiquette) :

- Les adresses à proprement parler, représentées sous forme d'une byte string CBOR (suite d'octets, cf. RFC 8949, section 3.1, type majeur 2) et donc pas sous la forme textuelle (celle avec les points pour IPv4 et les deux-points pour IPv6),

- Les préfixes, représentés par un tableau de deux éléments, un entier pour la longueur du préfixe et une suite d'octets pour le préfixe lui-même (les octets nuls à la fin doivent être omis),

- L'interface, sous forme d'un tableau de deux ou trois

éléments, qui comporte une adresse IP, la longueur du préfixe sur

cette interface et éventuellement un identificateur d'interface

(genre

eth0sur Linux, voir la section 6 du RFC 4007 pour IPv6, et les RFC 4001 et RFC 6991 pour IPv4, mais cela peut aussi être un entier), identificateur qui est local à la machine.

La section 5 du RFC contient une description en CDDL (RFC 8610) de ces données.

J'ai écrit une mise en œuvre en Python de ce RFC, qui renvoie à un client

HTTP son

adresse IP, et le préfixe annoncé dans la DFZ en BGP (en utilisant pour cela les

données du RIS,

via le programme WhichASN). Le

service est accessible à l'adresse

https://www.bortzmeyer.org/apps/addresses-in-cbor,

par exemple :

% curl -s https://www.bortzmeyer.org/apps/addresses-in-cbor > tmp.cbor

Le CBOR est du binaire, on peut regarde avec le programme read-cbor :

% read-cbor tmp.cbor Array of 3 items String of length 165: Your IP address in CBOR [...] Tag 54 Byte string of length 16 Tag 54 Array of 2 items Unsigned integer 32 Byte string of length 4

On voit que le service renvoie un tableau CBOR de trois entrées :

- Une chaine de caractères de documentation,

- l'adresse IP (ici, de l'IPv6, d'où l'étiquette 54 et les 16 octets),

- le préfixe routé, sous la forme d'une longueur (ici, 32 bits) et des octets non nuls dudit préfixe (ici, au nombre de 4).

Vu avec le programme cbor2diag, le même fichier :

% cbor2diag.rb tmp.cbor

["Your IP address in CBOR, done with Python 3.9.2 [...]",

54(h'200141D0030222000000000000000180'),

54([32, h'200141D0'])]

(Le préfixe du client HTTP était en effet bien

2001:41d0::/32.) Le code source de service est

dans les sources du moteur de ce

blog, plus précisement en

wsgis/dispatcher.py.

Sinon, la raison du choix des étiquettes est que, en ASCII, 52 est le chiffre 4 et 54 est 6. Les deux étiquettes sont désormais dans le registre IANA. À noter que la représentation des adresses IP en CBOR avait été faite initialement avec les étiquettes 260 et 261, en utilisant un encodage complètement différent. 260 désignait les adresses (v4 et v6), 261, les préfixes. (Ces deux étiquettes sont marquées comme abandonnées, dans le registre IANA.) Au contraire, dans notre nouveau RFC, l'étiquette identifie la version d'IP, la distinction entre adresse et préfixe se faisant par un éventuel entier initial pour indiquer la longueur.

L'article seul

RFC 9162: Certificate Transparency Version 2.0

Date de publication du RFC : Décembre 2021

Auteur(s) du RFC : B. Laurie, A. Langley, E. Kasper, E. Messeri (Google), R. Stradling (Sectigo)

Expérimental

Réalisé dans le cadre du groupe de travail IETF trans

Première rédaction de cet article le 10 décembre 2021

Le système de gestion de certificats PKIX (dérivé des certificats X.509) a une énorme faiblesse. N'importe quelle AC peut émettre un certificat pour n'importe quel nom de domaine. Il ne suffit donc pas de bien choisir son AC, votre sécurité dépend de toutes les AC. Ce RFC propose une approche pour combler cette faille de sécurité : encourager/obliger les AC à publier « au grand jour » les certificats qu'elles émettent. Un titulaire d'un certificat qui craint qu'une AC n'émette un certificat à son nom sans son autorisation n'a alors qu'à surveiller ces publications. (Il peut aussi découvrir à cette occasion que sa propre AC s'est fait pirater ou bien est devenue méchante et émet des certificats qu'on ne lui a pas demandés. L'idée est aussi d'empêcher l'émission « discrète » de vrais/faux certificats qui seraient ensuite utilisés uniquement à certains endroits.) Ce système, dit « Certificate Transparency » (CT) avait initialement été normalisé dans le RFC 6962, que notre RFC remplace, le protocole passant à une nouvelle version, la v2 (toujours considérée comme expérimentale).

Le principe est donc de créer des journaux des certificats émis. Le journal doit être public, pour que n'importe qui puisse l'auditer (section 4 du RFC). Il doit être en mode « ajout seulement » pour éviter qu'on puisse réécrire l'histoire. Les certificats sont déjà signés mais le journal a ses propres signatures, pour prouver son intégrité. Conceptuellement, ce journal est une liste de certificats dans l'ordre de leur création. Toute AC peut y ajouter des certificats (la liste ne peut pas être ouverte en écriture à tous, de crainte qu'elle ne soit remplie rapidement de certificats bidons). En pratique, le RFC estime que la liste des AC autorisées à écrire dans le journal sera l'union des listes des AC acceptées dans les principaux navigateurs Web (voir aussi les sections 4.2 et 5.7, chaque journal est responsable de ce qu'il accepte ou pas comme soumissions).

À chaque insertion, le journal renvoie à l'AC une estampille

temporelle signéee (SCT, pour Signed Certificate

Timestamp), permettant à l'AC de prouver qu'elle a bien

enregistré le certificat. Si on a cette signature mais que le

certificat est absent du journal, l'observateur aura la preuve que

le journal ne marche pas correctement. Le format exact de cette

estampille temporelle est décrit en section 4.8. Idéalement, elle

devra être envoyée au client par les serveurs TLS, dans l'extension

TLS transparency_info (désormais enregistrée

à l'IANA), comme preuve de la bonne foi de l'AC (cf. section

6 et notamment 6.5, car c'est plus compliqué que cela). Bien sûr,

cette validation de l'insertion dans un journal ne dispense pas de

la validation normale du certificat (un certificat peut être

journalisé et mensonger à la fois). Notez aussi que, si le serveur

TLS n'envoie pas toutes les données au client, celui-ci peut les

demander au journal (opérations /get-proof-by-hash et

get-all-by-hash) mais, ce faisant, il informe

le journal des certificats qui l'intéressent et donc, par exemple,

des sites Web qu'il visite.

De même, une extension à OCSP (RFC 6960) peut être utilisée pour appuyer les réponses OCSP. On peut même inclure les preuves d'inclusion dans le journal dans le certificat lui-même, ce qui permet d'utiliser des serveurs TLS non modifiés.

Les titulaires de certificats importants, comme Google, mais aussi des chercheurs, des agences de sécurité, etc, pourront alors suivre l'activité de ces journaux publics (section 8.2 du RFC). Ce qu'ils feront en cas de détection d'un certificat anormal (portant sur leur nom de domaine, mais qu'ils n'ont pas demandé) n'est pas spécifié dans le RFC : cela dépend de la politique de l'organisation concernée. Ce RFC fournit un mécanisme, son usage n'est pas de son ressort. Ce journal n'empêchera donc pas l'émission de vrais/faux certificats, ni leur usage, mais il les rendra visibles plus facilement et sans doute plus vite.

Notons que les certificats client, eux, ne sont typiquement pas journalisés (rappelez-vous que les journaux sont publics et que les certificats client peuvent contenir des données personnelles). Le serveur TLS ne peut donc pas utiliser Certificate Transparency pour vérifier le certificat du client. (Le RFC estime que le principal risque, de toute façon, est celui d'usurpation du serveur, pas du client.)

Pour que cela fonctionne, il faudra que les clients TLS vérifient que le certificat présenté est bien dans le journal (autrement, le méchant n'aurait qu'à ne pas enregistrer son vrai/faux certificat, cf. section 8.3 du RFC).

En pratique, la réalisation de ce journal utilise un arbre de Merkle, une structure de données qui permet de mettre en œuvre un système où l'ajout de certificats est possible, mais pas leur retrait, puisque chaque nœud est un condensat de ses enfants (voir aussi le RFC 8391). La section 2 du RFC détaille l'utilisation de ces arbres et la cryptographie utilisée. (Et les exemples en section 2.1.5 aident bien à comprendre comment ces arbres de Merkle sont utilisés.)

Le protocole utilisé entre les AC et le journal, comme celui

utilisé entre les clients TLS et le journal, est HTTP et le format des

données du JSON (section 5, qui décrit l'API). Ainsi, pour

ajouter un certificat nouvellement émis au journal géré sur

sunlight-log.example.net, l'AC fera :

POST https://sunlight-log.example.net/ct/v2/submit-entry

et le corps de la requête HTTP sera un tableau JSON de certificats encodés en Base64. La réponse contiendra notamment l'estampille temporelle (SCT pour Signed Certificate Timestamp). S'il y a un problème, le client recevra une des erreurs enregistrées. Pour récupérer des certificats, le programme de surveillance fera par exemple :

GET https://sunlight-log.example.net/ct/v2/get-entries

D'autres URL permettront de récupérer les condensats cryptographiques contenus dans l'arbre de Merkle, pour s'assurer qu'il est cohérent.

Comme il n'existe (en octobre 2021) aucune mise en œuvre de la

version 2 du protocole, voici quelques exemples, utilisant des

journaux réels, et la version 1 du protocole (notez le

v1 dans l'URL). Pour trouver les coordonnées

des journaux, j'ai utilisé la liste

« officielle » du projet. Notez que tous les journaux qui y figurent ne fonctionnent pas

correctement. Notez aussi que, comme pour les AC ou les serveurs de clés PGP, il n'y a

pas de « journal de référence », c'est à chacun de choisir les

journaux où il va écrire, et qu'il va lire. Le script test-ct-logs-v1.py teste la liste, et trouve :

50 logs are OK, 54 are currently broken

Si vous vous demandez pourquoi un même opérateur a plusieurs

journaux, c'est en partie parce qu'il n'est pas possible de faire

évoluer les algorithmes cryptographiques au sein d'un même journal

(cf. section 9 du RFC) et qu'il faut donc de temps en temps créer un

nouveau journal. Un journal est identifié par son URL, sa clé publique et

(en v2) par son OID. Par exemple, le journal

« Nimbus 2021 » de Cloudflare est en

https://ct.cloudflare.com/logs/nimbus2021/ et a

la clé

MFkwEwYHKoZIzj0CAQYIKoZIzj0DAQcDQgAExpon7ipsqehIeU1bmpog9TFo4Pk8+9oN8OYHl1Q2JGVXnkVFnuuvPgSo2Ep+6vLffNLcmEbxOucz03sFiematg==

(je ne donne pas l'OID, il n'existe pas encore de journaux qui

utilisent la version 2 du protocole). Voici un exemple d'utilisation

(le STH est le Signed Tree Head, la valeur de la

racine de l'arbre de Merkle, cf. section 4.2.10) :

% curl -s https://ct.cloudflare.com/logs/nimbus2021/ct/v1/get-sth | jq .

{

"tree_size": 408013312,

"timestamp": 1634739692384,

"sha256_root_hash": "7GnGjI7L6O5fn8kQKTdJG2riShNTTbcjRP2WbLoZrvQ=",

"tree_head_signature": "BAMARjBEAiAQ0gb6udc9e28ykUGUzl0HV8U5NlJhPVSTUF4JtXGSeQIgcSbZ9kRgttGzpFETFem4eCv7GgUYPUUnl7lTGGFZSHM="

}

Plus de quatre cents millions de certificats, fichtre. Si on veut récupérer les deux premiers certificats journalisés :

% curl -s https://ct.cloudflare.com/logs/nimbus2021/ct/v1/get-entries\?start=0\&end=1 | jq .

{

"entries": [

{

"leaf_input":

[L'exemple est fait avec un journal v1, l'objet JSON renvoyé est

différent en v2.]

Mais vous pouvez aussi utiliser Certificate

Transparency (CT) sans aller regarder du JSON. Un service en

ligne comme https://crt.sh

On a vu que plusieurs acteurs intervenaient, le gérant du

journal, les AC, les gens qui regardent le journal, par exemple pour

l'auditer, etc. Une utilisation courante de CT est pour surveiller

l'émission de certificats au nom de son entreprise ou de son

organisation, pour repérer les AC qui créent des certificats

incorrects. Pour éviter de programmer tout cela de zéro en partant

du RFC, on peut utiliser le service Certstream, qui sert

d'intermédiaire avec plusieurs journaux, et sa bibliothèque

Python. Ainsi, le petit script test-certstream.py permet de détecter tous les certificats

émis pour les noms de domaine en

.fr :

% pip3 install certstream % ./test-certstream.py ... [2021-10-23T13:21:46] pimpmydrone.fr (SAN: www.pimpmydrone.fr) [2021-10-23T13:21:51] pascal-goldbach.fr (SAN: www.pascal-goldbach.fr) [2021-10-23T13:21:52] leginkobiloba.fr (SAN: www.leginkobiloba.fr) [2021-10-23T13:21:52] promabat-distribution.fr (SAN: www.promabat-distribution.fr) [2021-10-23T13:21:53] maevakaliciak.fr (SAN: mail.maevakaliciak.fr, www.maevakaliciak.fr) [2021-10-23T13:21:55] pascal-goldbach.fr (SAN: www.pascal-goldbach.fr) [2021-10-23T13:21:56] maevakaliciak.fr (SAN: mail.maevakaliciak.fr, www.maevakaliciak.fr) [2021-10-23T13:21:57] blog.nicolas-buffart.itval.fr (SAN: euromillions-generator.itval.fr, itval.fr, loto-generator.itval.fr, password-generator.itval.fr, www.blog.nicolas-buffart.itval.fr, www.euromillions-generator.itval.fr, www.itval.fr, www.loto-generator.itval.fr, www.password-generator.itval.fr) ...

Bien sûr, cela fait beaucoup (regardez les intervalles entre deux messages). En pratique, on modifierait sans doute ce script pour ne regarder que les noms de son organisation. Ainsi, vous pouvez détecter les certificats et chercher ensuite s'ils sont légitimes (ce qui, dans certaines organisations très cloisonnées n'ira pas de soi…).

À part Certstream, Samuel Bizien Filippi me suggère CertSpotter mais qui me semble uniquement payant. Il a une API. Elle peut être utilisée par le programme check_ct_logs, qui peut être utilisé comme script de test pour les programmes de supervision comme Icinga.

Le projet « Certificate Transparency » (largement impulsé par Google) a un site officiel (lecture recommandée) et, une liste de diffusion (sans compter le groupe de travail IETF TRANS, mais qui se limitait à la normalisation, il ne parle pas des aspects opérationnels, et il a de toute façon été clos en août 2021). Questions logiciels, si vous voulez créer votre propre journal, il y a le programme de Google.

Aujourd'hui, on peut dire que « Certificate Transparency » est un grand succès. La plupart (voire toutes ?) des AC y participent, il existe de nombreux journaux publics, et ils sont fréquemment utilisés pour l'investigation numérique (voire pour le renseignement, puisqu'on peut savoir, via les journaux, les noms de domaine pas encore annoncés, ce qui a parfois été cité comme une objection contre CT). Un bon exemple est celui de l'attaque « moyen-orientale » de 2018 (mais il y a aussi l'affaire du certificat révoqué de la Poste). Par contre, un client TLS ne peut pas encore être certain que tous les certificats seront dans ces journaux, et ne peut donc pas encore refuser les serveurs qui ne signalent pas la journalisation du certificat. Et le navigateur Firefox ne teste pas encore la présence des certificats dans le sjournaux.

Un point amusant : le concept de « Certificate Transparency » montre qu'il est parfaitement possible d'avoir un livre des opérations publiquement vérifiable sans chaine de blocs. La chaine de blocs reste nécessaire quand on veut autoriser l'écriture (et pas juste la lecture) au public.

La section 1.3 du RFC résume les principaux changements entre les versions 1 (RFC 6962) et 2 du protocole :

- Les algorithmes cryptographiques utilisés sont désormais dans des registres IANA,

- certains échanges utilisent désormais le format CMS (RFC 5652),

- les journaux qui étaient auparavant idenfiés par un condensat de leur clé publique le sont désormais par un OID, enregistrés à l'IANA (aucun n'est encore attribué),

- nouvelle fonction

get-all-by-hashdans l'API, - remplacement de l'ancienne extension TLS

signed_certificate_timestamp(valeur 18) partransparency_info(valeur 52, et voir aussi le nouvel en-tête HTTPExpect-CT:du RFC 9163, - et d'autres changements, dans les structures de données utilisées.

CT ne change pas de statut avec la version 2 : il est toujours classé par l'IETF comme « Expérimental » (bien que largement déployé). La sortie de cette v2 n'est pas allée sans mal (le premier document étant sorti en février 2014), avec par exemple aucune activité du groupe pendant la deuxième moitié de 2020.

Une des plus chaudes discussions pour cette v2 avait été la

proposition de changer l'API pour que les requêtes, au lieu d'aller

à <BASE-URL>/ct/v2/ partent du chemin

/.well-known/ du RFC 8615. Cette idée a finalement été rejetée, malgré le RFC 8820, qui s'oppose à cette idée de chemins

d'URL en dur.

L'article seul

Saisie de noms de domaine par Microsoft

Première rédaction de cet article le 9 décembre 2021

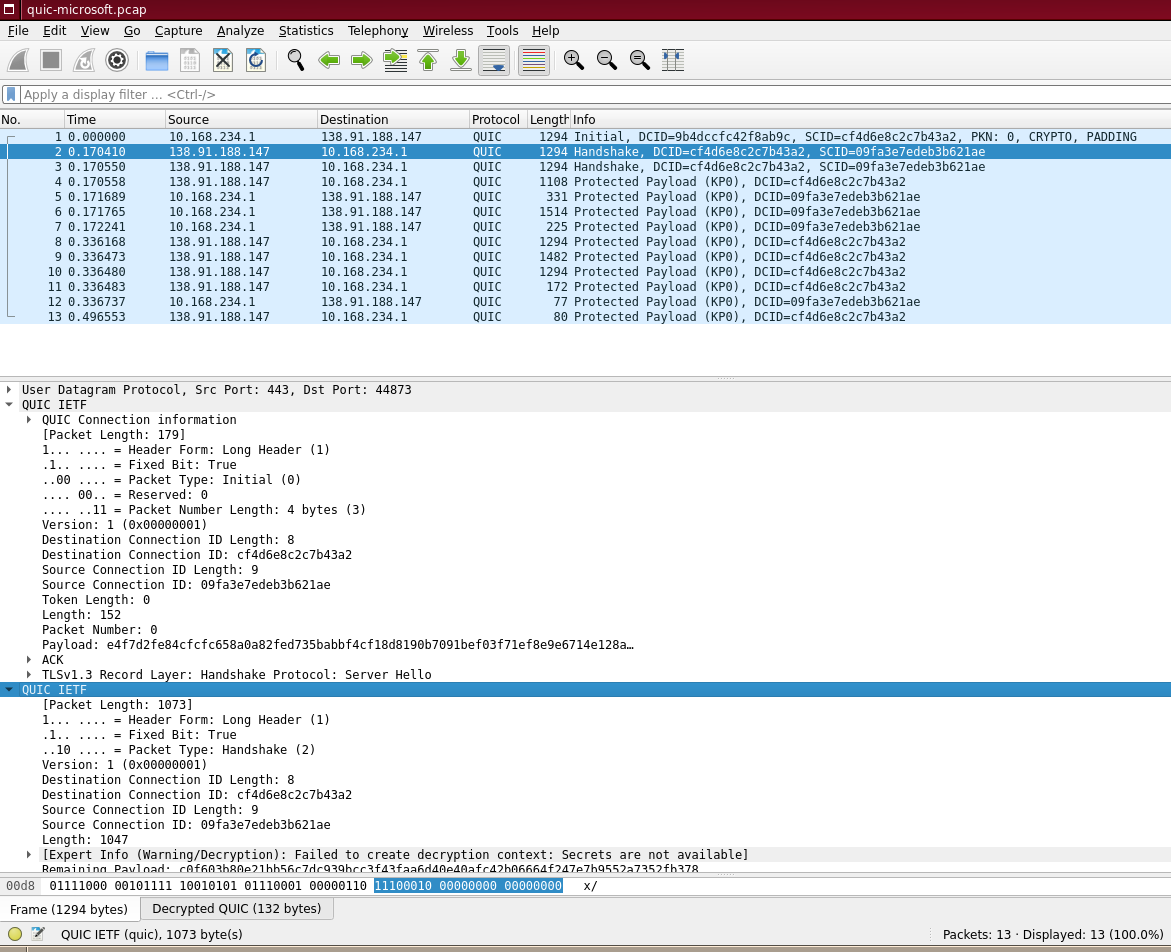

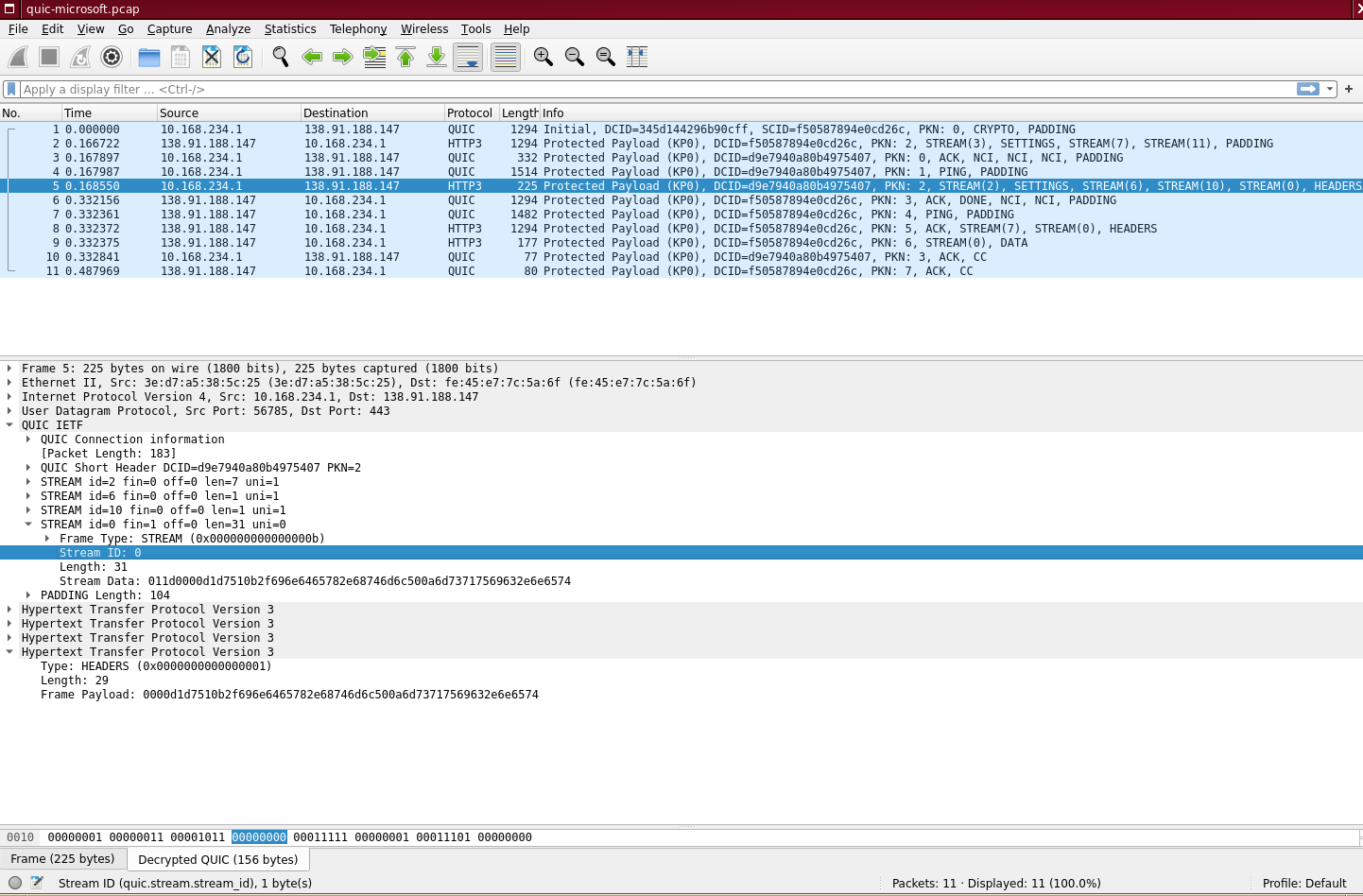

Il y a quelques jours, la justice étatsunienne a saisi, sur demande de Microsoft, un certain nombre de domaines, et les a transférés à cette société. Quelques informations techniques concrètes suivent pour celles et ceux qui seraient intéressé·es.

D'abord, le jugement du 2 décembre (trouvé par Rayna

Stamboliyska, merci beaucoup) : une

copie en ligne. En gros, Microsoft a

identifié des noms de

domaine utilisés par un groupe de délinquants nommé

Nickel (apparemment entre autres pour contrôler des botnets composés de machines

Microsoft Windows). La société a donc demandé à la justice de saisir ces

noms. Cela marche car ces domaines étaient dans les TLD

.com et

.org, TLD gérés par des

registres étatsuniens (alors que beaucoup de

gens croient qu'ils ont un statut « international »). La justice a

donné raison à Microsoft et ordonné le transfert des

noms. Techniquement, c'est l'équivalent d'un détournement de nom de

domaine ; Microsoft, ayant désormais le contrôle du nom, peut

changer les informations associées et, par exemple, envoyer le

trafic vers un serveur qu'ils contrôlent. La liste de ces noms

figure dans l'annexe A du jugement.

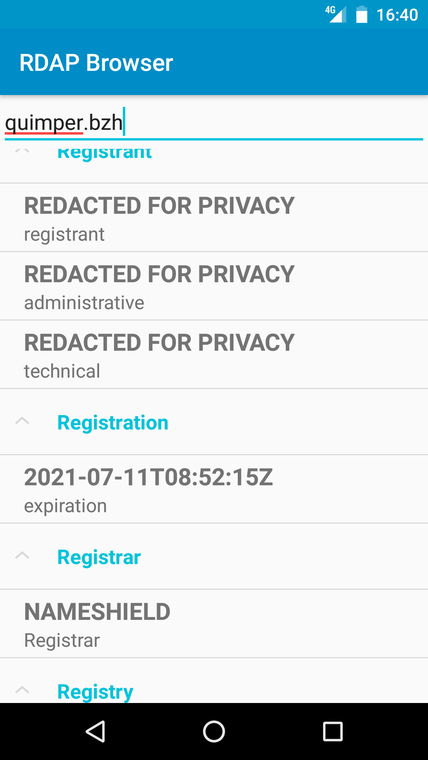

Prenons un de ces noms au hasard,

optonlinepress.com. Une requête

whois nous montre le nouveau titulaire (on

admire la célérité de l'opération, effectuée le lendemain du

jugement) :

% whois optonlinepress.com ... Updated Date: 2021-12-03T21:42:26Z ... Registrant Name: Digital Crimes Unit Digital Crimes Unit Registrant Organization: Microsoft Corporation Registrant Street: One Microsoft Way, Registrant City: Redmond Registrant State/Province: WA Registrant Postal Code: 98052 Registrant Country: US ...

(Attention, .com est un registre mince, et les

informations au registre peuvent être

différentes de celles au BE, notamment si l'injonction

judiciaire a visé le registre sans prévenir le BE. Mais, ici, tout

est cohérent.)

Le domaine est désormais délégué aux serveurs DNS faisant autorité de Microsoft (ici, avec l'outil check-soa) :

% check-soa optonlinepress.com NS104A.microsoftinternetsafety.net. 13.107.222.41: OK: 1 NS104B.microsoftinternetsafety.net. 13.107.206.41: OK: 1 ns001.microsoftinternetsafety.net. 13.107.222.41: OK: 1 ns002.microsoftinternetsafety.net. 13.107.206.41: OK: 1

(On notera que la liste des serveurs n'est pas la même dans la zone

parente, .com et dans la zone

optonlinepress.com. C'est une erreur de

configuration fréquente et Zonemaster proteste à juste

titre. Ici, encore plus rigolo, les serveurs supplémentaires

ont la même adresse

IP.)

DNSDB nous montre l'ancienne configuration :

;; bailiwick: com. ;; count: 136 ;; first seen: 2020-06-17 19:04:12 -0000 ;; last seen: 2021-12-01 16:37:44 -0000 optonlinepress.com. IN NS ns67.domaincontrol.com. optonlinepress.com. IN NS ns68.domaincontrol.com.

La nouvelle étant :

;; bailiwick: com. ;; count: 4 ;; first seen in zone file: 2021-12-04 22:50:22 -0000 ;; last seen in zone file: 2021-12-07 22:50:26 -0000 optonlinepress.com. IN NS ns104a.microsoftinternetsafety.net. optonlinepress.com. IN NS ns104b.microsoftinternetsafety.net.

L'adresse IP pour le nom optonlinepress.com est

désormais 40.83.198.93 (chez Microsoft) alors

qu'elle était auparavant 172.105.98.76 (chez le

gros hébergeur Linode), qui ne répond plus

aujourd'hui. D'ailleurs, les anciens serveurs faisant autorité répondent

toujours pour ce nom (ce qui est courant en cas de saisie

judiciaire, l'ancien hébergeur n'ayant pas été prévenu) :

% dig +norecurse @ns67.domaincontrol.com. ANY optonlinepress.com ; <<>> DiG 9.16.22-Debian <<>> +norecurse @ns67.domaincontrol.com. ANY optonlinepress.com ; (2 servers found) ;; global options: +cmd ;; Got answer: ;; ->>HEADER<<- opcode: QUERY, status: NOERROR, id: 1600 ;; flags: qr aa; QUERY: 1, ANSWER: 4, AUTHORITY: 0, ADDITIONAL: 1 ;; OPT PSEUDOSECTION: ; EDNS: version: 0, flags: do; udp: 1472 ;; QUESTION SECTION: ;optonlinepress.com. IN ANY ;; ANSWER SECTION: optonlinepress.com. 600 IN A 172.105.98.76 optonlinepress.com. 3600 IN NS ns67.domaincontrol.com. optonlinepress.com. 3600 IN NS ns68.domaincontrol.com. optonlinepress.com. 3600 IN SOA ns67.domaincontrol.com. dns.jomax.net. ( 2020111802 ; serial 28800 ; refresh (8 hours) 7200 ; retry (2 hours) 604800 ; expire (1 week) 600 ; minimum (10 minutes) ) ;; Query time: 12 msec ;; SERVER: 2603:5:2174::2c#53(2603:5:2174::2c) ;; WHEN: Thu Dec 09 10:53:43 CET 2021 ;; MSG SIZE rcvd: 164

L'affaire a fait l'objet d'un article sur ArsTechnica qui semble essentiellement reprendre l'article officiel de Microsoft, qui est très médiocre (utilisant au hasard des termes comme server et website, et mélangeant tout).

L'article seul

RFC 9138: Design Considerations for Name Resolution Service in Information-Centric Networking (ICN)

Date de publication du RFC : Novembre 2021

Auteur(s) du RFC : J. Hong, T. You (ETRI, L. Dong, C. Westphal (Futurewei Technologies), B. Ohlman (Ericsson)

Pour information

Réalisé dans le cadre du groupe de recherche IRTF icnrg

Première rédaction de cet article le 1 décembre 2021

L'ICN est l'idée (très contestable) qu'un réseau informatique sert à accéder à du « contenu » et que le réseau doit donc être architecturé autour de cette idée de contenu. Les noms identifient ainsi un contenu donné. Mais il faut bien ensuite trouver le contenu donc résoudre ces noms en quelque chose de plus concret. Ce RFC est le cahier des charges d'un tel système de résolution de noms pour les projets ICN. Comme beaucoup de cahier des charges, il est très « liste au Père Noël », accumulant des desiderata sans se demander s'ils sont réalistes (et compatibles entre eux !).

Comme avec beaucoup de documents qui promeuvent l'ICN, ce RFC donne une description erronée du nommage et de l'adressage dans l'Internet d'aujourd'hui. Passons, et voyons ce que l'ICN propose. L'idée est que le contenu est stocké dans des NDO (Named Data Objects) et que toute activité dans le réseau coniste à récupérer des NDO. Les NDO sont identifiés par un nom. Il ne s'agit pas seulement d'un identificateur mis au-dessus d'un réseau architecturé sur d'autres concepts (comme le sont les URI) mais du concept de base du réseau ; les routeurs ne routent plus selon des adresses mais selon les noms des NDO. Le problème est évidemment qu'il faudra bien, à la fin, trouver l'objet désiré. Cela nécessite (cf. RFC 7927) :

- Un mécanisme de résolution des noms en de l'information plus concrète (une localisation, un autre nom, etc),

- un mécanisme de routage vers l'endroit où se trouve le NDO,

- un mécanisme de récupération du NDO.

Ce RFC se focalise sur le premier point, le NRS (Name Resolution Service), et en est le cahier des charges. Le RFC 9236 a depuis décrit l'architecture envisagée. Si vous voulez apprendre des choses sur les ICN en général et la résolution de noms en particulier, voir par exemple « A Survey of Information-Centric Networking » ou « A Survey of Information-Centric Networking Research ».

Si on compare avec l'Internet actuel, le NRS aura un rôle analogue à celui de BGP (plutôt que du DNS, car le NRS sera au cœur du réseau, et complètement inséparable). Bon, ceci dit, c'est plus compliqué que cela car, derrière l'étiquette « ICN », il y a des tas de propositions différentes. Par exemple, certaines ressemblent plutôt à l'Internet actuel, avec une résolution de noms en localisateurs qui servent ensuite pour le routage (comme dans IDnet, cf. « IDNet: Beyond All-IP Network), alors que d'autres versions du concept d'ICN utilisent les noms pour le routage (comme le NDN ou le CCNx du RFC 8569). La section 2.4 du RFC compare ces approches.

La section 3 du RFC est ensuite le cahier des charges proprement dit. Malheureusement, elle plane au-dessus des réalités quand elle affirme par exemple qu'il faut un NRS qui fonctionnera de la même façon que l'espace de nommage soit plat ou hiérarchique. C'est très irréaliste, il n'y a pas de nette séparation entre la structure de l'espace de nommage et le mécanisme de résolution. Ainsi, ce mécanisme, dans le cas du DNS, est très lié à la structure des noms. Si on la change, tout le DNS serait à refaire (et sans doute en moins efficace). Parmi les systèmes d'ICN qui utilisent un nommage hiérarchique (et réintroduisent donc une forme de « localisation » dans les noms), on trouve NDN et CCNx.

Certains des mécanismes de résolution discutés ont déjà un RFC, par exemple le NI du RFC 6920, utilisé dans NetInf (cf. « Network of Information (NetInf) - An information-centric networking architecture »).

Bref, les principes du NRS :

- Fonctionner avec des structures d'espaces de noms différentes (cf. ma critique ci-dessus),

- accepter la mobilité des contenus,

- passer à l'échelle (ce qui est trivial avec des noms hiérarchiques, beaucoup moins avec des noms plats),

- permettre la mémorisation (caching),

- accepter que les objets soient identifiés par un nom choisi ou par un condensat du contenu (ce que le RFC nomme les « objets sans nom », ce qui me semble accroitre encore la confusion),

- permettre enfin de récupérer des métadonnées et pas seulement le localisateur.

Et le cahier des charges à proprement parler est en section 4. Je ne cite pas tout mais la liste au Père Noël comprend :

- Des réponses rapides (« en un temps raisonnable »),

- des réponses correctes (on voit bien le ridicule de l'approche par cahier des charges, quand il faut préciser explicitement des points aussi évidents), et à jour (là encore, « raisonnablement »),

- des réponses justes, respectant un principe de neutralité (pas de censure ? L'ARCOM n'aimerait pas),

- un fonctionnement satisfaisant sur des réseaux de grande taille (le RFC mentionne au moins 10^21 objets),

- un système gérable (pouvant s'adapter avec par exemple l'ajout et le retrait de nœuds),

- la capacité à être réellement déployé (là encore, on a envie de dire « encore heureux »),

- la résistance aux pannes (la panne d'une machine ne doit pas arrêter le NRS), et aux attaques par déni de service,

- la confidentialité des requêtes (un problème pour le DNS, cf. RFC 7626), mais aussi des données (le RFC mentionne des ACL sur les noms, chose qui n'existe pas vraiment dans le DNS)

- l'authentification des serveurs, des producteurs de noms (par exemple pour que seule l'entité qui a enregistré un nom puisse modifier les données associées), et des données elle-mêmes (ce que DNSSEC fournit au DNS),

Une conclusion ? Les projets regroupés sous le nom d'ICN sont assez anciens, n'ont rien fait de vraiment nouveau récemment, et il y a peu de chances que ce RFC soit suivi de réalisations concrètes.

L'article seul

RFC 9157: Revised IANA Considerations for DNSSEC

Date de publication du RFC : Novembre 2021

Auteur(s) du RFC : P. Hoffman (ICANN)

Chemin des normes

Réalisé dans le cadre du groupe de travail IETF dnsop

Première rédaction de cet article le 1 décembre 2021

Rien de très grave dans ce nouveau RFC, qui règle un problème surtout bureaucratique, le fait que les politiques d'inclusion dans les registres IANA pour certains algorithmes utilisés par DNSSEC n'étaient pas parfaitement alignées.

En effet, le RFC 6014 avait modifié la politique d'enregistrement des algorithmes cryptographiques de « Action de normalisation » à la plus laxiste « RFC nécessaire » (rappelez-vous que tous les RFC ne sont pas des normes, voir le RFC 8126 qui décrit ces politiques possibles). Mais cette « libéralisation » laissait de côté certains algorithmes, ceux utilisés pour les enregistrements DS (RFC 4034), et ceux utilisés pour NSEC3 (RFC 5155), qui restaient en « Action de normalisation ». Notre nouveau RFC aligne les politiques d'enregistrement des algorithmes utilisés pour les DS et pour NSEC3 pour qu'ils soient eux aussi « RFC nécessaire ».

Il modifie également le RFC 8624 pour préciser que les algorithmes normalisés dans des RFC qui ne sont pas sur le chemin des normes sont également couverts par les règles du RFC 8624 ; en gros, ils sont facultatifs (MAY dans le langage du RFC 2119).

Les registres concernés sur celui sur NSEC3 et celui sur DS. Ils portent désormais la mention RFC Required.

Comme l'enregistrement d'algorithmes va, du fait de ce RFC, être plus léger, cela facilitera l'enregistrement de bons algorithmes, mais aussi de mauvais. Le programmeur qui met en œuvre DNSSEC, ou l'administratrice système qui le déploie, ne doit donc pas considérer que la présence dans un registre IANA vaut forcément approbation de la solidité cryptographique de l'algorithme. Il faut consulter la littérature technique avant d'utiliser ces algorithmes.

L'article seul

Fiche de lecture : Digital roots

Auteur(s) du livre : Gabriele Balbi, Nelson

Ribeiro, Valérie Schafer, Christian

Schwarzenegger

Éditeur : De Gruyter Oldenbourg

978-3-11-073988-6

Publié en 2021

Première rédaction de cet article le 29 novembre 2021

Dans le débat public au sujet de l'Internet et du Web, il y a beaucoup de concepts qui sont discutés comme s'ils étaient nouveaux alors qu'ils ont en fait des racines anciennes (gouvernance, bulle de filtre, authenticité, participation d'amateurs…). Cet ouvrage collectif (en anglais) réunit plusieurs contributions qui analysent l'histoire d'un concept et ses origines, souvent bien antérieures au monde numérique.

Le livre a impliqué de nombreuses contributrices et de nombreux contributeurs (celles et ceux cité·es au début de cet article sont « juste » les coordinateurices). Chacun·e s'est attaqué à un concept particulier, montrant son historicité. Mon exemple favori a toujours été les soi-disant fake news, présentées comme une nouveauté du Web alors que le mensonge est aussi ancien que la communication. (Mais, en mettant le terme en anglais, on peut faire croire que c'est quelque chose de nouveau.) La version papier du livre est coûteuse mais il est sous une licence Creative Commons et peut être téléchargé.

Bien sûr, en insistant sur l'ancienneté d'un concept, et des débats qui l'ont toujours accompagné, il ne s'agit pas de dire que rien n'est nouveau, que tout existait déjà dans l'Antiquité. Mais juste de rappeler que la pression médiatico-commerciale a tendance à gommer le passé et à mettre en avant tous les mois un truc présenté comme nouveau.

Le livre commence logiquement par le concept de réseau, qui existait avant les réseaux informatiques, comme le réseau routier de l'empire romain (en étoile, « tous les chemins mènent à Rome », ce qui matérialisait la position dominante de la capitale), ou, plus récemment, le réseau télégraphique. Ces anciens réseaux ont déjà fait l'objet d'innombrables études et réflexions, rappelées par Massimo Rospocher et Gabriele Balbi. Certaines de ces études et réflexions s'appliquent toujours à l'ère de l'Internet. Le concept de multimédia fait l'objet d'un passionnant article de Katie Day Good, qui évoque les espoirs qu'avaient fait naitre les nouveaux médias, par exemple dans le domaine de l'éducation. Les commerciaux des entreprises liées à la radio annonçaient sans rire que radio et autres médias nouveaux à l'époque allaient révolutionner l'enseignement. On retrouve dans les textes de la première moitié du XXe siècle bien des illusions technosolutionnistes d'aujourd'hui. Toujours dans la technique, l'intelligence artificielle est bien sûr à l'honneur, tant le concept est ancien mais ressort régulièrement comme solution miracle à tous les problèmes (article de Paolo Bory, Simone Natale et Dominique Trudel).

Après la technique, la politique. « Gouvernance » est également un concept présenté comme nouveau alors que la politique (arriver à prendre des décisions quand tout le monde n'a pas les mêmes intérêts et les mêmes opinions) est étudiée depuis pas mal de siècles. Comme le rappellent Francesca Musiani et Valérie Schafer, la politique sur l'Internet a des particularités nouvelles, mais les questions politiques liées à l'émergence d'un nouveau réseau ne sont pas, elles, une nouveauté. On se posait des questions de gouvernance bien avant l'Internet, par exemple avec le télégraphe. De même, l'usage de données pour gouverner (la « dataification »), analysée par Eric Koenen, Christian Schwarzenegger et Juraj Kittler, remonte à longtemps, par exemple aux efforts de Jean-Baptiste Colbert en France pour que tout ce qui se passe en France lui soit transmis. On fichait déjà tout, avant que l'arrivée des ordinateurs n'accélère considérablement la quantité de données récoltées, et on en espérait déjà, avant qu'on parle de big data un gouvernement plus efficace. Évidemment, le concept de fake news a droit à son article, et Monika Hanley et Allen Munoriyarwa font un intéressant historique de l'histoire de la tromperie et de la propagande mensongère, remontant au second triumvirat de Rome, en 43 avant l'ère commune, et passant par le XIXe siècle, où l'extension de la littératie et la diffusion massive des journaux allait pouvoir faire décoller cette activité (un fait que les médias d'aujourd'hui oublient quand ils critiquent les fake news diffusées sur le Web). Même regard critique de Maria Löblich et Niklas Venema sur les « bulles de filtre », qui ne sont pas apparues avec les « algorithmes » des réseaux sociaux.