Les RFC (Request For Comments) sont les documents de référence de l'Internet. Produits par l'IETF pour la plupart, ils spécifient des normes, documentent des expériences, exposent des projets...

Leur gratuité et leur libre distribution ont joué un grand rôle dans le succès de l'Internet, notamment par rapport aux protocoles OSI de l'ISO organisation très fermée et dont les normes coûtent cher.

Je ne tente pas ici de traduire les RFC en français (un projet pour cela existe mais je n'y participe pas, considérant que c'est une mauvaise idée), mais simplement, grâce à une courte introduction en français, de donner envie de lire ces excellents documents. (Au passage, si vous les voulez présentés en italien...)

Le public visé n'est pas le gourou mais l'honnête ingénieur ou l'étudiant.

RFC 9926: Prefix Registration for IPv6 Neighbor Discovery

Date de publication du RFC : Février 2026

Auteur(s) du RFC : P. Thubert

Chemin des normes

Première rédaction de cet article le 14 février 2026

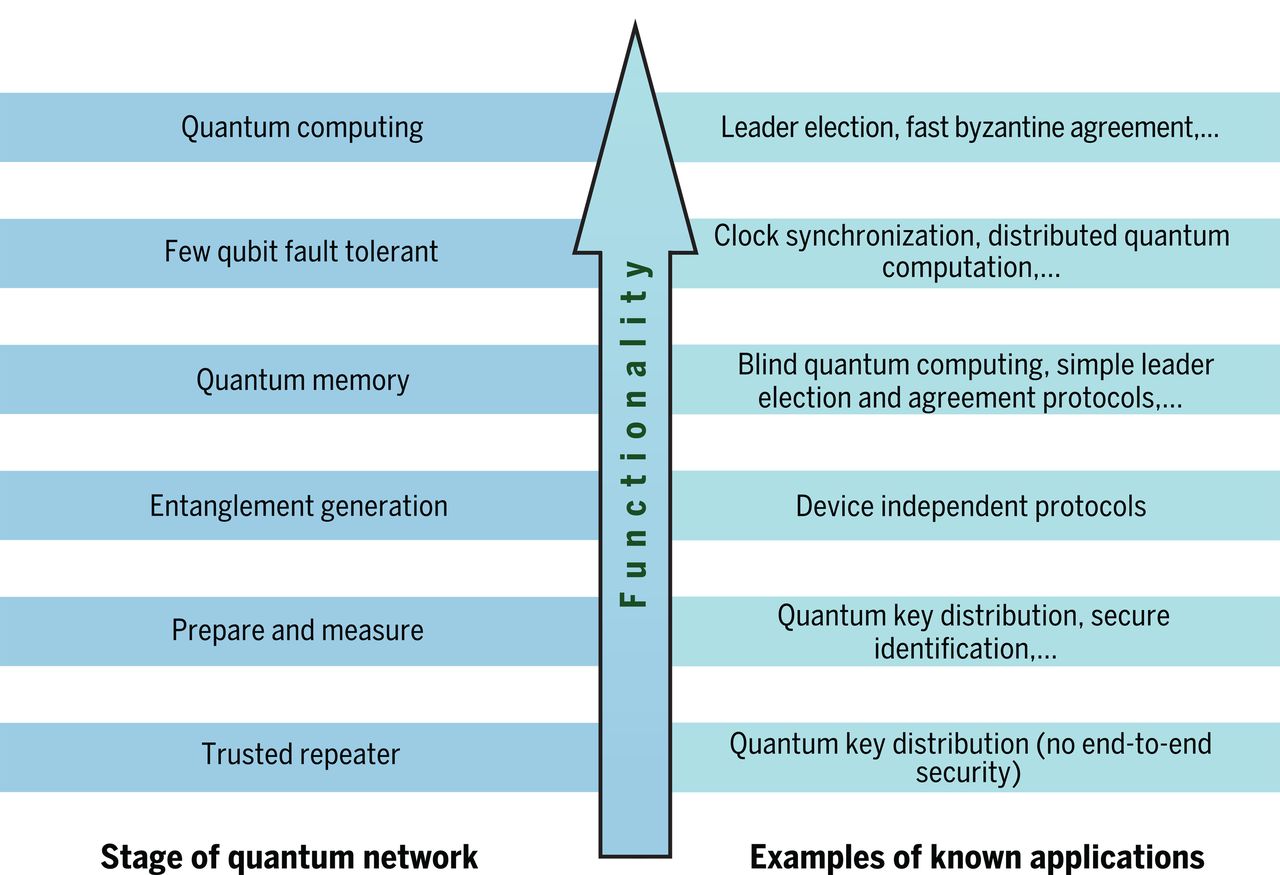

Une addition sympa au mécanisme de découverte des voisins d'IPv6 (RFC 4861), utile pour les réseaux d'objets contraints, genre Internet des Objets mais aussi les réseaux à connectivité imparfaite, par exemple avec des hauts et des bas : la possibilité pour une machine qui est connectée à un réseau d'un préfixe donné d'enregistrer ce préfixe auprès des routeurs voisins. Ceux-ci sauront alors où envoyer les paquets pour ce préfixe. Cela ne remplace pas les protocoles de routage traditionnels, c'est plutôt une addition pour optimiser les protocoles spécialisés dans les réseaux contraints.

Le cœur de cible de ce RFC, ce sont les LLN (Low power and Lossy Networks, les réseaux « pauvres », avec pas beaucoup d'énergie et des liaisons pourries, cf. RFC 7102 et RFC 7228). La préoccupation principale est d'économiser l'énergie ; éviter de transmettre (la radio coûte cher) et s'endormir le plus souvent possible. Ces LLN utilisent des technologies comme 6LoWPAN (RFC 4919) et le protocole de routage RPL du RFC 6550. Les protocoles conçus pour les LLN n'utilisent donc pas d'émissions périodiques (comme le fait OSPF), qui consomment de l'énergie, et obligent tout le monde à écouter tout le temps, donc à ne pas dormir. L'idée de ce RFC est de compter sur quelques routeurs qui sont moins contraints (par exemple parce qu'ils sont connectés à une prise de courant) et que les autres signalent aux routeurs les préfixes connus, lorsqu'ils sont réveillés.

Autre exemple, les mécanismes IPv6 de

découverte du voisin (RFC 4861 et RFC 4862) ont été conçus en pensant à des machines

alimentées électriquement en permanence, sur des réseaux comme

Ethernet, où diffuser à tout le monde est peu

coûteux. Mais ils ne fonctionnent plus si, par exemple, certaines

machines sont endormies, et ne répondent donc pas aux

sollicitations. D'où des idées comme le RFC 6775, où une machine n'attend pas les sollicitations,

elle profite de ses périodes d'éveil pour enregistrer son adresse

auprès du routeur. Idem avec le projet draft-ietf-6man-ipv6-over-wireless. L'idée

a ensuite été généralisée par le RFC 8505,

sur lequel s'appuie notre nouveau RFC, qui permet d'enregistrer un

préfixe IP entier. Notez bien que cette technique est indépendante

de la manière dont la machine a reçu ce préfixe en allocation, et de

la manière dont le routeur auprès duquel on s'enregistre va ensuite

diffuser son préfixe dans son domaine de routage.

La section 3 du RFC donne une vision générale du nouveau mécanisme, je vous laisse la lire 😃.

Notez (section 11) que la machine qui enregistre un préfixe peut mentir et que cette technique doit donc être déployée en comprenant les caractéristiques spécifiques du réseau (par exemple, fermé ou au contraire ouvert sur l'Internet). Le RFC 8928 est ici une bonne lecture, ainsi que la section 9 de notre RFC.

Et merci à Pascal Thubert pour sa relecture. (Naturellement, je reste responsable des erreurs et approximations.)

L'article seul

RFC 9925: Unsigned X.509 Certificates

Date de publication du RFC : Février 2026

Auteur(s) du RFC : D. Benjamin (Google)

Chemin des normes

Réalisé dans le cadre du groupe de travail IETF lamps

Première rédaction de cet article le 27 février 2026

Un certificat est signé par une AC, normalement, ou à la rigueur auto-signé, ce qui ne sert pas à grand'chose mais est obligatoire dans X.509. Mais voici que ce RFC rend la signature facultative.

À ma connaissance, le seul intérêt d'auto-signer son certificat

est de prouver qu'on a bien la clé privée correspondante (car un

plaisantin peut toujours fabriquer un certificat avec la clé

publique de quelqu'un d'autre) et, en prime, de vérifier

l'intégrité. C'est pas crucial. Mais la norme

X.509 (cf. RFC 5280) ne

permet pas d'avoir un certificat sans

signature. Notre RFC 9925 contourne

cette obligation en enregistrant un nouvel algorithme,

id-alg-unsigned,

qui indique qu'il n'y a pas de signature du tout.

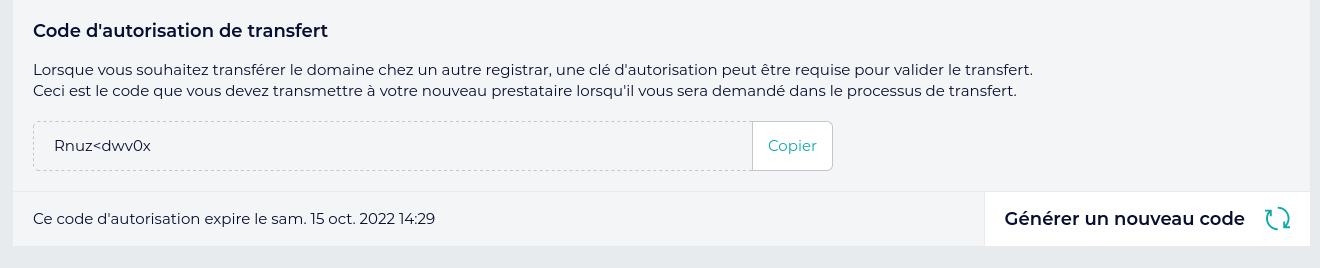

C'est parce que, parfois, on n'a pas besoin des signatures. Un exemple typique se trouve dans votre magasin d'AC : vous ne vérifiez pas les signatures (vous ne pouvez pas, puisque les AC sont à la racine de la validation, RFC 5280, section 6), la seule présence du certificat dans le magasin inspire la confiance. Les certificats des AC sont donc auto-signés, ce qui ne sert pas à grand'chose, à part à satisfaire les exigences syntaxiques du format X.509. Ici, le certificat d'une AC du magasin de ma machine Ubuntu ; Issuer est égal à Subject, le certificat est auto-signé :

% openssl x509 -text -in /etc/ssl/certs/Autoridad_de_Certificacion_Firmaprofesional_CIF_A62634068.pem

Certificate:

Issuer: C = ES, CN = Autoridad de Certificacion Firmaprofesional CIF A62634068

Subject: C = ES, CN = Autoridad de Certificacion Firmaprofesional CIF A62634068

…

X509v3 Basic Constraints: critical

CA:TRUE, pathlen:1

X509v3 Key Usage: critical

Certificate Sign, CRL Sign

…

(Une autre solution serait le RFC 5914 mais il ne semble pas très courant.)

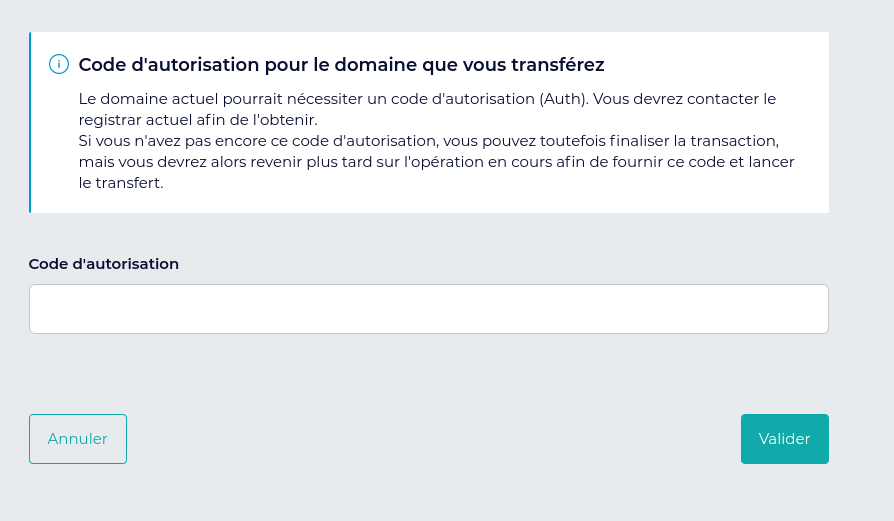

Un autre cas où on se moque de la signature du certificat est celui où le certificat est validé d'une autre façon, par exemple un serveur EPP sur TLS qui a une liste de tous les clients possibles, et des certificats que le registre a distribués à ses BE.

Donc, il y a des cas où la signature ne sert guère, voire pas du tout. Mais est-ce gênant ? Ce n'est pas dramatique mais, dans certains cas, c'est sous-optimal, par exemple :

- Les signatures post-quantiques sont souvent de grande taille, donc cela rend les certificats plus gros pour rien.

- La clé publique dans le certificat peut utiliser un

algorithme qui ne permet pas la signature (comme

ML-KEM, cf. le

futur RFC

draft-ietf-lamps-kyber-certificates).

La section 3 du RFC fournit les détails techniques. Dans le

certificat, on met le champ signatureAlgorithm

à id-alg-unsigned et le champ

signatureValue à une chaine vide. Le champ

issuer pourrait être vide puisque personne n'a

signé le certificat, mais comme il était obligatoire, pour éviter de

choquer les applications actuelles, il vaut mieux mettre un

issuer égal au subject

(comme pour un auto-signé). On a le droit de mettre plutôt un nom

/id-rdna-unsigned= (en fait

1.3.6.1.5.5.7.25.1 mais je montre la

représentation textuelle du RFC 4514). RDNA signifie

Relative

Distinguished Name Attribute et un nouveau

registre, « SMI

Security for PKIX Relative Distinguished Name

Attribute », est créé pour accueillir

id-rdna-unsigned et d'autres futurs noms

(politique de Spécification nécessaire, cf. RFC 8126).

Quand une application rencontre un de ces certificats non signés, si elle valide les signatures, elle doit évidemment rejeter le certificat. Si elle est plus laxiste (ou bien a d'autres mécanismes de vérification), elle peut l'accepter (section 4). Les applications et bibliothèques existantes font déjà cela (elles rejettent les signatures d'algorithmes inconnus) donc l'introduction des certificats non signés ne devrait rien casser.

Quelques conseils de sécurité figurent en section 5, par exemple de ne pas réutiliser les clés dans des contextes différents (X.509, jusqu'à présent, ignorait ce conseil pour les certificats auto-signés puisque la clé publiée servait aussi à signer. Plus de signature, plus de problème.)

Désolé, mais je n'ai pas trouvé comment générer aujourd'hui de tels certificats, que ce soit avec OpenSSL ou d'autres logiciels. Si vous trouvez, ça m'intéresse, je pourrais mettre des essais pratiques ici.

L'article seul

RFC 9920: RFC Editor Model (Version 3)

Date de publication du RFC : Février 2026

Auteur(s) du RFC : P. Hoffman (ICANN), A. Rossi (RFC

Series Consulting Editor)

Pour information

Réalisé dans le cadre de l'activité d'édition des RFC rswg

Première rédaction de cet article le 12 février 2026

Vous avez toujours voulu savoir qui s'occupait de publier les RFC et qu'est-ce que ce mystérieux « RFC Editor » ? Ce nouveau RFC décrit ce rôle et la façon dont il doit accomplir sa tâche. Il s'agit d'une légère mise à jour du RFC 9280, sans changement de version. (Parmi les nouveautés, la définition de la notion d'utilisateurice des RFC, avant, on ne parlait que des auteurices.)

Les RFC sont un ensemble de documents techniques au sujet de l'Internet, qui comprend notamment, mais pas uniquement, les normes TCP/IP. Les RFC sont librement accessibles en ligne et sont publiés depuis 1969 (cf. RFC 8700).

Il y a très longtemps, quand les dinosaures étaient petits, le rôle de RFC Editor s'incarnait bien dans une personne unique, Jon Postel. Aujourd'hui, c'est plus complexe et il n'y a plus, depuis la version 2 du modèle (qui était dans le RFC 8728), de RFC Editor unique. Ce rôle est désormais réparti en deux tâches principales, définir la politique, et la mettre en œuvre. La première tâche est du ressort du RSWG (RFC Series Working Group), pour discuter et proposer (tout le monde, et son chat, peut y participer), puis du RSAB (RFC Series Approval Board), pour décider (ce comité est plus fermé). La deuxième tâche, la mise en œuvre de la politique, est du ressort du RFC Production Center, typiquement une organisation privée sous contrat avec l'IETF LLC, l'organisation administrative derrière l'IETF (RFC 8711). Ce sont donc tous ces groupes ensemble qui composent le « RFC Editor ». Tout ceci, et quelques autres points, étaient déjà dans le RFC 9280, notre nouveau RFC 9920 n'apporte que des changements de détail.

Les RFC sont publiés par cinq voies (streams) différentes, dont une, la voie IETF, sert pour les normes (mais tous les RFC ne sont pas des normes). Chaque voie a une organisation ou une personne responsable du contenu des RFC (pour la voie IETF, le responsable est… l'IETF), la fonction RFC Editor ne gère pas le contenu (ou seulement la forme, mais pas le fond des documents) mais la publication. Le RFC 8729, dans sa section 5.1, décrit les quatre voies classiques (IETF, IRTF, IAB et indépendante). En plus, le RFC 9280 avait introduit la voie éditoriale, dédiée aux évolutions des RFC (les RFC parlant des RFC…). C'est via cette voie que seront publiés les propositions issues du RSWG et approuvées par le RSAB. Un exemple est le récent RFC 9896, dont vous pouvez suivre l'historique.

Dans les deux tâches décrites plus haut (la définition de la politique, et sa mise en œuvre), je n'ai pas mentionné un acteur supplémentaire (comme s'il n'y en avait pas déjà assez !), le RFC Series Consulting Editor, qui est un·e expert·e en édition, membre du RSAB.

Et donc, si vous avez des idées géniales pour améliorer les RFC, il faut faire comment pour qu'elles triomphent ? Lisez la section 3 et notamment la 3.2.2 :

- Les propositions sont écrites (un Internet draft) et diffusées au RSWG (rappelez-vous : il est ouvert, tout le monde peut y participer),

- Après un dernier appel dans le RSWG, puis plus large, s'il y a un consensus approximatif (RFC 2418),

- Les propositions atterrissent au RSAB, qui décidera (avec des votes YES ou CONCERN, le second n'étant pas un NO mais une demande de discussion).

Chaque acteur est décrit ensuite plus en détail. Le RSWG est le groupe le plus ouvert du lot, vous vous abonnez à sa liste de diffusion et c'est parti, vous êtes membre. Et ceci que vous soyez déjà participant à l'IETF ou pas. Les développeur·ses qui mettent en œuvre les RFC, les auteurs de RFC, les auteurs de logiciels qui traitent les RFC, les gens qui citent les RFC dans leurs appels d'offres, tous ceux et toutes celles là sont les bienvenu·es. Les discussions sont publiques. Le RSWG peut aussi utiliser des outils en ligne comme MicrosoftHub (RFC 8874).

Le RSAB, lui, est relativement fermé, aussi bien dans sa composition (les membres avec droit de vote sont un représentant de chaque voie plus le RFC Series Consulting Editor, cf. section 5) que dans son travail (mais les comptes-rendus des réunions sont publics). Par contre, il n'est pas censé court-circuiter le RSWG : toutes les propositions doivent d'abord être discutées au RSWG.

Les boilerplates, ces textes rigides présents au début de chaque RFC et expliquant le statut de celui-ci, décrits dans le RFC 7841, sont décidés par chaque voie puis approuvés par le RSAB, le RFC Production Center et l'IETF Trust.

Le RPC (RFC Production Center) est décrit en section 4. C'est actuellement AMS. C'est ce RPC qui va écrire et maintenir le guide stylistique à respecter (RFC 7322 et documents en ligne), décider des formats acceptés (par exemple du profil restreint de SVG, cf. RFC 9896), et préciser les points que le RFC 7991 laissait libres. C'est aussi le RPC qui doit faire le travail de publication effectif :

- Attribuer les numéros des RFC (qui sera le numéro 10 000 ?),

- Relire et corriger les textes soumis, en respectant le sens technique,

- Garder trace de toutes les modifications faites (des « corrections » peuvent accidentellement changer le fond du texte),

- Assurer la communication avec les auteurs et avec des organisations comme l'IANA, quand le futur RFC leur donne un rôle, par exemple de créer un nouveau registre de paramètres, et archiver tous ces dialogues,

- Demander le cas échéant au RSCE et/ou au RSAB, et leur faire des suggestions, fondées sur son expérience de publication des RFC,

- Participer au RSWG,

- Rendre compte à la communauté des auteurs et lecteurs de RFC, d'une part, et à l'IETF LLC d'autre part,

- Mettre les RFC en ligne, veiller au serveur

www.rfc-editor.orgqui les distribue, archiver les RFC (RFC 8153), annoncer les publications (le RPC est sur le fédivers, voyez par exemple cette annonce, et il y a bien sûr un flux de syndication sur le site Web), - Maintenir le système d'errata (« Submit an issue »),

- Et répondre aux demandes judiciaires car il y a parfois des procès impliquant un RFC.

Le RPC est choisi suite à un appel d'offres de l'IETF LLC, qui est chargée d'écrire le cahier des charges détaillé et de sélectionner le vainqueur. L'argent vient du budget de l'IETF LLC, qui paie le RPC (AMS, actuellement, comme indiqué plus haut).

Et le RSCE (RFC Series Consulting Editor) ? La section 5 le décrit plus en détail. C'est une personne expérimentée dans les questions d'édition. Il ou elle doit guider le RPC sur les questions techniques liées à la publication (la section 4 du RFC 8729 donne une liste complète de ces questions). La RSCE actuelle, depuis 2022, est Alexis Rossi, une des auteures de ce RFC.

Une des nouveautés du RFC 9280 était la voie éditoriale (Editorial Stream), la cinquième voie de création de RFC, consacrée aux RFC qui parlent des RFC. La section 6 de notre RFC la détaille. Cette voie est empruntée par les RFC discutés par le RSWG puis approuvés par le RSAB, comme ce RFC 9920 dont vous êtes en train de lire le résumé. Le statut de ces RFC est forcément « Pour information » (informational, cf. RFC 8729), mais ce sont bien des règles impératives pour les RFC qu'ils spécifient.

Et, pour finir, la section 7 de notre RFC liste les propriétés « historiques » des RFC qui, si elles n'ont pas forcément été mises par écrit, surtout au début, ont toujours été respectées et ne doivent pas être prises à la légère lors des propositions d'évolution :

- Libre disponibilité des documents, que tout le monde peut télécharger, lire, redistribuer. (Ce n'est pas évident, puisque des organisations fermées comme l'AFNOR ou l'ISO ne fournissent toujours pas d'accès libre à leurs documents et, même si vous avez payé pour en avoir un, vous ne pouvez pas le redistribuer.)

- Accessibilité (format texte d'abord, puis XML avec plusieurs formats de sortie), sans dépendance vis-à-vis de logiciels privateurs comme le font les organisations fermées.

- En anglais (notez que la licence permet de faire une traduction sans demander d'autorisation). Opinion personnelle : ce n'est évidemment pas génial mais il n'y pas d'alternative réaliste : traduire des documents normatifs en N autres langues est très coûteux (chaque virgule compte et, par exemple, un texte en français tend facilement à être plus directif que le texte en anglais).

- Diversité : tous les RFC ne sont pas des normes, il y a des informations, des discussions, de l'humour…

- Qualité des documents.

- Stabilité et longévité : le contenu sémantique des RFC n'est jamais modifié, et les formats sont choisis pour garantir qu'ils seront toujours lisibles dans des dizaines d'années (formats standards, acceptés par de nombreux logiciels). À part le cas particulier du RFC 20, le RFC le plus ancien et qui est toujours applicable est le RFC 768, qui a presque un demi-siècle. L'archivage à long terme est un point crucial des RFC, à la fois pour les RFC anciens mais toujours d'actualité, et aussi pour les historien·nes de l'informatique.

La section 1.1 de notre RFC résume les changements depuis le RFC 9280, qui avait spécifié la version 3 du modèle « RFC Editor ». On reste en version 3 et les changements sont peu importants :

- Précisions des responsabilités de développement des outils informatiques nécessaires. C'est au RFC Production Center de s'en occuper. Cela implique des choses comme les choix de formats ou bien les grammaires XML.

- Définition de la notion d'utilisateur des RFC (consumer of RFCs, section 3.3), en se référant au RFC 3935, qui décrit la mission de l'IETF mais qui n'expliquait pas clairement cette notion. Les utilisateurs des RFC sont un ensemble plus large que celui des participants à l'IETF, et un RFC doit être utilisable par des gens qui ne connaissent rien à l'IETF.

- En cohérence avec le RFC 9720, on précise désormais qu'un RFC, une fois publié, peut être modifié (sa forme, mais pas son fond).

La section 9, quant à elle, raconte les changements qu'il y avait eu depuis la version 2 du modèle (la version 1 du modèle était dans le RFC 5620 en 2009 et la version 2 dans le RFC 6635 en 2012) :

- Éclatement de la fonction de RFC Editor en plusieurs acteurs (RSWG, RSAB, etc).

- Fusion des fonctions RFC Production Center et RFC Publisher.

- Suppression du RSOC (RFC Series Oversight Commitee).

- Création de la voie éditoriale pour les RFC parlant des RFC.

L'article seul

RFC 9915: Dynamic Host Configuration Protocol for IPv6 (DHCPv6)

Date de publication du RFC : Janvier 2026

Auteur(s) du RFC : T. Mrugalski (ISC), B. Volz

(Individual Contributor), M. Richardson

(SSW), S. Jiang (BUPT), T. Winters (QA

Cafe)

Chemin des normes

Réalisé dans le cadre du groupe de travail IETF dhc

Première rédaction de cet article le 11 février 2026

IPv6 dispose de trois mécanismes principaux pour l'allocation d'une adresse IP à une machine. L'allocation statique, « à la main », le système d'« autoconfiguration » SLAAC du RFC 4862 et DHCP. DHCP pour IPv6 était normalisé dans le RFC 8415, que notre RFC met à jour. Le protocole n'a guère changé, le principal changement est la suppression de certaines fonctions peu utilisées.

DHCP permet à une machine (qui n'est pas forcément un ordinateur, ou plus exactement qui n'est pas perçue comme telle) d'obtenir une adresse IP (ainsi que plusieurs autres informations de configuration) à partir d'un serveur DHCP du réseau local. C'est donc une configuration « avec état », du moins dans son mode d'utilisation le plus connu. (Notre RFC documente également un mode sans état.) DHCP nécessite un serveur, par opposition à l'autoconfiguration du RFC 4862 qui ne dépend pas d'un serveur (cette autoconfiguration sans état peut être utilisée à la place de ou bien en plus de DHCP). Deux utilisations typiques de DHCP sont le SoHo où le routeur est également serveur DHCP pour les trois PC connectés et le réseau local d'entreprise où deux ou trois machines Unix distribuent adresses IP et informations de configuration à des centaines de machines.

Le principe de base de DHCP (IPv4 ou IPv6) est simple : la nouvelle machine annonce à la cantonade qu'elle cherche une adresse IP, le serveur lui répond, l'adresse est allouée pour une certaine durée, le bail, la machine cliente devra renouveler le bail de temps en temps.

L'administrateur d'un réseau IPv6 se pose souvent la question « DHCP ou SLAAC » ? Notez que les deux peuvent coexister, ne serait-ce que parce que certaines possibilités n'existent que pour un seul des deux protocoles. Ainsi, DHCP seul ne peut indiquer l'adresse du routeur par défaut. Pour le reste, c'est une question de goût.

Le DHCP spécifié par notre RFC ne fonctionne que pour IPv6, les RFC 2131 et RFC 2132 traitant d'IPv4. Les deux protocoles restent donc complètement séparés, le RFC 4477 donnant quelques idées sur leur coexistence. Il a parfois été question de produire une description unique de DHCPv4 et DHCPv6, ajoutant ensuite les spécificités de chacun, mais le projet n'a pas eu de suite (section 1.2 de ce RFC), les deux protocoles étant trop différents.

DHCP fonctionne par diffusion

restreinte. Un client DHCP,

c'est-à-dire une machine qui veut obtenir une adresse, diffuse (DHCP

fonctionne au-dessus d'UDP, RFC 768, le

port source est 546,

le port de destination, où le serveur écoute, est 547) sa demande à

l'adresse multicast locale au lien

ff02::1:2. Le serveur se reconnait et lui

répond. S'il n'y a pas de réponse, c'est, comme dans le DNS, c'est au client de

réémettre (section 15). L'adresse IP source du client est également

une adresse locale au lien.

(Notez qu'une autre adresse de diffusion restreinte est réservée,

ff05::1:3 ; elle inclut également tous les

serveurs DHCP mais, contrairement à la précédente, elle exclut les

relais, qui transmettent les requêtes DHCP d'un réseau local à un

autre.)

Le serveur choisit sur quels critères il alloue les adresses IP. Il peut les distribuer de manière statique (une même machine a toujours la même adresse IP) ou bien les prendre dans un pool d'adresses et chaque client aura donc une adresse « dynamique ». Le fichier de configuration du serveur DHCP Kea ci-dessous montre un mélange des deux approches.

Il faut bien noter (et notre RFC le fait dans sa section 22) que DHCP n'offre aucune sécurité. Comme il est conçu pour servir des machines non configurées, sur lesquelles on ne souhaite pas intervenir, authentifier la communication est difficile. Un serveur DHCP pirate, ou, tout simplement, un serveur DHCP accidentellement activé, peuvent donc être très gênants.

Outre l'adresse IP, DHCP peut indiquer des options comme les adresses des serveurs DNS à utiliser (RFC 3646).

Notre version IPv6 de DHCP est assez différente de la version IPv4 (et le RFC est plus de trois fois plus long). Par exemple, l'échange « normal » entre client et serveur prend quatre paquets IP (section 5) et non pas deux. (Mais il y a aussi un échange simplifié à deux paquets, cf. section 5.1.) L'encodage des messages est très différent, et il y a des différences internes comme l'IA (Identity Association) de la section 12. Il y a aussi des différences visibles à l'utilisateur comme le concept de DUID (DHCP Unique IDentifier), section 11, qui remplace les anciens client identifier et server identifier de DHCP v4. Les différences sont telles que le RFC précise que leur intégration avec DHCP pour IPv4 n'est pas envisagée.

À l'heure actuelle, il existe plusieurs mises en œuvre de DHCPv6, comme Kea (serveur seulement) et dhcpcd (client seulement). (Notez qu'une liste complète figurait dans le brouillon du RFC.) Pour celles et ceux qui utilisent une Freebox comme serveur DHCP, il semble qu'elle ait DHCPv6 depuis 2018 (je n'ai pas testé). Il parait que la Livebox le fait également. Je n'ai pas non plus essayé pour la Turris Omnia mais cela devrait marcher puisqu'elle utilise le serveur odhcpd, qui sait faire du DHCPv6 (ceci dit, je ne vois pas comment l'activer depuis les menus de Luci). Et il y a bien sûr des implémentations non-libres dans des équipements comme les Cisco. Notez que ces mises en œuvre de DHCPv6 n'ont pas forcément déjà intégré les modifications de notre RFC 9915.

Il existe aussi des programmes qui ne sont plus maintenus comme Dibbler (client et serveur), l'ancien programme de l'ISC (le nouveau est Kea), etc.

Voici un exemple d'utilisation de Dibbler, face à Kea, qui nous

affiche les quatre messages (Solicit - Advertise - Request

- Reply) :

% sudo dibbler-client run ... 2026.02.11 08:28:04 Client Notice DUID creation: Generating 14-bytes long link-local+time (duid-llt) DUID. 2026.02.11 08:28:04 Client Notice DUID creation: generated using wlan0/4 interface. 2026.02.11 08:28:04 Client Info My DUID is 00:01:00:01:31:1e:fa:14:f6:fc:69:10:65:09. ... 2026.02.11 08:28:04 Client Info Creating SOLICIT message with 1 IA(s), no TA and 0 PD(s) on eth1/3 interface. 2026.02.11 08:28:04 Client Debug Sending SOLICIT(opts:1 3 39 8 6 ) on eth1/3 to multicast. 2026.02.11 08:28:04 Client Info Received ADVERTISE on eth1/3,trans-id=0x5ded1b, 5 opts: 1 2 3 23 39 2026.02.11 08:28:05 Client Info Processing msg (SOLICIT,transID=0x5ded1b,opts: 1 3 39 8 6) 2026.02.11 08:28:05 Client Info Creating REQUEST. Backup server list contains 1 server(s). 2026.02.11 08:28:05 Client Debug Advertise from Server ID=00:01:00:01:31:19:db:68:38:f7:cd:ce:22:c6, preference=0.[using this] 2026.02.11 08:28:05 Client Debug Sending REQUEST(opts:1 3 39 6 2 8 ) on eth1/3 to multicast. 2026.02.11 08:28:05 Client Info Received REPLY on eth1/3,trans-id=0x6eb008, 5 opts: 1 2 3 23 39 2026.02.11 08:28:05 Client Notice Address fc00:cafe:1234:4321:5678::2/128 added to eth1/3 interface. 2026.02.11 08:28:05 Client Debug RENEW(IA_NA) will be sent (T1) after 1000, REBIND (T2) after 2000 seconds. 2026.02.11 08:28:08 Client Notice FQDN: About to perform DNS Update: DNS server=2001:db8:2::dead:beef, IP=fc00:cafe:1234:4321:5678::2 and FQDN=grace ...

Le serveur en face était un Kea ainsi configuré :

"subnet6": [

{

"interface": "eth0", // Ce n'est pas bien documenté mais

// cette option est cruciale, autrement le client reçoit

// des « Server could not select subnet for this client ».

"subnet": "fc00:cafe:1234:4321::/64",

"pools": [ { "pool": "fc00:cafe:1234:4321:5678::/80" } ],

...

Si vous voulez, le pcap de l'échange est disponible (capture faite avec

tcpdump -w /tmp/dhcpv6-bis.pcap udp and \(port 546 or port

547\)). tcpdump voit le trafic

ainsi :

09:28:04.624687 IP6 fe80::606d:ad11:58ca:6cab.546 > ff02::1:2.547: dhcp6 solicit 09:28:04.639479 IP6 fe80::6ee4:5672:da95:1018.547 > fe80::606d:ad11:58ca:6cab.546: dhcp6 advertise 09:28:05.652900 IP6 fe80::606d:ad11:58ca:6cab.546 > ff02::1:2.547: dhcp6 request 09:28:05.667843 IP6 fe80::6ee4:5672:da95:1018.547 > fe80::606d:ad11:58ca:6cab.546: dhcp6 reply

La requête est émise depuis une adresse

lien-local (ici

fe80::606d:ad11:58ca:6cab) pas depuis une

adresse « tout zéro » comme en IPv4 (section 17 du RFC). On voit

bien les quatre messages (Solicit - Advertise - Request -

Reply), décrits section 5.2 (et la liste des types

possibles est en section 7.3). Le serveur n'a pas répondu

directement avec un Reply, parce que le client

n'a pas inclut l'option Rapid Commit (section

21.14). Dans l'échange à quatre messages, le client demande à tous

(Solicit), un(s) serveur(s) DHCP répond(ent)

(Advertise), le client envoie alors sa requête

au serveur choisi (Request), le serveur donne

(ou pas) son accord (Reply). Avec l'option

-vvv, tcpdump est plus bavard et montre qu'il

analyse bien DHCPv6 :

09:28:04.624687 IP6 (flowlabel 0x51d28, hlim 1, next-header UDP (17) payload length: 99) fe80::606d:ad11:58ca:6cab.546 > ff02::1:2.547: [udp sum ok] dhcp6 solicit (xid=5ded1b (client-ID hwaddr/time type 1 time 824113684 f6fc69106509) (IA_NA IAID:1 T1:4294967295 T2:4294967295 (IA_ADDR :: pltime:4294967295 vltime:4294967295)) (Client-FQDN) (elapsed-time 0) (option-request DNS-server Client-FQDN)) 09:28:04.639479 IP6 (flowlabel 0xf6846, hlim 64, next-header UDP (17) payload length: 140) fe80::6ee4:5672:da95:1018.547 > fe80::606d:ad11:58ca:6cab.546: [udp sum ok] dhcp6 advertise (xid=5ded1b (client-ID hwaddr/time type 1 time 824113684 f6fc69106509) (server-ID hwaddr/time type 1 time 823778152 38f7cdce22c6) (IA_NA IAID:1 T1:1000 T2:2000 (IA_ADDR fc00:cafe:1234:4321:5678::2 pltime:3000 vltime:4000)) (DNS-server 2001:db8:2::dead:beef 2001:db8:2::cafe:babe) (Client-FQDN)) 09:28:05.652900 IP6 (flowlabel 0x51d28, hlim 1, next-header UDP (17) payload length: 117) fe80::606d:ad11:58ca:6cab.546 > ff02::1:2.547: [udp sum ok] dhcp6 request (xid=6eb008 (client-ID hwaddr/time type 1 time 824113684 f6fc69106509) (IA_NA IAID:1 T1:4294967295 T2:4294967295 (IA_ADDR fc00:cafe:1234:4321:5678::2 pltime:3000 vltime:4000)) (Client-FQDN) (option-request DNS-server Client-FQDN) (server-ID hwaddr/time type 1 time 823778152 38f7cdce22c6) (elapsed-time 0)) 09:28:05.667843 IP6 (flowlabel 0xf6846, hlim 64, next-header UDP (17) payload length: 140) fe80::6ee4:5672:da95:1018.547 > fe80::606d:ad11:58ca:6cab.546: [udp sum ok] dhcp6 reply (xid=6eb008 (client-ID hwaddr/time type 1 time 824113684 f6fc69106509) (server-ID hwaddr/time type 1 time 823778152 38f7cdce22c6) (IA_NA IAID:1 T1:1000 T2:2000 (IA_ADDR fc00:cafe:1234:4321:5678::2 pltime:3000 vltime:4000)) (DNS-server 2001:db8:2::dead:beef 2001:db8:2::cafe:babe) (Client-FQDN))

Mais si vous préférez tshark, l'analyse de cet échange est également disponible.

Notez que certains clients DHCP dépendent de la présence d'un routeur qui envoie des RA (RFC 4861) avec le bit M - Managed - à 1 (RFC 4861, section 4.2). En l'absence de ces annonces, le client se contente de demander des informations diverses au serveur DHCP, mais pas d'adresse IP.

Et si vous voulez compiler dhcpcd vous-même, c'est simple :

wget https://github.com/NetworkConfiguration/dhcpcd/releases/download/v10.3.0/dhcpcd-10.3.0.tar.xz dhcpcd-10.3.0.tar.xz tar xvf dhcpcd-10.3.0.tar dhcpcd-10.3.0 ./configure make sudo make install

L'échange à deux messages (Solicit - Reply)

est, lui, spécifié dans la section 5.1. Il s'utilise si le client

n'a pas besoin d'une adresse IP, juste d'autres informations de

configuration comme l'adresse du serveur NTP, comme décrit dans le RFC 4075. Même si le client demande une adresse IP, il est

possible d'utiliser l'échange à deux messages, via la procédure

rapide avec l'option Rapid Commit.

Tout client ou serveur DHCP v6 a un DUID (DHCP Unique

Identifier, décrit en section 11). Le DUID est opaque et

ne devrait pas être analysé par la machine qui le reçoit. La seule

opération admise est de tester si deux DUID sont égaux (indiquant

qu'en face, c'est la même machine). Il existe plusieurs façons de

générer un DUID (dans l'exemple plus haut, Dibbler avait choisi la

méthode duid-llt, adresse locale et heure) et

de nouvelles pourront apparaitre dans le futur. Par exemple, un DUID

peut être fabriqué à partir d'un UUID (RFC 6355).

Mais l'utilisation exclusive du DUID, au détriment de l'adresse MAC, n'est pas une obligation du RFC (le RFC, section 11, dit juste « DHCP servers use DUIDs to identify clients for the selection of configuration parameters », ce qui n'interdit pas d'autres méthodes). On peut utiliser l'adresse Ethernet. En combinaison avec des commutateurs qui filtrent sur l'adresse MAC, cela peut améliorer la sécurité.

Puisqu'on peut aussi attribuer des adresses statiquement à une machine, en la reconnaissant, par exemple, à son adresse MAC ou à son DUID, voici comment on peut configurer Kea pour donner une adresse IP fixe au client d'un certain DUID :

"reservations": [

{

"duid": "00:01:00:01:31:1e:fa:14:f6:fc:69:10:65:09",

"ip-addresses": [ "fc00:cafe:1234:4321:b0f:1111::1" ]

}

La section 6 de notre RFC décrit les différentes façons d'utiliser DHCPv6. On peut se servir de DHCPv6 en mode sans état (section 6.1), lorsqu'on veut juste des informations de configuration, ou avec état (section 6.2, qui décrit la façon historique d'utiliser DHCP), lorsqu'on veut réserver une ressource (typiquement l'adresse IP) et qu'il faut alors que le serveur enregistre (et pas juste dans sa mémoire, car il peut redémarrer) ce qui a été réservé. On peut aussi faire quelque chose qui n'a pas d'équivalent en IPv4, se faire déléguer un préfixe d'adresses IP entier (section 6.3). Un client DHCP qui reçoit un préfixe, mettons, /60, peut ensuite redéléguer des bouts, par exemple ici des /64. (Le RFC 7084 est une utile lecture au sujet des routeurs installés chez M. Toutlemonde.)

Le format détaillé des messages est dans la section 8. Le début des messages est toujours le même, un type d'un octet (la liste des types est en section 7.3) suivi d'un identificateur de transaction de trois octets. Le reste est variable, dépendant du type de message.

On a déjà parlé du concept de DUID plus haut, donc sautons la section 11 du RFC, qui parle du DUID, et allons directement à la section 12, qui parle d'IA (Identity Association). Une IA est composée d'un identifiant numérique, l'IAID (IA IDentifier) et d'un ensemble d'adresses et de préfixes. Le but du concept d'IA est de permettre de gérer collectivement un groupe de ressources (adresses et préfixes). Pour beaucoup de clients, le concept n'est pas nécessaire, on n'a qu'une IA, d'identificateur égal à zéro. Pour les clients plus compliqués, on a plusieurs IA, et les messages DHCP (par exemple d'abandon d'un bail) indiquent l'IA concernée.

Comme pour DHCPv4, une bonne partie des informations est transportée dans des options, décrites dans la section 21. Certaines options sont dans ce RFC, d'autres pourront apparaitre dans des RFC ultérieurs. Toutes les options commencent par deux champs communs, le code identifiant l'option (deux octets), et la longueur de l'option. Ces champs sont suivis par des données, spécifiques à l'option. Ainsi, l'option Client Identifier a le code 1, et les données sont un DUID (cf. section 11). Autre exemple, l'option Vendor Class (code 16) permet d'indiquer le fournisseur du logiciel client (notez qu'elle pose des problèmes de sécurité, cf. RFC 7824, et section 23 de notre RFC). Notez qu'il peut y avoir des options dans les options, ainsi, l'adresse IP (code 5) est toujours dans les données d'une option IA (les IA sont décrites en section 12).

Puisqu'on a parlé de sécurité, la section 22 du RFC détaille les questions de sécurité liées à DHCP. Le fond du problème est qu'il y a une profonde incompatibilité entre le désir d'une autoconfiguration simple des clients (le but principal de DHCP) et la sécurité. DHCP n'a pas de chiffrement et tout le monde peut donc écouter les échanges de messages, voire les modifier. Et, de toute façon, le serveur n'est pas authentifié, donc le client ne sait jamais s'il parle au serveur légitime. Il est trivial pour un méchant de configurer un serveur DHCP « pirate » et de répondre à la place du vrai, indiquant par exemple un serveur DNS que le pirate contrôle. Les RFC 7610 et RFC 7513 décrivent des solutions possibles à ce problème.

Des attaques par déni de service sont également possibles, par exemple via un client méchant qui demande des ressources (comme des adresses IP) en quantité. Un serveur prudent peut donc limiter la quantité de ressources accessible à un client.

Maintenant, les questions de vie privée. La section 23 rappelle que DHCP est très indiscret. Le RFC 7824 décrit les risques que DHCP fait courir à la vie privée du client (et le RFC 7844 des solutions possibles).

Les registres IANA ne changent pas par rapport à l'ancien RFC. Les différents paramètres sont en ligne.

L'annexe A de notre RFC décrit les changements depuis l'ancien RFC 8415. Rien d'essentiel n'a été changé. On notera :

- Suppression de certains mécanismes optionnels (comme ils étaient de toute façon optionnels, cela n'affecte pas l'interopérabilité) qui étaient complexes et peu mis en œuvre : les adresses temporaires (IA_TA), il faut désormais relâcher explicitement celles qu'on veut temporaires, la possibilité de faire de l'unicast, et donc, logiquement, l'option qui forçait le multicast.

- Correction de plusieurs erreurs signalées (certaines n'ont pas été corrigées puisqu'elles s'appliquaient à des options supprimées).

- Texte plus précis sur les ports UDP utilisés.

- Progression du RFC au statut de norme Internet complète (alors que le RFC 8415 était officiellement une proposition de norme).

L'article seul

RFC 9910: Registration Data Access Protocol (RDAP) Regional Internet Registry (RIR) Search

Date de publication du RFC : Janvier 2026

Auteur(s) du RFC : T. Harrison (APNIC), J. Singh (ARIN)

Chemin des normes

Réalisé dans le cadre du groupe de travail IETF regext

Première rédaction de cet article le 8 janvier 2026

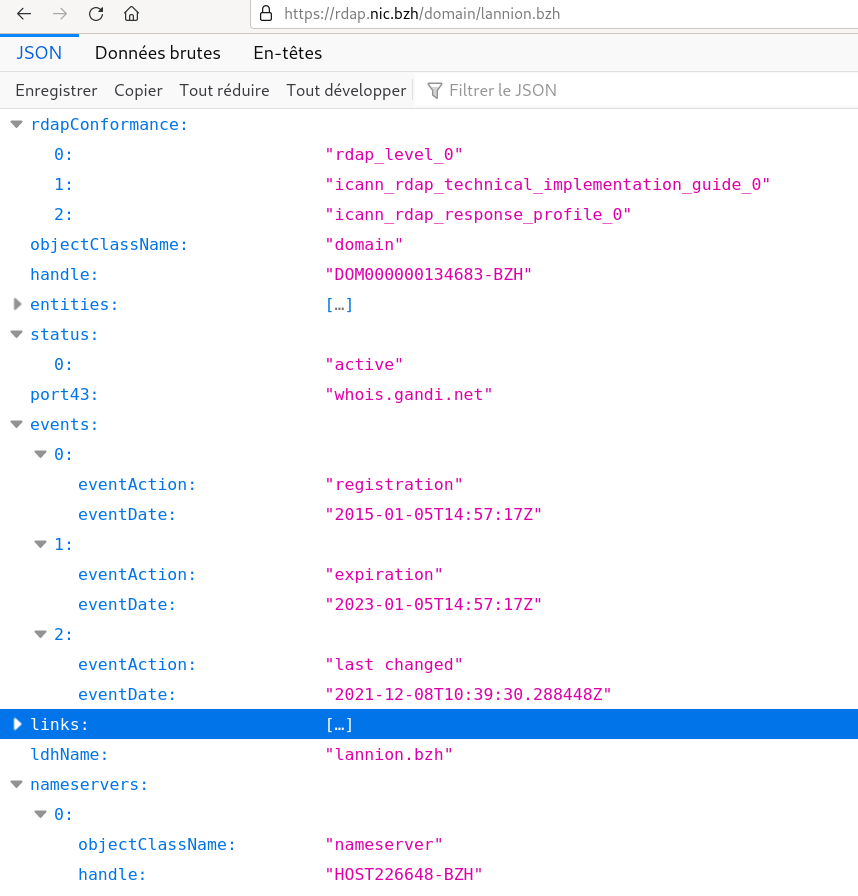

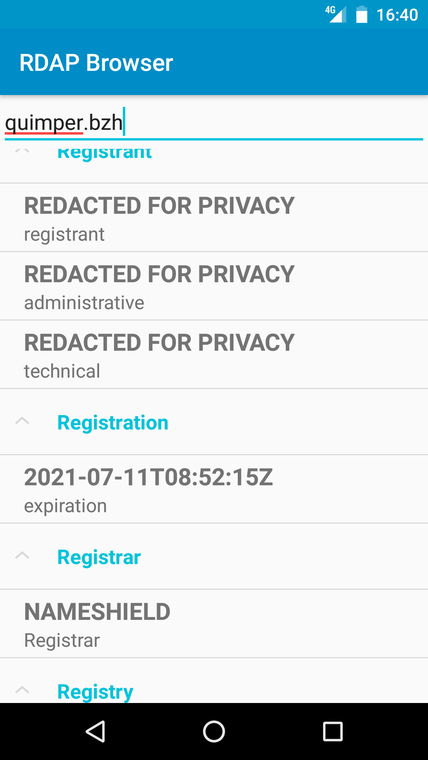

Le protocole RDAP, successeur de whois, n'est pas utilisé que par les registres de noms de domaine. Il sert aussi chez les RIR, pour obtenir des informations sur les entités qui sont derrière une adresse IP (ou un AS). RDAP dispose dès le début de fonctions de recherche (regardez le RFC 9082) mais ce nouveau RFC ajoute des choses en plus.

Traditionnellement, les serveurs whois des RIR disposaient de fonction de recherche « avancées » comme la possibilité de chercher par valeur (« quels sont tous les préfixes IP de tel titulaire ? »). L'idée de ce RFC est de permettre la même chose en RDAP. RDAP de base permet les recherches des informations associées à une adresse IP :

% curl -s https://rdap.db.ripe.net/ip/2001:41d0:302:2200::180 | jq .

{

"handle": "2001:41d0::/32",

"name": "FR-OVH-20041115",

"country": "FR",

"parentHandle": "2001:4000::/23",

…

"status": [

"active"

],

"entities": [

{

"handle": "OK217-RIPE",

…

"text",

"Octave Klaba"

…

En plus de ip, ce RFC ajoute

ips (section 2.1) qui permet une recherche sur

tous les préfixes dont le nom correspond à un certain motif (ici,

tous ceux d'OVH) :

% curl -s https://rdap.db.ripe.net/ips\?name="FR-OVH-*" | jq '.ipSearchResults.[].handle' "109.190.0.0 - 109.190.255.255" "135.125.0.0 - 135.125.255.255" "137.74.0.0 - 137.74.255.255" "141.94.0.0 - 141.95.255.255" "145.239.0.0 - 145.239.255.255" "147.135.128.0 - 147.135.255.255" "149.202.0.0 - 149.202.255.255" "152.228.128.0 - 152.228.255.255" "159.173.0.0 - 159.173.255.255" "162.19.0.0 - 162.19.255.255" …

J'ai utilisé ici curl et jq mais, évidemment, l'avantage de RDAP est que vous pouvez utiliser un client dédié ou bien n'importe quel logiciel qui sait faire du HTTP et du JSON (voyez plus loin un exemple en Python).

Et chez un autre RIR :

% curl -s https://rdap.arin.net/registry/ips\?name='CLOUDFLARE*' | \

jq '.ipSearchResults.[].handle'

"NET-104-16-0-0-1"

"NET-108-162-192-0-1"

"NET-156-146-101-152-1"

"NET-162-158-0-0-1"

"NET-172-64-0-0-1"

"NET-173-245-48-0-1"

"NET-198-41-128-0-1"

"NET-199-27-128-0-1"

"NET6-2606-4700-1"

De la même façon, vous pouvez chercher par numéro d'AS :

% curl -s https://rdap.db.ripe.net/autnums\?name="*NIC-FR*" | \

jq '.autnumSearchResults.[].handle'

"AS2483"

"AS2484"

"AS2485"

"AS2486"

La section 3 décrit ensuite des moyens de trouver les objets parents et enfants (puisque l'allocation des adresses IP est hiérarchique, toute adresse est dans un préfixe plus général et contient des préfixes plus spécifiques, cf. la section 3.2.1 du RFC) :

% curl -s https://rdap.db.ripe.net/ips/rirSearch1/rdap-up/2001:41d0:302:2200::180 | \

jq '.handle'

"2001:41d0::/32"

% curl -s https://rdap.db.ripe.net/ips/rirSearch1/rdap-down/2001:4000::/23 | \

jq '.ipSearchResults.[].handle'

"2001:4000::/32"

"2001:4010::/32"

"2001:4018::/29"

"2001:4020::/32"

…

Notez la relation (rdap-up et

rdap-down). Notez aussi que

rdap-up renvoie au maximum un objet alors que

rdap-down peut en renvoyer plusieurs

(cf. section 4.2), et c'est pour cela qu'il a fallu itérer en jq (le

.[] parcourt le tableau). Quant au

rirSearch1, le 1 indique la version de cette

extension de recherche chez les RIR (désormais enregistrée

à l'IANA).

Et en Python, ça donnerait :

#!/usr/bin/python

# Example of using search extensions to RDAP (RFC 9910)

# https://requests.readthedocs.io

import requests

# Standard library

import json

import sys

# Yes, we should use the registry documented in RFC 7484…

BASE_URL = "https://rdap.db.ripe.net/ips/rirSearch1/rdap-down"

if len(sys.argv) != 2:

raise Exception("Usage: %s ip-prefix-at-ripe" % sys.argv[0])

arg = sys.argv[1]

response = requests.get("%s/%s" % (BASE_URL, arg))

if response.status_code != 200:

raise Exception("Wrong HTTP return code from %s: %s" % (BASE_URL, response.status_code))

data = json.loads(response.text)

for prefix in data["ipSearchResults"]:

print(prefix["handle"])

Et les recherches inverses, telles que décrites dans le RFC 9536 ? La section 5 du RFC les présente et voici un exemple qui marche (trouver tous les préfixes de Webflow) :

% curl -s 'https://rdap.arin.net/registry/ips/reverse_search/entity?handle=WEBFL' | \

jq '.ipSearchResults.[].handle'

"NET-198-202-211-0-1"

"NET6-2620-CB-2000-1"

Un serveur RDAP qui gère les extensions de ce RFC doit le signaler dans ses réponses (section 6) :

…

"rdapConformance" : [ "geofeed1", "rirSearch1", "ips", "cidr0",

"rdap_level_0", "nro_rdap_profile_0", "redacted" ],

…

Mais aussi dans les liens donnés dans les réponses (ici, en réponse

à une requête traditionnelle ip) :

"links": [

{

"value": "https://rdap.db.ripe.net/ip/2001:41d0:302:2200::180",

"rel": "rdap-up",

"href": "https://rdap.db.ripe.net/ips/rirSearch1/rdap-up/2001:41d0::/32",

"type": "application/rdap+json"

},

Et bien sûr dans les réponses d'aide :

% curl -s https://rdap.arin.net/registry/help

{

"rdapConformance" : [ "nro_rdap_profile_0", "rdap_level_0", "cidr0", "nro_rdap_profile_asn_flat_0", "arin_originas0", "rirSearch1", "ips", "ipSearchResults", "autnums", "autnumSearchResults", "reverse_search" ],

"notices" : [ {

"title" : "Terms of Service",

"description" : [ "By using the ARIN RDAP/Whois service, you are agreeing to the RDAP/Whois Terms of Use" ],

"links" : [ {

"value" : "https://rdap.arin.net/registry/help",

"rel" : "terms-of-service",

"type" : "text/html",

"href" : "https://www.arin.net/resources/registry/whois/tou/"

} ]

…

Les fonctions de recherche, c'est très bien mais c'est, par construction, indiscret. La section 8 de notre RFC détaille les risques de ces extensions de recherche pour la vie privée (relire le RFC 7481 est une bonne idée).

Les extensions de ce RFC, rirSearch1,

ips, autnums,

ipSearchResults et

autnumSearchResults ont été enregistrées

à l'IANA (section 10 du RFC). Les relations

rdap-up, rdap-down,

rdap-top et rdap-bottom

sont dans le registre

des liens (RFC 8288). Et le registre

des recherches inverses inclut désormais

fn, handle,

email et role, avec leur

correspondance en JSONPath.

Et question mise en œuvre et déploiement, on a quoi ? ARIN et RIPE ont annoncé avoir programmé les extensions de ce RFC mais elles ne sont pas forcément accessibles via le serveur RDAP public, entre autre pour les raisons de vie privée discutées dans la section 8. Aujourd'hui, comme vous le voyez dans les exemples ci-dessus, au moins ARIN et RIPE rendent une partie de ces extensions utilisables.

L'article seul

RFC 9896: SVG in RFCs

Date de publication du RFC : Janvier 2026

Auteur(s) du RFC : A. Rossi (RFC Series Consulting

Editor), N. Brownlee, J. Mahoney (RFC

Production Center), M. Thomson

Pour information

Réalisé dans le cadre de l'activité d'édition des RFC rswg

Première rédaction de cet article le 5 février 2026

Le RFC 7996 avait introduit la possibilité de mettre des images dans les RFC. Ce nouveau document le remplace, il décrit les règles pour inclure du SVG. Il est très court, se limitant aux principes, il n'a plus de mention d'un profil SVG particulier.

On peut donc mettre des images vectorielles car, a priori, dans un RFC, il y aura beaucoup plus de schémas que de photos. Donc, pas de bitmap.

Au fait, c'est quoi, SVG ? Il s'agit d'une norme d'un format d'images vectoriel, gérée par le W3C, et fondée sur XML. Voici un exemple d'un simple dessin en SVG :

<svg xmlns="http://www.w3.org/2000/svg" version="1.2"> <rect x="25" y="25" width="200" height="200" fill="white" stroke-width="4" stroke="black" /> <circle cx="125" cy="125" r="75" fill="black" /> <polyline points="50,150 50,200 200,200 200,100" stroke="black" stroke-width="4" fill="none" /> <line x1="50" y1="50" x2="200" y2="200" stroke="white" stroke-width="4" /> </svg>

Et voici son rendu :

Ce RFC décrit des objectifs, une politique. Contrairement à son prédécesseur, le RFC 7996, il ne décrit pas de profil de SVG, il fixe des buts, pas les moyens de les atteindre. Ces buts sont :

- Le schéma en SVG ne doit jamais être la seule représentation. Le RFC doit être compréhensible sans les schémas.

- Le SVG ne doit pas inclure d'animations et ne doit pas être trop réactif (pas question de changer quand on tourne le téléphone).

- Le but étant d'être vu et compris par le public le plus large possible, il ne faut pas utiliser les fonctions de SVG qui ne sont pas largement mises en œuvre. Pas de pointeurs vers des ressources externes, pas de script exécutable (pas de JavaScript actif dans un RFC…), attention portée à l'accessibilité, en suivant WAI. Pour la même raison, il ne faut pas de dépendance vis-à-vis des couleurs (RFC 6949, section 3.2) et pas de choix arbitraire de police.

Il est crucial que les RFC soient accessibles à tou·te·s, non seulement quel que soit le matériel utilisé, mais également quels que soient les handicaps dont souffre leur propriétaire. C'est bien joli de vouloir ajouter des tas de choses dans les RFC mais encore faut-il ne pas creuser ainsi davantage le fossé entre les utilisateurs. Ainsi, accepter de la couleur (le RFC 6949 limite les futurs RFC au noir et blanc) fait courir le risque que les daltoniens ne puissent pas comprendre un RFC. De même, les graphiques, qui ont l'air comme ça d'être une bonne idée, peuvent aggraver la situation des malvoyants. Le texte seul peut toujours être lu à voix haute par un synthétiseur de parole mais pas le graphique.

La traduction de ces principes en conseils techniques concrets, et l'application de ces règles seront du ressort du RFC Production Center. Il suivra peut-être les nombreux détails pratiques décrits dans le RFC 7996 mais il n'y est pas obligé.

Comment on écrit du SVG ? S'il est évidemment possible de le faire entièrement à la main avec un éditeur ordinaire, gageons que peu de gens le tenteront. Le RFC 7996 citait des éditeurs graphiques, produisant du SVG, comme les logiciels libres Inkscape et Dia. (Et, si on aime programmer en Python, il y a svgwrite, que je présente plus en détail à la fin.) Attention, Inkscape et Dia produisent du SVG généraliste, qui peut inclure des fonctions de SVG qui ne suivent pas les principes de notre RFC.

Autre solution, utiliser la bibliothèque Fletcher de Typst :

% typst compile --format svg essai-fletcher.typ

Le texte « Tips for Creating Accessible SVG » donne des bons conseils pour faire du SVG accessible. Et il y a bien sûr la norme ARIA, dont il existe une introduction et de bons exemples. (Désolé, je n'ai pas suivi ces excellents principes dans les exemples ci-dessous, mais j'accepte les patches.)

Avec Inkscape, il faut veiller à sauver le

fichier en Plain SVG (autrement, on a des ennuis

avec les éléments spécifiques d'Inkscape, ex-Sodipodi). Mais il

reste malgré cela deux ou trois trucs à corriger manuellement, avant

que le document produit par Inkscape soit accepté. Pour Dia, il faut utiliser l'action

Export (par défaut, Dia n'enregistre pas en SVG),

mais Dia produit alors un document avec une DTD. Si on la retire

(manuellement, ou bien avec xmllint --dropdtd),

tout se passe bien.

Si vous voulez voir des exemples concrets de RFC utilisant SVG, vous avez entre beaucoup d'autres, le RFC 8899, le RFC 9869 ou encore le RFC 9750. Ainsi, le RFC 8899 inclut un schéma qui a deux formes alternatives, en art ASCII :

<artwork type="ascii-art" name="" alt="" align="left" pn="section-4.4-2.1.2">

Any additional

headers .--- MPS -----.

| | |

v v v

+------------------------------+

| IP | ** | PL | protocol data |

+------------------------------+

<----- PLPMTU ----->

<---------- PMTU -------------->

</artwork>

Et en SVG, que vous pouvez admirer dans le rendu HTML du RFC et son rendu en PDF.

Une alternative, pour tester les SVG est svgcheck. Ici avec le vrai source du RFC 9750 :

% svgcheck rfc9750.xml INFO: File conforms to SVG requirements.

Et si je tente de mettre des couleurs vives en modifiant le XML :

% svgcheck rfc9750.xml rfc9750.xml:438: The attribute 'stroke' does not allow the value 'red', replaced with 'black' ERROR: File does not conform to SVG requirements

Autre solution que j'aime bien pour faire du SVG, dès qu'on a des éléments répétitifs et qu'on veut donc automatiser (en Python), svgwrite. Ce schéma en art ASCII :

+--------------+ +----------------+ | Alice |------------------------------------| Bob | | 2001:db8::1 | | 2001:db8::2 | +--------------+ +----------------+

aurait pu être créé avec svgwrite avec network-schema-svgwrite.py, qui donne

Bien sûr, pour un schéma aussi simple, le gain n'est pas évident, mais il le devient pour les schémas comportant beaucoup d'éléments récurrents. Mais notez que svgwrite, par défaut, peut donc produire des SVG non conformes aux règles du RFC (par exemple avec de la couleur). Le programmeur doit donc faire attention.

L'article seul

RFC 9881: Internet X.509 Public Key Infrastructure -- Algorithm Identifiers for the Module-Lattice-Based Digital Signature Algorithm (ML-DSA)

Date de publication du RFC : Octobre 2025

Auteur(s) du RFC : J. Massimo, P. Kampanakis (AWS), S. Turner (sn3rd), B. E. Westerbaan (Cloudflare)

Chemin des normes

Réalisé dans le cadre du groupe de travail IETF lamps

Première rédaction de cet article le 18 février 2026

Vous reprendrez bien un peu de post-quantique ? Ce RFC normalise l'utilisation de signatures ML-DSA dans les certificats X.509.

ML-DSA est un des premiers gagnants du concours du NIST (il se nommait Dilithium à l'époque). Il est normalisé dans FIPS-204. Il utilise les réseaux euclidiens. C'est un algorithme de signature et il a donc toute sa place dans les certificats X.509, aux côtés des plus classiques RSA et ECDSA. Petit rappel de cryptographie post-quantique au passage : contrairement à RSA, ML-DSA ne sait faire que les signatures, pas l'échange de clés. Vous pouvez donc mettre des clés publiques ML-DSA dans un certificat, le signer avec ML-DSA mais, pour un protocole comme TLS, il faudra utiliser autre chose pour l'échange de clés (par exemple ML-KEM, autre vainqueur du concours NIST).

Mettre du post-quantique dans les certificats était moins urgent que dans l'échange de clés : ici, pas de risque qu'un attaquant prévoyant stocke des communications chiffrées, en attendant d'avoir un calculateur quantique pour les décrypter. Avec TLS, le risque est nul car la signature est au moment de la connexion, les calculateurs quantiques ne pourront usurper que les communications futures. Mais, bon, les certificats sont utilisés pour autre chose que TLS, et, comme il faut se préparer à un lent déploiement, il vaut mieux s'y prendre tout de suite.

Notez aussi qu'il n'y a pas que les certificats qui sont signés, les CRL le sont aussi, et ce RFC s'applique aussi à ces listes.

Des deux variantes normalisées dans FIPS-204, « pure » et « HashML-DSA », seule la première est utilisée dans notre RFC, pour les raisons qu'explique la section 8.3.

Le RFC utilise trois niveaux de sécurité différents, et les

identificateurs pour les trois niveaux sont

id-ml-dsa-44 (OID

2.16.840.1.101.3.4.3.17),

id-ml-dsa-65 (OID

2.16.840.1.101.3.4.3.18) et

id-ml-dsa-87 (OID

2.16.840.1.101.3.4.3.19). (Ces OID sont enregistrés

par le NIST.) D'autre part, l'IANA a

enregistré l'identificateur

id-mod-x509-ml-dsa-2025 (OID

1.3.6.1.5.5.7.0.119) pour le module ML-DSA

(annexe A).

Un certificat X.509 contient des indications sur les utilisations

permises (section 4.2.1.3 du RFC 5280). Comme

ML-DSA sait faire des signatures mais pas des échanges de clés, un

certificat avec ML-DSA aura les utilisations de signature, comme

keyCertSign mais pas celles d'échange de clés

comme keyEncipherment.

Le format de la clé privée (section 6) a été un des sujets de discussions chauds à l'IETF (et chez les implémenteurs). Dans la norme FIPS-204, on peut définir une clé privée de deux façons, une optimisée (section 4 de la norme) où on ne stocke que la graine (notée ξ) ou bien une forme longue avec la graine, les éléments de la clé secrète, etc. On peut déduire la clé de la graine (section 6.1 de la norme), mais pas l'inverse donc si vous ne gardez pas la graine, vous pourrez toujours signer mais pas retrouver la graine. Le RFC permet de stocker la clé privée de trois façons, la graine seule (la méthode recommandée, cf. section 8.1), la clé seule (déconseillé) ou les deux (voir un exemple plus loin).

Je n'ai pas trouvé de certificat utilisant ML-DSA dans la nature.

crt.sh ne permet pas de

chercher par algorithme, même dans ses fonctions avancées. Il

faudrait écrire son propre client d'examen des journaux

Certificate Transparency (RFC 9162) et j'avais la flemme. Donc, on va utiliser

OpenSSL 3.5 pour fabriquer des certificats (je

n'ai pas testé pour voir s'ils étaient parfaitement conformes au RFC…).

% openssl req -new -newkey mldsa44 -keyout mldsa.key -out mldsa.csr -nodes -subj "/CN=test" % openssl x509 -in mldsa.csr -out mldsa.crt -req -signkey mldsa.key -days 2001 Certificate request self-signature ok subject=CN=test

Et hop, nous voilà avec un beau certificat :

% openssl x509 -text -in mldsa.crt

Certificate:

Data:

Version: 3 (0x2)

Serial Number:

54:5b:c0:5d:0e:85:83:43:90:77:93:4f:53:83:e1:38:a2:12:9f:61

Signature Algorithm: ML-DSA-44

Issuer: CN=test

Validity

Not Before: Feb 17 15:01:53 2026 GMT

Not After : Aug 11 15:01:53 2031 GMT

Subject: CN=test

Subject Public Key Info:

Public Key Algorithm: ML-DSA-44

ML-DSA-44 Public-Key:

pub:

15:10:02:cc:d6:ec:53:12:bb:6d:34:23:82:65:ec:

…

X509v3 extensions:

X509v3 Subject Key Identifier:

6E:F9:AD:56:9C:AA:60:EF:ED:B7:A1:7B:70:F6:71:55:74:B8:68:B9

Signature Algorithm: ML-DSA-44

…

Autre solution, de plus bas niveau, en découpant les étapes :

# Créer la clé privée

openssl genpkey -algorithm ML-DSA-44 -out private.pem

# Extraire la clé publique (mais on ne s'en servira pas ici)

openssl pkey -in private.pem -pubout -out public.pem

# Créer la demande de signature du certificat

openssl req -new -subj /CN=Test -key private.pem -out cert.csr

# (Auto-)Signer

openssl x509 -req -in cert.csr -signkey private.pem -out cert.pem

Certificate request self-signature ok

subject=CN=Test

# Vérifier

openssl x509 -text -in cert.pem

Certificate:

Data:

Version: 3 (0x2)

Serial Number:

7c:65:cb:17:5b:ed:ee:08:c9:1a:6b:a5:97:da:ac:b8:0e:6e:df:cd

Signature Algorithm: ML-DSA-44

Issuer: CN=Test

Validity

Not Before: Feb 18 13:24:05 2026 GMT

Not After : Mar 20 13:24:05 2026 GMT

Subject: CN=Test

Subject Public Key Info:

Public Key Algorithm: ML-DSA-44

ML-DSA-44 Public-Key:

…

Signature Algorithm: ML-DSA-44

…

Et si vous voulez utiliser des extensions comme la restriction d'utilisation du certificat (ici, on se limite à la signature), remplacez la demande de signature et la signature par :

openssl req -new -subj /CN=Test -key private.pem -out cert.csr -addext "keyUsage=digitalSignature" openssl x509 -req -in cert.csr -signkey private.pem -out cert.pem -copy_extensions copy

Si vous voulez regarder ce qu'il y a dans la clé privée :

% openssl pkey -text -in private.pem

…

ML-DSA-44 Private-Key:

seed:

48:c8:e4:e3:63:16:c0:e4:57:da:22:31:94:36:98:

..

priv:

d9:0b:5b:8d:18:4f:61:8d:c0:8f:85:6c:97:28:46:

…

Vous voyez que sont stockées graine et clé (et la clé publique, plus loin).

Pour wolfSSL, vous pouvez regarder ici.

Pour des « vrais » certificats, notez que Digicert en fait apparemment, ainsi que l'AC pour usage privé d'AWS. Vous connaissez d'autres AC qui permettraient ML-DSA ?

Sinon, l'annexe C du RFC comprend de nombreux exemples de clés et de signatures.

L'article seul

RFC 9874: Best Practices for Deletion of Domain and Host Objects in the Extensible Provisioning Protocol (EPP)

Date de publication du RFC : Septembre 2025

Auteur(s) du RFC : S. Hollenbeck (Verisign Labs), W. Carroll (Verisign), G. Akiwate (Stanford University)

Réalisé dans le cadre du groupe de travail IETF regext

Première rédaction de cet article le 5 octobre 2025

Dans un registre de noms de domaine, il existe une classe d'objets pour les domaines et parfois une pour les serveurs de noms (hosts). C'est en se basant sur les objets de ces classes que des informations sont ensuite publiées dans le DNS. Que se passe-t-il si on retire un objet de ces classes, alors que d'autres objets en dépendaient ? Va-t-on scier une branche sur laquelle quelqu'un est assis ? Ce RFC fait le point sur les solutions existantes, notant que certaines sont moins bonnes que d'autres, notamment pour la sécurité.

Prenons un exemple simple : le domaine

monbeaudomaine.example est enregistré auprès du

registre

du TLD .example. Ses

serveurs de noms sont ns1.domaine-d-un-copain.example et

ns1.hébergeur.example et on va supposer que le

registre de .example traite les serveurs de

noms comme une classe distincte dans sa base de données. Maintenant,

supposons que le domaine

domaine-d-un-copain.example soit supprimé parce

que son titulaire n'en voit plus l'utilité. Que va devenir le

serveur de noms

ns1.domaine-d-un-copain.example ? Il existe de

nombreuses façons de traiter ce problème, et c'est le rôle de ce RFC

de les analyser toutes.

Ainsi, la section 3.2.2 du RFC 5731 dit que

ce n'est pas bien de détruire un domaine si des objets de type

serveur de noms sont sous ce domaine. Dans l'exemple précédent, le

registre de .example aurait refusé la

suppression de

domaine-d-un-copain.example. Mais cela laisse

le problème entier : si le titulaire ne veut plus payer et donc veut

supprimer le domaine, que faire ?

Un cas similaire se produit si on veut supprimer un serveur de

noms. Si le client EPP demande au serveur EPP

du registre de .example la suppression de

l'objet ns1.domaine-d-un-copain.example, que

doit faire le registre, sachant que ce serveur de noms est utilisé

par monbeaudomaine.example ? La section 3.2.2

du RFC 5732 dit que le registre devrait

refuser la suppression. C'est d'autant plus gênant que, dans le

modèle RRR (Registrant-Registrar-Registry), domaine et serveur(s) peuvent

être gérés par des BE différents, n'ayant

pas le droit de toucher aux objets des autres BE.

Vous pouvez trouver des bonnes explications et des exemples réels dans les supports d'une présentation qui avait été faite à l'IETF.

Quelles sont donc les recommandations concrètes de ce RFC ? La section 6 les résume. Au choix :

- Renommer les serveurs de noms vers le nom d'un serveur maintenu par le client EPP (le BE), comme décrit dans la section 5.1.3.4.

- Demander au client EPP de supprimer les serveurs de noms mais avec possibilité de rétablissement (RFC 3915) comme décrit en section 5.2.2.3.

- Renommer les serveurs de noms dans un nom de domaine

spécial, dont il est garanti qu'il ne sera jamais utilisé, comme décrit en

section 5.1.4.3. Pour éviter d'avoir à créer une nouvelle entrée

dans le registre des noms de domaine

spéciaux, le nom

sacrificial.invalid, utilisant un TLD existant, est recommandé.

Le protocole EPP permet de changer le nom

d'un serveur de noms (section 3.2.5 du RFC 5732). Une pratique déjà observée est donc de renommer les

serveurs de noms. Dans l'exemple ci-dessus, recevant la demande de

suppression de domaine-d-un-copain.example, le

registre (ou le BE s'il le peut) renommerait

ns1.domaine-d-un-copain.example en, mettons,

ns1.domaine-d-un-copain.renamed.invalid. Ici,

.invalid, TLD réservé

par le RFC 6761, ne poserait pas vraiment de

problème mais renommer dans un domaine ouvert à l'enregistrement

pourrait créer un risque de sécurité, si le domaine de destination

n'existe pas, un méchant pouvant alors l'enregistrer et être ainsi en

mesure de répondre aux requêtes DNS.

La section 3 du RFC explique brièvement pourquoi les RFC 5731 et RFC 5732 déconseillent fortement de permettre la suppression d'un domaine tant que des serveurs de noms dans ce domaine existent. Il y a deux risques de sécurité si on détruisait le domaine en laissant les serveurs de noms tels quels dans la base de données du registre : un de déni de service (le nom ne se résout plus et le serveur va donc être inutile) et un de détournement (si un méchant peut ré-enregistrer le nom de domaine supprimé). Il y a aussi le problème de la colle orpheline, décrit dans le rapport du SSAC, « Comment on Orphan Glue Records in the Draft Applicant Guidebook ».

Si la clé qui identifie un serveur de noms est un numéro quelconque et pas son nom, on peut renommer le serveur sans changer les délégations, ce qui est particulièrement utile si le client EPP n'a pas le droit de changer des délégations qui appartiennent à un autre client du registre. Le nouveau nom ne va en général pas être associé à un serveur opérationnel : on sacrifie un serveur pour pouvoir supprimer le domaine parent. Mais cela entraine quelques risques (section 4 du RFC et l'article d' Akiwate, G., Savage, S., Voelker, G., et K. Claffy, « Risky BIZness: Risks Derived from Registrar Name Management »). Si on renomme vers un nom actuellement inexistant, le domaine peut être détourné si un malveillant enregistre ensuite ce domaine.

Compte tenu de tout cela, la section 5 du RFC étudie les différentes pratiques possibles, leurs avantages et leurs inconvénients. Pour les illustrer, je vais utiliser une base de données simple, décrite en SQL (les essais ont été faits avec PostgreSQL). Voici par exemple une création d'une telle base :

CREATE TABLE Domains (name TEXT UNIQUE);

-- Ici, la table Nameservers n'offre aucune valeur ajoutée par rapport

-- au fait de tout mettre dans Domains. Mais ce ne sera pas le cas par

-- la suite.

CREATE TABLE Nameservers (name TEXT UNIQUE);

CREATE TABLE Delegation (domain TEXT REFERENCES Domains(name),

server TEXT REFERENCES Nameservers(name));

INSERT INTO Domains VALUES ('monbeaudomaine.example');

INSERT INTO Domains VALUES ('domaine-d-un-copain.example');

INSERT INTO Nameservers VALUES ('ns1.domaine-d-un-copain.example');

INSERT INTO Nameservers VALUES ('ns1.hébergeur.example');

INSERT INTO Delegation VALUES ('monbeaudomaine.example', 'ns1.domaine-d-un-copain.example');

INSERT INTO Delegation VALUES ('monbeaudomaine.example', 'ns1.hébergeur.example');

Dans ce premier cas très simple, la suppression du domaine

domaine-d-un-copain.example est triviale :

registry=> DELETE FROM Domains WHERE name='domaine-d-un-copain.example'; DELETE 1

Mais elle laisse la possibilité de colle

orpheline et surtout d'un détournement de monbeaudomaine.example si

quelqu'un ré-enregistre

domaine-d-un-copain.example. Ce premier essai

n'est pas conforme aux exigences des RFC 5731

et RFC 5732. On va essayer de

faire mieux.

Si on interdit (à juste titre) la suppression d'un domaine lorsque des serveurs de noms sont nommés dans ce domaine, on peut arriver à supprimer un domaine en supprimant d'abord les serveurs de noms qui sont nommés dans ce domaine (section 5.2) :

CREATE TABLE Domains (name TEXT UNIQUE);

-- Ajout d'une dépendance au domaine parent, pour éviter les suppressions.

CREATE TABLE Nameservers (name TEXT UNIQUE, parent TEXT REFERENCES Domains(name));

CREATE TABLE Delegation (domain TEXT REFERENCES Domains(name),

server TEXT REFERENCES Nameservers(name));

INSERT INTO Domains VALUES ('monbeaudomaine.example');

INSERT INTO Domains VALUES ('domaine-d-un-copain.example');

INSERT INTO Domains VALUES ('hébergeur.example');

-- Pour une vraie base, on écrirait du code SQL qui extrait le parent

-- automatiquement.

INSERT INTO Nameservers VALUES ('ns1.domaine-d-un-copain.example', 'domaine-d-un-copain.example');

INSERT INTO Nameservers VALUES ('ns1.hébergeur.example', 'hébergeur.example');

INSERT INTO Delegation VALUES ('monbeaudomaine.example', 'ns1.domaine-d-un-copain.example');

INSERT INTO Delegation VALUES ('monbeaudomaine.example', 'ns1.hébergeur.example');

registry=> DELETE FROM Domains WHERE name='domaine-d-un-copain.example';

ERROR: update or delete on table "domains" violates foreign key constraint "nameservers_parent_fkey" on table "nameservers"

DETAIL: Key (name)=(domaine-d-un-copain.example) is still referenced from table "nameservers".

-- Ce comportement est ce que recommandent les RFC 5731 et 5732.

-- Cela oblige le client à supprimer les serveurs de noms d'abord, ce qui à

-- son tour nécessite potentiellement de changer les délégations :

registry=> DELETE FROM Delegation WHERE server = 'ns1.domaine-d-un-copain.example';

DELETE 1

registry=> DELETE FROM Nameservers WHERE name='ns1.domaine-d-un-copain.example';

DELETE 1

registry=> DELETE FROM Domains WHERE name='domaine-d-un-copain.example';

DELETE 1

Ici, il y a eu suppression explicite des serveurs de noms par le

client (section 5.2.2.1). Cela peut poser des problèmes de permission, dans le cadre du

système RRR, si tous les objets ne sont pas

chez le même BE. Mais la suppression explicite est

une des trois solutions recommandées, notamment si on ajoute la

possibilité de rétablir l'état précédent (commande EPP

<restore>, RFC 3915).

On peut aussi envisager une suppression implicite (section 5.2.1.1), le registre se

chargeant du nettoyage (c'est le rôle

de la directive SQL ON DELETE

CASCADE) :

CREATE TABLE Domains (name TEXT UNIQUE);

CREATE TABLE Nameservers (name TEXT UNIQUE,

parent TEXT REFERENCES Domains(name) ON DELETE CASCADE);

CREATE TABLE Delegation (domain TEXT REFERENCES Domains(name) ON DELETE CASCADE,

server TEXT REFERENCES Nameservers(name) ON DELETE CASCADE);

INSERT INTO Domains VALUES ('monbeaudomaine.example');

INSERT INTO Domains VALUES ('domaine-d-un-copain.example');

INSERT INTO Domains VALUES ('hébergeur.example');

-- Pour une vraie base, on écrirait du code SQL qui extrait le parent

-- automatiquement.

INSERT INTO Nameservers VALUES ('ns1.domaine-d-un-copain.example', 'domaine-d-un-copain.example');

INSERT INTO Nameservers VALUES ('ns1.hébergeur.example', 'hébergeur.example');

INSERT INTO Delegation VALUES ('monbeaudomaine.example', 'ns1.domaine-d-un-copain.example');

INSERT INTO Delegation VALUES ('monbeaudomaine.example', 'ns1.hébergeur.example');

registry=> SELECT Domains.name,Nameservers.name FROM Domains,Delegation,Nameservers WHERE Delegation.domain=Domains.name AND Delegation.server=Nameservers.name;

name | name

------------------------+---------------------------------

monbeaudomaine.example | ns1.domaine-d-un-copain.example

monbeaudomaine.example | ns1.hébergeur.example

(2 rows)

registry=> DELETE FROM Domains WHERE name='domaine-d-un-copain.example';

DELETE 1

-- Serveur de noms et délégation ont été détruits en cascade. Ce n'est

-- pas déraisonnable mais c'est quand même un peu effrayant.

registry=> SELECT Domains.name,Nameservers.name FROM Domains,Delegation,Nameservers WHERE Delegation.domain=Domains.name AND Delegation.server=Nameservers.name;

name | name

------------------------+-----------------------

monbeaudomaine.example | ns1.hébergeur.example

(1 row)

Cette solution est simple et efficace mais détruire implicitement des objets de la base de données peut inquiéter les responsables de cette base. Et cela peut laisser un domaine avec trop peu de serveurs de noms pour assurer sa continuité de service voire, dans le pire des cas, sans serveurs du tout. Et il serait bon de prévenir le client de cette suppression implicite, par exemple par le mécanisme de poll d'EPP (RFC 8590).

Si on interdit (à juste titre, le RFC le recommande) la suppression d'un

domaine lorsque des serveurs de noms sont nommés dans ce domaine, une

solution possible est de

renommer les serveurs avant de supprimer le domaine (section 5.1). Le nouveau nom

permet d'indiquer clairement la raison du renommage. Mais ce

renommage laisse dans la base des « déchets » qu'il faudra nettoyer

un jour. Cette catégorie

contient de nombreuses variantes. Par exemple, on peut renommer dans

un TLD spécial (RFC 6761), ici, .invalid :

CREATE TABLE Domains (name TEXT UNIQUE);

-- On introduit un identificateur du serveur de noms qui n'est *pas*

-- son nom, pour permettre le renommage.

CREATE TABLE Nameservers (id SERIAL UNIQUE, name TEXT UNIQUE,

parent TEXT REFERENCES Domains(name));

CREATE TABLE Delegation (domain TEXT REFERENCES Domains(name),

server INTEGER REFERENCES Nameservers(id));

INSERT INTO Domains VALUES ('monbeaudomaine.example');

INSERT INTO Domains VALUES ('domaine-d-un-copain.example');

INSERT INTO Domains VALUES ('hébergeur.example');

-- Pour le renommage, un nom qui indique clairement le but :

INSERT INTO Domains VALUES ('renamed.invalid');

-- Pour une vraie base, on écrirait du code SQL qui extrait le parent

-- automatiquement.

INSERT INTO Nameservers (name, parent) VALUES ('ns1.domaine-d-un-copain.example', 'domaine-d-un-copain.example');

INSERT INTO Nameservers (name, parent) VALUES ('ns1.hébergeur.example', 'hébergeur.example');

INSERT INTO Delegation VALUES ('monbeaudomaine.example',

(SELECT id FROM Nameservers WHERE name='ns1.domaine-d-un-copain.example'));

INSERT INTO Delegation VALUES ('monbeaudomaine.example',

(SELECT id FROM Nameservers WHERE name='ns1.hébergeur.example'));

registry=> SELECT Domains.name,Nameservers.name FROM Domains,Delegation,Nameservers WHERE Delegation.domain=Domains.name AND Delegation.server=Nameservers.id;

name | name

------------------------+---------------------------------

monbeaudomaine.example | ns1.domaine-d-un-copain.example

monbeaudomaine.example | ns1.hébergeur.example

(2 rows)

registry=> UPDATE Nameservers SET name='ns1.domaine-d-un-copain.example.renamed.invalid', parent='renamed.invalid' WHERE id=1;

UPDATE 1

registry=> DELETE FROM Domains WHERE name='domaine-d-un-copain.example';

DELETE 1

registry=> SELECT Domains.name,Nameservers.name FROM Domains,Delegation,Nameservers WHERE Delegation.domain=Domains.name AND Delegation.server=Nameservers.id;

name | name

------------------------+-------------------------------------------------

monbeaudomaine.example | ns1.domaine-d-un-copain.example.renamed.invalid

monbeaudomaine.example | ns1.hébergeur.example

(2 rows)

Par contre, il ne faut pas utiliser .alt, qui

est explicitement réservé aux protocoles non-DNS (RFC 9476). Notez que certains serveurs EPP peuvent tester le

nom des serveurs de noms et refuser des TLD « inconnus ».

Dans la nature, on a pu observer d'autres pratiques, comme de

renommer dans un sous-domaine de as112.arpa, nom

garanti ne pas exister (RFC 7535), mais qui

n'est pas censé servir à cela (RFC 6305). On a

vu aussi des renommages vers des résolveurs DNS publics, ce qui est

également une horreur, la délégation doit être faite vers des serveurs faisant

autorité, pas des résolveurs.

Certains clients EPP maintiennent des serveurs de noms actifs qui

servent pour le renommage. Cela fait davantage de travail mais cela

protège contre le détournement. Le DNS va continuer à fonctionner

normalement. On pourrait aussi imaginer des serveurs de noms actifs, répondant

NXDOMAIN (« ce domaine n'existe pas »), qui soient

gérés collectivement (section 5.1.4.4) ; un tel service serait

certainement utile. On pourrait même créer un nom de domaine pour ce

service (sacrificial.arpa ?) mais personne ne

l'a encore fait. Pour l'instant, la solution des serveurs maintenus

par le client EPP (section 5.1.3.4) fait partie des trois solutions

recommandées. Le client prudent doit bien verrouiller le domaine dans

lequel ces serveurs sont nommés (enregistrement multi-années,

verrouillage par le registre, etc).

On peut aussi renommer les serveurs de noms vers un nom

non-existant dans un TLD existant. Ça s'est déjà vu mais il ne faut

surtout pas faire cela : un attaquant pourrait enregistrer le nom et

capter ainsi le trafic (.invalid n'a pas ce

problème). Idem si le nom n'est pas sous votre contrôle. Un exemple

est donné par le domaine lenvol.re : ses

serveurs de noms étaient ns.hostin.io,

ns.hostin.mu et

ns.hostin.re. Lors de la suppression de

hostin.re en octobre 2024, le dernier serveur

de noms a été renommé

host1.renamedbyregistry.com (et, en dépit du

nom, pas par le registre). Ce domaine

renamedbyregistry.com étant enregistré, et par

un autre BE, on voit le risque.

% whois lenvol.re domain: lenvol.re status: ACTIVE … nserver: host1.renamedbyregistry.com nserver: ns.hostin.io nserver: ns.hostin.mu

D'autres noms qui utilisaient ce même serveur ont également le problème :

% dig @d.nic.fr savanna.re. NS … ;; AUTHORITY SECTION: savanna.re. 3600 IN NS host1.renamedbyregistry.com. savanna.re. 3600 IN NS ns.hostin.mu. savanna.re. 3600 IN NS ns.hostin.io. ;; Query time: 8 msec ;; SERVER: 2001:678:c::1#53(d.nic.fr) (UDP) ;; WHEN: Tue Jun 24 14:33:32 CEST 2025

En lecture supplémentaire, notre RFC recommande le rapport « SSAC 125 "Report on Registrar Nameserver Management" », ainsi que l'article « Risky BIZness: Risks Derived from Registrar Name Management ».

L'article seul

RFC 9868: Transport Options for UDP

Date de publication du RFC : Octobre 2025

Auteur(s) du RFC : J. Touch, C. Heard

Chemin des normes

Réalisé dans le cadre du groupe de travail IETF tsvwg

Première rédaction de cet article le 5 décembre 2025

Des protocoles de transport, comme TCP, ont le concept d'options, ajoutées à l'en-tête et permettant de régler divers paramètres. Ce RFC ajoute ce concept à UDP et standardise quelques options. Désormais, il y a des moyens standards de faire du « ping » en UDP.

Mais comment ajouter des options à un vénérable protocole (UDP a été normalisé en 1980, dans le RFC 768), qui n'a pas de place pour cela dans son en-tête très minimal ? L'astuce est que UDP indique une taille de paquet qui peut être différente de celle indiquée par IP. Si elle est supérieure, les octets ainsi disponibles peuvent stocker des options, à la fin du paquet. Ce sera donc un pied (trailer) et pas un en-tête.

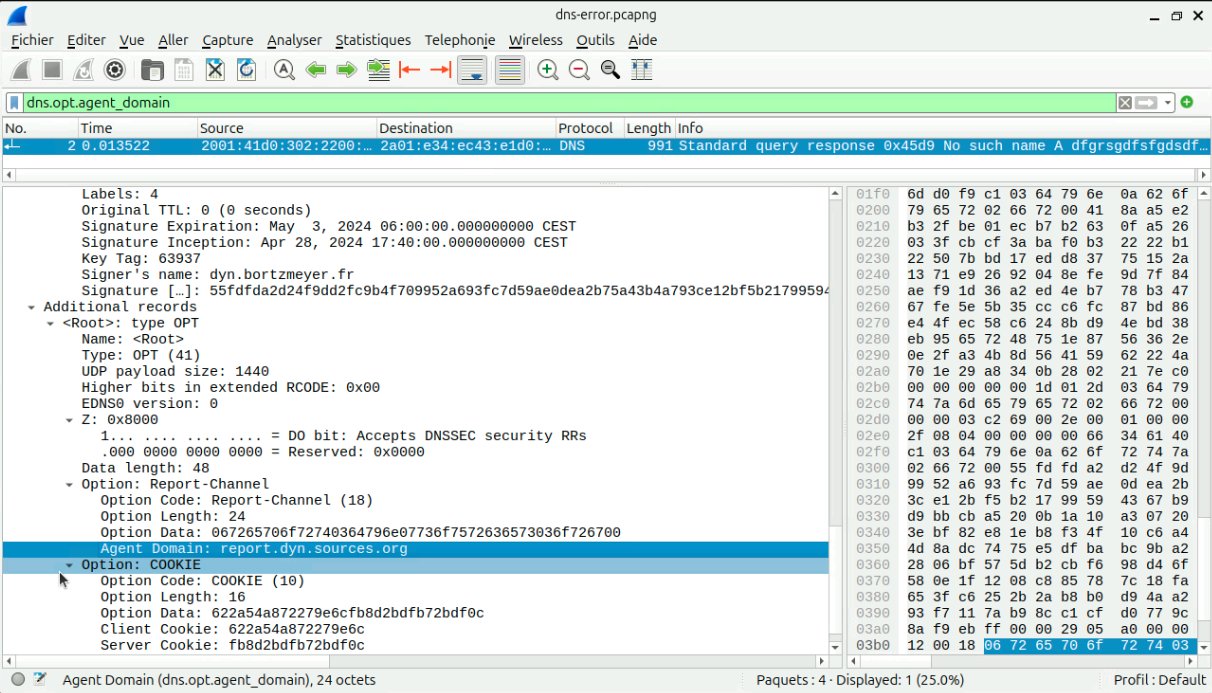

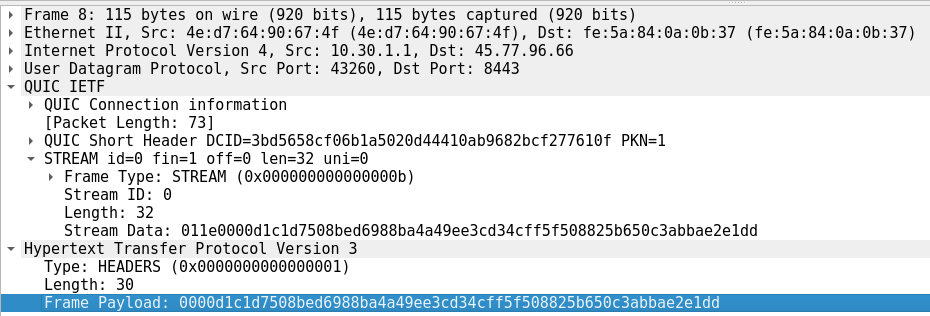

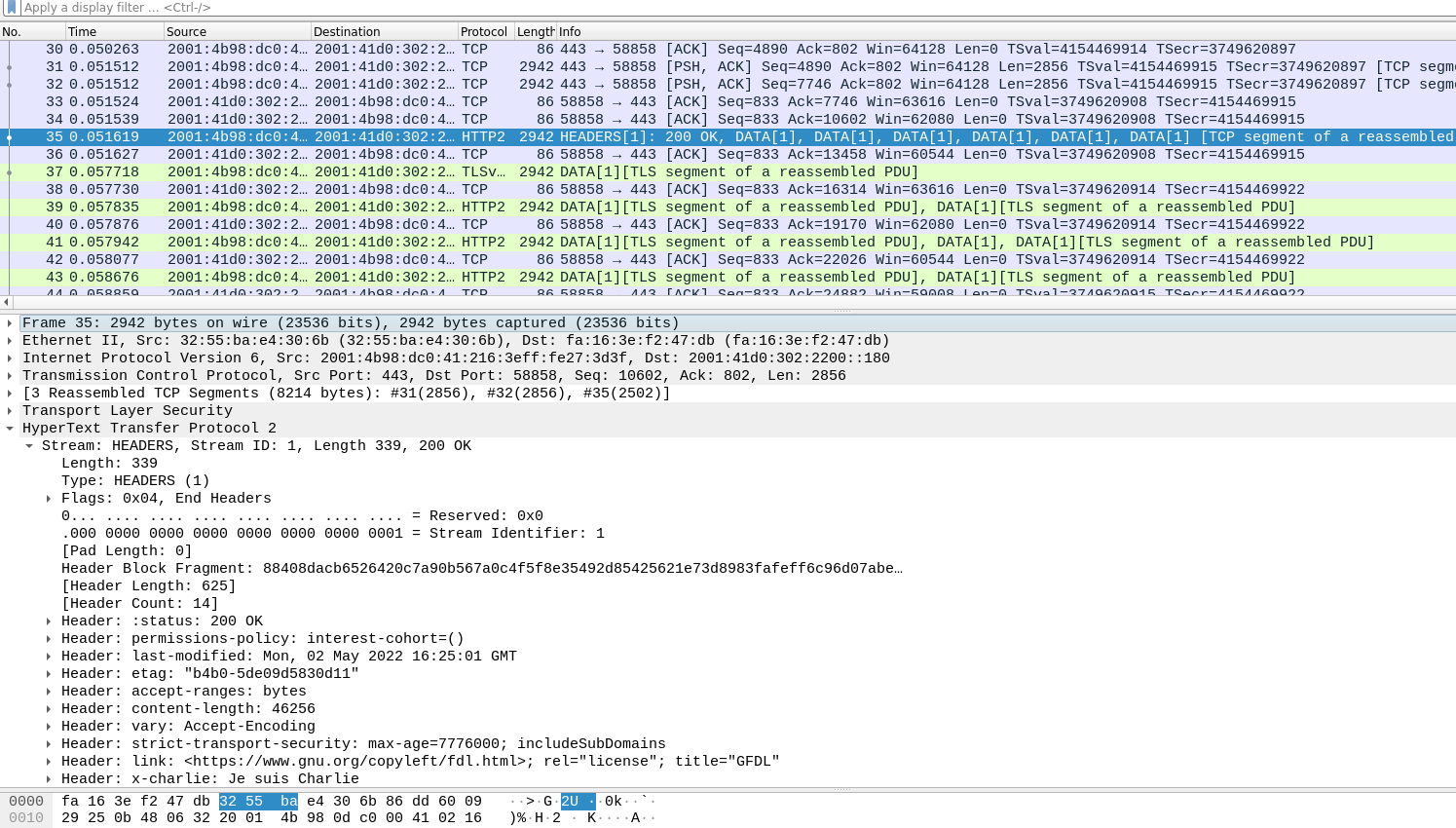

Voici un paquet UDP simplifié (j'ai aussi mis une partie de l'en-tête IP) analysé par tshark :

Internet Protocol Version 6, Src: 2a04:cec0:10fc:5bd8:efd1:79bb:7356:4583, Dst: 2001:db8::1

0110 .... = Version: 6

…

Payload Length: 56

Next Header: UDP (17)

Hop Limit: 64

Source Address: 2a04:cec0:10fc:5bd8:efd1:79bb:7356:4583

Destination Address: 2001:db8::1

User Datagram Protocol, Src Port: 57560 (57560), Dst Port: domain (53)

Source Port: 57560 (57560)

Destination Port: domain (53)

Length: 56

…

UDP payload (48 bytes)