Ce blog n'a d'autre prétention que de me permettre de mettre à la disposition de tous des petits textes que j'écris. On y parle surtout d'informatique mais d'autres sujets apparaissent parfois.

Checking quickly a DNS zone: a new variant of check-soa

First publication of this article on 26 December 2012

Last update on of 22 November 2014

When you want to assert rapidly whether or not a

DNS zone works fine, typical exhaustive tools

like Zonemaster may be too

slow. There is room for a light-and-fast tool and many people used to

rely on the check_soa (with an underscore) program developed by Liu

and Albitz and published with their famous book DNS and

BIND. This original program no longer seems maintained and, the

last time I tested it, did not support

IPv6. So, I wrote one more variant of "my very

own check-soa".

Like the original one, it queries each name server of a zone for the SOA record of the zone:

% check-soa fr d.ext.nic.fr. 192.5.4.2: OK: 2222258998 2001:500:2e::2: OK: 2222258998 d.nic.fr. 194.0.9.1: OK: 2222258998 2001:678:c::1: OK: 2222258998 e.ext.nic.fr. 193.176.144.6: OK: 2222258998 2a00:d78:0:102:193:176:144:6: OK: 2222258998 f.ext.nic.fr. 194.146.106.46: OK: 2222258998 2001:67c:1010:11::53: OK: 2222258998 g.ext.nic.fr. 194.0.36.1: OK: 2222258997 2001:678:4c::1: OK: 2222258997

Here, we can see that all name servers of .FR reply properly and their serial number is

2222258998. You have several options (-h to see

them all). For instance, -i will display the

response time:

% check-soa -i nl nl1.dnsnode.net. 194.146.106.42: OK: 2012122607 (3 ms) 2001:67c:1010:10::53: OK: 2012122607 (40 ms) ns-nl.nic.fr. 192.93.0.4: OK: 2012122607 (3 ms) 2001:660:3005:1::1:2: OK: 2012122607 (2 ms) ns1.dns.nl. 193.176.144.5: OK: 2012122607 (25 ms) 2a00:d78:0:102:193:176:144:5: OK: 2012122607 (38 ms) ns2.dns.nl. 2001:7b8:606::85: OK: 2012122607 (15 ms) 213.154.241.85: OK: 2012122607 (36 ms) ns3.dns.nl. 194.171.17.10: OK: 2012122607 (24 ms) 2001:610:0:800d::10: OK: 2012122607 (29 ms) ns4.dns.nl. 95.142.99.212: OK: 2012122607 (25 ms) 2a00:1188:5::212: OK: 2012122607 (34 ms) ns5.dns.nl. 194.0.28.53: OK: 2012122607 (24 ms) 2001:678:2c:0:194:0:28:53: OK: 2012122607 (33 ms) sns-pb.isc.org. 2001:500:2e::1: OK: 2012122607 (14 ms) 192.5.4.1: OK: 2012122607 (19 ms)

Sometimes, the name servers of the zone are not synchronized (it can be temporary, the DNS being only loosely consistent, or it can be permanent if there is a problem):

% check-soa xname.org ns0.xname.org. 195.234.42.1: OK: 2012081301 ns1.xname.org. 178.33.255.252: OK: 2009030502 ns2.xname.org. 88.191.64.64: OK: 2012081301 2a01:e0b:1:64:240:63ff:fee8:6155: OK: 2012081301 ns3.xtremeweb.de. 130.185.108.193: OK: 2012081301 2a01:4a0:2002:2198:130:185:108:193: OK: 2012081301

Here, ns1.xname.org lags behind.

Do note that check-soa uses a

zone, not just any domain:

% check-soa gouv.fr No NS records for "gouv.fr.". It is probably a domain but not a zone

Of course, when everything works fine, it is boring. What if there

is a problem? check-soa will display it and will

set the exit code accordingly:

% check-soa frnog.org leeloo.supracrawler.com. 193.178.138.10: OK: 2011112300 mercury.ecp-net.com. 193.178.138.20: OK: 2011112300 ns1.saitis.net. 62.220.128.88: OK: 2011112300 2001:788::88: ERROR: Timeout ns2.saitis.net. 62.220.128.98: OK: 2011112300 2001:788::98: ERROR: Timeout

Here, two name servers failed to reply in time (you can tune the

timeout with options -t and

-n). The actual problem was with IPv6

connectivity, so you can try with -4:

% check-soa -q frnog.org ns1.saitis.net. 2001:788::88: ERROR: Timeout ns2.saitis.net. 2001:788::98: ERROR: Timeout % echo $? 1 % check-soa -q -4 frnog.org % echo $? 0

In this specific case, I tested from several sites. But do note that,

quite often, networks problems and the resulting timeout will depend

on the site from which you test. check-soa sees

the Internet from just one point. Other points may be different (this

is specially true with IPv6 today.) A good

example is a test from Free (it works for every

other operator):

% check-soa -i mil CON1.NIPR.mil. 199.252.157.234: ERROR: Timeout CON2.NIPR.mil. 199.252.162.234: ERROR: Timeout EUR1.NIPR.mil. 199.252.154.234: ERROR: Timeout EUR2.NIPR.mil. 199.252.143.234: OK: 2012122703 (229 ms) PAC1.NIPR.mil. 199.252.180.234: ERROR: Timeout PAC2.NIPR.mil. 199.252.155.234: ERROR: Timeout

There are of course many other possible errors. For instance, on the TLD of Cambodia:

% check-soa kh admin.authdns.ripe.net. 193.0.0.198: ERROR: REFUSED 2001:67c:2e8:5:53::6: ERROR: REFUSED dns1.online.com.kh. 203.189.128.1: OK: 2012030124 kh.cctld.authdns.ripe.net. Cannot get the IPv4 address: NXDOMAIN ns.camnet.com.kh. 203.223.32.3: OK: 2012030124 ns.telesurf.com.kh. 203.144.66.3: ERROR: Not authoritative ns1.dns.net.kh. 203.223.32.21: OK: 2012030124 sec3.apnic.net. 2001:dc0:1:0:4777::140: OK: 2012030124 202.12.28.140: OK: 2012030124

We see three types of errors,

admin.authdns.ripe.net refuses to answer for this

TLD (it is called a "lame delegation", the TLD is delegated to a

server which does not know or does not want to answer about it,

probably because of a misunderstanding between operators),

kh.cctld.authdns.ripe.net does not exist and

ns.telesurf.com.kh replies, but is not

authoritative (it is actually an open recursive resolver, something

which is frowned upon, see RFC 5358).

By default, check-soa uses

EDNS. This can create problems with some very

old name servers:

% check-soa microsoft.com ns1.msft.net. 65.55.37.62: ERROR: FORMERR 2a01:111:2005::1:1: ERROR: FORMERR ns2.msft.net. 2a01:111:2006:6::1:1: ERROR: FORMERR 64.4.59.173: ERROR: FORMERR ns3.msft.net. 213.199.180.53: ERROR: FORMERR 2a01:111:2020::1:1: ERROR: FORMERR ns4.msft.net. 2404:f800:2003::1:1: ERROR: FORMERR 207.46.75.254: ERROR: FORMERR ns5.msft.net. 65.55.226.140: ERROR: FORMERR 2a01:111:200f:1::1:1: ERROR: FORMERR

All of Microsoft's name servers reply "FORmat

ERRor". The -r option will force back old DNS:

% check-soa -r microsoft.com ns1.msft.net. 65.55.37.62: OK: 2012122401 2a01:111:2005::1:1: OK: 2012122401 ns2.msft.net. 2a01:111:2006:6::1:1: OK: 2012122401 64.4.59.173: OK: 2012122401 ns3.msft.net. 213.199.180.53: OK: 2012122401 2a01:111:2020::1:1: OK: 2012122401 ns4.msft.net. 2404:f800:2003::1:1: OK: 2012122401 207.46.75.254: OK: 2012122401 ns5.msft.net. 65.55.226.140: OK: 2012122401 2a01:111:200f:1::1:1: OK: 2012122401

One of the points where my check-soa is an

improvment over the original is that it issues DNS requests in

parallel. So, the waiting time will depend only on the slowest server,

not on the sum of all servers. Let's try it on

Sri Lanka TLD:

% time check-soa -i lk c.nic.lk. 203.143.29.3: OK: 2012122601 (268 ms) 2405:5400:3:1:203:143:29:3: OK: 2012122601 (274 ms) d.nic.lk. 123.231.6.18: OK: 2012122601 (133 ms) l.nic.lk. 192.248.8.17: OK: 2012122601 (189 ms) m.nic.lk. 202.129.235.229: OK: 2012122601 (290 ms) ns1.ac.lk. 192.248.1.162: OK: 2012122601 (179 ms) 2401:dd00:1::162: OK: 2012122601 (300 ms) p.nic.lk. 204.61.216.27: OK: 2012122601 (4 ms) 2001:500:14:6027:ad::1: OK: 2012122601 (5 ms) pendragon.cs.purdue.edu. 128.10.2.5: OK: 2012122601 (142 ms) ripe.nic.lk. 2001:67c:e0::88: OK: 2012122601 (16 ms) 193.0.9.88: OK: 2012122601 (17 ms) t.nic.lk. 203.94.66.129: OK: 2012122601 (622 ms) check-soa -i lk 0.02s user 0.00s system 3% cpu 0.637 total

The elapsed time was only 637 ms (a bit more than the slowest server,

which was at 622), not the sum of all the delays. Parallelism is

specially important when some servers timeout. By default,

check-soa tries three times, with a waiting time

of 1.5 second (other programs have a default of 5 seconds, which is

extremely long: a DNS reply never comes back after 5 seconds!). So:

% time check-soa -i ml ciwara.sotelma.ml. 217.64.97.50: ERROR: Timeout djamako.nic.ml. 217.64.105.136: OK: 2012122100 (115 ms) dogon.sotelma.ml. 217.64.98.75: OK: 2012122100 (109 ms) ml.cctld.authdns.ripe.net. 193.0.9.95: ERROR: REFUSED (13 ms) 2001:67c:e0::95: ERROR: REFUSED (14 ms) ns-ext.isc.org. 2001:4f8:0:2::13: OK: 2012122100 (173 ms) 204.152.184.64: OK: 2012122100 (183 ms) yeleen.nic.ml. 217.64.100.112: OK: 2012122100 (124 ms) check-soa -i ml 0.01s user 0.00s system 0% cpu 4.518 total

The elapsed time, 4.518 seconds, is mostly because of the timeout (and

retries) on ciwara.sotelma.ml.

By default, check-soa retrieves the list of name servers to query

from the local resolver. If the domain is so broken that it cannot

even handle these requests, or simply if you want to test with

different name servers (for instance because the zone is not yet

delegated), you can use the -ns option to

indicate explicitely the name servers:

% check-soa -ns "a.gtld-servers.net b.gtld-servers.net" com a.gtld-servers.net. 2001:503:a83e::2:30: OK: 1416671393 192.5.6.30: OK: 1416671393 b.gtld-servers.net. 2001:503:231d::2:30: OK: 1416671393 192.33.14.30: OK: 1416671393

Are you convinced? Do you want to install it? Then, get the source code

and follow the instructions in the file

README.md. Do note that my

check-soa is written in Go

so you'll need a Go compiler. Also, it depends on the excellent godns library so you need

to install it first.

If you read the source code, there is nothing extraordinary: parallelism is very simple in Go, thanks to the goroutines so there is little extra effort to make a parallel program (one of the great strengths of Go).

I also wrote a Nagios plugin in Go to perform more or less the same tests. But the Nagios plugin does not use parallelism: since it is not an interactive program, it is less important if the elapsed time is longer.

Other versions of check-soa (or check_soa):

- The original source code.

- The one I prefer is written in Python by Alain Thivillon:

soa.py. - A Perl one, in the excellent Net::DNS library and a simpler one, written by Laurent Frigault.

- There is

check_soa.rbin dnsruby.

A recent alternative to check-soa is the

option nssearch of dig:

% dig +nodnssec +nssearch bortzmeyer.fr SOA ns3.bortzmeyer.org. hostmaster.bortzmeyer.org. 2012122602 7200 3600 604800 3600 from server 192.134.7.248 in 1 ms. SOA ns3.bortzmeyer.org. hostmaster.bortzmeyer.org. 2012122602 7200 3600 604800 3600 from server 2001:67c:2219:3::1:4 in 1 ms. SOA ns3.bortzmeyer.org. hostmaster.bortzmeyer.org. 2012122602 7200 3600 604800 3600 from server 217.70.190.232 in 2 ms.

It has several limitations: each server is tested only once, even if

it has multiple IP addresses (which can belong to different physical

machines), if stops immediately for some errors (such as a name server

which has no entry in the DNS), it does not react properly to non-EDNS

name servers like microsoft.com mentioned above, etc.

Thanks to Miek Gieben for godns and for his debugging of my code. Also, check-soa is available as a package in ArchLinux AUR.

L'article seul

Fiche de lecture : Tubes: A journey to the center of the Internet

Auteur(s) du livre : Andrew Blum

Éditeur : Harper Collins

978-0-06-199493-7

Publié en 2012

Première rédaction de cet article le 25 décembre 2012

Contrairement à ce qu'on pourrait croire en prêtant attention aux niaiseries comme le discours sur le « virtuel » ou sur le « cloud », l'Internet n'est pas un concept évaporé. Il s'appuie sur de grosses et lourdes machines, qui sucent beaucoup d'électricité, et qui sont hébergées dans de grands bâtiments industriels. Ceux-ci sont connectés par des liens bien physiques, les ondes radio étant marginales. C'est cet enracinement physique de l'Internet que décrit Andrew Blum. L'auteur vivait autrefois dans l'ignorance de l'endroit où passait son trafic Internet. Il a eu son chemin de Damas lorsqu'un écureuil insolent a eu l'audace de ronger son accès Internet. Blum a alors compris la physicalité du réseau et est parti visiter la planète pour trouver les lieux physiques d'Internet.

(Au passage, ceux qui aiment les écureuils et se demandent pourquoi une si charmante bête est peu aimée des professionnels du réseau doivent lire l'excellent article de Pierre Col.)

Car Blum regrette qu'on ne prête plus attention à cette physicalité : comme le dit Leonard Kleinrock, interrogé par l'auteur sur les lieux des débuts d'Arpanet, « Students no longer take things apart », on ne démonte plus les choses. À défaut de les démonter, Blum les visite. Il se rend dans plusieurs points d'échange et décrit de manière très vivante ces points d'interconnexion où bat le cœur du réseau. Il ne peint pas que l'état physique actuel mais aussi son histoire compliquée et conflictuelle. Le livre contient une passionnante histoire du célèbre MAE-East. Lorsque je travaillais au CNAM, c'était un endroit mythique et lointain où l'Internet, l'interconnexion des réseaux, même entre opérateurs français, se faisait. Dans le livre de Blum, on suit sa difficile naissance, mais aussi celle de son opposé Equinix. (Pendant que je lisais ce chapitre, j'ai appris la naissance d'un des tous derniers points d'échange créés, à Kinshasa, le Kinix.)

Blum visite aussi DE-CIX, AMS-IX, le LINX (contrairement à ce qu'on lit parfois chez des amateurs de sensationnalisme, ces lieux n'ont rien de secret, puisque tout le monde s'y connecte) et suit les réunions de NANOG pour y entendre les mystérieures négociations sur le peering, les exposés des acteurs essayant d'encourager les autres à peerer avec eux, en se vendant et en vendant leurs abonnés comme s'ils étaient une marchandise (« I have eyeballs. If you have content, peer with me. », en utilisant le terme péjoratif de « globes oculaires » pour parler des abonnés, supposés être des consommateurs passifs et bêtes). On croise dans le livre des figures familières de ce genre de réunions comme Sylvie LaPerrière, qui vient de rentrer au Conseil d'Administration d'AMS-IX.

Après les points d'échange, l'auteur se tourne vers les câbles sous-marins, par lesquels passent l'essentiel du trafic international. Ces câbles ne relient pas n'importe quels points. Comme « People go where things are », on s'installe là où il y a déjà quelque chose), la plupart de ces câbles atterrissent aux mêmes endroits où atterrissaient les fils du télégraphe, des lieux comme Porthcurno (un des meilleurs reportages du livre) ou 60 Hudson.

Andrew Blum a même suivi l'atterrissage d'un nouveau câble de Tata, le WACS, au Portugal, encore un passionnant récit.

Ces câbles ne sont pas posés n'importe où : la résilience de l'Internet dépend d'une répartition de ces liens à différents endroits, pour ne pas risquer qu'ils soient victimes du même problème, comme la fameuse panne de Luçon en 2006 où un tremblement de terre avait coupé plusieurs câbles d'un coup.

(Au passage, si vous aimez les histoires de pose de câbles sous-marins, vous pouvez aussi relire l'excellent reportage de Neal Stephenson.)

Après les points d'échange où se connectent les opérateurs, et les câbles qui les relient, où se trouve physiquement l'Internet ? Bien sûr dans les grands data centers où sont hébergées les données. C'est la troisième partie du livre. L'auteur revient sur le scandale de The Dalles, où Google était arrivé en terrain conquis, imposant même au maire de ne pas informer son propre conseil municipal sur les projets en cours. Et, alors que visiter les points d'échange et les stations d'atterrissage des câbles n'avait posé aucun problème au journaliste, il s'est par contre heurté à un mur en tentant de visiter un data center de Google : il n'a pas dépassé la cafétéria, où les officiels lui ont servi un excellent saumon bio et un très indigeste discours corporate comme quoi Google était formidable, « Hein, John, dit au monsieur pourquoi c'est si formidable de travailler pour Google ». Comme le note l'auteur, « Google sait tout de nous, mais nous ne pouvons rien savoir de Google ».

Très peu d'erreurs dans ce livre, qui a été soigneusement étudié et bien vérifié. La plus amusante : ARIN qualifié, p. 121, de Internet governing body. (Le RIPE-NCC, bien plus ancien, n'est guère mentionné.)

L'article seul

RFC 6821: Improving Peer Selection in Peer-to-peer Applications: Myths vs. Reality

Date de publication du RFC : Décembre 2012

Auteur(s) du RFC : E. Marocco, A. Fusco (Telecom Italia), I. Rimac, V. Gurbani (Bell Labs, Alcatel-Lucent)

Pour information

Réalisé dans le cadre du groupe de recherche IRTF PeerToPeerResearchGroup

Première rédaction de cet article le 22 décembre 2012

Le trafic du pair-à-pair peut, on le sait, représenter une bonne part de l'activité d'un réseau, malgré les efforts de l'industrie du divertissement pour diaboliser cette technique. Il y a donc depuis plusieurs années de gros efforts de recherche pour optimiser ce trafic, notammment via l'amélioration de la sélection des pairs. Si je veux télécharger la saison 1 de Being human, et que trois pairs ont les données, auquel demander ? Le bon sens répond « au plus proche ». Mais le concept de « plus proche » est plus flou qu'il n'y parait, et, de toute façon, le logiciel pair-à-pair installé sur ma machine n'a pas forcément accès à toutes les informations nécessaires pour déterminer « le plus proche ». Il existe plusieurs solutions pour résoudre ce problème, mais notre RFC se penche plutôt sur le méta-problème : la sélection des pairs améliore-t-elle les choses ?

Tellement de choses ont été dites à ce sujet que l'ingénieur ou l'étudiant débutant qui se penche sur l'optimisation du pair-à-pair peut avoir une impression de grande confusion. Ce RFC choisit donc l'approche « retours aux faits ». Parmi toute la littérature scientifique et technique existante, peut-on trancher sur la question de l'intérêt de la sélection des pairs ?

Je préviens tout de suite que le titre de ce RFC, inutilement sensationnaliste, ne correspond pas à son contenu : le RFC ne dynamite pas de mythes, il examine un certain nombre de questions posées par la sélection des pairs et, pour chacune, en se basant sur des mesures ou des simulations déjà effectuées et publiées, fait une synthèse de leurs conclusions.

A priori, l'intérêt de la sélection est grand : comme les machines, dans un réseau pair-à-pair, ne connaissent pas la topologie sous-jacente (elles ne savent pas si les pairs sont proches ou lointains, s'ils sont joignables par des liens de peering gratuits ou par du transit payant, etc), elles risquent de ne pas choisir le meilleur pair. Une des conséquences fâcheuses sera l'utilisation d'inter-connexions lointaines, au lieu de rester dans le réseau du FAI. Il est donc logique que cette idée de sélection « intelligente » des pairs ait fait l'objet de nombreux travaux (résumés dans le RFC 6029 ; sinon, voir les articles « Can ISPs and P2P systems co-operate for improved performance? » d'Aggarwal, V., Feldmann, A., et C. Scheidler, ou « Taming the Torrent: A practical approach to reducing cross-ISP traffic in P2P systems » de Choffnes, D. et F. Bustamante, ou encore « P4P: Explicit Communications for Cooperative Control Between P2P and Network Providers » de Xie, H., Yang, Y., Krishnamurthy, A., Liu, Y., et A. Silberschatz) et qu'un groupe de travail de l'IETF, ALTO, travaille entièrement sur ce sujet (voir ses RFC 5693 et RFC 6708). (À noter que j'avais fait un exposé sur ces techniques en 2010.) L'évaluation de ces techniques n'est pas évidente, notamment de leur passage à l'échelle lorsque le réseau comprend des dizaines de millions de pairs.

Notre RFC suit le schéma suivant pour synthétiser la littérature existante :

- Décrire une croyance (un mythe, dit le RFC, terme très exagéré),

- Lister les faits (études, mesures, simulations, etc) disponibles,

- Discuter ces données,

- Conclure à la véracité ou à la fausseté de la croyance.

Naturellement, cette synthèse n'est valable qu'aujourd'hui : les progrès de la science pourront changer les conclusions. Ah et, sinon, question terminologie, en l'absence d'une norme unique du pair-à-pair, ce RFC utilise largement le vocabulaire de BitTorrent (section 2), comme le terme d'essaim pour désigner un groupe de pairs ayant les données convoitées.

Place maintenant aux croyances et à leur évaluation. La première : « la sélection des pairs permettra de diminuer le trafic entre domaines ». Les différents essais ou simulations montrent des réductions allant de 20 à 80 % (la variation importante donne une idée de la difficulté à estimer cette réduction). 70 % pour la simulation de Xie, H., Yang, Y., Krishnamurthy, A., Liu, Y., et A. Silberschatz déjà citée. 34 % en sortie et 80 % en entrée pour les mesures du RFC 5632. Et jusqu'à 99,5 % si le trafic est fortement localisé (beaucoup de pairs dans le même domaine) selon « Pushing BitTorrent Locality to the Limit » de Stevens Le Blond, Arnaud Legout et Walid Dabbous.

Bref, cette croyance est tout à fait justifiée (comme la plupart de celles citées par le RFC). On peut vraiment espérer une réduction du trafic entre opérateurs.

Cette réduction profite aux opérateurs, qui voient baisser leur facture d'interconnexion. Une autre croyance fait espérer des gains pour les utilisateurs : « la sélection des pairs se traduira par une amélioration des performances », en clair, on attendra moins longtemps pour charger la dernière ISO d'Ubuntu.

Les simulations de Xie, H., Yang, Y., Krishnamurthy, A., Liu, Y., et A. Silberschatz montrent une diminution du temps de transfert de 10 à 23 %. Celles de « Applicability and Limitations of Locality-Awareness in BitTorrent File-Sharing » par Seetharaman, S., Hilt, V., Rimac, I., et M. Ammar (article que je n'ai pas réussi à trouver en ligne et qui ne semble pas avoir été publié « officiellement ») montraient que le gain n'est pas systématique. Les mesures du RFC 5632 indiquent une augmentation du débit de 13 à 85 %. L'expérience de Choffnes, D. et F. Bustamante déjà citée a vu 31 % de gain de débit en moyenne (mais une perte dans certains cas).

La conclusion est donc plutôt « ça dépend ». En général, il y a une amélioration mais dans certains cas (capacité du lien montant faible, peu de pairs disponibles à proximité), on peut voir une dégradation. Donc, la croyance est probablement justifiée mais pas dans tous les cas.

Et l'occupation du lien réseau montant ? Cela pourrait être un effet négatif d'une meilleure sélection des pairs. Ils sont plus proches, donc on envoie plus vite les données, saturant le canal montant, souvent très petit sur les liens asymétriques comme l'ADSL ou DOCSIS. Cette crainte est-elle justifiée ?

Les mesures du RFC 5632 ne montrent pas un tel effet. Théoriquement, cela serait pourtant possible (si la sélection des pairs menait à choisir une machine mal connectée mais proche plutôt qu'une machine lointaine et ayant de fortes capacités réseau, la machine mal connectée verrait son lien montant plus utilisé). Mais, en pratique, cela ne semble pas le cas.

Autre croyance parfois entendue : la sélection des pairs va avoir une influence sur les accords de peering. Ceux-ci sont souvent fondés sur le volume de trafic échangé. Si la sélection des pairs améliore la localité, le trafic entre opérateurs va baisser, le faisant passer en dessous du seuil qu'exigent certains opérateurs pour peerer avec eux. Mais, sur ce point, on ne dispose pas de mesures ou de simulations. On ne peut faire pour l'instant qu'une analyse théorique.

Par exemple, si les deux opérateurs ont une base d'utilisateurs très différente (mettons qu'un opérateur a beaucoup de clients offrant du contenu et l'autre pas du tout), non seulement le trafic entre eux va baisser, mais il peut baisser nettement plus dans une direction que dans l'autre, remettant en cause un accord de peering fondé sur la réciprocité.

Curieusement, le RFC affirme que, si les opérateurs sont très similaires (même base d'utilisateurs, mêmes technologies d'accès), il n'y aura sans doute pas beaucoup de changement. Pourtant, comme indiqué plus haut, la seule baisse du trafic entre eux, même symétrique, peut changer les conditions du peering.

Le RFC rappele que des opérateurs ont déjà tenté d'injecter des paquets vers un autre opérateur, pour obtenir artificiellement des chiffres élevés de trafic, avant de pouvoir demander un peering (« The art of Peering: The peering playbook » de Norton). Ce n'est pas très subtil car ce trafic purement unidirectionnel apparait vite comme suspect. En revanche, avec des techniques de sélection des pairs, le même FAI peu scrupuleux pourrait faire mieux, en redirigeant systématiquement ses utilisateurs vers l'opérateur avec qui il espère négocier un accord de peering, créant ainsi un trafic nettement plus réaliste.

En conclusion (fondée sur un raisonnement purement théorique, contrairement à la grande majorité des croyances étudiées dans ce RFC), il est probable que la sélection des pairs amène à changer les accords de peering.

Et sur le transit, y aura-t-il un impact ? Là aussi, on peut imaginer des transitaires peu scrupuleux qui, en utilisant les techniques de sélection de pairs comme ALTO, redirigeront le trafic vers des clients payants, plutôt que vers des opérateurs pairs gratuits. Là encore, on ne dispose pas d'études à ce sujet. Mais, vue l'importance de la question pour le monde des opérateurs, le RFC recommande que l'on se penche sur la question. Des cas comme Sprint contre Cogent ou Cogent contre AOL illustrent bien l'extrême sensibilité du problème.

Un effet de bord négatif d'une bonne sélection des pairs avait été envisagé dans l'article Stevens Le Blond, Arnaud Legout et Walid Dabbous ci-dessus (mais les mesures faites ne montraient pas cet effet). Si la sélection marche trop bien, l'essaim de pairs va se fragmenter en plusieurs essaims, un par FAI, avec peu de communications entre eux, ce qui annulerait une partie de l'intérêt du pair-à-pair. En effet, les simulations de Seetharaman, S., Hilt, V., Rimac, I., et M. Ammar ont montré que cela pouvait se produire.

Le RFC conclut que l'effet dépend de l'algorithme utilisé. Si BitTorrent semble assez résistant à ce problème, comme montré par les mesures de Stevens Le Blond, Arnaud Legout et Walid Dabbous, d'autres algorithmes peuvent avoir le problème. Et que la croyance peut donc être justifiée dans certains cas. Attention donc, si vous concevez un algorithme de pair-à-pair à ne pas mettre tous vos œufs dans le même panier en ne sélectionnant que des pairs très proches.

Dernière croyance étudiée, celle que des caches P2P chez les FAI, combinés avec la sélection des pairs, va améliorer les choses. Un problème classique de tous les caches réseau est de les trouver, et de ne les utiliser que s'ils apportent réellement un gain. Avec la sélection des pairs, le problème est théoriquement résolu : le cache est un pair comme un autre et est sélectionné s'il est « plus proche ».

Une étude chez un FAI a montré (« Are file swapping networks cacheable? Characterizing p2p traffic » de Nathaniel Leibowitz, Aviv Bergman, Roy Ben-Shaul et Aviv Shavit) que le cache pouvait potentiellement gérer 67 % du trafic pair-à-pair. Cette croyance est donc plausible.

L'article seul

RFC 6781: DNSSEC Operational Practices, Version 2

Date de publication du RFC : Décembre 2012

Auteur(s) du RFC : O. Kolkman (NLnet Labs), W. Mekking (NLnet Labs), R. Gieben (SIDN Labs)

Pour information

Réalisé dans le cadre du groupe de travail IETF dnsop

Première rédaction de cet article le 22 décembre 2012

Comme avec toute technique fondée sur la cryptographie, le protocole DNSSEC impose, non seulement des bons algorithmes et une mise en œuvre correcte, mais surtout des procédures rigoureuses et soigneusement exécutées. C'est le but de ce RFC, qui remplace le RFC 4641 et qui explique tout ce à quoi doivent s'attendre les registres et autres administrateurs de zones DNS, grandes ou petites, qui déploieraient DNSSEC. (Le cas des serveurs DNS récursifs, par exemple les résolveurs d'un FAI, n'est pas étudié.)

Notre RFC rappelle donc des concepts de base du

DNS (notamment le fait que la réjuvénation des

modifications n'est pas instantanée) puis rappelle les différentes

clés (cf. section 1.1 pour une définition précise de clé) utilisées par DNSSEC et leurs caractéristiques souhaitables

(longueur, période maximale pendant laquelle on les utilise, lieu de

stockages, etc). Tout n'est pas encore bien connu dans ce

domaine. Certes, la racine est signée depuis

juillet 2010, ainsi que plus de 80

TLD mais, au niveau en dessous du TLD, peu de

zones sont signées (dans les 1 % de

.fr, par exemple) et

l'expérience opérationnelle peut donc encore être améliorée.

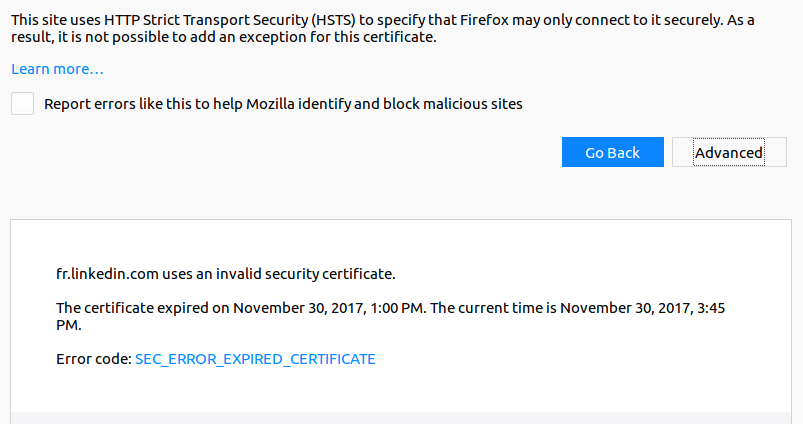

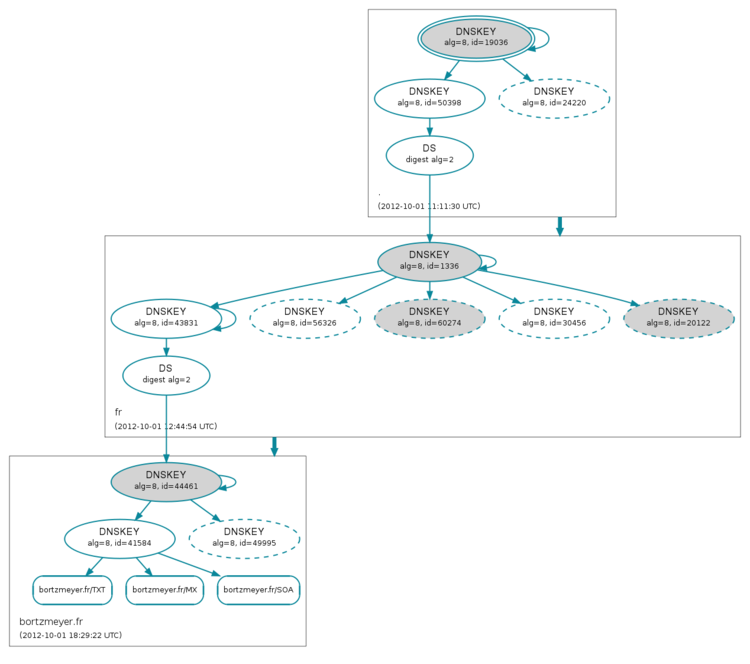

Il explique ensuite les considérations temporelles (DNSSEC utilise le temps et nécessite des horloges bien synchronisées, par exemple par NTP). Le DNS étant hiérarchique, il faut veiller, lors de toutes les manipulations, à bien rester synchronisé avec le gérant de la zone parente, dont les enregistrements de type DS (delegation signer) pointeront vers notre clé. Le but est, qu'à tout moment, une chaîne de confiance intacte aille de la clé de confiance jusqu'aux enregistrements du domaine. Si un lien de cette chaîne casse, le domaine sera marqué comme bogus (RFC 4033, section 5) et rejeté par les résolveurs validants.

Enfin, le RFC étudie le rollover, le remplacement d'une clé. Les clés ne pouvant pas raisonnablement être utilisées éternellement, il faut prévoir à l'avance les remplacements périodiques et aussi, hélas les remplacements en urgence en cas de compromission. Il faut apporter beaucoup de soin à ce remplacement, si on veut éviter que, pendant une certaine période, les données publiées dans le DNS soient invalides et donc rejetées par un résolveur DNS paranoïaque (il faut publier la nouvelle clé suffisamment à l'avance pour qu'elle soit présente partout ou bien signer tous les enregistrements avec les deux clés, l'ancienne et la nouvelle). Mon article à la conférence SATIN en 2011 avait montré que c'était loin d'être le cas : les erreurs sont fréquentes, même pour les grandes zones sérieuses.

Bref, pour un gérant de zone DNS, déployer DNSSEC, ce n'est pas uniquement signer la zone : c'est aussi mettre en place des procédures de sécurité, analogues à celle d'une autorité de certification.

Maintenant, avec la section 3, voyons les détails pratiques. D'abord, la génération et le stockage des clés cryptographiques. D'abord, un message d'espoir : en lisant ce RFC, on peut avoir l'impression d'un ensemble de tâches très compliquées, impossible à réaliser correctement. Heureusement, il existe déjà des logiciels qui, en automatisant la plupart de ces tâches, rendent les choses bien plus faciles. J'utilise pour cela OpenDNSSEC.

D'abord, avant de se lancer, il faut faire certains choix technico-politiques :

- Est-ce qu'on n'utilise qu'un type de clé ou bien est-ce qu'on sépare KSK (Key Signing Key) et ZSK (Zone Signing Key) ? Contrairement à ce qu'on lit souvent, la dichotomie entre une KSK et une ZSK n'a rien d'obligatoire, et elle complique les choses.

- Est-ce que les KSK vont être configurés par certains comme clés de confiance, à partir desquels on valide ? Cela permet d'être indépendant des autres acteurs comme la racine mais cela augmente les responsabilités.

- Quels sont les délais pertinents, par exemple le champ

Expiredu SOA, le temps de réaction souhaité en cas de problème ? Il faut aussi se demander siNOTIFY(RFC 1996) marche bien (ou si on ne peut compter que sur le paramètreRefreshde l'enregistrement SOA) et si on utiliseIXFR(RFC 1995) ouAXFR, - Quels sont les choix cryptographiques (par exemple, concernant la longueur des clés RSA) ?

Une fois ces choix faits, on pourra configurer le résultat (dans

OpenDNSSEC, fichier /etc/opendnssec/kasp.xml). Mais que choisir ?

Pour le choix entre une séparation KSK/ZSK et une clé unique, le choix est purement un problème opérationnel du côté du gestionnaire de zone. Les résolveurs ne feront pas de différence.

Un problème à garder en tête pour le stockage des clés est le risque de compromission de la clé (vol du disque sur lequel se trouve la partie privée de la clé, par exemple). Si la clé privée est sur le disque d'une machine connectée à l'Internet, le risque est plus élevé que s'il est sur une machine déconnectée et enfermée dans un coffre-fort. Encore mieux, pour les plus riches, l'usage des HSM permet d'être raisonnablement sûr qu'il n'y aura pas de vol de la clé. D'un autre côté, pour signer des enregistrements, une clé sur une machine non-connectée est certainement moins pratique. Une des façons de résoudre le dilemne est de séparer KSK et ZSK : on met la KSK en sécurité dans un endroit bien protégé (elle ne sert qu'à signer la ZSK, qui ne change pas tous les jours) et on fait les signatures des enregistrements de la zone avec la ZSK. En cas de compromission de la ZSK, son remplacement est relativement simple, puisqu'il est entièrement interne à la zone, il ne nécessite pas d'interaction avec la zone parente. (C'est ainsi, par exemple, que fonctionne la racine.)

Comme toujours en sécurité,il y a un fort risque de blinder la porte en oubliant la fenêtre : il ne sert pas à grand'chose de protéger la KSK avec des précautions de niveau militaire si les données de la zone, celles qu'on va signer, peuvent être facilement modifiées par un attaquant (encore que le RFC oublie de dire que la possession de la clé privée permette de générer des enregistrements mensongers sans que le registre s'en aperçoive). De même, le HSM empêche certes le méchant de copier la clé privée, mais il ne l'empêche pas de signer : si le pirate prend le contrôle de la machine connectée au HSM, il peut faire signer à ce dernier ce qu'il veut. Bref, il n'y a pas de solution miracle en matière de sécurité.

Séparer KSK et ZSK permet donc plus de souplesse dans la gestion de la sécurité. Mais cela rend les choses plus complexes. Si les clés sont gérés automatiquement par un outil comme OpenDNSSEC, ce n'est pas trop un problème. Sinon, il vaut peut-être mieux n'avoir qu'une clé.

Une question qui agite les milieux DNSSEC depuis de nombreuses années est celle du remplacement (rollover) des clés. Il y a deux écoles :

- Celle qui dit que les remplacements doivent être systématiques et fréquents, pour qu'ils deviennent de la routine ; elle se sépare en deux sous-écoles, une qui favorise les remplacements périodiques et une qui préfère les faire au hasard,

- Et l'école qui dit que les remplacements ne doivent se faire que s'il y a une bonne raison, par exemple une forte suspicion que la clé privée a été copiée.

Notre RFC note qu'il n'y a pas consensus sur cette question. Il note

qu'un facteur important est « est-ce que la clé est utilisée comme

clé de confiance quelque part ? », c'est-à-dire est-ce que des gens

l'ont configuré dans leur résolveur validant (directives trusted-keys ou managed-keys de

BIND et trust-anchor ou trust-anchor-file de

Unbound) ? Cela peut se faire, par exemple pour

éviter de dépendre de la hiérarchie du DNS (on peut imaginer une clé

DNSSEC de gouv.fr installée dans les résolveurs

des ministères pour être sûr de ne pas être affectés par des problèmes à

l'AFNIC ou à la racine). Notez que cela peut arriver sans le

consentement du gérant de la zone. Si ce dernier publie un DPS

(DNSSEC Practice Statement) disant en gros

caractères « n'utilisez pas notre KSK comme clé de confiance, ne vous

fiez qu'au DS de la zone parente », alors, on peut tenir pour acquis

qu'il y aura peu de cas où la KSK sera installée en dur dans les

résolveurs. Autrement, le remplacement devient bien plus compliqué car

il faut prévenir tous les gens qui ont configuré cette clé de

confiance. Certains ne seront pas joignables ou ne réagiront pas et il

faudra donc prendre le risque de casser leur accès DNSSEC. Ainsi, pour la racine (qui ne peut pas compter sur

l'enregistrement DS de la zone parente) qui est forcément clé de

confiance, on peut penser qu'il n'y aura jamais de remplacement de la

KSK originelle, la 19036, sauf en cas de compromission : cela nécessiterait de changer

trop de résolveurs.

Notez qu'il existe un mécanisme pour mettre à jour les clés de

confiance, décrit dans le RFC 5011. Comme il

n'est jamais sûr que tous les « clients » le mettent en œuvre,

il est difficile de savoir si on peut compter dessus (dans Unbound,

trust-anchor-file: "/etc/unbound/root.key"

installe une clé de confiance statique et auto-trust-anchor-file: "/var/lib/unbound/root.key"

- notez le auto- devant - installe

une clé qui pourra être mise à jour par les procédures du RFC 5011). Ces procédures n'ont jamais été testées

pour la racine.

Si on sépare KSK et ZSK, c'est normalement le bit SEP

(Secure Entry Point, cf. RFC 3757) qui les distingue (dans le cas le plus courant, la ZSK

aura un champ Flags de 256 et la KSK de 257 à

cause du bit SEP). Ce bit n'est pas utilisé par les validateurs mais

certains outils s'en servent pour trouver la KSK (par exemple le

dnssec-signzone de BIND). Si on n'a qu'une seule

clé, elle sert de KSK et doit donc avoir le bit SEP (autrement, le dnssec-signzone de BIND vous dira dnssec-signzone: fatal: No self signed KSK's found). Notez que

certains outils ne vous laisseront pas facilement n'utiliser qu'une

clé. Par exemple, avec dnssec-signzone, vous aurez le message dnssec-signzone: fatal: No non-KSK

DNSKEY found; supply a ZSK or use '-z'. et vous devrez

utiliser l'option indiquée pour signer quand même.

Un peu de cryptographie, maintenant. La durée de vie raisonnable d'une clé dépend de sa longueur. Le RFC suggère de décider d'une durée de vie, en tenant compte des contraintes opérationnelles, et d'en déduire la longueur. Une KSK qui a des enregistrements DS dans sa zone parente peut durer vingt ans sans problème, sauf si on désire tester régulièrement les procédures de remplacement ou sauf si la clé privée est compromise. Si on veut la remplacer régulièrement, une durée raisonnable proposée par le RFC est d'un an.

Quel algorithme cryptographique choisir ? Les quatre standardisés à l'heure actuelle (le RFC en cite trois mais ECDSA est apparu depuis), RSA, DSA et GOST sont bien connus et spécifiés et considérés comme fiables. En partie pour des raisons de performance, le RFC suggère la combinaison RSA/SHA-256 comme l'algorithme préféré (RFC 5702) et RSA/SHA-1 sinon.

Les algorithmes fondés sur les courbes elliptiques (GOST - RFC 5933 - et ECDSA - RFC 6605) ont des avantages importants sur RSA, notamment les clés et signatures plus petites. Mais très peu de résolveurs validant les gèrent et signer une zone uniquement avec ces algorithmes serait donc peu utile. D'autre part, même si le RFC ne le dit qu'en passant, les problèmes de brevet sont bien plus nombreux que pour RSA.

Si on a choisi RSA, il faut se décider pour une longueur de clé, suffisante pour résister à la cryptanalyse pendant la durée de vie de la clé (le RFC 3766 contient des calculs intéressants sur la solidité des clés). Comme le note le RFC, en dépit d'un FUD important, personne n'a encore annoncé la cryptanalyse d'une clé RSA de 1024 bits (le record publié est aux alentours de 700 bits). Et, le jour où cela arrivera, ce ne sera pas la fin de RSA mais la fin d'une seule clé. Bien sûr, la cryptanalyse progresse (et, le RFC oublie ce point, les meilleurs résultats ne sont pas forcément publiés) mais le RFC estime que les clés de 1024 bit sont encore sûres pour dix ans.

Néanmoins, utiliser des clés plus grandes est raisonnable si on veut une très longue durée de vie ou bien si on estime que le remplacement de la clé sera difficile (ce qui est certainement le cas de la clé de la racine). Pour ces cas, une clé de 2048 bits est donc utile. Attention, ce n'est pas gratuit, notamment la vérification est quatre fois plus lente et la signature huit fois moins rapide.

Certains férus de cryptographie peuvent tiquer à la pensée de n'utiliser que 1024 bits. Mais l'argument massue du RFC est celui de l'équilibre : on ne fait pas du DNSSEC pour le plaisir de la cryptographie. On le fait pour protéger quelque chose, par exemple un site Web de banque en ligne. Et ce genre de sites est en général protégé par TLS avec des clés qui ne sont souvent pas plus longues. Si un attaquant peut casser une clé de 1024 bits, il peut s'attaquer à TLS aussi bien qu'à DNSSEC. Avec des clés de 2048 bits, on blinde fortement la porte... alors que la fenêtre du rez-de-chaussée ne l'est pas toujours. Bref, si un brusque progrès de la cryptanalyse permet de casser ces clés de 1024 bits plus tôt que les dix ans indiqués, cela fera du bruit et cassera bien d'autres choses que DNSSEC.

Notons que, contrairement à son prédécesseur RFC 4641, notre RFC ne fait plus dépendre la solidité d'une clé du fait qu'elle soit largement utilisée ou pas. La cryptographie a évolué depuis le RFC 4641.

Où stocker ensuite ces clés ? Idéalement, sur une machine sécurisée et non connectée au réseau. On apporte les données sur cette machine, on signe et on repart avec les données signées pour les apporter au serveur de noms. C'est très sûr mais cela ne peut pas marcher si on utilise les mises à jour dynamiques du DNS (RFC 3007). Dans ce cas, il faut bien avoir la clé privée sur le serveur de noms (on parle de online key). C'est donc moins sûr et le RFC suggère, dans ce cas, que le serveur maître ne soit pas directement accessible de l'Internet (technique du hidden master, où le vrai maître n'est pas dans les enregistrements NS de la zone). Notez qu'une des motivations pour la séparation KSK/ZSK vient de là : avoir une KSK peu utilisée et dont la clé privée est stockéee de manière très sûre et une ZSK en ligne, plus vulnérable mais plus facile à changer.

Comme toujours en matière de sécurité, ces bons avis doivent être mis en rapport avec les contraintes opérationnelles et économiques. Ainsi, on peut sans doute améliorer la sécurité des clés en les gardant dans un HSM. Mais ces engins sont chers et pas pratiques pour les opérations quotidiennes.

Et la génération des clés ? C'est un aspect souvent oublié de la

sécurité cryptographique mais il est pourtant essentiel. La clé doit

être vraiment imprévisible par un attaquant et pour cela elle doit

être générée en suivant les recommandations du RFC 4086 et de NIST-SP-800-90A, « Recommendation for Random

Number Generation Using Deterministic Random Bit

Generators ». Par exemple, avec les outils de génération de

clés de BIND (dnssec-keygen), il ne faut

pas utiliser l'option -r

/dev/urandom en production, car elle n'utilise qu'un

générateur pseudo-aléatoire. (Les HSM disposent

tous d'un générateur correct.)

À noter que la version précédente de ce document, le RFC 4641 faisait une différence entre les zones DNS

selon leur place dans la hiérarchie (plus ou moins haute). Cette

distinction a disparu ici et les mêmes règles de sécurité s'appliquent

à toutes. L'une des raisons de ce choix est qu'on ne peut pas

facilement déterminer quelles zones sont importantes pour un attaquant

(grossebanque.com est peut-être plus importante

que le TLD

.td, même si ce dernier

est placé plus haut dans la hiérarchie). Cela n'empêche évidemment pas

chaque gérant de zone de devoir déterminer si sa zone est critique ou

pas, avant d'adapter les mesures de sécurité en conséquence.

La section 4 de notre RFC est ensuite consacrée au gros morceau de la gestion opérationnelle de DNSSEC : les remplacements de clés (key rollovers). Qu'on choisisse de faire des remplacements réguliers, pour qu'ils deviennent une simple routine, ou qu'on choisisse de n'en faire que lors d'évenements exceptionnels (comme une copie illégale de la clé), les remplacements sont une réalité et il faut s'y préparer. Par exemple, même si on décide de ne pas en faire systématiquement, il faut s'entrainer (et tester ses procédures) avec une zone de test. L'opération est délicate en raison de l'existence des caches DNS, qui vont garder la vieille information un certain temps. Personnellement, je déconseille fortement de faire les remplacements à la main : le risque d'erreur est bien trop grand. Il faut plutôt automatiser le processus, et avec un logiciel soigneusement débogué. L'expérience (mon article à la conférence SATIN en 2011) montre que les erreurs sont, elles aussi, une réalité.

Si on a décidé d'avoir deux clés, ZSK et KSK, leurs remplacements sont indépendants. Les ZSK sont les plus simples car elles peuvent être remplacées sans interaction avec la zone parente (pas d'échange d'enregistrements DS). Le RFC explique ensuite (en grand détail : je n'en donne qu'un court résumé ici) les deux méthodes connues pour remplacer une ZSK :

- la pré-publication de la future clé,

- et la double signature.

Dans le premier cas, on génére la nouvelle ZSK, on la publie (sans

qu'elle signe quoi que ce soit) puis, lorsque le nouvel ensemble

DNSKEY est dans tous les caches, on utilise la

nouvelle ZSK pour signer. Une fois que les signatures faites avec

l'ancienne clé ont disparu des caches, on arrête de publier l'ancienne

clé. Le remplacement est terminé. Cette description très sommaire de

l'algorithme suffit déjà, je crois, à montrer qu'il vaut mieux ne pas

le faire à la main.

Quant à la double signature (plus rare, en pratique), elle consiste à signer tout de suite avec la nouvelle clé, tout en continuant à signer avec l'ancienne, pour les caches ayant seulement l'ancienne clé.

La section 4.1.1.3 résume les avantages et inconvénients de chaque méthode. La pré-publication nécessite davantage d'étapes (ce qui est grave si on la fait à la main, et moins si on a tout automatisé). La double signature est plus coûteuse puisque la zone sera, pendant la période transitoire, bien plus grosse (les signatures forment l'essentiel de la taille d'une zone signée). Dans les deux cas, comme il n'y a pas besoin d'interagir avec la zone parente, le processus peut être entièrement automatisé et c'est bien ce que fait, par exemple, OpenDNSSEC.

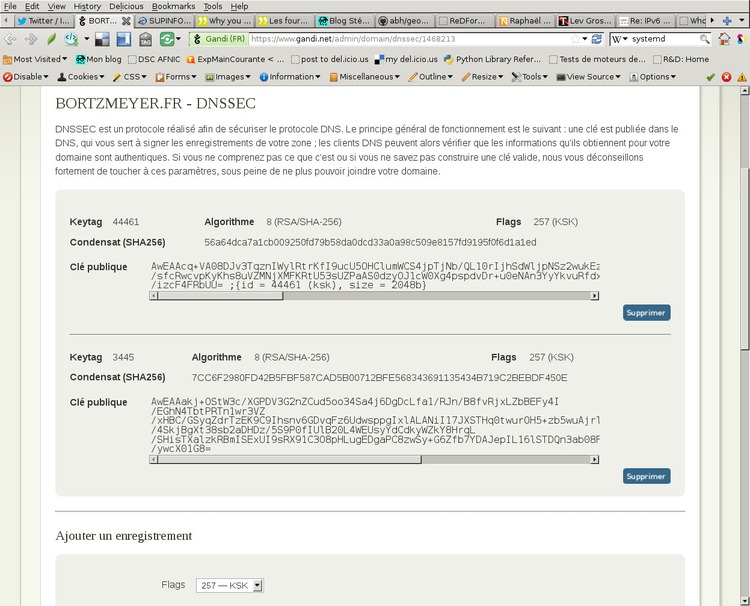

Et pour remplacer une KSK ? La double signature devient alors plus

intéressante, puisque la KSK ne signe pas toute la zone, seulement

l'ensemble d'enregistrements DNSKEY. Les

problèmes de taille ne se posent donc pas. Par rapport au remplacement

d'une ZSK, la grosse différence est l'interaction avec la zone

parente. Il n'existe pas d'API standard pour le

faire. Les bureaux d'enregistrement (BE)

utilisent en général EPP - RFC 5910 - avec le registre mais

le gestionnaire de la zone, avec son BE, a typiquement une interface

Web, ou bien une API non-standard, par exemple à base de

REST (cf. aussi la section 4.3.2). L'opération nécessite donc souvent une

intervention manuelle comme décrit dans mon

article sur un exemple avec OpenDNSSEC.

Et si on a une clé unique ? Le cas est proche de celui d'un remplacement de KSK et le RFC recommande la double-signature, car c'est la solution la plus simple (et, si on n'utilise qu'une clé, c'est qu'on aime la simplicité).

La section 4.2 couvre le cas des préparatifs pour un remplacement d'urgence. On arrive le lundi matin au bureau, le coffre-fort est grand ouvert et la clé USB qui stockait la clé privée a disparu (une variante moins gênante est celle où la clé privée est détruite, mais pas copiée, par exemple en raison d'un incendie). Il faut alors remplacer cette clé et c'est bien plus facile si on a planifié avant. Notez qu'il y a toujours un compromis ici : si on supprime immédiatement l'ancienne clé, désormais compromise, une partie des résolveurs (ceux qui ont les anciennes signatures, mais pas l'ancienne clé) dans leurs caches considéreront la zone comme invalide. Mais, si on continue à diffuser l'ancienne clé, on augmente la durée pendant laquelle le voleur pourra injecter des informations mensongères. Il existe une méthode intermédiaire, faire retirer l'enregistrement DS par la zone parente. Selon les TTL en jeu, cela peut permettre de diminuer la durée du problème. Comme on le voit, il vaut mieux faire les calculs, l'analyse et le choix de la meilleure méthode avant le fatal lundi matin...

Une solution possible est d'utiliser des Standby keys, qui seront publiées (et donc dans tous les caches) mais pas utilisées pour signer, et dont la partie privée sera gardée à un endroit différent.

Le problème est évidemment plus grave si la clé en question avait

été configurée par certains comme clé de confiance dans leurs

résolveurs. Il faut alors prévenir tout le monde de la compromission,

par un message (authentifié) envoyé à plusieurs endroits, pour

maximiser les chances de toucher tout le monde. Si la clé de la racine

(ou d'un grand TLD comme .net)

était compromise, on verrait sans doute l'annonce sur dns-operations, NANOG,

Twitter, etc. Outre l'authentification de

l'annonce, la nouvelle clé devra elle aussi être authentifiée, par un

moyen non compromis : ne mettez pas la partie privée de la KSK dans le

même coffre-fort que la partie privée de votre clé PGP !

Autre cas amusant pour les gérants d'une zone DNS, le changement d'opérateurs. Par exemple, le titulaire d'une zone décide de passer d'un hébergeur DNS à un autre (notez que l'hébergeur est souvent le BE mais ce n'est pas obligatoire). Si les deux hébergeurs (en pratique, c'est évidemment le perdant qui fait des histoires) coopèrent, le problème est relativement simple. Le RFC suppose que l'ancien hébergeur ne va pas transmettre la clé privée (si elle est dans un HSM, il ne peut tout simplement pas). Dans ce cas, l'ancien hébergeur doit mettre dans la zone la clé publique du nouveau, et les signatures calculées par le nouveau avec ses clés. Le nouvel opérateur publie la même zone et, une fois le changement terminé (une fois que les clés du nouvel hébergeur sont dans tous les caches), le nouvel hébergeur peut retirer les clés et les signatures de l'ancien. Ce n'est pas très pratique (il faut échanger clés publiques et signatures). Personnellement, je trouve cet algorithme tout à fait irréaliste. Dans le DNS d'aujourd'hui, des obligations bien plus modérées (en cas de changement d'hébergeur, continuer à servir la zone jusqu'à ce que les TTL sur les enregistrements NS expirent) ne sont jamais respectées par les hébergeurs perdants, même lorsqu'elles figurent dans les obligations contractuelles. Le RFC note à juste titre que c'est un problème économique et qu'il n'a pas de solution technique.

Il reste donc le cas qui sera sans doute le plus probable, celui où l'ancien hébergeur de la zone DNS ne coopérera pas. (Techniquement, il peut même saboter activement le transfert, en publiant un enregistrement DNSKEY avec un très long TTL, pour « empoisonner » les caches.) La seule solution est alors de passer par une phase où la zone ne sera pas sécurisée par DNSSEC : le parent retire l'enregistrement DS, on attend que l'ancien DS ait disparu des caches, puis on en remet un, pointant vers une clé du nouvel hébergeur.

Quelques mesures techniques dans les résolveurs validants peuvent aider :

- Limiter les TTL qu'on accepte (RFC 2308) pour diminuer le risque d'obstruction,

- Vérifier la délégation lorsque les enregistrements NS vont expirer, pour être sûr de ne pas rester bloqué sur de vieux serveurs de noms (c'est également une protection contre l'attaque des domaines fantômes),

- Lorsque la validation échoue, réessayer après avoir viré les DNSKEY du cache.

Le gérant de la zone peut aussi aider en n'ayant pas des TTL trop longs.

Gérer proprement du DNSSEC impose une grande rigueur sur les questions temporelles. Avant DNSSEC, le temps dans le DNS était toujours relatif. Par exemple, le champ Expire de l'enregistrement SOA était relatif au moment de la dernière synchronisation avec le serveur maître. Même chose pour les TTL. Mais, avec DNSSEC, le temps devient absolu. Les dates de début et de fin de validité dans un enregistrement RRSIG, par exemple, sont absolues. Elles dépendent donc d'une horloge à l'heure.

Quelques conseils, donc, sur le temps :

- La période de validité des signatures devrait être au moins égale au TTL (autrement, des signatures encore dans le cache pourraient être expirées),

- Ne pas attendre le dernier moment pour re-signer. Cela laisse un délai pour corriger d'éventuels problèmes. Par exemple, si les signatures ont en permanence deux jours de validité devant elles, cela permet de survivre pendant un week-end, en cas d'incapacité à re-signer.

- Ne pas mettre de TTL trop bas (du genre 5 minutes) à la fois à cause de la charge sur les serveurs et aussi parce que la validation DNSSEC nécessite de récupérer beaucoup d'enregistrements et qu'il ne faut pas que leur TTL expire avant que le processus ne soit terminé.

- Pour une zone signée, avoir un Expire (dans le SOA) plus long que la durée de validité des signatures ne sert pas à grand'chose : un serveur esclave qui servirait des signatures qui ne sont plus valides serait pire qu'un serveur esclave qui ne servirait plus rien.

Bon, mais alors, quelle durée choisir pour la validité des signatures (les outils de signature de BIND mettent un mois, par défaut). C'est un compromis : une durée trop longue et on est vulnérable aux attaques par rejeu. Une durée trop courte et on risque de n'avoir pas assez de temps pour réagir en cas de problème. Une erreur dans la configuration du pare-feu, les serveurs esclaves qui ne peuvent plus se synchroniser, les signatures sur ces serveurs esclaves qui expirent et crac, la zone est invalide. Cela arrive vite. Mon opinion personnelle est qu'aujourd'hui, les procédures ne sont pas assez testées et l'expérience DNSSEC est insuffisante. Il faut donc jouer la sécurité et avoir des durées de validité longues (au moins deux semaines). Dans le futur, au fur et à mesure de la montée en compétence et de l'amélioration des logiciels, on pourra mettre des durées de validité des signatures plus courtes, fermant ainsi la porte aux attaques par rejeu.

Voilà, nous avons couvert le gros de ce RFC. La section 5, qui suit, se consacre à un problème rigolo, celui des enregistrements indiquant l'enregistrement suivant, les enregistrements next. L'un des choix importants de conception de DNSSEC était de permettre que les signatures se fassent entièrement hors-ligne. On ne pouvait donc pas prévoir toutes les questions posées au serveur et avoir une signature pour toutes les réponses « ce domaine n'existe pas ». Il y a donc des enregistrements qui disent « il n'y a pas de domaine ici », enregistrements qui sont signés pour qu'un résolveur validant puisse authentifier une réponse négative. Ces enregistrements next sont le NSEC et le NSEC3. Le premier est en clair (il indique le nom de l'enregistrement suivant celui qui n'existe pas), le second est brouillé (il indique le condensat suivant le condensat du nom qui n'existe pas). Pour l'administrateur, les NSEC sont plus pratiques, notamment au débogage. Mais ils permettent la récupération complète de la zone, en marchant de NSEC en NSEC.

Le choix entre NSEC et NSEC3 dépend du type de la zone. Si on a une

petite zone au contenu prévisible (juste l'apex, un

mail et un

www, ce qui est le cas de très nombreuses zones),

aucune raison d'utiliser NSEC3. Même chose si la zone est très

structurée et donc très prévisible (ip6.arpa,

ENUM...). Même chose si la zone est publique,

ce qui est le cas par exemple de la racine (il existe une autre raison

d'utiliser NSEC3, l'opt-out, qui intéresse surtout

les grandes zones de délégation comme certains TLD).

Autrement, si on n'est dans aucun de ces cas, si on est une assez

grande zone au contenu imprévisible et qui n'est pas publique, il est

cohérent d'utiliser NSEC3 (RFC 5155).

NSEC3 a certains paramètres à configurer (et qui sont publiés dans

l'enregistrement NSEC3PARAM). Notamment, on peut définir le nombre

d'itérations de hachage. Cette possibilité

protège des attaques par dictionnaires pré-calculés mais elle est

coûteuse et elle mène à l'exécution de code à chaque requête pour un

nom inexistant. Le RFC suggère un nombre de 100 itérations, ce qui est

colossal par rapport à ce que font la plupart des zones NSEC3

aujourd'hui (5 par défaut avec OpenDNSSEC, mais beaucoup l'abaissent, on trouve 1 pour

.fr et

.com, et même 0 pour

.org...) NSEC3 ajoute un

sel au début de l'itération et notre RFC

suggère de changer ce sel en même temps que la ZSK.

Les changements depuis le RFC 4641 sont résumés dans l'annexe E. D'abord, les erreurs connues ont été corrigées. Ensuite, la fonction de hachage SHA-256 a été ajoutée aux recommandations. La partie sur le changement d'hébergeur DNS a été ajoutée. Le modèle avec séparation KSK/ZSK ne bénéficie plus d'un privilège particulier puisque le modèle avec une seule clé est également décrit.

(Les juristes noteront que VeriSign a un brevet sur certaines des techniques présentées dans ce RFC.)

L'article seul

RFC 6817: Low Extra Delay Background Transport (LEDBAT)

Date de publication du RFC : Décembre 2012

Auteur(s) du RFC : S. Shalunov (BitTorrent Inc), G. Hazel (BitTorrent Inc), J. Iyengar (Franklin and Marshall College), M. Kuehlewind (University of Stuttgart)

Expérimental

Réalisé dans le cadre du groupe de travail IETF ledbat

Première rédaction de cet article le 20 décembre 2012

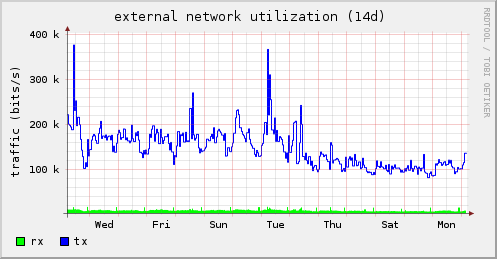

Alors que tant d'efforts de recherche ont été dépensés pour faire des réseaux informatiques et des protocoles qui permettent d'aller plus vite, d'attendre moins longtemps avant de voir la page d'accueil de TF1, le groupe de travail LEDBAT (Low Extra Delay Background Transport ) de l'IETF travaillait à un tout autre projet : un protocole de transport de données qui aille moins vite, de façon à être un bon citoyen du réseau, à n'utiliser celui-ci que lorsqu'il est vide et qu'on peut donc faire passer ses bits sans gêner personnne. Ce RFC décrit l'algorithme LEDBAT, un algorithme « développement durable ».

LEDBAT n'est donc pas un protocole complet, mais un algorithme de contrôle de la fenêtre de congestion, ce mécanisme par lequel les protocoles de transport évitent de saturer le réseau. Le plus connu et le plus utilisé de ces mécanismes est celui de TCP (RFC 5681) et ses objectifs sont d'utiliser le réseau à fond et d'assurer une relative égalité entre les flots de données qui se concurrencent sur ce réseau. LEDBAT, au contraire, vise avant tout à céder la place aux autre flots, non-LEDBAT.

Mais pourquoi diable voudrait-on être si généreux ? Cela peut être parce qu'on estime les autres flots plus importants : si je télécharge Plus belle la vie pendant que je passe un coup de téléphone via SIP, je souhaite que le téléchargement ne prenne pas de capacité si SIP en a besoin (c'est la différence entre applications d'« arrière-plan » comme le transfert de gros fichiers et d'« avant-plan » comme un coup de téléphone ou une session SSH interactive). Ou bien cela peut être pour profiter de réductions offertes par le réseau : après tout, un routeur ou une fibre optique ne coûtent pas plus cher à l'usage, que les octets circulent ou pas (contrairement à un autoroute ou une voie ferrée). Il serait donc logique que les transports « charognards », comme LEDBAT, qui n'utilisent la capacité réseau que lorsque personne n'en veut, reçoivent une récompense financière, par exemple une réduction des prix (parlez-en à votre FAI).

Pour les détails sur les motivations de LEDBAT et les raisons pour lesquelles des technqiues comme le shaping ne conviennent pas, voir le premier RFC du groupe LEDBAT, le RFC 6297. Ici, je vais me focaliser sur l'algorithme spécifié par LEDBAT et qui répond au cahier des charges : céder la place le plus vite possible.

Le principe de cet algorithme est simple : utiliser les variations du temps de voyage des paquets pour détecter l'approche de la congestion et refermer alors la fenêtre de transmission. TCP utilise essentiellement le taux de pertes de paquets comme indicateur (ou les marques ECN du RFC 3168). Les routeurs ayant des tampons d'entrée-sortie, lorsque la ligne de sortie est saturée, les paquets commencent à s'entasser dans ce tampon. Lorsqu'il est plein, le routeur jette des paquets (et TCP va alors réagir). On voit que l'augmentation du temps de voyage (dû au séjour dans le tampon) précède la perte de paquets. En réagissant dès cette augmentation, LEDBAT atteint son objectif de céder la place à TCP. (À noter qu'il existe des variantes de TCP qui utilisent également le temps de voyage comme indicateur de l'approche de la congestion, par exemple TCP Vegas, documenté dans « TCP Vegas: New techniques for congestion detection and avoidance » de Brakmo, L., O'Malley, S., et L. Peterson, mais voir le RFC 6297 pour un tour d'horizon général.)

Où est-ce que LEDBAT va être mis en œuvre ? Cela peut être dans un protocole de transport, par exemple comme une extension de TCP, ou bien dans l'application. LEDBAT est un algorithme, pas un protocole précis. Il peut être utilisé dans plusieurs protocoles, du moment que ceux-ci permettent l'estampillage temporel des paquets, pour que les deux machines qui communiquent puissent mesurer le temps de voyage (section 4.1).

La section 2 décrit l'algorithme exact. LEDBAT a une fenêtre de

congestion, notée cwnd qui indique combien

d'octets l'émetteur peut envoyer avant un nouvel accusé de

réception. L'émetteur met dans chaque paquet le moment où il a envoyé

ce paquet. Le récepteur regarde l'heure, en déduit le temps de voyage

(aller simple, puisque l'encombrement n'est pas forcément le même dans

les deux sens, une mesure aller-retour ne servirait pas à grand'chose) et retransmet cette indication à l'émetteur. Lorsque

celui-ci voit le temps de voyage augmenter (signe que les tampons des

routeurs se remplissent), il diminue la fenêtre de

congestion. L'émetteur notamment utilise deux paramètres,

TARGET et

GAIN. TARGET est

l'augmentation du temps de voyage en dessous de laquelle LEDBAT ne

fait rien. GAIN (qui vaut entre 0

et 1) indique le

facteur d'échelle entre l'augmentation du temps de voyage et la

réduction de la fenêtre de congestion. Plus il est élevé, plus LEDBAT

réagit rapidement et vigoureusement. Un GAIN de 1

est équivalent à TCP Reno. À noter qu'on

pourrait avoir deux valeurs de GAIN, une pour

augmenter la fenêtre de congestion et une pour la diminuer. En mettant

un GAIN plus grand pour la diminution de la

fenêtre, on garantit que LEDBAT cédera très vite la place dès le plus

petit signal d'un ralentissement.

(Pour

les amateurs de pseudo-code, une description

de l'algorithme avec cette technique figure dans le RFC.)

Bien sûr, le temps de voyage varie pour tout un tas de raisons et

il n'est pas forcément souhaitable de refermer la fenêtre de congestion à chaque

dérapage. LEDBAT filtre donc les

outliers à l'aide d'une

fonction FILTER() qui fait partie des paramètres

de l'algorithme (elle n'est pas imposée par le RFC, on peut tester

plusieurs mécanismes de filtrage des données.) Un filtre sommaire est

NULL (aucun filtrage, on accepte toutes les

mesures). Un autre plus sophistiqué est EWMA

(Exponentially-Weighted Moving

Average). Un bon filtre résiste au bruit

inévitable, mais reste sensible aux signaux indiquant une vraie

congestion.

Le temps de voyage se décompose en temps de transmission sur le

câble (qui dépend de la vitesse du médium, par exemple 100 Mb/s pour

du Fast Ethernet), temps de propagation (lié à

la vitesse de la lumière), temps d'attente dans

les tampons et temps de traitement à la

destination. Tous ces temps sont constants ou presque, à l'exception

du temps d'attente dans les tampons. Ce sont donc ses variations qui

déterminent l'essentiel des variations du temps de voyage. Pour

estimer ce temps d'attente dans les tampons, LEDBAT calcule un

temps de base (section 3.1.1) qui est le temps de voyage minimum

observé. Il permet de connaître la valeur minimale en dessous de

laquelle le temps de voyage ne pourra pas descendre. Les calculs de

fenêtre de congestion se font à partir de (temps de voyage - temps de

base), une grandeur qui part donc de zéro (les méthodes du RFC 6298 peuvent être utiles ici). L'algorithme de LEDBAT

est linéaire : la fenêtre est réduite ou

agrandie proportionnellement à cette grandeur, le facteur de

proportionnalité étant le paramètre GAIN. Autre intérêt du concept de

temps de base : en cas de changement de la route pendant la session

(par exemple, panne d'un lien et re-routage par un chemin plus long),

la mesure du temps de base pendant les N dernières secondes permettra

de voir que le trajet a changé et que les calculs doivent utiliser le

nouveau temps de base. (Le choix de N est un compromis : trop petit et

le temps de base va varier souvent, trop grand et il retardera le

moment où on détecte un changement de chemin.)

Avec son mécanisme de réduction de la fenêtre de congestion dès que le temps de voyage augmente, LEDBAT ne pousse normalement jamais jusqu'au point où il y aura des pertes de paquets. Néanmoins, celles-ci peuvent quand même survenir, et LEDBAT doit alors se comporter comme TCP, en refermant la fenêtre (section 3.2.2).

La section 4 du RFC discute ensuite de différents points

intéressants de LEDBAT. Par exemple, LEDBAT est efficace pour céder

rapidement à TCP lorsque celui-ci transfère de grandes quantités de

données. Mais cela laisse le problème des applications qui envoient

peu de données mais sont très sensibles à la

latence, comme la voix sur IP. Si la conversation téléphonique envoie peu de données,

il n'y aura jamais de remplissage des tampons, donc pas d'augmentation

du temps d'attente dans ceux-ci donc LEDBAT se croira tranquille et

enverra autant de données qu'il veut. Au moment où un des

interlocuteurs parlera, ses paquets se trouveront donc peut-être

coincés derrière un paquet LEDBAT. La seule protection contre ce

problème est le paramètre TARGET qui ne doit donc

pas être mis trop haut. La norme G.114 de

l'UIT suggère 150 ms comme étant le maximum de

retard tolérable pour le transport de la voix. LEDBAT doit donc

choisir ses paramètres pour réagir avant les 150 ms. Le RFC

recommande 100 ms pour le paramètre TARGET qui

indique l'augmentation de délai de voyage à partir de laquelle LEDBAT

réagit. (Ce paramètre TARGET détermine le temps

maximal d'attente supplémentaire dû à LEDBAT.)

Autre point subtil, la compétition entre flots LEDBAT. On sait que TCP assure la « justice » entre flots TCP : si trois flots sont en compétition, chacun aura un tiers de la capacité. LEDBAT, lui, cède à TCP. Si un flot LEDBAT et un flot TCP sont en compétition, TCP aura toute la capacité. Mais si deux flots LEDBAT parallèles se concurrencent ? L'algorithme de LEDBAT ne garantit pas de justice. En général, c'est le flot le plus récent qui va gagner : arrivant tard, dans un réseau déjà bien encombré, il mesure un temps de base très élevé et ne voit donc pas d'augmentation due au temps d'attente dans les tampons, et ne réduit donc pas sa fenêtre de congestion (« Rethinking Low Extra Delay Background Transport Protocols » de Carofiglio, G., Muscariello, L., Rossi, D., Testa, C., et S. Valenti). Pour corriger cet effet, on ne peut compter que sur le bruit : de temps en temps, les tampons se videront, le temps de voyage diminuera, et le récent arrivé corrigera sa mauvaise estimation du temps de base.

La section 5 du RFC considère les points qui sont encore ouverts à

expérimentation. Après tout, un protocole comme LEDBAT est quelque

chose de très nouveau dans le zoo de l'Internet. Par exemple, l'effet

de changement de routes pendant une session LEDBAT, modifiant le temps

de base, n'est pas encore vraiment bien connu. Quant à la valeur des

paramètres comme TARGET ou

GAIN, elle aura certainement besoin d'être

ajustée à la lumière de l'utilisation réelle. Enfin, le filtre des

mesures, qui permet d'éliminer les mesures jugées anormales, et évite

donc à LEDBAT d'ajuster brusquement sa fenêtre de congestion pour

rien, aura certainement besoin de réglages, lui aussi.

Et la sécurité de LEDBAT ? La section 6 rappelle que, même si un attaquant arrive à tromper LEDBAT sur les valeurs du temps de voyage, dans le pire des cas, il ne pourra pas le faire se comporter de manière plus gloutonne que TCP. Par contre, il pourra faire une attaque par déni de service en lui faisant croire que le délai de voyage a augmenté et que LEDBAT devrait ralentir. Pour l'instant, il n'y a pas de mécanisme contre cela.

Le bon fonctionnement de LEDBAT dépend de bonnes mesures. Les fanas de métrologie seront donc ravis de l'annexe A, qui parle des causes d'erreur dans les mesures. Le principal problème est que, pour mesurer les temps de voyage aller-simple dont a besoin LEDBAT, il faut des horloges à peu près synchronisées. Si l'émetteur met dans le paquet une heure de départ à 13 heures, 37 minutes et 56,789 secondes, que le récepteur mesure une arrivée à 13 heures, 37 minutes et 57,123 secondes et que le récepteur a 0,5 secondes de retard sur l'émetteur, il mesurera un temps de voyage de 0,334 secondes (alors qu'il est en fait de 0,834 secondes). Reprenant le vocabulaire de NTP (RFC 5905), on peut dire qu'il y a deux sources de problèmes, l'écart des horloges par rapport à une référence et le décalage (la variation de l'écart). L'écart entraine une erreur fixe dans la mesure du temps (comme dans notre exemple ci-dessus). Mais LEDBAT n'utilise pas directement le temps mais la différence entre temps actuel et temps de base. Cette erreur s'annule donc et l'écart des horloges par rapport au temps correct n'est donc pas importante pour LEDBAT.

Plus embêtant est le décalage puisque lui ne s'annulera pas. Si

l'horloge du récepteur bat plus vite que celle de l'émetteur, il aura

toujours l'impression d'un réseau très encombré, puisque ses mesures

de temps de voyage seront toujours supérieures au temps de base qu'il

avait mesuré avant. Heureusement, alors que des écarts énormes sont

souvent vus sur l'Internet (il est fréquent de voir plusieurs minutes,

voire plusieurs heures de différence entre une machine et le temps

UTC), les décalages sont typiquement bien plus

petits. Les mesures citées par le RFC 5905

indiquent des décalages courants de 100 à 200 ppm, soit 6 à 12 ms

d'erreur accumulée

par minute. Comme une machine LEDBAT limite sa mémoire (paramètre

BASE_HISTORY, pour lequel le RFC recommande

actuellement une valeur de dix minutes), et n'utilise donc que des

mesures récentes pour évaluer le temps de base, le problème reste donc

limité.

Si malgré tout, le problème se pose, il n'affectera que le cas où le récepteur a une horloge plus rapide, et en déduira donc à tort qu'il doit ralentir. Dans le cas inverse (horloge du récepteur plus lente), l'émetteur aura simplement l'impression que le temps de base augmente.

Pour corriger ce problème de décalage, on peut imaginer d'envoyer les estampilles temporelles dans les deux sens, pour que chaque machine puisse calculer ce que devrait voir l'autre, pour pouvoir détecter qu'un pair a une mauvaise mesure. Ensuite, l'émetteur pourrait corriger ses propres calculs por s'adapter à ce récepteur erroné. Il peut même calculer si le décalage est constant (horloge battant trop vite ou trop lentement, mais à une fréquence constante).

Et question mises en œuvre effectives ? LEDBAT a été testé dans des logiciels comme μTorrent Transport Protocol library. Il est l'algorithme utilisé par le microTP de BitTorrent (voir la documentation officielle de µTP). Il est aussi mise en œuvre dans Swift.

Merci à Mathieu Goessens pour sa suggestion et à André Sintzoff pour ses inlassables corrections.

L'article seul

RFC 6731: Improved Recursive DNS Server Selection for Multi-Interfaced Nodes

Date de publication du RFC : Décembre 2012

Auteur(s) du RFC : T. Savolainen (Nokia), J. Kato (NTT), T. Lemon (Nominum)

Chemin des normes

Réalisé dans le cadre du groupe de travail IETF mif

Première rédaction de cet article le 19 décembre 2012

Lorsqu'une machine connectée à l'Internet a plusieurs interfaces réseaux, et apprend (par exemple en DHCP) l'existence d'un résolveur DNS différent sur chaque interface, lequel utiliser ? Le principe de base de cette nouvelle norme est qu'il faudrait garder en mémoire chaque résolveur et utiliser à chaque fois celui qui correspond à l'interface réseau qu'on va utiliser.

Autrefois, le problème ne semblait pas crucial : après tout, un

résolveur DNS en vaut un autre, puisque tous

donnent les mêmes réponses. Mais ce n'est plus le cas aujourd'hui. Par

exemple, sur certaines interfaces, le résolveur DNS peut donner accès

à des noms de domaine privés,

strictement locaux, que les autres résolveurs ne connaissent pas. On

ne peut donc pas se contenter de prendre l'un des résolveurs au

hasard, ni même « le meilleur » résolveur car chacun peut avoir des

caractéristiques uniques (par exemple, l'un des résolveurs connait le domaine privé

foo.example et un autre un autre domaine privé bar.example). D'où cette règle de garder en mémoire tous

les résolveurs connus. (Le RFC utilise le terme de

RDNSS - Recursive DNS

Servers - pour les résolveurs.)

Ce n'est pas tout de mémoriser tous les résolveurs, encore faut-il savoir lequel utiliser. C'est le rôle de nouvelles options DHCP normalisées ici, qui permettent de distribuer les méta-informations dont le client a besoin pour savoir de quel résolveur se servir.

Si on veut mieux comprendre le problème de ces machines ayant

plusieurs interfaces réseaux, il faut lire le premier

RFC du groupe de travail MIF, le RFC 6418, qui définit le problème. Un exemple d'une telle

machine est un smartphone

qui a accès à la fois à un réseau WiFi privé et

à la 3G. Mais il y a aussi le cas où il n'y a

qu'une seule interface physique, mais plusieurs virtuelles, par

exemple un accès à l'Internet par le FAI local

et un VPN vers le réseau sécurisé de

l'entreprise. La partie la plus évidente du problème des machines à

plusieurs interfaces est celui des noms privés (section 2.1). Imaginons que la

société Foobar ait le domaine foobar.example et

qu'un sous-domaine internal.foobar.example

contienne les informations privées, spécifiques à l'entreprise et non

visibles dans le DNS public. Cela se fait en configurant spécialement

les résolveurs utilisés par les employés de l'entreprise. Par exemple, avec Unbound, pour un domaine nommé 42 et servi par 91.191.147.246 et 91.191.147.243, cela serait :

stub-zone: name: "42" stub-addr: 91.191.147.246 stub-addr: 91.191.147.243

Si un de ces employés est en voyage, connecté depuis l'hôtel,

ayant activé le VPN, et que sa machine utilise

le résolveur de l'hôtel, il ne pourra pas utiliser les noms en

internal.foobar.example. (Vous pouvez vous dire

« il faut utiliser le résolveur DNS de l'entreprise pour tout ». Mais il

sera en général plus lent et il pourra avoir ses propres limites, par

exemple ne pas pouvoir résoudre facebook.com car

le résolveur de l'entreprise censure ce nom.)

Notez aussi que le fait que l'application de ce RFC permettre de

gérer les noms de domaines privés (non rattachés à l'arbre principal

du DNS) ne signifie pas que ces noms privés soient une bonne idée,

approuvée par l'IETF. Ce point avait été une

des grosses controverses dans le groupe de travail. La section 6 donne à ce sujet des conseils pour

minimiser les risques associés à ces noms privés. (En gros, les

choisir uniques, par exemple en les suffixant du nom de

l'organisation, pour que tout le monde ne nomme pas ses machines dans

.private ou .lan.)

En général, le « bon » résolveur à utiliser dépend de l'interface

de sortie et les techniques de ce RFC sont donc à utiliser en

combinaison avec celles du RFC 4191 et du RFC 3442. Même si un nom de domaine est visible partout, il peut

se résoudre en des adresses

IP différentes selon l'interface réseau utilisé (cas

célèbre de smtp.orange.fr qui ne donne pas le

même résultat aux abonnés d'Orange et aux

autres.) On peut encore citer le cas des extensions au DNS utilisées

dans certains cas de coexistence

IPv4-IPv6 (RFC 6147).

Il peut y avoir des cas encore plus complexes et notre RFC ne prétend pas tout résoudre (section 2.3).

Avant de décrire la solution standardisée, le RFC présente trois études de cas permettant d'illustrer un problème soluble (section 3). Des études de cas plus détaillées, avec examen des pratiques actuelles, figurent dans le RFC 6419.

D'abord, le cas d'un foyer connecté à l'Internet via un FAI

ainsi qu'à un réseau privé, les deux connexions passant par le même

CPE. Ce réseau privé utilise uniquement des noms

dans un domaine qui n'apparait pas sur l'Internet (mettons

hidden.example). Pour que tout marche, du point

de vue de l'utilisateur, il faut envoyer les requêtes de résolution de

noms au résolveur du réseau privé, si le nom se termine en

hidden.example et au résolveur du FAI

autrement. Le plus simple est qu'un relais DNS

tourne sur le CPE et aiguille automatiquement les requêtes DNS vers le

bon résolveur.