Ce blog n'a d'autre prétention que de me permettre de mettre à la disposition de tous des petits textes que j'écris. On y parle surtout d'informatique mais d'autres sujets apparaissent parfois.

À quoi ressemblera la résolution de noms dans l'Internet de demain ?

Première rédaction de cet article le 25 décembre 2011

Dans tout réseau, il y a besoin d'un mécanisme de

résolution des noms, traduisant les noms en

identificateurs de plus bas niveau, plus proches du fonctionnement

technique du réseau. C'est ainsi que, de 1983 à

2011, la résolution de noms sur l'Internet a

surtout été assurée par le DNS, permettant

ainsi de séparer des noms stables, comme

www.example.org, des identificateurs moins stables,

comme 2001:db8:af::1:567. Mais est-ce que cela

sera toujours le cas demain ?

Car le DNS est aujourd'hui menacé. Pas par les vagues

projets de construire un système « meilleur », tâche plus compliquée qu'elle n'en a l'air. Mais par

l'intérêt que portent des forces néfastes au DNS, et par les réactions

que cela va entraîner. Aujourd'hui, avec le DNS, nous avons sur

l'Internet un système d'une très grande fiabilité (les attaques

DoS contre la racine ont

toujours échoué, par exemple), largement

déployé, qui permet des identificateurs stables (mon blog est resté en

www.bortzmeyer.org même lorsque je suis passé de

Slicehost à 6sync), et

qui assure une signification unique pour les noms. Pas besoin de

nuancer, de se renseigner, de demander quel réseau utilise son

interlocuteur, on est sûr que tout le monde pourra utiliser

www.bortzmeyer.org et avoir un résultat

équivalent.

En raison de ces propriétés, le DNS est donc aujourd'hui à la base de toutes les transactions sur l'Internet, qui commencent toujours par une requête DNS (et parfois bien plus).

Ce rôle a évidemment attiré l'attention des méchants, notamment des censeurs. C'est ainsi que la loi LOPPSI en France permet d'imposer aux FAI de bloquer l'accès à certains sites, sur simple décision administrative (pour éviter que les citoyens puissent prendre connaissance de la liste des sites bloqués, et vérifier qu'ils sont bloqués pour de bonnes raisons). Un des mécanismes évidents pour mettre en œuvre ce blocage est le DNS (transformation du résolveur du FAI en DNS menteur, avec blocage du port 53). Déjà, de nombreux commerciaux font le tour des acteurs de l'Internet pour promouvoir des solutions de filtrage DNS, qui est également possible dans des logiciels comme BIND (avec la RPZ). La France dispose d'une grande avance technologique dans ce domaine, avec des entreprises comme Amesys, fournisseur de censure pour l'ex-dictature lybienne.

Les autres pays ne sont pas en reste et c'est ainsi que les États-Unis ont leur projet SOPA, équivalent de la LOPPSI, qui permet également d'obliger les FAI à bloquer l'accès à tel ou tel site. Comme, là encore, une implémentation évidente d'un tel système est via le DNS, SOPA a suscité des réactions vigoureuses de la part des acteurs du DNS, ce qui explique en partie le recul des promoteurs du projet. Toutefois, la présence ou l'absence de cette loi ne sera pas forcément le facteur principal : un certain nombre d'opérateurs censurent déjà via le DNS (c'est donc une censure privée, contrairement à SOPA qui proposait une censure étatique).

Naturellement, cette censure ne restera pas sans réponse. Des tas de gens chercheront des contournements, des moyens de passer outre à la censure, comme cela s'est déjà produit pour Wikileaks. Comme le dit An dans les commentaires d'un blog : « Dans le temps, on s'échangeait des adresses de ftp warez. Dans un futur proche, on s'échangera peut-être des fichiers hosts contenant des listes:

warez1 @IP1 warez2 @IP2 etc...

et on lancera bien gentiment notre navigateur sur http://warez1, http://warez2 etc..

les sites webs auront été hackés et se verront ajouter un hostname warez1 qui servira

des films de vacances d'été comme au bon vieux temps du ftp warez. Ça ne tiendra pas

longtemps, ça sera difficilement traçable, et ça bougera bien trop rapidement pour

être coincé. ». D'autres tentatives ont déjà été faites, de diffuser

des listes d'adresses IP, suscitant de

vives discussions. En d'autres termes, il s'agit de revenir aux

anciennes listes genre

hosts.txt distribuées, et

jamais parfaitement à jour (comme le note Pierre Beyssac, ce sera du « hosts.txt, cloud-style »).

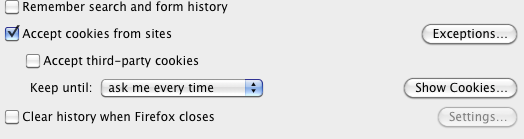

Autre solution, on verra apparaître des résolveurs DNS promettant de ne pas censurer comme ceux de Telecomix. Des outils apparaîtront pour permettre de changer de résolveur DNS plus facilement (comme le montre l'article de Korben).

Ces réactions entraineront à leur tour des contre-réactions, vers davantage de contrôle, comme l'industrie du divertissement le prévoit déjà.

Lors d'une discussion sur la liste FRnog, Ronan Keryell s'exclamait : « Je pense qu'il faut à la base arrêter de tuer Internet.

C'était mieux avant (quand nous utilisions tous les 2 Internet dans les

années 80... :-) ).

Doit-on vraiment revenir au bon vieux hosts.txt

(RFC 952 pour ceux qui ont oublié ou plus

probablement ici n'ont jamais connu) face à tous ces délires de filtrage

et de résolution de faux problèmes imaginaires pour le bonheur de

l'utilisateur comme dans toute dictature qui se respecte ?

Stop ! On s'arrête ! ».

Mais nous en sommes déjà là, à revenir à des systèmes mal fichus, dont le résultat varie selon l'utilisateur, et dont la fiabilité n'est pas garantie. Les gens qui font les lois comme LOPPSI ou SOPA se moquent bien de tuer l'Internet. Ce n'est pas par ignorance de la technique qu'ils décident des mesures qui vont gravement blesser l'Internet. Ils veulent le contrôle avant tout, même au prix de problèmes permanents pour les utilisateurs.

Petit à petit, ces utilisateurs vont se servir de systèmes de résolution « inhabituels ». Ce seront des résolveurs DNS avec des règles spéciales (comme le plugin Firefox de Pirate Bay) puis des infrastructures utilisant le protocole DNS mais avec des données différentes (comme les racines alternatives sauf que cette fois, cela sera réellement adopté massivement, car il existe une forte motivation, qui manquait aux racines alternatives d'il y a dix ans, qui n'avaient rien à proposer aux utilisateurs).

On verra par exemple des « pseudo-registres » qui partiront des données des « vrais » registres puis les « corrigeront », ajouteront des termes ou d'autres, à partir d'une base à eux (contenant les domaines censurés).

Puis cela sera des systèmes de résolution nouveaux, comme Namecoin,

avec des passerelles vers le DNS (projet .bit).

Pour l'utilisateur, cela entrainera désordre et confusion. Des noms

marcheront à

certains endroits et pas d'autres. On verra des tas de discussions sur

des forums avec des conseils plus ou moins avisés du genre « pour voir

tous les .fr, utilise

telle ou telle adresse de résolveur DNS, et

pas ceux de X ou de Y qui sont

censurés ».

À la fin de l'année 2011, ce scénario catastrophe semble difficilement évitable, sauf réaction vigoureuse contre les ayant-trop-de-droits et autres censeurs.

L'article seul

RFC 6474: vCard Format Extensions : place of birth, place and date of death

Date de publication du RFC : Décembre 2011

Auteur(s) du RFC : K. Li, B. Leiba (Huawei Technologies)

Chemin des normes

Réalisé dans le cadre du groupe de travail IETF vcarddav

Première rédaction de cet article le 24 décembre 2011

Le format de carte de visite numérique

vCard, normalisé dans le RFC 6350, est un des grands succès de l'Internet. On trouve ces

cartes partout. Le format de base définit un jeu de données limité

mais permet des extensions. Ce RFC est donc la

première extension à vCard version 4 (ex-aequo avec celle du RFC 6473), et normalise des

champs pour indiquer un lieu de naissance, un lieu de mort et une date

de mort (la date de naissance, BDAY, est dans le

format de base).

La section 2 décrit ces trois propriétés, toutes facultatives :

BIRTHPLACEindique le lieu de naissance. Il peut être indiqué en texte libre ou bien sous forme d'une URI, comme par exemple les URI de plangeo:du RFC 5870. Ainsi, Jésus-Christ pourrait avoirBIRTHPLACE: Dans une grange, Bethléem (Palestine)ou bienBIRTHPLACE;VALUE=uri:geo:31.7031,35.196.DEATHPLACEindique le lieu de mort, par exempleDEATHPLACE: Colline du Golgotha, Jérusalem(le RFC fournit un exemple où la longitude et latitude indiqués sont celles du point où a coulé le Titanic).DEATHDATEindique la date de la mort. Il avait longtemps été envisagé de la garder dans le format de base, commeBDAYmais elle avait finalement été retirée, suite à la réunion IETF de Pékin en 2010. Comme son homologueBDAY, le format préféré deDEATHDATEest celui d'ISO 8601 (cf. RFC 6350, section 4.3), par exempleDEATHDATE:00300501(date mise un peu au hasard, vu le manque de sources fiables...). Mais on peut aussi utiliser du texte libre pour le cas où on doit utiliser des formules vagues comme « au début du treizième siècle ».

Un exemple complet d'une vCard avec ces trois propriétés est :

BEGIN:VCARD VERSION:4.0 FN:Jeanne d'Arc N:d'Arc;Jeanne;;; UID:urn:uuid:4f660936-28d5-46bf-86c6-9720411ac02a GENDER:F KIND:individual TITLE:Bergère TITLE:Pucelle TITLE:Sauveuse de la France PHOTO:http://commons.wikimedia.org/wiki/File:Lenepveu,_Jeanne_d%27Arc_au_si%C3%A8ge_d%27Orl%C3%A9ans.jpg LANG:fr URL:http://fr.wikipedia.org/wiki/Jeanne_d%27arc BDAY:14120106 BIRTHPLACE:Domrémy (Lorraine) DEATHDATE:14310530 DEATHPLACE:Rouen (Normandie) END:VCARD

Ces trois nouvelles propriétés sont désormais enregistrées dans le registre IANA.

L'article seul

RFC 6434: IPv6 Node Requirements

Date de publication du RFC : Décembre 2011

Auteur(s) du RFC : E. Jankiewicz (SRI International), J. Loughney (Nokia), T. Narten (IBM Corporation)

Pour information

Réalisé dans le cadre du groupe de travail IETF 6man

Première rédaction de cet article le 22 décembre 2011

Il existe des tas de RFC qui concernent IPv6 et le programmeur qui met en œuvre ce protocole dans une machine risque fort d'en rater certains, ou bien d'implémenter certains qu'il aurait pu éviter. Ce RFC était donc un méta-RFC, chargé de dresser la liste de ce qui est indispensable dans une machine IPv6. Il a été remplacé depuis par le RFC 8504. Les deux points les plus chauds concernaient la configuration (par DHCP ou par RA - Router Advertisment ?) et la gestion d'IPsec, désormais officiellement facultative.

Ce document remplace son prédécesseur, le RFC 4294 (et est lui-même remplacé par le RFC 8504. Il vise le même but, servir de carte au développeur qui veut doter un système de capacités IPv6 et qui se demande s'il doit vraiment tout faire (réponse : non). Ce RFC explique clairement quels sont les points d'IPv6 qu'on ne peut pas négliger, sous peine de ne pas pouvoir interagir avec les autres machines IPv6. Le reste est laissé à l'appréciation du développeur. La section 2 résume ce but.

Les deux gros changements par rapport au RFC 4294 sont :

- DHCP monte en grade, bien que restant derrière les RA pour la configuration des machines IPv6,

- IPsec n'est plus obligatoire.

Ce RFC s'applique à tous les nœuds IPv6, aussi bien les routeurs (ceux qui transmettent des paquets IPv6 reçus qui ne leur étaient pas destinés) que les machines terminales (toutes les autres).

Bien, maintenant, les obligations d'une machine IPv6, dans l'ordre. D'abord, la couche 2 (section 4 du RFC). Comme IPv4, IPv6 peut tourner sur des tas de couches de liaison différentes et d'autres apparaîtront certainement dans le futur. En attendant, on en a déjà beaucoup, Ethernet (RFC 2464), 802.16 (RFC 5121), PPP (RFC 5072) et bien d'autres, sans compter les tunnels.

Ensuite, la couche 3 (section 5 du RFC) qui est évidemment le gros morceau puisque c'est la couche d'IP. Le cœur d'IPv6 est normalisé dans le RFC 2460 et ce dernier RFC doit donc être intégralement implémenté, à l'exception de l'en-tête de routage de type 0, qui a été abandonné par le RFC 5095.

Comme IPv6, contrairement à IPv4, ne permet pas aux routeurs intermédiaires de fragmenter les paquets, la découverte de la MTU du chemin est particulièrement cruciale. La mise en œuvre du RFC 1981 est donc recommandée. Seules les machines ayant des ressources très limitées (genre où tout doit tenir dans la ROM de démarrage) sont dispensées. Mais le RFC se doit de rappeler que la détection de la MTU du chemin est malheuresement peu fiable dans l'Internet actuel, en raison du grand nombre de pare-feux configurés avec les pieds et qui bloquent tout l'ICMP. Il peut être donc nécessaire de se rabattre sur les techniques du RFC 4821).

Le RFC 2460 décrit le format des paquets et leur traitement. Les adresses y sont simplement mentionnées comme des champs de 128 bits de long. Leur architecture est normalisée dans le RFC 4291, qui est obligatoire.

Également indispensable à toute machine IPv6, l'autoconfiguration sans état du RFC 4862, ainsi que ses protocoles auxiliaires comme la détection d'une adresse déjà utilisée.

ICMP (RFC 4443) est évidemment obligatoire, c'est le protocole de signalisation d'IP (une des erreurs les plus courantes des administrateurs réseaux incompétents est de bloquer ICMP sur les pare-feux).

Dernier protocole obligatoire, la sélection de l'adresse source selon les règles du RFC 3484 (depuis remplacé par le RFC 6724), pour le cas où la machine aurait le choix entre plusieurs adresses (ce qui est plus fréquent en IPv6 qu'en IPv4).

Le reste n'est en général pas absolument obligatoire mais recommandé (le terme a un sens précis dans les RFC, définie dans le RFC 2119 : ce qui est marqué d'un SHOULD doit être mis œuvre, sauf si on a une bonne raison explicite et qu'on sait exactement ce qu'on fait). Par exemple, la découverte des voisins (NDP, RFC 4861) est recommandée. Toutes les machines IPv6 en ont besoin, sauf si elles utilisent les liens ne permettant pas la diffusion.

Moins générale, la sélection d'une route par défaut s'il en existe plusieurs, telle que la normalise le RFC 4191. Elle est particulièrement importante pour les environnements SOHO (RFC 7084).

On a vu que l'autoconfiguration sans état (sans qu'un serveur doive se souvenir de qui a quelle adresse) était obligatoire. DHCP (RFC 8415), lui, n'est que recommandé.

Une extension utile (mais pas obligatoire) d'IP est celle des adresses IP temporaires du RFC 8981, permettant de résoudre certains problèmes de protection de la vie privée. Évidemment, elle n'a pas de sens pour toutes les machines (par exemple, un serveur dans son rack n'en a typiquement pas besoin). Elle est par contre recommandée pour les autres.

Encore moins d'usage général, la sécurisation des annonces de route (et des résolutions d'adresses des voisins) avec le protocole SEND (RFC 3971). Le déploiement effectif de SEND est très faible et le RFC ne peut donc pas recommander cette technique pour laquelle on n'a pas d'expérience, et qui reste simplement optionnelle.

L'une des grandes questions que se pose l'administrateur réseaux avec IPv6 a toujours été « autoconfiguration RA - Router Advertisment - ou bien DHCP ? » C'est l'un des gros points de ce RFC et la section 6 le discute en détail. Au début d'IPv6, DHCP n'existait pas encore pour IPv6 et les RA ne permettaient pas encore de transmettre des informations pourtant indispensables comme les adresses des résolveurs DNS (le RFC 6106 a résolu cela). Aujourd'hui, les deux protocoles ont à peu près des capacités équivalentes. RA a l'avantage d'être sans état, DHCP a l'avantage de permettre des options de configuration différentes par machine. Alors, quel protocole choisir ? Le problème de l'IETF est que si on en normalise deux, en laissant les administrateurs du réseau choisir, on court le risque de se trouver dans des situations où le réseau a choisi DHCP alors que la machine attend du RA ou bien le contraire. Bref, on n'aurait pas d'interopérabilité, ce qui est le but premier des normes Internet. Lorsque l'environnement est très fermé (un seul fournisseur, machines toutes choisies par l'administrateur réseaux), ce n'est pas un gros problème. Mais dans un environnement ouvert, par exemple un campus universitaire ou un hotspot Wifi, que faire ? Comme l'indiquent les sections 5.9.2 et 5.9.5, seul RA est obligatoire, DHCP ne l'est pas. RA est donc toujours la méthode recommandée si on doit n'en choisir qu'une, c'est la seule qui garantit l'interopérabilité. (Voir aussi la section 7.2 sur DHCP.)

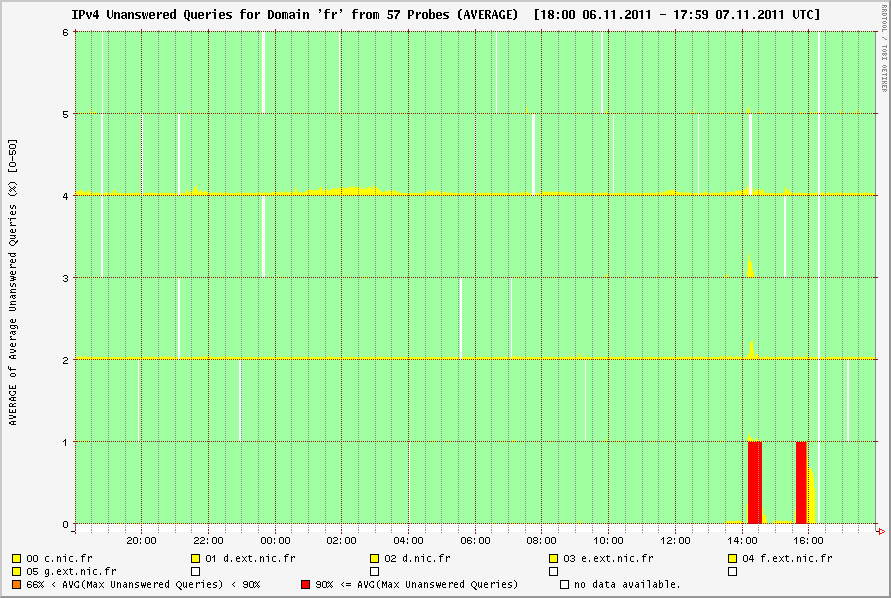

Continuons à grimper vers les couches hautes. La section 7 est

consacrée aux questions DNS. Une machine IPv6

devrait pouvoir suivre le RFC 3596 et donc avoir

la possibilité de gérer des enregistrements DNS de type AAAA (les

adresses IPv6) et la résolution d'adresses en noms grâce à des

enregistrements PTR dans

ip6.arpa. Les anciens enregistrements A6 (RFC 3363) ont été

abandonnés mais on constate que ces

enregistrements sont toujours très demandés lors des requêtes à des

serveurs DNS faisant autorité, comme ceux de

.fr (dans les 0,5 % des requêtes, soit davantage que SRV ou DS).

À noter qu'une machine IPv6, aujourd'hui, a de fortes chances de se retrouver dans un environnement où il y aura une majorité du trafic en IPv4 (c'est certainement le cas si cet environnement est l'Internet). La section 8 rappelle donc qu'une machine IPv6 peut avoir intérêt à avoir également IPv4 et à déployer des techniques de transition comme la double-pile du RFC 4213.

Encore juste une étape et nous en sommes à la couche 7, à laquelle la section 9 est consacrée. Si elle parle de certains détails de présentation des adresses (RFC 5952), elle est surtout consacrée à la question des API. En 2011, on peut dire que la grande majorité des machines a IPv6, côté couche 3 (ce qui ne veut pas dire que c'est activé, ni que le réseau le route). Mais les applications sont souvent en retard et beaucoup ne peuvent tout simplement pas communiquer avec une autre machine en IPv6. L'IETF ne normalise pas traditionnellement les API donc il n'y a pas d'API recommandée ou officielle dans ce RFC, juste de l'insistance sur le fait qu'il faut fournir une API IPv6 aux applications, si on veut qu'elles utilisent cette version d'IP, et qu'il en existe déjà, dans les RFC 3493 (fonctions de base) et RFC 3542 (fonctions avancées).

La sécurité d'IPv6 a fait bouger beaucoup d'électrons, longtemps avant que le protocole ne soit suffisamment déployé pour qu'on puisse avoir des retours d'expérience. Certains ont survendu IPv6 en prétendant que, contrairement à IPv4, il avait la sécurité intégrée dès le début et était donc plus sûr. Cette légende vient du fait qu'en théorie, IPsec était obligatoire pour toute mise en œuvre d'IPv6. Ce point n'a jamais été respecté par les implémentations (et puis, de toute façon, avoir IPsec est une chose, l'activer, avec sa complexe configuration, en est une autre). Désormais, depuis la sortie de notre RFC 6434, ce point n'est même plus vrai en théorie, IPsec (RFC 4301) est officiellement simplement recommandé.

Le RFC note donc bien que la sécurité est un processus complexe, qui ne dépend certainement pas que d'une technique magique (« IPsec est intégré donc il n'y a pas de problème de sécurité ») et qu'aucun clair gagnant n'émerge de la liste des solutions de sécurité (IPsec, TLS, SSH, etc). D'autant plus qu'IPv6 vise à être déployé dans des contextes comme « l'Internet des Trucs » où beaucoup de machines n'auront pas forcément les ressources nécessaires pour faire de l'IPsec.

Toutes les règles et recommandations précédentes étaient pour tous les nœuds IPv6. La section 12 expose les règles spécifiques aux routeurs. Ils doivent être capables d'envoyer les Router Advertisment et de répondre aux Router Solicitation du RFC 4861 et on suggère aux routeurs SOHO d'envisager sérieusement d'inclure un serveur DHCP (RFC 7084) et aux routeurs de réseaux locaux de permettre le relayage des requêtes DHCP.

Enfin, la section 13 se penche sur la gestion des réseaux IPv6 en notant que deux MIB sont obligatoires, celle du RFC 4292 sur la table de routage, et celle du RFC 4293 sur IP en général.

Les changements par rapport au RFC 4294 sont résumés dans l'annexe 16. Les deux plus importants, comme déjà noté, sont IPsec et DHCP, un qui descend, l'autre qui monte. Mais on y trouve aussi l'arrivée de SEND (mais en option), celle des options DNS du RFC 6106, et beaucoup de détails et de clarifications. Depuis, le RFC 8504 a aussi apporté ses changements.

L'article seul

Administration de machines Unix dans plusieurs fuseaux horaires

Première rédaction de cet article le 16 décembre 2011

Dernière mise à jour le 17 décembre 2011

Si vous administrez des machines Unix situées dans plusieurs fuseaux horaires, vous vous êtes peut-être déjà posé la question : quel fuseau indiquer à la machine ? Celui de sa localisation physique ? Celui de votre localisation physique ? Un autre ?

Voici la situation : Jean Michu, administrateur

système est à Paris et il gère des

machines à Newark,

Saint-Louis et d'autres endroits. Sur

Unix, on peut configurer chaque machine pour

indiquer son fuseau horaire (je ne crois pas qu'il existe de moyen

standard, par contre, sur Debian, c'est

dpkg-reconfigure tzdata et sur Red Hat, c'est vi /etc/sysconfig/clock). Mais lequel indiquer ?

Il y a au moins trois solutions :

- La localisation physique de la machine. Cela peut être plus pratique lorsqu'on veut communiquer avec des humains qui sont sur place, par exemple pour coordonner une intervention. Mais, autrement, cette localisation est une des choses les moins importantes dans l'Internet d'aujourd'hui. Avec le nuage, on peut même ne pas savoir dans quel fuseau horaire se trouve la machine qu'on administre. En outre, cela rend plus difficile de comparer des estampilles temporelles sur les différentes machines (par exemple pour déterminer si elles ont eu le même problème au même moment).

- La localisation physique de l'administrateur système. Cela a certainement plus de sens que celle de la machine : contrairement aux ordinateurs, les humains sont fortement dépendants de l'heure (la machine se moque de travailler à deux heures du matin ou à quatre heures de l'après-midi). Mais l'administrateur peut se déplacer. S'il se trouve temporairement en Chine, il va devoir jongler entre le fuseau horaire de sa localisation habituelle et celui de sa localisation actuelle. Et, surtout, s'il y a plusieurs administrateurs système, qui peuvent être dans des fuseaux horaires différents, cette méthode ne marche plus du tout.

- UTC? Ce fuseau horaire a l'avantage d'être normalisé, et d'avoir un sens pour tout le monde quel que soit sa localisation sur la planète. Lorsqu'il faut communiquer avec d'autres personnes (par exemple parce qu'il y a eu un problème de sécurité et qu'il faut indiquer le contenu d'un journal), UTC est la seule référence internationale.

C'est donc la dernière solution que j'ai choisie. Je configure toutes mes machines de manière à ce que leur heure par défaut soit UTC, ce qui produit des journaux utilisant cette heure.

Mais n'est-ce pas pénible que la commande date donne

cette heure UTC qui ne correspond pas au vécu de l'humain ? Et que

ls -l ne donne pas l'heure légale ?

Heureusement, Unix a réglé le problème depuis longtemps. Il suffit à

chaque administrateur système de définir la variable d'environnement TZ et il aura l'heure

dans son fuseau horaire :

% date Fri Dec 16 20:03:03 UTC 2011 % export TZ=Europe/Paris % % date Fri Dec 16 21:03:08 CET 2011

Même chose pour ls. Si les États-uniens font parfois preuve de provincialisme (par exemple en utilisant ASCII sans penser que sept bits ne suffisaient pas pour toutes les écritures du monde), le fait que leur pays compte plusieurs fuseaux horaires a certainement contribué à mettre en place une gestion correcte de ce concept sur Unix.

Évidemmment, aucune solution n'est parfaite. Par exemple, si on veut configurer cron pour lancer une tâche à une heure légale particulière, il faudra faire un peu de calcul avant de le programmer. Ceci dit, vous pouvez demander à date de le faire pour vous (merci à Gabriel Kerneis pour le rappel). Si vous voulez savoir quelle est l'heure légale à Doualalorsque UTC est à midi :

% TZ=Africa/Douala date --date="2011-12-16 12:00:00Z" Fri Dec 16 13:00:00 WAT 2011

(Le format utilisé est celui du RFC 3339, Z signifiant UTC.)

Si on veut faire l'inverse, trouver quelle sera l'heure UTC correspondant à une certaine heure légale (ici, on se demande quelle sera l'heure UTC lorsqu'il est cinq heures du matin en Californie) :

% TZ=UTC date --date="$(TZ=America/Los_Angeles date --date='2011-12-16 05:00:00')" Fri Dec 16 13:00:00 UTC 2011

Une dernière chose sur les fuseaux horaires. Certaines personnes disent que l'argument de communication (« We observed an abnormal traffic from your AS around 0200 UTC ») n'est pas si important que ça car on peut toujours indiquer le fuseau horaire explicitement, même lorsqu'il n'est pas UTC (« We observed an abnormal traffic from your AS around 0300 CET »). Le problème est que ces abréviations ne sont pas forcément connues mondialement (demandez à un États-unien ce qu'est CET et à un Français à quoi correspond MST) et qu'elles sont ambigues : par exemple EST peut être un fuseau horaire aux États-Unis ou bien en Australie. On peut demander à date d'afficher l'heure avec un fuseau horaire explicite, indiqué numériquement, sans ses abréviations (ici, pour le fuseau horaire de la Californie) :

# Par défaut, affiche une abréviation ambigue % date Sat Dec 17 14:16:40 PST 2011 # Avec un décalage numérique, tout est plus clair % date --rfc-3339=seconds 2011-12-17 14:16:46-08:00

mais les utilisateurs n'y pensent pas toujours.

L'article seul

Quel est le genre des RFC ?

Première rédaction de cet article le 14 décembre 2011

Vous l'avez remarqué, ce blog parle entre autres des RFC, qui représentent un bon bout des articles. Les RFC y sont actuellement mentionnés au masculin (« un RFC », « le RFC 6455 »). Est-ce une règle ? Est-ce la meilleure ?

Je le dis tout de suite, il n'y a pas de réponse simple à cette question. Le terme RFC veut dire en anglais Request For Comments qu'on peut traduire par « demande de commentaires » ou « appel à commentaires » (la traduction que je préfère). Dans le premier cas, on devrait utiliser le féminin, dans le second le masculin. En anglais, la langue dans laquelle sont écrits (écrites ?) les RFC, le terme est neutre. Il ne faut donc pas chercher un argument d'autorité pour trancher.

Et l'usage, que nous dit-il ? Si on cherche sur Google en faisant s'affronter "le RFC" contre "la RFC" ou bien "un RFC" contre "une RFC", on obtient des scores très proches (en décembre 2011, "un RFC" -> 38 200 résultats, "une RFC" -> 29 400 résultats). Il n'y a pas d'interprétation dominante. On trouve même des textes où l'auteur dit à un endroit « une RFC » et à un autre « le RFC 2616 ». À défaut de l'opinion majoritaire, quelle est celle des experts ? Le site du projet de traduction des RFC utilise le féminin. Wikipédia fait de même.

Les arguments basés sur la traduction de Request For Comments ne sont pas parfaits. Écartons d'abord la traduction erronée « requête de commentaires » qui n'est pas du français correct (une requête n'est pas une request). Mais toutes les traductions, même justes, souffrent du même défaut : le sigle n'a plus beaucoup de signification, même en anglais. À l'origine, il avait été choisi par modestie (puisque les costards-cravate refusaient aux documents Internet le titre de normes, on les appelait « appel à commentaires ») et il reflétait une certaine réalité. Aujourd'hui, les RFC sont figés (une fois publié, un RFC n'est jamais modifié, même d'une virgule) et l'étymologie du sigle est devenue très trompeuse (il y a même des projets à l'IETF de supprimer le développé Request For Comments et de ne garder que le sigle).

Une autre traduction possible, qui respecte le sigle, serait « Référence Formalisée par la Communauté », qui décrit bien mieux la réalité des RFC (merci à Emmanuel Saint-James).

Bref, pour l'instant, je traduis par « appel à commentaire » (même si cela ne reflète pas leur réalité de documents stables) et je parle des RFC au masculin. Ça changera peut-être plus tard, mais il me faudra reprendre tout mon blog...

L'article seul

Est-ce la même chose d'accéder à une donnée individuelle, et d'avoir un accès en masse ?

Première rédaction de cet article le 14 décembre 2011

Dans les discussions sur la protection de la vie privée, une confusion est souvent faite entre « donnée accessible publiquement » et « la totalité des données est récupérable » (ce qu'on nomme en anglais le bulk access).

Par exemple, cette confusion est souvent faite dans le cas de

l'accès aux données stockées dans le

DNS. N'importe qui peut interroger les serveurs

DNS de .fr pour savoir si

le nom

anemelectroreculpedalicoupeventombrosoparacloucycle.fr

existe ou pas (on peut aussi le faire via le protocole whois). En revanche, le fichier comportant tous les noms

existants dans .fr n'est pas

disponible. (Certaines zones permettent cet accès.) N'y a-t-il pas

une incohérence ? Si les données sont publiques, quel mal y aurait-il

à donner un accès à l'ensemble de ces données, un « bulk

access » (accès en masse) ?

Techniquement, la différence peut en effet sembler mince : si on

peut faire une requête DNS (ou whois) pour un nom, il est trivial de

faire une boucle pour essayer plein de

noms. Cela se nomme une attaque par dictionnaire et les serveurs de .fr

en voient régulièrement. Mais ce n'est pas très discret.

Et surtout, penser que l'accès individuel (éventuellement répété

dans une boucle) équivaut à l'accès en masse, c'est oublier

l'explosion combinatoire, qui limite

sérieusement les possibilités d'une attaque par

dictionnaire. Imaginons qu'on soit intéressé par les variantes de

mabanqueserieuse.example. Imaginons également qu'on se

limite aux variations d'un seul

caractère. mabanqueserieuse a 17 caractères. En

exploration systématique par des requêtes DNS, il faudrait 36 essais

(les lettres d'ASCII, plus les chiffres et le

tiret, moins le caractère existant) par caractère soit 612 essais. Et

cela ne teste que les substitutions, pas les ajouts ou suppressions

(dont on verra plus loin qu'ils existent). Bref, de tels tests

seraient assez bavards et feraient râler l'administrateur des serveurs

DNS (et c'est encore plus net avec whois). Dans la plupart des cas, énumérer toutes les variantes « intéressantes » (pour faire ensuite des requêtes DNS) n'est pas faisable.

Si on a l'accès en masse, tout est plus simple, car de superbes

algorithmes existent pour rechercher de manière plus efficace. Voyons

un exemple avec le programme agrep

(tre-agrep en fait), -E 1 signifiant qu'on cherche

les noms qui ne diffèrent que d'un seul caractère :

% grep mabanqueserieuse example.txt mabanqueserieuse.example % tre-agrep -E 1 mabanqueserieuse example.txt mabanqueserieuse.example mabanqueserieusr.example mabanqueserieusse.example mbanqueserieuse.example manbanqueserieuse.example ...

et on trouve ainsi de nombreuses autres variantes (testé avec une

banque réelle, où presque toutes les variantes avaient été

enregistrées par un bureau d'enregistrement

situé aux Bahamas). Le fait d'avoir accès à la

totalité de la base permet également des recherches sur une partie du

nom et de trouver ainsi les

doppelgangers comme wwwmabanqueserieuse.fr.

Dans ce cas précis, vous me direz peut-être que détecter les cybersquatteurs opérant depuis un paradis fiscal ne serait pas une mauvaise chose. Mais mon but était de montrer que l'accès aux données en masse permettait des recherches bien plus poussées, et que cela peut se faire au détriment d'innocents (par exemple des particuliers harcelés par les détenteurs de titre de propriété intellectuelle, comme dans l'affaire Milka).

C'est pour cela que le mécanisme NSEC3 du RFC 5155 était important. Sans lui, il était possible d'énumérer tous les noms d'une zone DNS signée avec DNSSEC. Certaines personnes avaient relativisé ce risque en disant « les données DNS sont publiques, de toute façon », ce qui est une sérieuse erreur, comme indiqué plus haut.

Si vous préférez aborder le problème sous l'angle juridique, il faut lire les articles L. 342-1 à 3 du Code de la Propriété Intellectuelle (merci à Thomas Duboucher pour les indications).

Les curieux noteront que les algorithmes de recherche approximative de texte sont proches de ceux utilisés en génomique comme Smith et Waterman ou Needleman et Wunsch. En effet, la recherche d'une séquence de bases dans un génome ne peut pas se faire littéralement, comme avec grep. En raison des mutations et des erreurs dans le séquençage, la correspondance n'est jamais parfaite, et il faut donc accepter, comme dans l'exemple avec tre-agrep, un certain nombre de différences.

L'article seul

Les malheurs du réseau 128.0.0.0/16

Première rédaction de cet article le 13 décembre 2011

Une série de chiffres en vaut une autre, pensez-vous ? Eh bien

non. Quoique numériques, toutes les adresses IP ne se valent pas. Le préfixe

128.0.0.0/16, quoique parfaitement légal, est

ainsi invisible depuis une bonne partie de

l'Internet.

Tentez l'expérience depuis votre machine en visant l'amer mis en place par le RIPE-NCC :

% ping -c 3 128.0.0.1 PING 128.0.0.1 (128.0.0.1) 56(84) bytes of data. 64 bytes from 128.0.0.1: icmp_req=1 ttl=55 time=83.6 ms 64 bytes from 128.0.0.1: icmp_req=2 ttl=55 time=83.8 ms 64 bytes from 128.0.0.1: icmp_req=3 ttl=55 time=83.5 ms --- 128.0.0.1 ping statistics --- 3 packets transmitted, 3 received, 0% packet loss, time 2005ms rtt min/avg/max/mdev = 83.519/83.692/83.890/0.367 ms

Si cela marche (comme ci-dessus), vous faites partie des favorisés. Sinon :

% ping -c 3 128.0.0.1 PING 128.0.0.1 (128.0.0.1) 56(84) bytes of data. --- 128.0.0.1 ping statistics --- 3 packets transmitted, 0 received, 100% packet loss, time 2010ms

Mais pourquoi ? Qu'est-ce que ce chiffre a de particulier ?

C'est parce qu'une bogue des routeurs Juniper

traite ce réseau différemment et, par défaut, le considère comme

« martien » (anormal sur l'Internet) et refuse les annonces

BGP pour lui (ce

préfixe était réservé, mais le RFC 3330 l'a libéré en 2002). Le numéro

(interne) de bogue chez Juniper est le PSN-2011-10-393. Le problème est bien expliqué

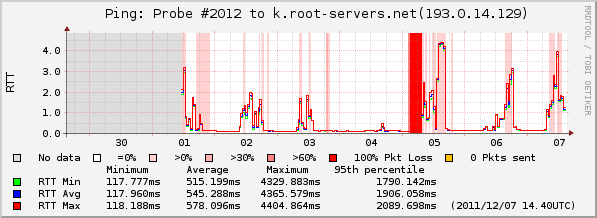

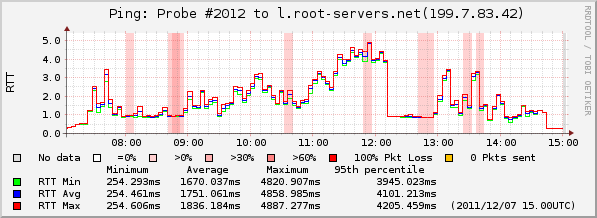

dans un

article des RIPE labs et son effet mesuré

par les sondes Atlas. Aujourd'hui, un tiers de l'Internet ne

peut pas joindre ce réseau 128.0.0.0/16. Autre

façon de mesurer le même problème, regarder la propagation des

annonces BGP, par exemple au

RIS qui, en décembre 2011, voit une propagation de seulement 80 %.

Une mise à jour existe désormais chez Juniper. On peut aussi

changer la configuration par défaut (qui est incorrecte). Si votre routeur

Juniper affiche 128.0.0.0/16 en réponse à

show route martians, c'est que vous avez la

mauvaise configuration. Changez-la :

set routing-options martians 128.0.0.0/16 orlonger allow set routing-options martians 191.255.0.0/16 orlonger allow set routing-options martians 223.255.255.0/24 exact allow

(Trois préfixes sont concernés, même si c'est surtout le premier qui a fait parler de lui.)

Si vous n'arivez pas à pinguer l'adresse de l'amer ci-dessus, tapez sur votre FAI jusqu'à ce qu'il mette à jour ses routeurs (et ainsi de suite récursivement car cela dépend également de l'opérateur qui connecte le FAI).

Avant la mise à jour, sur la console du routeur :

admin@m7i-2-sqy> show route 128.0.0.1

admin@m7i-2-sqy> show route 128.0.0.1 hidden

SERVICE.inet.0: 395145 destinations, 730370 routes (394162 active, 0

holddown, 1051 hidden)

+ = Active Route, - = Last Active, * = Both

128.0.0.0/21 [BGP/170] 1w5d 21:07:00, localpref 100

AS path: 2200 20965 1103 12654 I

> to 193.51.182.46 via ge-1/3/0.0

Après la mise à jour :

admin@m7i-2-sqy> show route 128.0.0.1

SERVICE.inet.0: 369404 destinations, 369404 routes (368357 active, 0

holddown, 1047 hidden)

+ = Active Route, - = Last Active, * = Both

128.0.0.0/21 +[BGP/170] 00:01:55, localpref 100

AS path: 2200 20965 1103 12654 I

> to 193.51.182.46 via ge-1/3/0.0

Merci à Sylvain Busson pour sa prompte mise à jour des routeurs.

L'article seul

RFC 6458: Sockets API Extensions for Stream Control Transmission Protocol (SCTP)

Date de publication du RFC : Décembre 2011

Auteur(s) du RFC : R. Stewart (Adara Networks), M. Tuexen (Muenster University of Applied Sciences), K. Poon (Oracle Corporation), P. Lei (Cisco Systems), V. Yasevich (HP)

Pour information

Réalisé dans le cadre du groupe de travail IETF tsvwg

Première rédaction de cet article le 12 décembre 2011

Il n'y a pas de protocole qui réussit sans une API, c'est-à-dire une spécification d'une interface qui permet au programmeur d'utiliser le protocole en question. Le protocole de transport SCTP, normalisé dans le RFC 4960, n'avait pas jusqu'à présent d'API standard et les programmes ne fonctionnaient donc qu'avec une seule bibliothèque. Désormais, avec ce RFC, SCTP a des chances de voir le développement de programmes portables.

SCTP est le principal concurrent de TCP dans la catégorie « protocole de couche 4 fiable » (i.e. qui garantit l'acheminement des données, contrairement à UDP). Mais il est beaucoup moins utilisé que TCP, plus ancien, et qui a une API standard depuis longtemps, interface décrite dans la norme POSIX. Il y a aussi d'autres raisons au moindre déploiement de SCTP. Mais l'absence d'API jouait certainement un rôle : pas moyen de programmer avec SCTP sans devoir se limiter, non seulement à un système donné, mais en prime à une mise en œuvre particulière de SCTP. Les instructions d'installation devenaient donc pénibles à lire. C'est ce problème que résout notre RFC.

L'API décrite dans ce RFC est longue (le RFC fait 113 pages) donc je résume plutôt sauvagement. Elle permet d'écrire des programmes qui font la même chose qu'avec TCP, comme des programmes qui tirent profit des fonctions spécifiques de SCTP. Car la sémantique de SCTP n'est pas exactement la même que celle de TCP, le remplacement de l'un par l'autre n'est pas entièrement invisible aux applications. Les points importants de cette nouvelle API :

- Elle est basée sur la traditionnelle interface socket,

- Elle permet le style de programmation un-vers-N (section 3). TCP ne permet que un-vers-un, UDP permet d'utiliser une prise (socket) pour du un-vers-N, et SCTP aussi. En termes SCTP, une prise permet de contrôler plusieurs associations. Par contre, pas de diffusion, que ne permet pas SCTP.

- Elle permet également le style un-vers-un (section 4), familier aux programmeurs qui utilisent TCP. Avec ce style (une seule association par prise), les applications existantes qui se servent de TCP peuvent être portées en SCTP avec très peu d'efforts.

Ces deux styles ne sont pas compatibles dans le même programme, le programmeur devra choisir.

Notez que les efforts de conception d'une API SCTP sont anciens. Résultat, il traîne dans la nature des tutoriels, des Howto, des exemples de programme utilisant des mécanismes qui ne sont plus les mécanismes recommandés. Plusieurs éléments des API expérimentales qui ont précédé celle-ci sont repris dans ce RFC, en les notant comme dépassés et ne devant plus être utilisés pour de nouveaux programmes.

Un programme serveur typique qui utilise le style un-vers-N ressemble à :

socket(..., SOCK_SEQPACKET, IPPROTO_SCTP): /* Le type SOCK_SEQPACKET indique le style 1-vers-n. Section 3.1.1 */ bind(...); listen(...); /* Pas besoin de accept(). Les nouvelles associations sont gérées automatiquement (si le serveur le veut, il est prévenu lors des recvmsg(), évenement SCTP_ASSOC_CHANGE). Section 3.1.3 */ recvmsg(...); sendmsg(...); close(...); /* close() ferme tout. Pour ne fermer qu'une seule association, on utilise sendmsg() avec SCTP_EOF. */

pendant que le client fera plutôt :

socket(..., SOCK_SEQPACKET, IPPROTO_SCTP): sendmsg(...); recvmsg(...); close(...):

Toutes les associations du serveur seront représentées par une seule

prise et distinguées par leur identificateur d'association, de type

sctp_assoc_t. La section 3.3 fournit les détails

pour ce cas. Par exemple, si le programme n'utilise qu'un seul tampon

par prise réseau, une association qui traîne peut bloquer toutes les

autres. Le RFC recommande d'utiliser des prises non-bloquantes.

Quant au style un-vers-un, c'est celui de TCP et il est familier à tous les programmeurs réseau. Il est présenté en section 4. L'idée est qu'une application d'aujourd'hui, qui utilise TCP, sera ainsi portée en très peu de temps.

La séquence de commandes pour le serveur est typiquement :

socket(..., SOCK_STREAM, IPPROTO_SCTP); /* Le protocole IPPROTO_SCTP est la seule différence avec TCP. */ bind(...); listen(...); accept(...); /* Ensuite, recv() et send() avec la nouvelle prise retournée par accept(). */ close(...);

Et chez le client :

socket(..., SOCK_STREAM, IPPROTO_SCTP); connect(...); /* Ensuite, recv()/recvmsg() et send()/sendmsg() */ close(...);

Voici pour le code. La section 5 présente ensuite les nouvelles

structures de données, celles qui sont spécifiques à SCTP, lorsqu'on

utilise recvmsg() et

sendmsg() pour des opérations de

contrôle (et pas seulement d'envoi et de récupération de données). Ces

fonctions prennent un paramètre message de type

msghdr (RFC 3542). On peut

s'en servir pour définir des paramètres de la connexion (options

SCTP_INIT et SCTP_SNDINFO),

ou obtenir des informations supplémentaires lors de la réception de

données (option SCTP_RCVINFO, par exemple le

champ rcv_assoc_id indiquera par quelle

association est venue le message).

Pendant la durée de vie d'une connexion SCTP, des tas d'évenements

qui n'ont pas d'équivalent dans le monde TCP peuvent se produire :

changement d'adresse IP d'un pair

(SCTP_PEER_ADDR_CHANGE, section 6.1.2), établissement de nouvelles

associations (ou arrêt des anciennes,

cf. SCTP_ASSOC_CHANGE, section 6.1.1), etc. La section 6 décrit

comment être informé de ces évenements. Quant aux options des prises spécifiques

à SCTP, elles sont dans la section 8. Elles s'utilisent avec

setsockopt() et

getsockopt(). Par exemple,

SCTP_ASSOCINFO permet d'obtenir (ou de modifier)

les paramètres liés aux associations,

SCTP_PRIMARY_ADDR d'obtenir l'adresse IP du pair

pour une association donnée, etc.

Le RFC contient en annexe A deux exemples d'utilisation de cette API, un pour un serveur en un-vers-N et un pour un client en un-vers-un. Pour les raisons expliquées plus haut (retard à normaliser l'API et bibliothèque non standards développées en attedant), ces exemples ne compilent pas sur une Debian ou une Ubuntu récente :

% gcc sctp-sample-client.c sctp-sample-client.c: In function 'main': sctp-sample-client.c:40:25: error: storage size of 'info' isn't known sctp-sample-client.c:97:54: error: 'SCTP_SENDV_SNDINFO' undeclared (first use in this function) sctp-sample-client.c:97:54: note: each undeclared identifier is reported only once for each function it appears in

Je n'ai pas encore trouvé de système où ces exemples compilent. Il existe en effet plusieurs mises en œuvre de SCTP mais pas de cette API. Plus exactement, les implémentations de cette API sont ultra-récentes et ne sont pas encore arrivés chez l'utilisateur. On a :

- Sur Linux Linux Kernel Stream Control Transmission Protocol (dont l'API est fondée sur une très vieille version de l'Internet-Draft qui a fini par donner naissance à ce RFC),

- Sur FreeBSD, SCTP existe depuis longtemps mais l'API a le même problème.

- Et pareil pour sctplib (une mise en œuvre de SCTP en espace utilisateur) et son API.

Le RFC note que des implémentations de l'API standard existent sur Linux, FreeBSD et Solaris mais leur déploiement effectif est inconnu. Elles ont apparemment déjà servi à ajouter SCTP à Firefox et Chrome.

Le livre de référence sur la programmation réseau, celui de Stevens, ne parle pas de SCTP dans les deux premières éditions. C'est à partir de la troisième édition (réalisée par d'autres, après la mort de l'auteur) que SCTP apparaît.

En attendant, la bogue echoping #1676608 risque d'attendre longtemps (d'autant plus que je n'ai plus le temps de m'occuper d'echoping).

L'article seul

RFC 6455: The WebSocket protocol

Date de publication du RFC : Décembre 2011

Auteur(s) du RFC : I. Fette (Google), A. Melnikov (Isode)

Chemin des normes

Réalisé dans le cadre du groupe de travail IETF hybi

Première rédaction de cet article le 12 décembre 2011

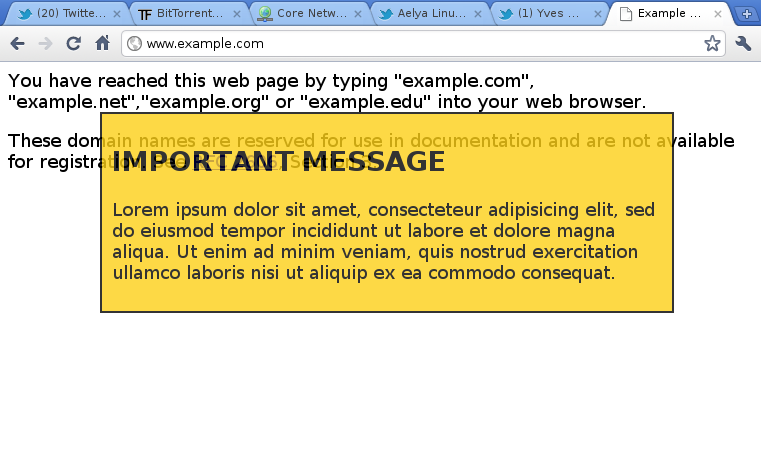

Ce nouveau protocole, WebSocket, vise à résoudre un problème embêtant pour les développeurs d'applications réseau. L'architecture de l'Internet était conçue pour que le seul point commun réellement obligatoire soit le protocole de couche 3, IP. Ce protocole est simple et fournit peu de services. Les développeurs qui voulaient des choses en plus les mettaient dans leurs applications ou, la plupart du temps, comptaient sur les protocoles de transport comme TCP. Si aucun des protocoles de transport existant ne satisfaisaient leurs besoins, ils avaient parfaitement le droit d'en inventer un autre et de le déployer sans rien demander à personne (principe dit « de bout en bout »). Ce modèle ne marche plus guère aujourd'hui. Il est devenu très difficile de faire passer un autre protocole de transport que TCP à travers les innombrables obstacles du réseau (NAT et pare-feux, notamment), et même un protocole applicatif nouveau, tournant sur un port TCP à lui, risque d'avoir le plus grand mal à passer. D'où l'idée de base de WebSocket : faire un protocole de transport au dessus de HTTP, qui va être le seul à passer à peu près partout. WebSocket est donc l'aboutissement d'un processus, qui a mené à ce que le protocole d'unification ne soit plus IP mais HTTP. Bienvenue dans l'Internet d'aujourd'hui « Tout sur le port 80 ».

WebSocket n'est toutefois pas un protocole généraliste, il est conçu pour fonctionner essentiellement dans le cadre du navigateur Web qui charge du code inconnu (typiquement en JavaScript) et qui va ensuite l'exécuter. Ce code pourra utiliser le réseau, dans une certaine limite (vers la même origine, cf. RFC 6454) mais les possibilités de communication offertes précédemment étaient limitées. WebSocket donne à ce code JavaScript (ou écrit dans d'autres langages) les possibilités d'une vraie communication réseau bidirectionnelle.

Avant, les applications s'exécutant sur le navigateur n'avaient pas

de moyen simple de faire de telles communications, équivalentes à ce

qu'on fait en TCP. Des applications comme la messagerie instantanée, le partage d'un document en cours d'édition

ou bien comme des jeux en commun souhaitaient un

modèle d'interaction plus riche que le traditionnel

GET du client vers le serveur. Bien sûr, elles

auraient pu être extérieures au navigateur, ce qui était certainement

plus propre du point de vue architectural. Mais elles se heurtent

alors au problème de filtrage décrit plus haut. Et, dans le

navigateur, elles dépendaient de

XMLHttpRequest ou bien de <iframe> et de

polling. Par exemple, un

code tournant sur le navigateur qui voulait simplement se mettre en

attente de donnés émises de manière asynchrone par le serveur n'avait

pas d'autres solutions que d'interroger ce dernier de temps en temps. Ce problème est

décrit en détail dans le RFC 6202. Il avait

plusieurs conséquences fâcheuses comme un surcoût en octets (tout

envoi de données nécessitait les en-têtes HTTP complets) ou comme un

modèle de programmation peu naturel.

WebSocket vise à résoudre ce problème en transformant HTTP en un protocole de transport. Il réutilise toute l'infrastructure HTTP (par exemple les relais ou bien l'authentification). Passant sur les mêmes ports 80 et 443, on espère qu'il réussira à passer partout. Comme le note un observateur, « WebSocket est un protocole totalement alambiqué pour contourner la stupidité du monde ».

Le résultat n'est donc pas parfait (rappelez-vous que HTTP n'avait pas été conçu pour cela) et le RFC note qu'on verra peut-être un jour les services de WebSocket fonctionner directement sur TCP (personnellement, j'ai des doutes, puisqu'on pourrait aussi bien dans ce cas utiliser des protocoles de transport qui fournissent les mêmes services, comme SCTP - RFC 4960).

Une petite note avant d'attaquer le RFC : si vous avez l'habitude de lire des RFC, vous noterez que celui-ci a des notations originales (section 2.1) comme d'utiliser les tirets bas pour souligner les définitions, les barres verticales pour encadrer les noms d'en-têtes ou de variables et les barres obliques pour les valeurs des variables.

La section 1.2 résume le fonctionnement du protocole (le lecteur

pressé du RFC peut d'ailleurs se contenter de la section 1, non

normative mais qui contient l'essentiel sur WebSocket). Le principe

de base est d'utiliser du HTTP normal (RFC 7230) mais le client ajoute un en-tête

Upgrade: à une requête GET, pour indiquer sa volonté de faire du

WebSocket :

GET /chat HTTP/1.1 Host: server.example.com Upgrade: websocket Connection: Upgrade Sec-WebSocket-Key: dGhlIHNhbXBsZSBub25jZQ== Origin: http://example.com Sec-WebSocket-Protocol: chat, superchat Sec-WebSocket-Version: 13

Le serveur répond alors par un code 101 et en indiquant upgrade dans

l'en-tête Connection: et en ajoutant des en-têtes

spécifiques à WebSocket :

HTTP/1.1 101 Switching Protocols Upgrade: websocket Connection: Upgrade Sec-WebSocket-Accept: s3pPLMBiTxaQ9kYGzzhZRbK+xOo= Sec-WebSocket-Protocol: chat

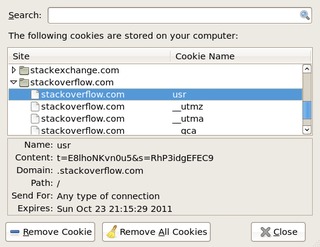

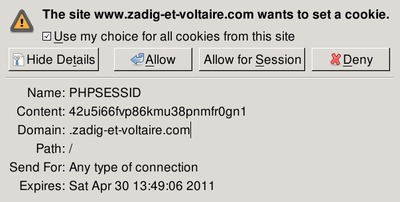

Bien sûr, d'autres en-têtes HTTP sont possibles comme les petits gâteaux du RFC 6265. Une fois que le client a fait sa demande, et que le serveur l'a acceptée, il existe une connexion bidirectionnelle entre ces deux acteurs et on peut faire passer les données.

Contrairement à TCP (mais comme dans SCTP), la communication n'est pas un flot d'octets sans structure ; c'est une suite de messages, chacun composé d'une ou plusieurs trames. Les trames sont typées et toutes les trames d'un même message ont le même type. Par exemple, il existe un type texte, où les trames contiennent des caractères Unicode encodés en UTF-8. Il existe évidemment un type binaire. Et il existe des trames de contrôle, conçues pour l'usage du protocole lui-même.

La section 1.3 se focalise sur la poignée de main entre

client et serveur qui lance le protocole (les détails complets étant en section 4). On l'a vu, le client doit

ajouter l'en-tête Upgrade: websocket pour

demander au serveur de basculer en WebSocket (RFC 7230, section 6.7 ; la valeur

websocket pour cet en-tête est enregistrée à l'IANA, cf. section 11.2, et aussi le RFC 2817, section 7.2). Le client indique également des

en-têtes spécifiques à WebSocket comme

Sec-WebSocket-Protocol: qui permet d'indiquer un

protocole applicatif au dessus de WebSocket (chat

dans l'exemple plus haut). Ces protocoles applicatifs (section 1.9)

sont normalement enregistrés à l'IANA pour

assurer l'unicité de leurs noms. L'en-tête Origin: du

RFC 6454 sert à indiquer quelle était l'origine de la page Web

qui a chargé le script client. Quand à

Sec-WebSocket-Key:, son rôle est de permettre de

vérifier que la connexion était bien prévue pour être du WebSocket et

pas des jeux faits par un programme malveillant qui enverrait des

données ressemblant à du WebSocket sur le port 80, sans être passé par

la poignée de main normale. Le serveur doit combiner la valeur de

l'en-tête Sec-WebSocket-Key: avec un

GUID (RFC 4122) fixe,

258EAFA5-E914-47DA-95CA-C5AB0DC85B11. Il passe le résultat par

SHA-1 puis par Base64

et retourne ce résultat au client (dans un en-tête Sec-WebSocket-Accept:), qui peut alors être sûr que c'est

bien ce serveur qui a reçu sa poignée de main. (Voir la section 1.6

sur ce point. Les en-têtes commençant par Sec ne

peuvent pas être ajoutés via du code

XMLHttpRequest normal et, donc, un client

JavaScript ordinaire ne peut pas se comporter en client

WebSocket.)

À noter que les en-têtes spécifiques de WebSocket ont été ajoutés au registre des en-têtes.

La réponse du serveur utilise le code HTTP 101 (qui avait été prévu

de longue date par le RFC 7231, section 6.2.2), qui signifie que le serveur accepte

le changement de protocole. Tout autre code indique que le serveur

n'accepte pas WebSocket et que le client doit donc continuer en HTTP

normal. Ainsi, un serveur HTTP normal refusera l'en-tête Upgrade: :

% telnet www.bortzmeyer.org http Trying 2605:4500:2:245b::bad:dcaf... Connected to www.bortzmeyer.org. Escape character is '^]'. GET / HTTP/1.1 Host: www.bortzmeyer.org Upgrade: websocket HTTP/1.1 400 Bad Request Date: Tue, 29 Nov 2011 21:15:34 GMT Server: Apache/2.2.16 (Debian) Vary: Accept-Encoding Content-Length: 310 Connection: close Content-Type: text/html; charset=iso-8859-1

La section 1.4, elle, décrit la fermeture de la connexion (détails en section 7). Elle se fait par l'envoi d'une trame de contrôle ad hoc. Notez que la simple fermeture de la connexion TCP sous-jacente ne suffit pas forcément : en présence d'intermédiaires, par exemple les relais, elle peut être insuffisante.

Un peu de philosophie après ces détails ? La section 1.5 décrit les concepts à la base de WebSocket. Par exemple, l'un des buts était de garder au strict minimum le nombre de bits de tramage. La structure des données que permet WebSocket est donc réduite (séparation des trames, et typage de celles-ci) et toute structuration plus sophistiquée (par exemple pour indiquer des métadonnées) doit être faite par l'application, au dessus de WebSocket.

Dans cette optique « ne pas trop en ajouter », cette section note que WebSocket ajoute à TCP uniquement :

- Le modèle de sécurité du Web, fondé sur la notion d'origine du RFC 6454,

- Un mécanisme de nommage permettant de mettre plusieurs

applications sur le même port (c'est le chemin donné en argument de la

commande

GET), - Un système de tramage, que n'a pas TCP, qui ne connait que les flots d'octets sans structure,

- Un mécanisme de fermeture explicite de la connexion (on l'a dit, TCP seul ne suffit pas, dans la jungle qu'est le Web d'aujourd'hui, truffé de middleboxes).

Et c'est tout. Le reste doit être fait par les applications. Compte-tenu des contraintes spécifiques du Web, WebSocket offre donc pratiquement le même service aux applications que TCP. Sans ces contraintes Web (de sécurité, de fonctionnement à travers les middleboxes), du TCP brut suffirait.

Voila, vous connaissez maintenant l'essentiel de WebSocket. Le

reste du RFC précise les détails. La section 3 décrit les

URI WebSocket. Ils utilisent le plan

ws: (non chiffré, port 80

par défaut) ou le wss: (chiffré avec

TLS, port 443 par défaut). La section 11 décrit

l'enregistrement de ces plans dans le registre

IANA. Par exemple

ws://example.com/chat est un URI WebSocket (pour la connexion donnée en exemple au début de cet article), comme ws://www.3kbo.com:9090/servers/1/status ou wss://foobar.example/newsfeed.

Comment fonctionne le tramage, le découpage du flot de données en

trames bien délimitées ? La section 5 le normalise avec précision. Une

trame a un type, une longueur et des données. On trouve également

quelques bits comme FIN qui indique la dernière

trame d'un message, ou comme RSV1,

RSV2 et RSV3, réservés pour

de futures extensions du protocole. Une grammaire complète

est donnée en section 5.2, en utilisant ABNF

(RFC 5234. Les fanas d'ABNF noteront que cette

grammaire ne décrit pas des caractères mais des bits, ce qui

représente une utilisation originale de la norme.

Le type est nommé opcode et occupe quatre bits. Les valeurs de 0x0 à 0x7 indiquent une trame de données, les autres sont des trames de contrôle. 0x1 indique une trame de texte, 0x2 du binaire, 0x8 est une trame de contrôle signalant la fin de la connexion, 0x9 une demande d'écho (ping), 0xA une réponse (pong), etc. La sémantique des trames de contrôle figure en section 5.5. On y apprend par exemple que des échos non sollicités (pong non précédé d'un ping) sont légaux et peuvent servir à indiquer qu'une machine est toujours en vie.

On le sait, l'insécurité est une des plaies du Web, on trouve tout le temps de nouvelles manières de pirater les utilisateurs. Les problèmes viennent souvent de nouveaux services ou de nouvelles fonctions qui semblent super-cool sur le moment mais dont on découvre après qu'elles offrent plein de pièges. Il n'est donc pas étonnant que la section 10, sur la sécurité, soit longue.

D'abord, le serveur WebSocket doit se rappeler qu'il peut avoir

deux sortes de clients (section 10.1) : du code « embarqué » par

exemple du JavaScript exécuté par un navigateur

et dont l'environnement d'exécution contraint sérieusement les

possibilités. Par exemple, l'en-tête Origin: est

mis par ce dernier, pas par le code Javascript, qui ne peut donc pas

mentir sur sa provenance. Mais un serveur WebSocket peut aussi être

appelé par un client plus capable, par exemple un programe

autonome. Celui-ci peut alors raconter ce qu'il veut. Le serveur ne

doit donc pas faire confiance (par exemple, il ne doit pas supposer

que les données sont valides : il serait très imprudent de faire

une confiance aveugle au champ Payload length,

qu'un client malveillant a pu mettre à une valeur plus élevée que la

taille de la trame, pour tenter un débordement de

tampon).

WebSocket ayant été conçu pour fonctionner au dessus de

l'infrastructure Web existante, y compris les relais, la section 10.3

décrit les risques que courent ceux-ci. Un exemple est l'envoi, par un

client malveillant, de données qui seront du WebSocket pour le serveur

mais qui sembleront un GET normal pour le

relais. Outre le tramage, la principale protection de WebSocket contre

ce genre d'attaques est le masquage des données avec une clé contrôlée

par l'environnement d'exécution (l'interpréteur JavaScript, par

exemple), pas par l'application (section 5.3 pour en savoir plus sur

le masquage). Ainsi, un code JavaScript méchant ne pourra pas

fabriquer des chaînes de bits de son choix, que WebSocket

transmettrait aveuglément.

Un peu d'histoire et de politique, maintenant. WebSocket a une histoire compliquée. L'idée de pousser les informations du serveur vers le client (connue sous le nom de Comet) est ancienne. Le protocole WebSocket (dont l'un des buts est justement cela) a été créé par Ian Hickson (qui a aussi écrit les premiers projets de RFC mais n'apparait plus comme auteur). Le groupe de travail WHATWG a ensuite beaucoup participé. La plupart des mises en œuvre de WebSocket citent ce groupe ou bien les anciens Internet-Drafts, écrits avant la création du groupe de travail IETF HyBi en janvier 2010.

Le principe même de WebSocket a souvent été contesté. Pourquoi passer tant d'efforts à contourner les problèmes de l'Internet aujourd'hui (notamment les middleboxes abusives) plutôt qu'à les résoudre ? Un intéressant texte de justification a été écrit à ce sujet. Notez qu'il inclut des exemples de code. Le groupe HyBi a connu de vives discussions, avec menaces de scission (« À WHATWG, c'était mieux, on va quitter l'IETF si ça n'avance pas »). Un des points d'affrontement était par exemple les problèmes de sécurité (résolus par la solution du masquage). Cela s'est ensuite arrangé, début 2011.

Si vous voulez vous lancer dans la programmation d'applications WebSocket tournant dans le navigateur, regardez l'API. Aujourd'hui, on trouve des implémentations de WebSocket pour les différents serveurs (GlassFish, Jetty, Apache). Dans les environnements de développement, on trouve du WebSocket chez Django et bien d'autres. Chez les clients, Firefox l'a en théorie depuis la version 6, Chrome et Internet Explorer l'ont annoncé pour une version prochaine. Bon, en pratique, c'est compliqué, et la démo ne donne pas toujours les résultats attendus (elle me refuse mon Firefox 7 mais accepte un Chrome).

Attention si vous lisez les sources, pas mal d'implémentations ont été faites en suivant des vieilles versions de la spécification de WebSocket, antérieures à sa normalisation à l'IETF. Cela se sent par exemple dans les noms des variables utilisés. (Un terme comme « opcode » pour le type est dans le RFC mais pas toujours dans les programmes.)

En dehors du monde des navigateurs, si vous voulez programmer du WebSocket, vous avez, entre autres :

- En Python, la bibliothèque pywebsocket, également ws4py, websocket-client et python-websocket. Ne me demandez pas un avis, je n'ai pas eu l'occasion et le temps de les comparer sérieusement. Je crains que, comme souvent en Python, il y ait pléthore d'implémentations plus au moins au point, et aucune « de référence ».

- En Go, il y a un paquetage dans la bibliothèque standard. Un exemple pour un chat est décrit.

- En C++, il y a la bibliothèque websocketpp.

- Enfin, il existe un article de Wikipédia de comparaison des mises en œuvres.

Si vous voulez jouer plutôt avec un programme client comme curl, vous avez un bon article qui explique comment faire du WebSocket avec curl.

Si vous cherchez des fichiers pcap de Websocket, on en trouve sur pcapr mais attention, la plupart concernent des mises en œuvres de versions antérieures du protocole. Mais Wireshark n'a pas l'air encore capable de décoder le framing Websocket. (Une mise en œuvre existe.)

Les autres registres IANA pour WebSocket

sont en https://www.iana.org/assignments/websocket/websocket.xml. Il existe un site de référence

sur WebSocket.

Un exemple de service publiquement accessible et utilisant WebSocket est le service RIS Live.

Enfin, si vous voulez d'autres articles sur WebSocket, j'ai beaucoup apprécié celui de Brian Raymor.

L'article seul

RFC 6454: The Web Origin Concept

Date de publication du RFC : Décembre 2011

Auteur(s) du RFC : A. Barth (Google)

Chemin des normes

Réalisé dans le cadre du groupe de travail IETF websec

Première rédaction de cet article le 12 décembre 2011

Chaque jour, plusieurs failles de sécurité sont annoncées frappant

un site Web, ou, plus rarement, un

navigateur. Ces failles proviennent souvent de

l'exécution de code, par exemple Java ou

JavaScript, téléchargé depuis un serveur qui

n'était pas digne de confiance, et exécuté avec davantage de privilèges

qu'il n'aurait fallu. Une des armes principales utilisées par la

sécurité du Web, pour essayer d'endiguer la marée de ces attaques, est

le concept d'origine. L'idée est que toute

ressource téléchargée (notamment le code) a une origine, et que cette

ressource peut ensuite accéder uniquement à ce qui a la même origine

qu'elle. Ainsi, un code JavaScript téléchargé depuis

www.example.com aura le droit d'accéder à l'arbre

DOM de www.example.com, ou

à ses cookies, mais pas à

ceux de manager.example.net. Ce concept d'origine

semble

simple mais il y a plein de subtileries qui le rendent en fait très

complexe et, surtout, il n'avait jamais été défini précisément. Ce que

tente de faire ce RFC.

Pour comprendre l'importance de l'origine,

revoyons un navigateur Web en action. Imaginons

qu'il n'impose aucune limite au code (Java,

JavaScript, Silverlight,

etc) qu'il exécute. Un méchant pourrait alors mettre du

code malveillant JavaScript sur son serveur, faire de la

publicité (par exemple via le spam) pour

http://www.evil.example/scarlet-johansson-pictures/,

et attendre les visites. Le navigateur récupérerait

l'HTML, puis le JavaScript inclus, et celui-ci

pourrait faire des choses comme lancer une DoS

par connexions HTTP répétées vers

http://www.victim.example/. C'est pour éviter ce

genre d'attaques que tous les navigateurs ont la notion d'origine. Le

code récupéré sur le site du méchant va avoir l'origine

www.evil.example, et le navigateur l'empêchera de

faire des requêtes HTTP vers un autre serveur que

www.evil.example. En gros, le principe

traditionnel de sécurité est « Le contenu récupéré depuis l'origine X

peut interagir librement avec les ressources ayant cette même

origine. Le reste est interdit. » (section 1 du RFC, pour un résumé).

Mais ce principe très simple à énoncer et à comprendre dissimule pas mal de pièges. Ce RFC va donc essayer de les mettre en évidence. À noter qu'il ne fait que fournir un cadre, ce n'est pas un protocole, et il n'y a donc pas besoin de modifier les navigateurs pour obéir à ce texte. Les détails concrets du principe d'origine vont en effet dépendre du protocole utilisé et chacun (HTML, WebSockets du RFC 6455, etc) va donc devoir décliner ce principe selon ses caractéristiques propres. Par exemple, pour le futur HTML5, voici la définition.

Donc, on attaque avec la section 3, qui expose ce qu'est ce

« principe de même origine » (Same Origin

Policy). D'abord, la

confiance (section 3.1) est exprimée sous forme

d'un URI. Lorsque le serveur

www.niceguy.example sert une page

HTML

https://www.niceguy.example/foo/bar.html qui contient :

<script src="https://example.com/library.js"/>

Il annonce sa confiance envers l'URI

https://example.com/library.js. Le code

JavaScript téléchargé via cet URI sera exécuté avec les privilèges de

https://www.niceguy.example/foo/bar.html, qui a choisi de lui faire confiance.

Cette idée de « confiance par URI » peut poser des problèmes dans

certains cas. Par exemple, si on utilise le

STARTTLS du RFC 2817, le

fait d'utiliser TLS ou pas n'apparait pas dans

l'URI et la page HTML ne peut donc pas exiger TLS. Les URI de plan

https: n'ont pas ce défaut, l'exigence de TLS y

est explicite.

Mais il y a une question plus sérieuse : dans

https://www.niceguy.example/foo/bar.html, quelle

est l'origine, celle dont vont dépendre les

autorisations ultérieures (section 3.2) ? Est-ce tout l'URI ? Ou bien

seulement le FQDN

www.niceguy.example ? Réponse : aucune des

deux.

Utiliser tout l'URL comme origine manquerait de souplesse. Un code

venu de http://www.niceguy.example/foo ne

pourrait pas interagir avec du contenu récupéré en

http://www.niceguy.example/bar. Mais n'utiliser

que le nom de domaine n'est pas génial non plus. Car cela permettrait

à du code JavaScript récupéré par

http://www.niceguy.example:8080/ de modifier un

arbre DOM de

https://www.niceguy.example/ (notez que la

seconde est sécurisée avec HTTPS ; ne se servir

que du nom de domaine comme origine permettrait à du contenu non sûr

de manipuler du contenu sûr).

Et faut-il utiliser tout le FQDN ? Cela

empêche http://portal.niceguy.example/ de jouer

avec http://manager.niceguy.example/ alors que

les deux sites sont sous la même autorité, celle de

niceguy.example. Mais le problème est que la

détermination de cette autorité est difficile. Contrairement à ce que

croient les débutants, elle n'est pas forcément dans les deux derniers

composants du nom de domaine. Par exemple,

jones.co.uk et smith.co.uk

ne sont pas sous la même autorité. Et, même lorsque c'est le cas, une

Université ne souhaite pas forcément que

http://students.example.edu/ (consacré aux pages

personnelles des étudiants) aient des droits sur

http://admin.example.edu/. Bien sûr, aucun

système n'est parfait. Avec le FQDN,

http://example.edu/students/~mark aura des droits

sur http://example.edu/grades/admin. Mais ce

modèle fondé sur le FQDN est maintenant trop ancien pour le changer

(rappelez-vous qu'il a évolué informellement, notre RFC 6454 ne fait que le documenter a posteriori).

Donc, pour résumer le point important de la section 3.2 : une

origine est un tuple {FQDN, plan, port}. Par exemple,

http://example.com/,

http://example.com:80 et

http://example.com/toto.html ont tous les trois la même origine,

le tuple {example.com, http,

80}. En revanche, http://example.com:81/ a une

autre origine (port différent), de même que

ftp://example.com (plan différent), ou

http://www.example.com/ (nom différent).

Ce principe de même origine ne répond pas à tous les risques de

sécurité. Il faut également intégrer la notion d'autorité (tel que ce

terme est utilisé en sécurité, notez que le RFC 3986 utilise ce mot dans un autre sens). L'autorité est

que le navigateur donne des droits différents selon le type de document. Une

image n'a aucun droit, c'est du contenu passif (du moins pour les formats traditionnels : avec des formats comme SVG, l'analyse de sécurité est bien plus complexe). En revanche, un

document HTML a le droit de déclencher le

chargement d'autres ressources (styles CSS mais

surtout code actif, par exemple JavaScript). Normalement, l'autorité

dépend du type MIME indiqué

(image/png pour une image,

text/html pour l'HTML). Si ce type est déterminé

par un utilisateur, de nouvelles vulnérabilités peuvent

survenir (et certains navigateurs sont assez imprudents pour deviner

le type MIME en examinant le contenu, une mauvaise pratique, connue

sous le nom de content sniffing). Pire, si l'utilisateur peut insérer du contenu qu'il choisit

dans des documents ayant une forte autorité (pages HTML), de nouveaux

risques peuvent survenir. Par exemple, une attaque

XSS débute par l'insertion de contenu dans une

page HTML, contenu qui sera ensuite interprété par le navigateur, et

exécuté avec l'origine de la page Web (cf. section 8.3). Or, ce cas est très fréquent

(pensez à un moteur de recherche qui affiche la requête originale sans

précaution, alorss qu'elle était choisie par un utilisateur

extérieur). La protection contre les XSS est complexe mais le conseil

de base est : modifiez tout contenu venu de l'extérieur avant de

l'inclure dans un document ayant de l'autorité (comme une page HTML),

de façon à ce qu'il ne puisse pas être interprété par le

navigateur. Le plus simple pour cela est d'utiliser exclusivement un

système de gabarit pour fabriquer les pages. Il

se chargera alors des précautions comme de transformer

les < en <.

Une fois déterminée l'origine, il reste à décider des privilèges donnés aux objets de la même origine (section 3.4). Pour les objets récupérés, on l'a vu, la politique est typiquement de ne donner accès qu'aux objets de même origine que le code. Mais pour les accès à d'autres objets, tout est bien plus complexe et la sécurité rentre ici en conflit avec l'utilisabilité. Par exemple, une application stricte du principe de même origine aux accès aux ressources interdirait à une page Web de mener à une autre page, d'origine différente, alors que c'est évidemment une fonction essentielle du Web. Moins caricatural, le cas d'images ou autres contenus embarqués dans une page Web. Bien que cela pose des problèmes de sécurité (pensez aux Web bugs), aucun navigateur n'impose que les images aient la même origine que la page qui les charge... De même, aucun navigateur n'interdit complètement d'envoyer des données à une autre origine, même si c'est la base de nombreuses CSRF.

Voilà, l'essentiel des principes du RFC tient dans cette section

3. Le reste, ce sont les détails pratiques. La section 4 formalise la

notion d'origine en en donnant une définition rigoureuse. Elle couvre

des cas rigolos comme les URI de plan file:

(autrefois, les navigateurs considéraient tous les fichiers locaux

comme ayant la même origine, aujourd'hui, les plus paranoïaques font

de chaque fichier une origine différente), ou bien explicite le cas

des ports par défaut de certains plans (vous avez remarqué

l'équivalence entre les URI http://example.com/,

http://example.com:80, plus haut ?). La section 5

décrit d'autres pièges comme le cas des plans où n'apparaissent pas de

noms de machine comme par exemple les data: du RFC 2397 (un cas amusant car

deux URI data: complètement identiques, bit par

bit, sont quand même d'origine différente). Et la section 6 explique

la sérialisation d'un URI, à des fins de comparaison simples avec

d'autres URI, pour déterminer s'ils ont la même origine. Par exemple,

http://www.example.com:80/ et

http://www.example.com/toto se sérialisent tous

les deux en http://www.example.com. Pour les URI

de type {scheme, host,

port} (les plus fréquents), une simple

comparaison de chaînes de caractères nous dira ensuite s'ils ont la

même origine (ici, oui).

Si on revient au premier exemple JavaScript que j'ai donné, celui

où https://www.niceguy.example/foo/bar.html

charge https://example.com/library.js, on voit

que l'origine n'est pas l'URI du script mais celle de la page qui le

charge. Or, on peut imaginer que le serveur

example.com voudrait bien connaître cette

origine, par exemple pour appliquer des règles différentes. ou tout

simplement pour informer le script du contexte dans lequel il va s'exécuter. C'est le rôle de l'en-tête

HTTP Origin:, normalisé

dans la section 7, et qui peut être ajouté aux requêtes. Ainsi, dans

l'exemple ci-dessus, la requête HTTP ressemblerait à :

[Connexion à exemple.com...] GET /library.js HTTP/1.1 Host: example.com Origin: https://www.niceguy.example ...

On voit que l'origine indiquée est la forme sérialisée comme indiqué

plus haut. Ce n'est donc pas l'équivalent de

Referer: qui indique un URI complet.

Cet en-tête est désormais dans le registre des en-têtes (cf. section 9).

Comme tout ce RFC décrit un mécanisme de sécurité, il est prudent de bien lire la section 8, Security Considerations, qui prend de la hauteur et rappelle les limites de ce mécanisme. Historiquement, d'autres modèles que le « principe de même origine » ont été utilisés (à noter que le RFC ne fournit pas de référence), comme le taint tracking ou l'exfiltration prevention mais pas avec le même succès.

D'abord, la notion d'origine est une notion unique qui s'applique à des problèmes très différents et peut donc ne pas être optimisée pour tous les cas.

Ensuite, elle dépend du DNS (section 8.1)

puisque la plupart des plans d'URI utilisent la notion

d'host et que la politique de même origine considère que deux serveurs sont les mêmes s'ils ont le

même nom. Si l'attaquant contrôle le DNS, plus aucune sécurité n'est

possible (on croit parler au vrai www.example.com et on

parle en fait à une autre machine).

À noter que le RFC prend bien soin de ne pas parler de la principale vulnérabilité de ce concept d'host : l'absence de notion générale d'identité d'une machine dans l'Internet (cette notion n'existe que pour certains protocoles spécifiques comme SSH). En l'absence d'une telle notion, des attaques sont possibles sans que l'attaquant ait eu à compromettre le DNS, comme par exemple le changement d'adresse IP.

Autre piège, le fait que le principe de même origine, ne soit pas

apparu tout de suite et que certaines techniques de sécurité du Web

utilisent une autre unité d'isolation que l'origine (section

8.2). Le Web n'a pas en effet de sécurité cohérente. C'est le cas des

cookies (RFC 6265), qui se servent d'un autre concept, le « domaine

enregistré ». Le navigateur essaie de trouver, lorsqu'il récupère un

cookie, à quel « domaine enregistré » il appartient

(l'idée étant que sales.example.com et

it.example.com appartiennent au même domaine

enregistré, alors qu'ils n'ont pas la même origine). Il enverra

ensuite le cookie lors des connexions au même

domaine enregistré. Pour déterminer ce domaine, notez que les

cookies ne font pas de différence entre HTTP et

HTTPS (sauf utilisation de l'attribut Secure) et

qu'un cookie acquis de manière sûre peut donc être

envoyé par un canal non sûr.

Notre RFC note que cette pratique d'utiliser le « domaine enregistré » est mauvaise et la déconseille. En effet :

- Rien n'indique dans le nom lui-même où est le domaine

enregistré. Sans connaître les règles d'enregistrement de

JPRS, vous ne pouvez pas dire que

a.co.jpetb.co.jpsont deux domaines enregistrés différents. Il existe des listes publiques de politiques d'enregistrement commehttp://publicsuffix.org/mais aucune n'est officielle et aucune n'est à jour. - Cette pratique dépend fortement du plan d'URI utilisé, certains n'ayant pas de domaine (donc pas de domaine enregistré).

Autre faiblesse du principe de même origine, l'autorité diffuse (section 8.3). L'autorité va dépendre de l'URI, pas du contenu. Or, un URI de confiance peut inclure du contenu qui ne l'est pas (pour le cas, fréquent, où une page Web inclut du contenu généré par l'utiisateur) et c'est alors un risque de XSS.

Résultat, le principe de même origine ne suffit pas à lui seul à protéger l'utilisateur (plusieurs attaques ont déjà été documentées.) Il faut donc ajouter d'autres pratiques de sécurité.